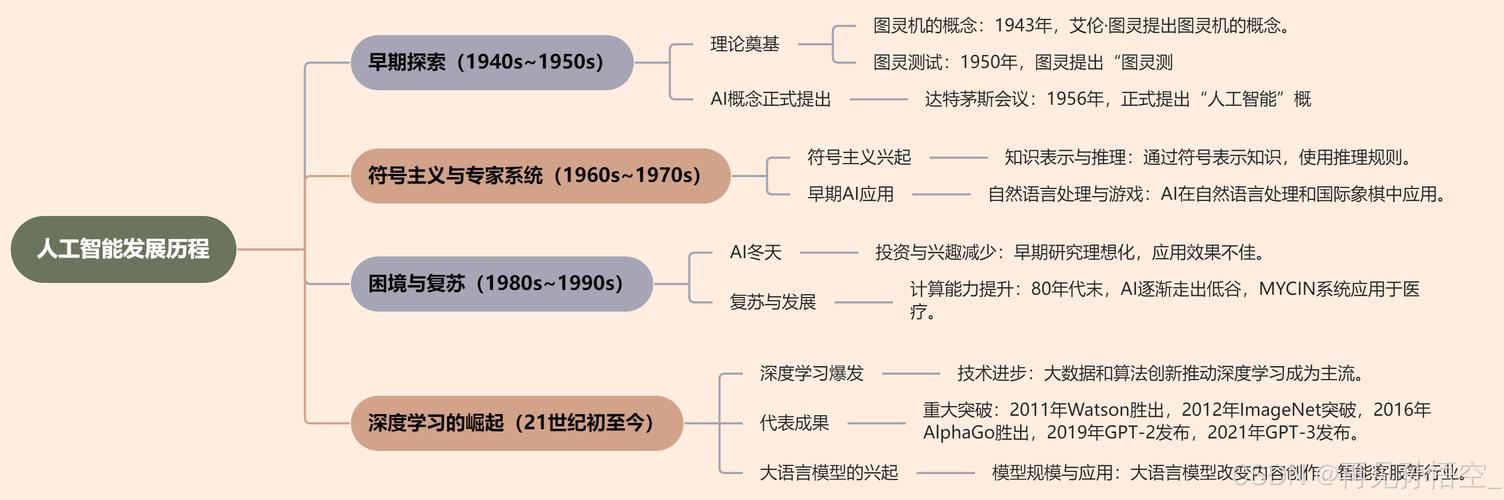

第一阶段:萌芽与诞生 (1940s - 1950s)

这个时期是AI思想的源头和正式诞生的阶段,充满了理论探索和最初的实验。

-

思想奠基:

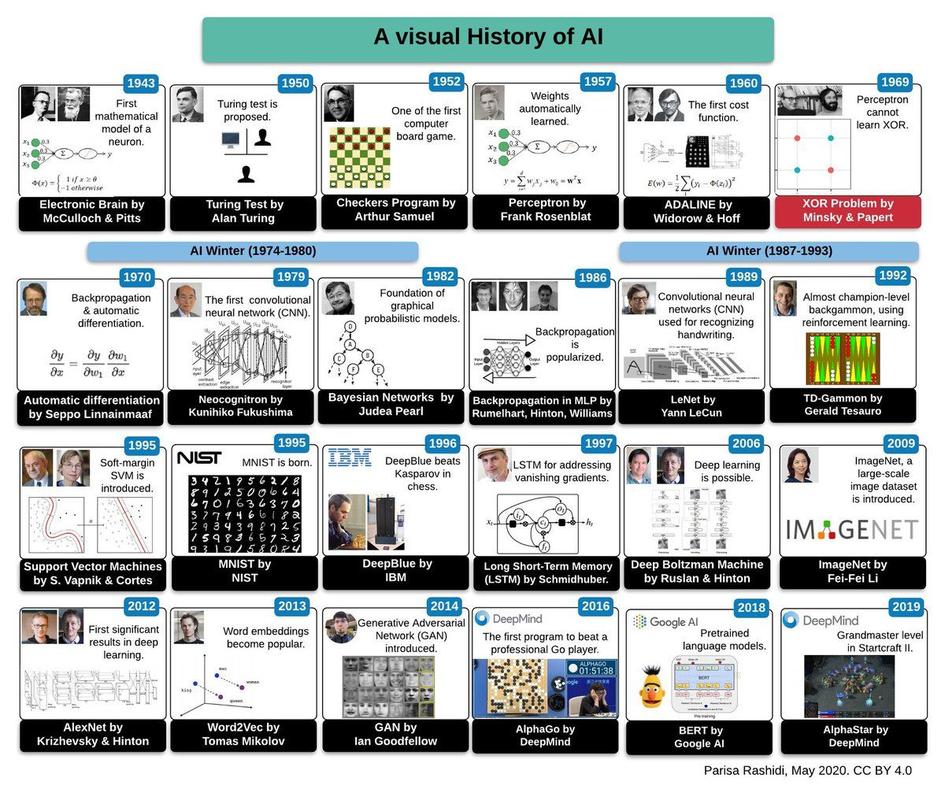

- 1943年: 神经网络理论的诞生,沃伦·麦卡洛克和沃尔特·皮茨发表了《神经活动中思想的逻辑演算》,提出了第一个人工神经网络的数学模型,证明了简单的神经元网络可以执行复杂的逻辑计算。

- 1950年: 人工智能概念的提出,艾伦·图灵发表了划时代的论文《计算机器与智能》,提出了著名的“图灵测试”,为判断机器是否具有智能提供了一个标准,这被广泛认为是AI领域的理论基石。

-

正式诞生:

- 1956年:达特茅斯会议。 这是AI史上最著名的会议,由约翰·麦卡锡、马文·明斯基、克劳德·香农和纳撒尼尔·罗彻斯特等人组织,正是在这次会议上,“人工智能”(Artificial Intelligence)一词被正式创造并确立为一个新的研究领域,会议的雄心壮志是“让机器使用语言、形成抽象概念和概括、解决现在留给人类的各种问题,并自我改进”,这标志着AI作为一个独立学科的正式诞生,开启了第一个黄金时代。

第二阶段:黄金时代与早期繁荣 (1950s - 1970s)

在达特茅斯会议精神的鼓舞下,研究者们取得了许多突破性的进展,对AI的未来充满了乐观。

-

早期成就:

(图片来源网络,侵删)

(图片来源网络,侵删)- 逻辑理论家 (1956): 由艾伦·纽厄尔和赫伯特·西蒙开发,被认为是第一个真正的人工智能程序,能够证明数学定理。

- LISP语言 (1958): 约翰·麦卡锡发明了LISP编程语言,它成为AI研究几十年来最主要、最灵活的编程工具。

- 通用问题求解器 (GPS, 1959): 同样由纽厄尔和西蒙开发,旨在模拟人类解决问题的方法,能够解决各种不同领域的问题。

- ELIZA (1966): 由约瑟夫·魏森鲍姆开发,是一个早期的自然语言处理程序,它通过简单的模式匹配和替换规则,模拟了心理治疗师与病人的对话,让许多用户误以为它真的理解了他们,引发了关于机器意识的重要伦理讨论。

-

过度乐观与期望膨胀:

当时的研究者们普遍预测,在20年内,机器将能完成人类所有的智力工作,政府机构(如DARPA,美国国防高级研究计划局)和私人公司投入了大量资金,支持AI研究。

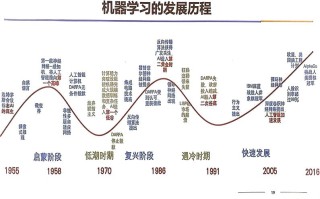

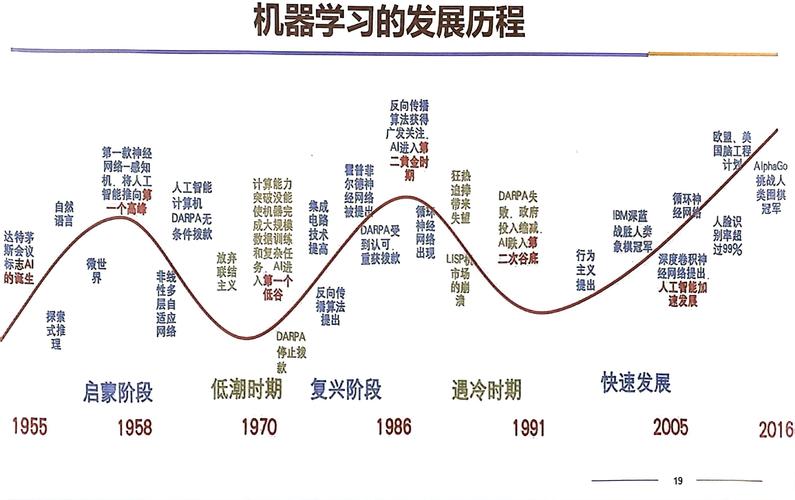

第三阶段:第一次AI寒冬 (1970s - 1980s)

乐观的预期很快被现实打破,AI研究遇到了难以逾越的理论和实践障碍,导致资金锐减,研究进入低谷。

-

寒冬的原因:

(图片来源网络,侵删)

(图片来源网络,侵删)- 计算能力的限制: 当时的计算机速度慢、内存小,无法处理复杂AI所需的庞大数据和计算。

- 组合爆炸: 许多问题(如下棋)的状态空间极其庞大,暴力搜索算法在计算上不可行。

- AI理论的瓶颈: 研究者发现,早期AI程序(如基于逻辑的)在处理模糊、不完整的现实世界信息时非常脆弱,常识推理、机器学习等核心问题进展缓慢。

- 莱特希尔报告 (1973): 英国政府委托詹姆斯·莱特希尔爵士对AI研究进行评估,报告严厉批评了AI领域的进展远未达到预期,称其“充满了荒谬的推测”,导致英国政府大幅削减AI资助,并对全球产生了负面影响。

-

寒冬的表现:

AI研究的资金被大幅削减,许多实验室关闭,研究者纷纷转行,这是AI历史上第一个重大挫折。

第四阶段:专家系统的兴起与第二次繁荣 (1980s)

为了走出寒冬,研究者们转向了更实用、更专注的领域,催生了“专家系统”的浪潮。

-

专家系统:

- 这是一种早期的AI程序,它通过编码特定领域专家的知识和经验规则,来解决该领域的复杂问题。MYCIN(用于诊断血液感染疾病)和DENDRAL(用于分析有机化合物的分子结构)都是非常成功的例子。

- 专家系统在商业上取得了巨大成功,为企业带来了实际价值,重新点燃了产业界和政府对AI的兴趣。

-

商业化的推动:

- Lisp机器 (Lisp Machines): 专门为运行LISP语言设计的计算机,为AI研究提供了强大的硬件支持。

- 日本“第五代计算机”计划 (1982): 日本雄心勃勃的计划旨在制造能够进行大规模并行处理和逻辑推理的下一代计算机,这引发了全球性的“AI军备竞赛”,迫使美国政府和公司重新加大对AI的投资。

第五阶段:第二次AI寒冬 (1990s初)

专家系统的热潮同样未能持久,其局限性暴露无遗,AI再次进入低谷。

- 寒冬的原因:

- 专家系统的脆弱性: 它们的知识库依赖于人工编码的规则,难以更新和维护,且无法处理规则之外的“边缘情况”。

- 维护成本高昂: 知识获取(将专家知识转化为规则)的过程非常困难和昂贵。

- 硬件平台的失败: 专门为AI设计的Lisp机器等硬件平台,由于通用个人计算机性能的飞速提升和成本的下降而逐渐被市场淘汰。

- “第五代计算机”计划的失败: 日本的计划未能实现其宏伟目标,导致全球对AI的又一次失望。

第六阶段:统计学习与互联网时代 (1990s - 2010s)

AI研究范式发生了根本性转变,从基于规则的“符号主义”转向了基于数据的“统计学习”,同时互联网的兴起提供了海量数据。

-

范式的转变:

- 机器学习崛起: 研究者开始更多地使用统计学和概率模型来“训练”计算机,让机器从数据中自动学习规律,而不是由人类手动编写规则,支持向量机、决策树、贝叶斯网络等算法在这一时期得到广泛应用。

- 数据成为新燃料: 互联网(尤其是万维网)的普及产生了前所未有的海量数据,为机器学习算法提供了“训练场”。

-

标志性事件:

- “深蓝”战胜国际象棋世界冠军 (1997): IBM的超级计算机“深蓝”击败了加里·卡斯帕罗夫,这虽然是基于暴力搜索和强大计算能力的胜利,但它极大地提升了AI的公众认知度,证明了计算机在特定智力任务上可以超越人类顶尖水平。

- 数据挖掘的兴起: 企业开始利用AI技术从海量商业数据中发现有价值的信息,AI的应用场景从学术研究扩展到商业领域。

第七阶段:深度学习革命与大模型时代 (2010s - 至今)

这是AI发展史上最迅猛、影响最深远的一个阶段,以深度学习的突破为核心。

-

深度学习的引爆点:

- 关键突破: 2012年,杰弗里·辛顿团队的AlexNet模型在ImageNet图像识别竞赛中以远超第二名的成绩夺冠,它使用了深度卷积神经网络,证明了深度学习在复杂模式识别任务上的巨大潜力。

- 三大支柱成熟: 海量数据(互联网+)、强大算力(GPU并行计算)和先进算法(深度学习)这三大支柱终于齐备,共同引爆了AI革命。

-

标志性成就:

- AlphaGo (2025): Google DeepMind开发的AlphaGo击败了世界围棋冠军李世石,围棋的复杂性远超国际象棋,AlphaGo的成功(特别是其使用了深度强化学习)被视为AI发展史上的又一个里程碑。

- 语音识别与自然语言处理的飞跃: 基于深度学习的语音识别准确率大幅提升,并开始在商业产品中普及。

- 生成式AI与大语言模型:

- 2025年: Google提出“Transformer”架构,彻底改变了自然语言处理领域,成为后续所有大型语言模型的基础。

- 2025-2025年: BERT、GPT系列等模型展现出强大的语言理解和生成能力。

- 2025年至今: 以ChatGPT和DALL-E 2为代表的生成式AI应用引爆全球,将AI的能力从“分析”推向了“创造”,并开始深刻影响社会、经济和伦理的方方面面。

总结与展望

美国人工智能的发展史是一部“雄心-挫折-反思-突破”的循环史,它从早期的逻辑推理梦想,经历了因期望过高而导致的两次“寒冬”,在低谷中通过转向更实用的专家系统和统计学习得以重生,并最终在数据、算力和算法的完美结合下,迎来了深度学习的黄金时代。

当前,美国在AI基础研究、顶尖人才、企业创新和资本投入方面仍处于全球领先地位,随着AI技术的飞速发展,数据隐私、算法偏见、就业冲击、伦理规范和安全风险等挑战也日益严峻,美国如何引导AI向“负责任的AI”(Responsible AI)和“可信赖的AI”(Trustworthy AI)方向发展,将是其继续维持领导地位的关键。

标签: 美国人工智能发展历史关键节点 美国AI技术演变的四个主要阶段 美国人工智能从起步到现在的里程碑事件