下面我将从核心概念、技术挑战、应用场景、现状与未来等多个维度,为您详细解读这个领域。

核心概念:什么是哑语自动翻译?

哑语自动翻译系统,通常指利用计算机视觉、机器学习和自然语言处理技术,将手语视频实时或非实时地转换成文本、语音或其他形式,或将文本/语音转换成手语动画/虚拟人的双向系统。

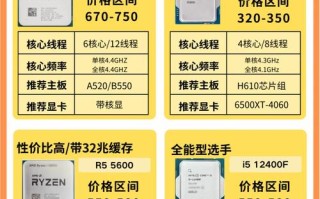

它主要包含两大核心模块:

-

手语识别

- 目标:将手语视频流转换成结构化的文本或语义信息。

- 过程:摄像头捕捉手语使用者 -> AI模型分析视频 -> 识别出手部动作、手势、身体姿态和面部表情 -> 输出对应的文字或语音。

-

手语生成

(图片来源网络,侵删)

(图片来源网络,侵删)- 目标:将文本或语音信息转换成自然、流畅的手语动作。

- 过程:输入文本/语音 -> AI模型进行语义理解 -> 生成连贯的手部动作、身体姿态和面部表情 -> 通过动画或虚拟人展示出来,供听障人士理解。

主要技术挑战

手语是一种视觉-空间语言,其复杂性远超口头语言,这给AI带来了巨大的挑战。

手语识别的挑战

-

高维度与复杂性:

- 手部:双手的形状、朝向、位置、运动轨迹,双手的组合动作更是指数级增长。

- 非手部信号:面部表情在手语中至关重要,一个表情可以改变整个词义(如“好” vs “不好”)。身体姿态和头部运动也承载着语法信息。

- 时空连续性:手语是连续的动作流,需要AI理解动作的时序关系,而不是孤立地识别每个手势。

-

数据稀缺与标注困难:

- 数据量少:相比于海量的文本和语音数据,高质量、大规模、多样化的手语视频数据集非常稀少。

- 标注成本高:标注手语需要懂手语的专家,过程耗时耗力,不仅要标注手势,还要标注关键点、动作边界、表情等,非常复杂。

-

个体差异与环境干扰:

(图片来源网络,侵删)

(图片来源网络,侵删)- signer variability:不同人的手语习惯、速度、幅度差异很大(方言)。

- 环境因素:光照变化、背景杂乱、遮挡(如头发、衣物、物体)都会严重影响识别效果。

-

缺乏统一标准:

世界各地有数百种不同的手语(如中国手语CSL、美国手语ASL、英国手语BSL),彼此不通,为每种手语开发模型都是巨大的工程。

手语生成的挑战

- 自然度与流畅性:

生成的手语不能是生硬的“动作拼接”,必须符合手语的语法规则和韵律节奏,听起来要像自然对话一样。

- 表情与姿态的同步:

手部动作必须与恰当的面部表情和身体姿态同步,否则表达的意思可能完全错误。

- 虚拟人技术:

需要高保真的3D虚拟人或机器人,能够以自然的物理方式执行手语动作,这对硬件和动画技术都是考验。

应用场景

一旦技术成熟,其应用场景将非常广泛:

-

无障碍沟通:

- 实时对话:在银行、医院、政务大厅、机场等场所,通过手机App或专用设备,让听障人士与健听人士实现无障碍实时交流。

- 视频会议辅助:在Zoom、Teams等视频会议中,提供实时的字幕翻译和虚拟人手语翻译。

-

教育与学习:

- 手语学习App:为健听人士提供互动式的手语学习工具,AI可以纠正用户的动作。

- 课堂辅助:为听障学生提供课堂实时字幕和手语翻译,帮助他们平等地接受教育。

-

媒体与娱乐:

- 翻译:为电影、电视节目、网络直播、在线课程等添加手语翻译轨道。

- 游戏与虚拟现实:在游戏中让NPC(非玩家角色)使用手语,或在VR环境中创建更沉浸式的沟通体验。

-

公共服务:

- 紧急呼叫系统:在报警电话、紧急求助热线中集成手语翻译,保障听障人士在紧急情况下的求助权利。

- 政府信息发布:政府新闻发布会、政策解读等提供手语翻译,确保信息触达每一个人。

研究现状与代表性进展

尽管挑战重重,但全球的科研机构和科技公司都在积极攻关,并取得了一些突破性进展。

-

学术界:

- 关键技术:基于深度学习,特别是3D卷积神经网络和Transformer模型,来处理手语的时空特征。姿态估计技术(如MediaPipe)被广泛用于提取手部和身体的关键点。

- 数据集建设:一些大学和研究机构正在努力构建大规模手语数据集,如 WLASL (World Level American Sign Language)、How2Sign 等,以推动研究。

-

产业界:

- 谷歌:推出了 “Live Transcribe” 和 “Live Caption” 功能,并积极探索手语识别技术,其MediaPipe框架提供了强大的手部追踪能力,是许多手语应用的基础。

- 微软:其AI for Accessibility项目资助了多个手语翻译项目,并开发了Azure AI认知服务,部分能力可用于手语分析。

- 中国科技公司:如百度、阿里巴巴、腾讯等也在相关领域有研究布局,尤其是在中文手语方面。

- 创业公司:

- SignAll:专注于为企业和机构提供手语翻译解决方案。

- MotionSavvy:开发了使用手势控制的平板电脑,并集成了手语识别和生成功能。

- 中国的“小手”等团队也在开发面向C端的手语学习App和翻译工具。

手语自动翻译的未来发展将呈现以下趋势:

- 多模态融合:未来系统将不仅仅依赖视觉,还会结合语音识别(如果听障人士也能说话)、唇读等信息,提高翻译的鲁棒性和准确性。

- 个性化与自适应:AI将能够学习特定用户的手语习惯,实现个性化的翻译,更好地应对个体差异。

- 轻量化与边缘计算:随着算法优化和硬件性能提升,翻译系统将可以在手机、智能眼镜等边缘设备上高效运行,保护用户隐私,降低延迟。

- 虚拟人与机器人结合:未来的翻译可能不再是屏幕上的一个2D动画,而是更具亲和力的3D虚拟人,甚至是在物理世界中与你互动的机器人。

- 构建手语元宇宙:在未来的虚拟世界里,手语可能会成为一种主流的沟通方式,AI手语翻译将是连接不同沟通方式人群的关键基础设施。

人工智能为哑语自动翻译带来了前所未有的机遇,它不仅是技术难题的攻坚,更是促进社会包容和人文关怀的重要实践,虽然目前的技术离完美还有距离,但发展速度非常快,我们有理由相信,在不远的将来,沟通无障碍的美好愿景将逐步成为现实。

标签: AI实时哑语翻译技术 哑语实时翻译AI工具 AI哑语翻译实时交互系统