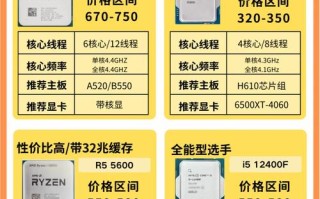

硬件基石:AI计算的核心引擎

这是英伟达最核心、最广为人知的部分,其硬件专为AI计算中的两个关键任务设计:训练 和 推理。

数据中心 GPU - AI训练的绝对王者

这是当前AI大模型浪潮下最炙手可热的硬件。

-

旗舰产品:H100 (Hopper架构)

- 地位:目前全球性能最强、最先进的AI GPU,是训练GPT-4等超大规模语言模型的标配。

- 核心特性:

- Transformer引擎:专门为Transformer模型(如ChatGPT的基础)进行硬件和软件优化,能极大提升训练和推理速度。

- FP8精度:支持全新的8位浮点精度,在保持模型精度的同时,将计算吞吐量提升近一倍。

- HBM3 高带宽内存:提供高达3TB/s的内存带宽,确保数据能快速喂给庞大的计算核心。

- NVLink 4.0:实现GPU之间超高速的互联,多卡协同工作的效率极高。

- 应用:OpenAI、Google、Meta等所有顶级AI公司训练大模型的核心动力。

-

前代/主流产品:A100 (Ampere架构)

- 地位:H100出现之前的“神卡”,至今仍是许多AI研究和企业应用的主力。

- 核心特性:支持FP16、BFLOAT16等AI关键精度,强大的多GPU扩展能力。

- 应用:广泛用于各类AI模型的训练、推理以及科学计算。

-

新一代产品:B100 (Blackwell架构,预计2025年发布)

(图片来源网络,侵删)

(图片来源网络,侵删)- 展望:据传性能将是H100的2-4倍,采用新的芯片设计(如2个芯片封装),将进一步巩固英伟达在AI算力领域的领导地位。

数据中心加速卡 - 针对推理和特定优化的选择

有些任务不需要H100这样的“巨无霸”,更看重能效比和成本。

- L40S (基于Ada Lovelace架构)

- 定位:专为AI推理和生成式AI工作负载设计,是A100在推理场景下的理想替代品。

- 核心特性:拥有更大的显存(48GB GDDR6),支持FP8和FP16,能效比更高,成本相对较低。

- 应用:在云服务中部署大量AI聊天机器人、图像生成模型等。

AI工作站 - 开发者和研究者的个人“超级计算机”

对于个人开发者、研究人员和小型团队,他们不需要整个数据中心,但需要强大的本地算力。

- 产品线:NVIDIA RTX 6000 Ada Generation / RTX 5000 Ada Generation 等

- 核心特性:基于消费级/专业级RTX Ada Lovelace架构,但提供更大的显存(如RTX 6000有48GB GDDR6 ECC内存)、更稳定的驱动和专业的认证。

- 应用:在本地进行AI模型原型设计、微调、数据预处理、以及复杂的3D渲染和科学计算。

Jetson 平台 - 边缘AI与机器人

这是英伟达面向嵌入式系统和边缘计算的AI解决方案,让AI可以在设备端(如汽车、无人机、机器人)直接运行。

- 产品系列:

- Jetson Orin Nano:性能与功耗的平衡点,适合消费级机器人、智能相机等。

- Jetson AGX Orin:性能强大的边缘AI超级计算机,用于自动驾驶汽车、高端机器人、医疗设备等。

- Jetson Xavier:上一代主流产品,应用广泛。

- 核心特性:集成了CPU、GPU、深度学习加速器和各种I/O接口,功耗极低(通常5-30瓦)。

- 应用:NVIDIA DRIVE系列自动驾驶平台、智能工厂、智能零售、无人机等。

软件与平台:让硬件发挥最大威力的“灵魂”

如果说硬件是引擎,那么软件就是让引擎高效运转的燃油和传动系统,英伟达的软件生态是其护城河的关键。

CUDA (Compute Unified Device Architecture)

- 地位:英伟达最核心、最根本的技术,它不是一个软件,而是一个并行计算平台和编程模型。

- 作用:允许开发者使用C/C++等语言来直接调用NVIDIA GPU的强大并行计算能力,没有CUDA,GPU的强大算力就无法被高效利用。

- 现状:经过十几年发展,CUDA已经成为事实上的行业标准,拥有最庞大的开发者社区和最完善的库支持,几乎所有主流的AI框架(TensorFlow, PyTorch)都深度优化了CUDA。

cuDNN / TensorRT

- cuDNN (CUDA Deep Neural Network library):专门用于深度学习的GPU加速库,提供高度优化的卷积、池化等神经网络操作,是AI框架的底层加速引擎。

- TensorRT:AI推理的终极优化工具,它可以将训练好的模型进行优化、融合和量化,生成一个在特定GPU上运行速度最快、延迟最低的优化引擎,对于部署在云端或边缘的AI应用至关重要。

AI框架与库

- NVIDIA AI Enterprise:一个企业级的AI软件套件,包含经过优化的、支持CUDA的AI框架(如PyTorch, TensorFlow)和工具,提供长期支持和技术保障。

- RAPIDS:一个开源的软件库,将数据科学和数据分析的流程(如Pandas, Scikit-learn)移植到GPU上,实现端到端的GPU加速。

NVIDIA Omniverse

- 定位:一个用于3D工业协作和模拟的“元宇宙平台”。

- 与AI的关系:它是一个强大的AI应用和开发平台,可以在其中进行物理模拟、生成式AI(如文本生成3D模型、图像生成材质)、数字人等,其底层大量依赖Omniverse Replicator(用于合成数据生成)和NVIDIA Isaac(用于机器人仿真)等AI工具。

系统与服务:完整的AI解决方案

英伟达不仅卖“零件”,还提供完整的“整车”和“交钥匙”服务。

DGX SuperPOD

- 定位:由多台DGX服务器(内置8张H100/A100 GPU)通过高速网络(InfiniBand)连接而成的“AI超级计算机集群”。

- 特点:开箱即用的AI算力集群,提供完整的硬件、软件(包括NGC软件库)和部署支持,企业可以像租用电一样按需使用。

- 应用:为全球顶级科技公司、研究机构和政府提供训练万亿参数级别大模型的算力基础设施。

NVIDIA DGX Cloud

- 定位:DGX SuperPOD的云服务版本,用户可以通过订阅的方式,在AWS、Google Cloud、Microsoft Azure等主流云平台上直接使用DGX算力。

- 优势:结合了公有云的灵活性和DGX专用硬件的强大性能,降低了企业自建AI数据中心的门槛。

NVIDIA DRIVE

- 定位:一个完整的自动驾驶平台,涵盖了从硬件(Orin/Xavier芯片)、软件(DRIVE OS, CUDA, TensorRT)、开发工具到仿真平台(Omniverse DRIVE)的全栈解决方案。

- 目标:为汽车制造商提供从L2+到L5级别的自动驾驶技术。

| 类别 | 核心产品 | 主要用途 | 目标用户 |

|---|---|---|---|

| 硬件 | H100 / A100 GPU | 训练超大AI模型 | 大型科技公司、研究机构、云服务商 |

| L40S 加速卡 | AI推理、生成式AI | 云服务商、企业IT部门 | |

| RTX 工作站 | 本地AI开发、原型设计 | 开发者、研究人员、中小企业 | |

| Jetson 平台 | 边缘AI、机器人 | 自动驾驶、机器人、物联网开发者 | |

| 软件 | CUDA / cuDNN | GPU并行计算基础 | 所有AI开发者 |

| TensorRT | AI推理性能优化 | AI模型部署工程师 | |

| Omniverse | 3D协作与AI生成式应用 | 数字孪生、元宇宙、内容创作者 | |

| 系统/服务 | DGX SuperPOD / Cloud | 企业级AI算力集群 | 政府、大型企业、科研机构 |

| DRIVE | 自动驾驶全栈解决方案 | 汽车制造商、Tier1供应商 |

英伟达通过“硬件+软件+系统服务”三位一体的战略,构建了一个强大的生态系统。 它不仅提供最快的AI计算“发动机”(GPU),还提供最匹配的“燃油”(CUDA、cuDNN)和最智能的“驾驶系统”(TensorRT、Omniverse),甚至直接提供“整车”(DGX、DRIVE)和“代驾服务”(DGX Cloud),这种全方位的布局使其在当前的AI浪潮中占据了难以撼动的核心地位。

标签: 英伟达人工智能设备推荐 人工智能设备英伟达型号 英伟达人工智能设备价格