核心观点

英伟达的人工智能业务在带来算力革命的同时,也带来了巨大的能耗挑战,英伟达并非被动地消耗能源,而是通过其芯片架构、软件栈和生态系统,正在成为AI能耗问题的核心解决者,其商业模式已经从单纯的“卖GPU”转变为“提供整套AI算力解决方案”,而能耗效率是这套方案的核心竞争力。

能耗挑战:为什么AI能耗如此巨大?

要理解英伟达的角色,首先要明白AI为什么是“电老虎”。

-

AI训练的指数级增长

- 模型规模:以GPT-4为代表的巨型语言模型,拥有数万亿个参数,训练这样的模型需要进行海量的矩阵运算,每一次运算都需要消耗电能。

- 数据量:训练数据集的规模呈指数级增长,处理这些数据本身就消耗巨大能量。

- 计算时长:训练一个顶级AI模型可能需要数周甚至数月,在数千颗GPU组成的集群上不间断运行,其总能耗相当于一个小型城镇的日常用电量。

-

推理的持续消耗

- 训练是一次性的,但推理(AI提供服务,如ChatGPT回答你的问题)是持续不断的,随着AI应用普及(自动驾驶、智能客服、内容生成等),全球范围内的AI推理任务数量将呈爆炸式增长,其总能耗将超过训练能耗。

- 推理对延迟和响应速度要求高,通常需要7x24小时在线,进一步增加了能耗。

-

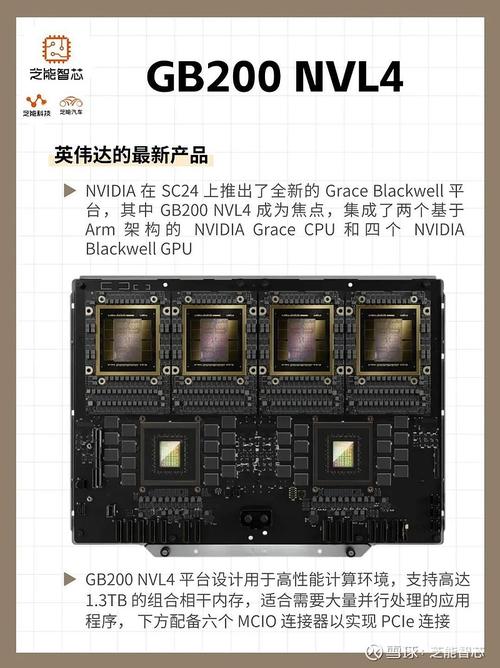

数据中心的高密度

(图片来源网络,侵删)

(图片来源网络,侵删)- AI服务器(通常包含8颗A100/H100 GPU)的功率密度极高,单台服务器功耗可达10kW以上,是传统服务器的5-10倍。

- 这给数据中心的供电和散热带来了巨大压力,需要更强大的电力基础设施和更高效的冷却技术(如液冷),这本身就是巨大的能源消耗。

简单比喻:如果说以前的计算机是几辆小轿车,那么AI计算中心就是一支由数百辆重型卡车组成的舰队,它们不仅“喝油”(耗电)快,而且还需要庞大的“加油站”(电力)和“维修冷却站”(散热系统)。

英伟达的能耗优化策略:从“问题制造者”到“方案解决者”

面对巨大的能耗挑战,英伟达从硬件、软件到系统层面,构建了一套完整的能耗优化方案。

硬件层面:追求极致的能效比

-

架构创新:

- Transformer引擎:在H100/B200等最新GPU中,专门针对AI大模型最核心的Transformer计算单元进行了硬件级优化,它能自动选择最高效的算法和精度(如FP8),在几乎不损失性能的情况下,大幅降低计算所需的能耗。

- FP8(8位浮点数):引入比FP16/FP32更低的数值精度,可以在同样时间内完成更多计算,直接降低单位任务的能耗。

-

制程工艺:

采用最先进的台积电4N/5nm制程工艺,在同样晶体管数量下,更先进的制程意味着更低的漏电和更高的晶体管开关效率,从而降低功耗。

-

硬件级计算稀疏化:

AI模型中存在大量“零”或“冗余”的参数,英伟达的硬件可以自动识别并跳过这些无效计算,只处理有效数据,这能带来最高可达2倍的能效提升。

软件与系统层面:让每一瓦电都物尽其用

-

CUDA生态系统:

- CUDA不仅仅是编程接口,更是一个庞大的优化库集合,通过cuDNN、TensorRT等库,开发者可以轻松地将AI应用深度优化到英伟达硬件上,榨干每一颗GPU的性能。性能越高,意味着完成同样任务所需的时间越短,总能耗就越低。

-

AI基础设施软件栈:

- NVIDIA DOCA:为DPU(数据处理器)提供软件栈,将网络、存储等基础设施任务从CPU和GPU上卸载下来,解放宝贵的GPU资源用于核心AI计算,间接提升了整体能效。

- NVIDIA NeMo™/Megatron-LM:提供大模型训练和推理的优化框架,支持模型并行、张量并行、流水线并行等技术,可以在更大规模的集群上高效训练,通过优化通信和计算来降低整体能耗。

-

数据中心优化:

- 推出NVIDIA BlueField® DPU(Data Processing Unit),将网络、存储和安全功能集成到一个独立的处理器上,这使得数据中心可以实现“计算与存储分离”,数据不需要在服务器之间大量移动,大大减少了网络传输带来的能耗。

- 与合作伙伴(如NVIDIA、Supermicro、浪潮信息)一起设计和推广液冷服务器,液冷的散热效率远高于传统风冷,能效比可提升高达30%,是解决高密度GPU散热问题的关键技术。

量化指标:性能功耗比

英伟达在宣传其新产品时,越来越强调一个关键指标:性能功耗比,即每瓦特算力,H100相对于上一代A100,在AI训练性能上提升了最多6倍,而能效比提升了最多9倍,这意味着,完成同样的训练任务,H100消耗的电能可能只有A100的几分之一。

能耗带来的影响与未来展望

-

对数据中心和企业的挑战

- 成本飙升:电费和散热成本已成为AI数据中心运营的主要开支,这使得AI的拥有成本非常高昂,只有少数科技巨头和大型企业能够负担。

- “绿色AI”的压力:环保组织和公众对AI的碳足迹日益关注,企业需要证明其AI应用是“绿色”的,这倒逼他们必须采用像英伟达这样能效更高的解决方案。

-

英伟达的商业优势

- 护城河:通过构建从芯片、驱动、库、框架到数据中心解决方案的完整生态系统,英伟达建立了极高的技术壁垒,竞争对手(如AMD、Intel)很难在短时间内复制这套体系。

- 锁定客户:客户一旦深度使用CUDA和NVIDIA的软件栈,迁移成本极高,这使得英伟达能够维持其市场领导地位和定价权。

- 开辟新市场:能效问题催生了对AI基础设施咨询、优化、液冷改造等服务的需求,英伟达正积极进入这些高附加值的服务市场。

-

未来趋势

- Chiplet(芯粒)技术:通过将不同功能的芯片模块封装在一起,可以提高良率、降低成本,并可能针对不同任务进行更灵活的能效优化。

- 专用AI芯片:虽然通用GPU仍是主流,但针对特定场景(如推理)的专用ASIC芯片因其极致的能效比,将长期存在并发展。

- 软件定义的能效:未来AI集群的管理将更加智能化,软件可以根据实时电价、温度和任务优先级,动态调整GPU的工作状态,实现全局能效最优。

英伟达与AI能耗的关系是辩证统一的。

- 一方面,英伟达的GPU是当前最强大的AI算力引擎,其大规模部署确实推高了全球AI的总体能耗。

- 另一方面,英伟达也是目前市场上最致力于解决AI能效问题的公司,通过硬件架构创新、软件深度优化和端到端系统设计,它不断提供性能功耗比更高的解决方案,帮助AI产业走向更可持续、更经济、更绿色的未来。

讨论英伟达的AI能耗,不能简单地将其视为一个“耗电大户”,而应看到它作为“AI能源效率革命”核心推动者的关键角色,其未来的竞争,很大程度上将取决于谁能在这场“能效军备竞赛”中胜出。

标签: 英伟达AI节能方案 降低AI芯片能耗技术 高效AI算力优化方法