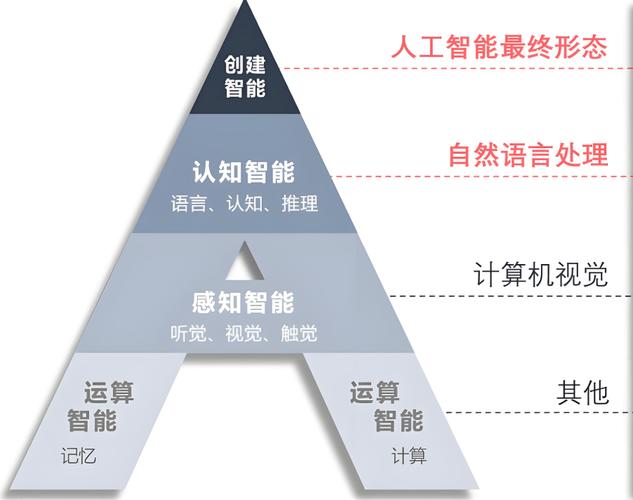

传统计算架构是为解决“确定性问题”而生的,而人工智能(特别是深度学习)则需要为解决“不确定性问题”而生的全新架构。

下面我们从几个维度进行详细对比和解释。

传统计算架构:冯·诺依曼体系的天下

我们日常接触的绝大多数计算机,从个人电脑到服务器,都遵循着冯·诺依曼架构,它的核心思想是“存储程序”,即指令和数据存储在同一内存中,CPU通过总线依次取出指令和数据进行处理。

核心特点:

- 串行处理:CPU核心在同一时间只能执行一条指令(尽管现代CPU有多级流水线和多核,但本质上仍是按指令序列执行),它擅长处理逻辑清晰、步骤明确的任务。

- 逻辑运算为主:擅长布尔逻辑(与、或、非)、算术运算和条件判断,编程的本质就是将这些逻辑步骤清晰地告诉计算机。

- 数据驱动:程序是静态的,输入数据后,程序按照预设的流程处理数据,输出确定的结果。

输入 + 程序 = 确定输出。 - 通用性:通过改变软件(程序),同一套硬件可以处理各种不同的任务,从文字处理到科学计算。

传统计算架构的瓶颈:

当面对人工智能任务时,尤其是深度学习,冯·诺依曼架构暴露出了严重的瓶颈:

- “内存墙”(Memory Wall):AI算法(尤其是神经网络)需要进行海量的并行数据计算,而CPU需要不断地在计算单元和内存之间来回搬运数据,这个数据搬运的耗时远大于计算本身,就像一堵墙一样阻碍了性能。

- 计算范式不匹配:AI需要的是大规模并行计算,而CPU是为串行逻辑处理优化的,用CPU做AI训练,就像用一把锋利的手术刀去劈柴,既不高效也不合适。

- 功耗问题:频繁的数据搬运消耗了大量能量,导致计算效率低下,成本高昂。

人工智能:数据驱动的并行革命

人工智能,特别是深度学习,其工作原理与传统计算截然不同。

核心特点:

- 大规模并行计算:神经网络由数百万甚至数十亿个神经元(参数)组成,在训练过程中,需要同时计算所有神经元的加权和与激活函数,这本质上是成千上万次相同的计算任务,需要同时进行。

- 数据驱动与模型迭代:AI的核心不是预设的规则,而是从海量数据中学习出规律,这个过程是迭代的:通过不断调整模型参数(权重),使模型的预测结果与真实结果的误差越来越小,这需要巨量的矩阵和向量运算。

- 计算密集型:训练一个大型AI模型(如GPT-3)需要进行数千万亿甚至更多的浮点运算,这被称为“算力”的巨大消耗。

- 对特定硬件的强依赖:为了满足上述需求,AI催生了对专用硬件的极致追求。

AI所需的新型计算架构:

为了克服冯·诺依曼架构的瓶颈,专为AI设计的硬件架构应运而生,它们的核心思想是“计算贴近数据”,减少数据搬运,最大化并行计算能力。

-

GPU (图形处理器):

- 起源:最初为处理图形渲染中的像素并行计算而设计。

- 优势:拥有成千上个小而简单的计算核心,非常适合AI中大规模的并行矩阵运算,它将冯-诺依曼架构中的“内存墙”问题缓解了很多,但并未从根本上解决。

-

TPU (张量处理器):

- 设计方:Google

- 优势:专为张量运算(深度学习的核心)而设计的ASIC(专用集成电路),它将计算单元和内存(称为“矩阵乘法单元”)更紧密地结合在一起,极大地减少了数据搬运,能效比远超GPU。

-

NPU (神经网络处理器):

(图片来源网络,侵删)

(图片来源网络,侵删)- 设计方:华为、寒武纪等公司

- 优势:与TPU类似,是针对神经网络推理和训练的专用处理器,通常集成在手机、边缘设备等终端上,实现高效的本地AI计算。

-

新型计算架构探索:

- 存内计算:这是对冯-诺依曼架构的颠覆性尝试,它将计算单元直接集成在存储器中,在数据存储的地方直接进行计算,彻底消除了“内存墙”,这是未来极具潜力的方向。

- 光子计算:利用光子进行计算,速度更快、能耗更低,特别适合AI的矩阵运算。

核心差异对比表

| 特性维度 | 传统计算架构 | 人工智能计算架构 |

|---|---|---|

| 核心目标 | 执行精确的逻辑和算术运算 | 从数据中学习模式和规律 |

| 处理范式 | 串行、指令驱动 | 并行、数据驱动 |

| 计算任务 | IF-ELSE循环、条件判断、事务处理 | 矩阵乘法、卷积、大规模浮点运算 |

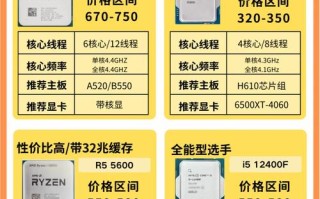

| 硬件需求 | 通用CPU,强调低延迟和单核性能 | 众核GPU、TPU、NPU,强调高吞吐和并行度 |

| 主要瓶颈 | CPU处理速度、内存访问延迟 | 数据搬运(内存墙)、功耗、算力 |

| 编程模型 | C++, Java等,基于指令和算法 | Python + TensorFlow/PyTorch,基于计算图和自动微分 |

| 典型应用 | 数据库、操作系统、Web服务器、办公软件 | 图像识别、自然语言处理、自动驾驶、科学模拟 |

融合与未来趋势

传统计算和AI计算并非完全对立,而是正在走向深度融合。

-

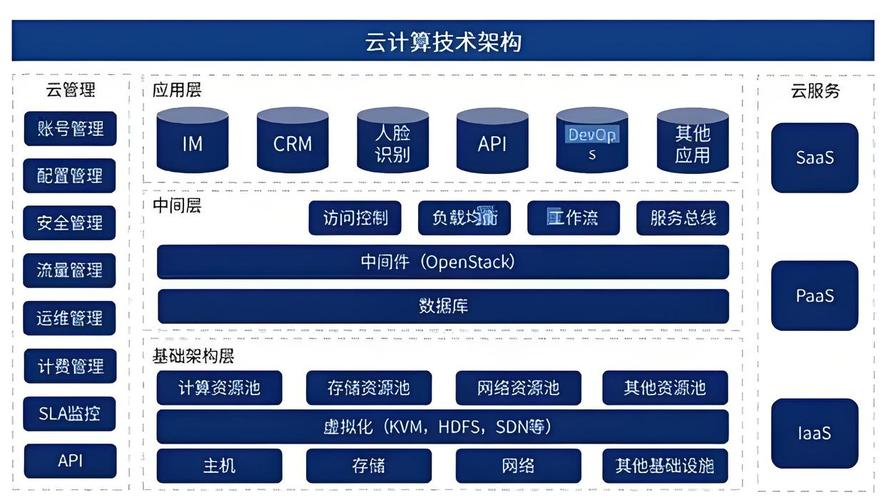

异构计算:现代服务器和终端设备普遍采用异构计算架构,在一个系统中,CPU负责处理逻辑控制、任务调度等串行任务;GPU/TPU/NPU负责处理AI模型的并行计算任务,它们协同工作,各司其职。

- 例子:你的手机用CPU(高通/联发科)打电话、发微信,同时用NPU(苹果的Neural Engine/华为的NPU)进行人脸解锁、AI美颜和拍照优化。

-

AI for 传统计算:人工智能反过来也在优化传统计算架构,用AI算法来动态调度CPU资源、优化数据中心能耗、预测硬件故障等,让传统系统运行得更高效。

-

传统计算 for AI:AI的发展离不开强大的传统计算基础设施,没有分布式文件系统(如Hadoop)、高速网络和云计算平台,我们无法存储和传输训练AI所需的海量数据。

- 传统计算架构是数字世界的基石,它构建了我们熟悉的软件和应用生态,擅长处理有明确规则的任务。

- 人工智能计算架构是数字世界的新引擎,它让计算机拥有了“学习和思考”的能力,擅长处理模糊、复杂、非结构化的任务,但这需要全新的、以“并行”和“数据为中心”的硬件支持。

两者正在形成一个“大脑与神经系统”的关系:传统计算架构(CPU)如同负责思考和决策的“大脑皮层”,而AI计算架构(GPU/TPU)则如同负责快速感知和处理的“视觉/听觉等感官系统”,只有当它们协同工作时,我们才能构建出更强大、更智能的未来计算世界。

标签: 传统计算架构支撑AI发展的关键技术 传统计算架构优化AI性能的方法 传统计算架构与人工智能的协同演进路径