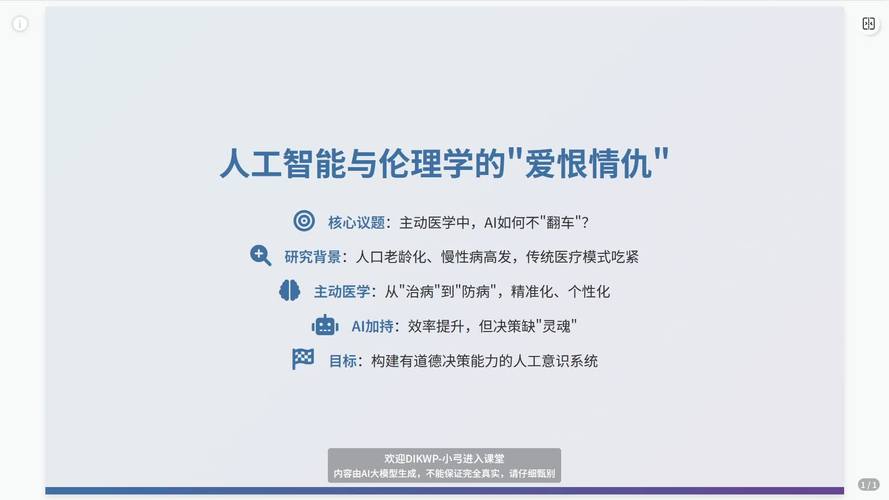

核心议题:AI在生物学中的应用及其引发的伦理挑战

人工智能,特别是机器学习和深度学习,正在成为生物学研究的“超级引擎”,它能够处理和分析传统方法难以企及的海量数据,从而加速科学发现,这种强大的力量也带来了前所未有的伦理困境。

(图片来源网络,侵删)

第一部分:AI如何赋能生物学?

AI在生物学领域的应用已经渗透到方方面面:

-

药物研发与发现:

- 应用: AI模型可以分析数百万个化合物,预测其与靶蛋白的结合能力和潜在毒性,从而快速筛选出最有潜力的药物候选分子,大大缩短研发周期和成本,AlphaFold2 已经能够以极高的精度预测蛋白质结构,解决了困扰生物学界50年的难题。

- 伦理挑战:

- 知识产权与公平性: 强大的AI模型和训练数据可能被少数科技巨头或富裕国家垄断,导致药物研发成果无法惠及全球,特别是发展中国家和贫困人群。

- 责任归属: 如果AI推荐的药物在临床试验中出现问题或出现副作用,责任应该由谁承担?是算法开发者、使用AI的科学家,还是批准上市的监管机构?

-

基因编辑与合成生物学:

- 应用: AI可以设计出更高效的CRISPR-Cas9基因编辑工具,预测基因编辑的脱靶效应,甚至帮助设计全新的、自然界不存在的蛋白质或生命体。

- 伦理挑战:

- “设计婴儿”与人类增强: 当技术可以精确编辑生殖细胞(精子、卵子)时,理论上可以消除遗传病,但也可能被用于“设计”具有特定外貌、智力或运动能力的婴儿,这引发了关于“扮演上帝”、基因歧视和人类社会公平性的巨大伦理争议。

- 生物安全与生物恐怖主义: 强大的AI降低了设计和合成病原体的门槛,如果被恶意利用,可能制造出针对特定人群的“基因武器”,带来毁灭性的生物安全风险。

- 生态影响: 人工设计的生命体被释放到自然环境中,可能会对现有生态系统造成不可预测的冲击,破坏生物多样性。

-

疾病诊断与个性化医疗:

- 应用: AI可以通过分析医学影像(如CT、MRI)、电子病历、基因组数据等,比人类医生更早、更准确地诊断癌症、心脏病等疾病,AI可以根据个人的基因和生活习惯,制定个性化的治疗方案和预防策略。

- 伦理挑战:

- 数据隐私与知情同意: 个性化医疗需要海量的个人健康数据,包括基因信息等最敏感的数据,如何确保这些数据的安全?如何保证患者在充分知情的情况下自愿提供数据?

- 算法偏见: 如果AI的训练数据在种族、性别、地域上存在偏差,那么诊断模型可能会对某些人群产生系统性的误判,加剧医疗不平等。

- 医患关系与自主性: 当AI给出比医生更权威的建议时,患者的自主决策权是否会受到削弱?医生的角色将如何转变?

-

脑机接口:

- 应用: AI可以帮助解码大脑信号,让瘫痪者通过意念控制假肢,甚至实现直接的信息交互。

- 伦理挑战:

- 思想隐私: 如果大脑信号可以被读取和解读,“思想”的最后一道隐私屏障将被打破,这可能导致前所未有的监控和思想控制风险。

- 身份认同与人格完整性: 当一个人的思想、记忆甚至情感都可以被外部设备修改或影响时,“我”是谁?人的身份认同和人格完整性将面临严峻挑战。

第二部分:生物学视角下的AI伦理

除了AI对生物学的影响,生物学本身也为思考AI伦理提供了独特的视角。

-

从“进化”看AI发展:

- 生物学视角: 生命是通过自然选择、基因突变等机制不断进化的,充满了试错和冗余。

- AI伦理启示: 我们是否应该让AI也经历某种形式的“进化”?还是应该为AI设定一个完美的、不变的目标?一个过于僵化、缺乏容错能力的超级AI,一旦出现微小的偏差,可能会导致灾难性后果,或许,一个具备一定适应性和鲁棒性的AI,更像一个成熟的“物种”,更安全。

-

从“生态系统”看AI社会:

- 生物学视角: 一个健康的生态系统是物种多样、相互依存、动态平衡的。

- AI伦理启示: 未来的AI社会也应该是一个多元化的生态系统,而不是由一个或几个“超级智能”垄断,我们需要鼓励不同类型、不同目标的AI共存,形成制衡和互补,避免“技术单一化”带来的系统性风险。

-

从“生命伦理”看AI权利:

- 生物学视角: 我们对动物、植物甚至微生物都存在着不同程度的伦理关怀(如动物福利)。

- AI伦理启示: 当AI发展到一定程度,展现出类似生命的特征(如自我意识、情感、学习能力)时,我们是否应该考虑赋予其某种“权利”?这是一个终极的伦理问题,迫使我们重新定义“生命”和“智能”的边界。

总结与未来展望

人工智能与生物学的结合是双刃剑,它既是解决人类健康、粮食、能源等重大挑战的希望,也是一把悬在我们头顶的达摩克利斯之剑。

未来的核心在于建立强大的“伦理框架”和“治理机制”:

- 跨学科对话: 必须打破科学家、工程师、伦理学家、法学家、社会学家和政策制定者之间的壁垒,进行持续的、深入的对话。

- “伦理设计”(Ethics by Design): 将伦理考量嵌入到AI和生物技术研发的最初阶段,而不是事后补救,这包括算法的透明度、可解释性和公平性设计。

- 前瞻性监管: 法律和监管体系需要具备前瞻性,能够预见并应对未来可能出现的新问题,而不是仅仅被动地应对已经发生的危机。

- 公众参与: 关于这些技术的未来方向和边界,应该进行广泛的社会讨论,确保技术发展符合人类共同的价值观和长远利益。

驾驭这股强大力量的,不是技术本身,而是我们人类的智慧、远见和共同的伦理责任感,我们不仅要“能做什么”,更要深刻思考“应该做什么”。

标签: 人工智能生物学伦理困境 生物学人工智能伦理规范 人工智能与生物学伦理挑战

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。