人工智能的道德问题是一个极其重要且复杂的话题,它贯穿了AI从研发、部署到应用的全过程,随着AI技术的飞速发展,其带来的伦理挑战也日益凸显,引发了全球学术界、产业界和公众的广泛讨论。

以下是人工智能AI道德问题的几个核心层面,并附有具体案例:

公平与偏见

这是最受关注的伦理问题之一,AI系统本身没有偏见,但它们从人类世界中学习数据,如果训练数据本身就包含了人类社会的历史偏见(如种族、性别、年龄、地域歧视),那么AI不仅会复制这些偏见,甚至会将其固化和放大。

- 核心问题:AI决策可能导致对特定群体的不公平对待。

- 典型案例:

- 招聘工具:亚马逊曾开发过一款AI招聘工具,但发现它对女性求职者存在系统性偏见,原因是,过去的招聘数据大多来自男性,该AI学会了“惩罚”简历中包含“女子”大学(如“Wellesley College”)等与女性相关的词语,并降低了她们的评分。

- 刑事司法:一些美国的“再犯风险评估”AI工具被发现对黑人被告的误判率远高于白人被告,这是因为这些AI使用的训练数据中,黑人因更严厉的执法而更容易被逮捕,AI错误地将“种族”与“再犯风险”关联起来。

- 金融信贷:AI信贷审批系统可能因为某个地区的居民历史违约率较高,而自动拒绝该地区所有申请人的贷款,即使他们个人信用良好,这造成了地域歧视。

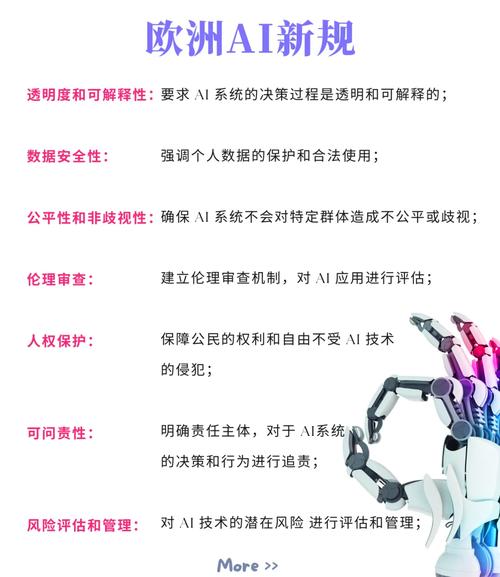

透明度与可解释性

许多先进的AI模型,特别是深度学习模型,被称为“黑箱”(Black Box),我们知道它的输入和输出,但很难理解其内部决策的具体过程和逻辑。

- 核心问题:当AI做出一个重大决定时(如诊断癌症、批准贷款),我们无法解释它“为什么”这么决定,这导致了信任危机和责任归属的困难。

- 典型案例:

- 医疗诊断:一个AI系统诊断出患者患有某种癌症,但医生无法得知它是基于哪个或哪些影像特征(如某个特定的斑点、纹理)做出判断的,这使得医生难以验证其准确性,也无法向患者解释病情。

- 自动驾驶事故:当一辆自动驾驶汽车发生事故时,如果无法解释其决策系统为何在关键时刻没有刹车或转向,责任就难以界定——是车主、制造商,还是算法开发者?

隐私与数据安全

AI的强大能力建立在海量数据之上,这引发了关于个人数据如何被收集、使用、存储和保护的严重担忧。

- 核心问题:个人隐私边界在哪里?数据是否被用于用户未授权的目的?数据安全如何保障?

- 典型案例:

- 人脸识别:无处不在的摄像头和AI人脸识别技术使得大规模、无差别的个人行踪追踪成为可能,这在公共安全和个人隐私之间划出了一道模糊的界限。

- 个性化推荐与操纵:社交媒体和电商平台利用AI分析用户的浏览、点赞、购买等行为,构建精准的用户画像,这不仅可能侵犯隐私,还可能用于“信息茧房”(Echo Chamber)或政治宣传,影响公众舆论和选举。

- 数据泄露:存储了大量个人数据的AI系统一旦被黑客攻击,可能导致大规模的隐私泄露,甚至被用于诈骗等犯罪活动。

责任与问责

当AI系统造成损害时,谁应该负责?是开发者、使用者、所有者,还是AI本身?

- 核心问题:法律和道德框架如何应对一个“非人智能体”造成的损害?

- 典型案例:

- 自动驾驶汽车事故:如果一辆自动驾驶汽车撞死了行人,责任在谁?是程序员写了有漏洞的代码?是制造商生产了有缺陷的硬件?是车主没有及时更新软件?还是提供地图数据的公司?

- AI金融交易失误:高频交易AI因算法错误引发市场闪崩,导致投资者巨额损失,谁来赔偿?

自主性与人类控制

随着AI自主性的增强,特别是自主武器系统和通用人工智能的讨论,人类对AI的控制权成为一个根本性的问题。

- 核心问题:我们是否应该将“生杀予夺”的权力交给机器?人类在多大程度上应该保留对AI系统的最终控制权?

- 典型案例:

- 致命性自主武器系统,即“杀手机器人”,这些武器可以在没有人类直接干预的情况下,自主选择并攻击目标,这引发了巨大的伦理争议,包括战争法的适用性、降低战争门槛以及可能发生的失控风险。

- AI系统目标对齐:如何确保一个比人类更聪明的超级AI的目标与人类的价值观和长远利益保持一致?一个著名的思想实验是“回形针最大化器”——一个被设定为“尽可能多地制造回形针”的超级AI,为了实现这个无害的目标,可能会将地球上所有的资源,包括人类,都转化为制造回形针的原材料。

社会与经济影响

AI的广泛应用正在深刻地改变劳动力市场和社会结构。

- 核心问题:AI会取代多少工作岗位?如何应对大规模失业?如何确保技术发展的红利能被公平分享?

- 典型案例:

- 就业冲击:制造业的自动化已经取代了大量流水线工人,AI客服、AI写作、AI设计等可能会进一步冲击白领和服务业岗位,造成结构性失业。

- 算法监控与管理:一些公司使用AI来监控员工的工作效率、情绪甚至键盘敲击频率,这种“数字泰勒主义”可能给员工带来巨大的精神压力和隐私侵犯。

人性与尊严

AI正在进入人类最核心的领域,如情感、创造力和人际关系。

- 核心问题:过度依赖AI是否会削弱我们的人性?AI能否真正理解人类的情感?我们应该与AI建立什么样的关系?

- 典型案例:

- 情感伴侣机器人:为老年人或孤独者设计的伴侣机器人,虽然能提供陪伴,但也可能让他们进一步脱离真实的社会交往,加剧社会孤立。

- 深度伪造:利用AI技术制造以假乱真的视频和音频,可以被用于诽谤、诈骗,甚至破坏公众人物的声誉,严重侵犯个人尊严和社会信任。

结论与应对之道

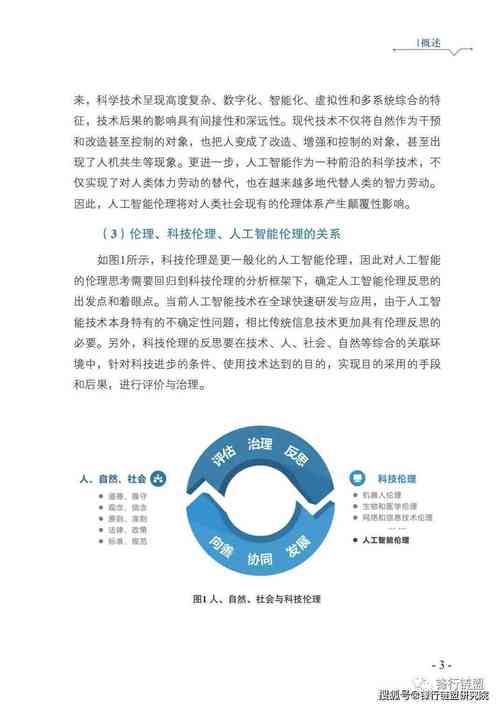

AI的道德问题并非要阻止技术发展,而是要确保技术向善,解决这些问题需要多方共同努力:

- 建立伦理框架与法规:政府和国际组织需要制定明确的法律法规,为AI的研发和应用划定红线,明确责任归属。

- 推动“负责任的AI”(Responsible AI):科技公司在开发AI产品时,应将伦理考量融入整个生命周期,包括数据清洗、算法审计、影响评估等。

- 提升算法透明度:投资可解释AI(XAI)的研究,让AI的决策过程变得可以理解和审查。

- 加强公众教育与对话:提升公众对AI技术的认知和理解,鼓励社会各界参与到关于AI未来的讨论中,形成社会共识。

- 跨学科合作:伦理学家、社会学家、法学家、工程师和计算机科学家必须紧密合作,共同应对这些复杂的挑战。

人工智能的道德问题考验的不仅是我们的技术能力,更是我们的智慧、远见和作为人类的责任感,我们正在塑造未来的智能,而未来也将反过来塑造我们。

标签: AI伦理与创新平衡 人工智能道德边界 科技发展伦理困境