这是一个非常核心的问题。GPU在人工智能中扮演着“引擎”的角色,没有它,现代AI的快速发展几乎是不可能的。

我们可以从以下几个方面来理解为什么GPU对于AI如此重要:

核心原因:GPU的“天生”优势

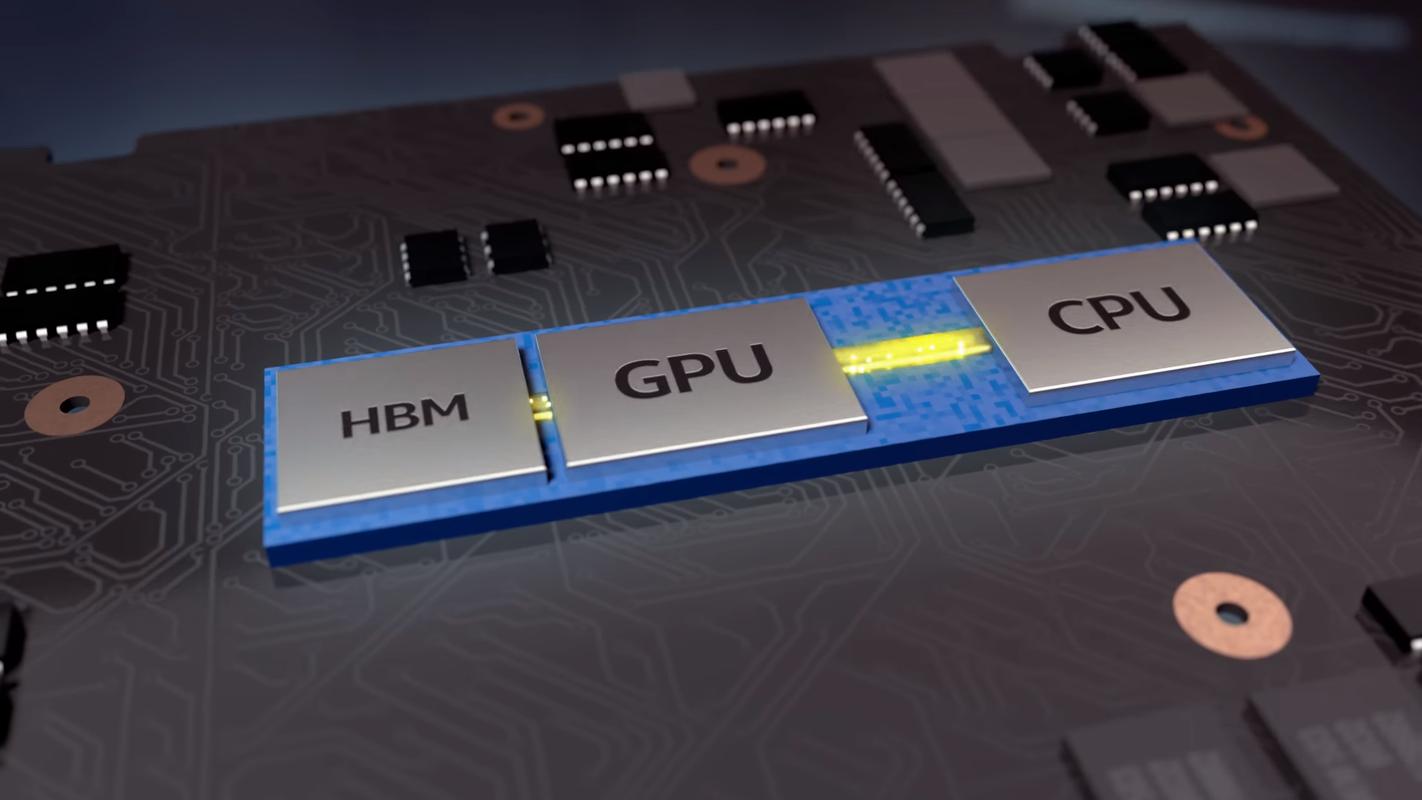

GPU(图形处理器)最初是为了处理电脑游戏中的图形渲染而设计的,想象一下,在游戏中,屏幕上的每一个像素点都需要被计算和着色,这涉及到海量的、并行的数学运算(主要是矩阵和向量运算),这种计算需求恰好与AI模型,特别是深度学习模型的计算需求完美契合。

a. 并行计算架构

这是最根本的原因。

- CPU (中央处理器):像一位“专家”或“总经理”,它擅长处理复杂的、串行的逻辑任务,比如运行操作系统、处理应用程序指令等,它的核心数量相对较少(几个到几十个),但每个核心都非常强大,可以快速处理一系列不同的任务。

- GPU (图形处理器):像一支“庞大的军队”或“工厂里的流水线”,它拥有成千上万个小小的计算核心,这些核心虽然单个能力不如CPU核心,但它们可以同时执行完全相同的计算任务。

为什么这对AI重要?

现代AI的核心是神经网络,而神经网络的本质就是大量的矩阵乘法,一个常见的操作是:输出 = 输入数据 × 权重矩阵,在这个计算中,输入数据中的每一个元素都需要和权重矩阵中的对应元素进行相乘再相加,这些计算是完全独立的,可以同时进行,GPU的并行架构可以一次性处理成千上万个这样的计算,效率极高,而CPU则需要一个一个地处理,速度就慢得多。

一个形象的比喻:

- CPU:一个顶级的厨师,可以独立完成一道复杂菜品的所有步骤(切、炒、调味),速度很快。

- GPU:一个大型后厨,有100个帮厨,虽然每个帮厨只会做一种简单的切菜或摆盘,但100个帮厨同时工作,可以瞬间处理掉100份蔬菜的准备工作,远超那位顶级厨师。

b. 高内存带宽

AI模型训练需要处理海量的数据(如图像、文本),这些数据都需要从内存中读取,GPU拥有非常高的内存带宽,意味着它可以更快地在核心和内存之间传输数据,避免了核心因为“没数据可算”而空闲下来,从而保证了并行架构的最大效率。

c. 针对特定运算的优化

GPU的硬件设计特别擅长执行深度学习中常见的数学运算,

- 张量运算

- 浮点运算

- 卷积运算 (Convolution,在图像识别中至关重要)

这些运算在GPU上都有专门的硬件指令集和优化路径,执行速度远超CPU。

AI发展的关键需求:规模和速度

深度学习的成功很大程度上依赖于“数据量”和“模型规模”的爆炸式增长。

- 更大的模型:像GPT-4这样的语言模型,其参数量达到了万亿级别,训练这样的模型需要天文数字的计算量。

- 更多的数据:训练一个图像识别模型,可能需要数百万甚至上亿张图片。

没有GPU,训练这些模型将需要数百年甚至更长时间,而使用GPU,训练时间可以从数年缩短到数周、数天,甚至数小时,这种数量级的速度提升,使得研究人员能够快速地实验、迭代和改进他们的模型,从而极大地推动了AI技术的进步。

生态系统的成熟

除了硬件本身,软件生态也至关重要。

- CUDA (Compute Unified Device Architecture):这是NVIDIA(英伟达)推出的一个并行计算平台和编程模型,它为开发者提供了一个非常方便的接口,让他们可以使用C++或Python等语言来编写在GPU上运行的代码,CUDA成为了事实上的行业标准,拥有最完善的工具链、库支持和开发者社区。

- 深度学习框架:TensorFlow, PyTorch等主流框架都深度集成了CUDA,使得开发者可以非常轻松地在代码中调用GPU进行计算,而无需关心底层的硬件细节。

这种“硬件 + 软件 + 生态”的完美结合,使得GPU成为了AI开发的默认选择。

CPU vs. GPU 在AI中的角色

为了更清晰地对比,我们可以用一个表格来总结:

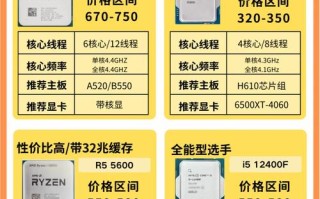

| 特性 | CPU (中央处理器) | GPU (图形处理器) |

|---|---|---|

| 核心设计理念 | 低延迟,处理复杂、串行任务 | 高吞吐量,处理海量、并行任务 |

| 核心数量 | 少 (几到几十个) | 多 (数千到数万个) |

| 内存带宽 | 相对较低 | 非常高 |

| 在AI中的角色 | 总指挥:负责数据预处理、模型逻辑控制、结果后处理等。 | 计算引擎:负责执行核心的、大规模的矩阵运算和神经网络前向/反向传播。 |

| 适用场景 | 传统计算、操作系统、数据库、游戏逻辑 | 图形渲染、科学计算、AI/深度学习训练和推理 |

结论就是:AI的“大脑”是算法和模型,而GPU则是驱动这个大脑进行高强度思考的“超级心脏”和“肌肉”。 它们天生匹配的并行计算能力,为处理神经网络中庞大规模的计算提供了无与伦比的效率,从而成为了现代人工智能技术革命的基石。

标签: GPU人工智能算力核心 人工智能核心算力引擎GPU GPU人工智能算力引擎原理