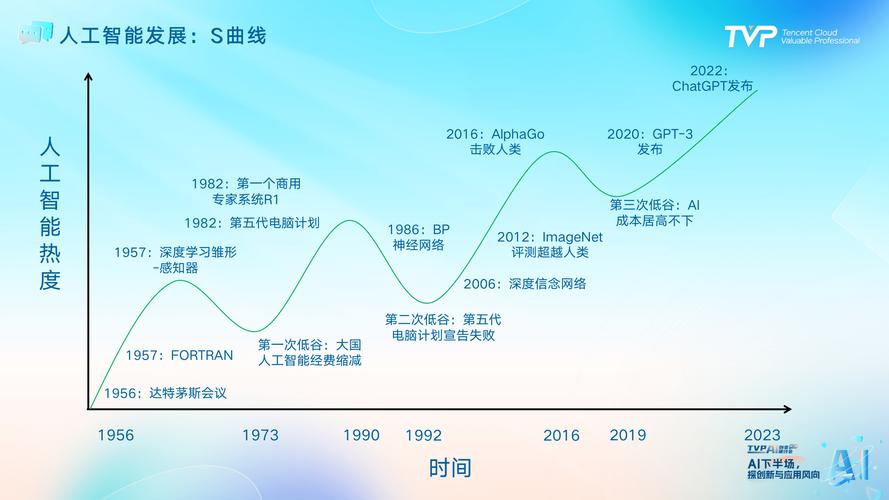

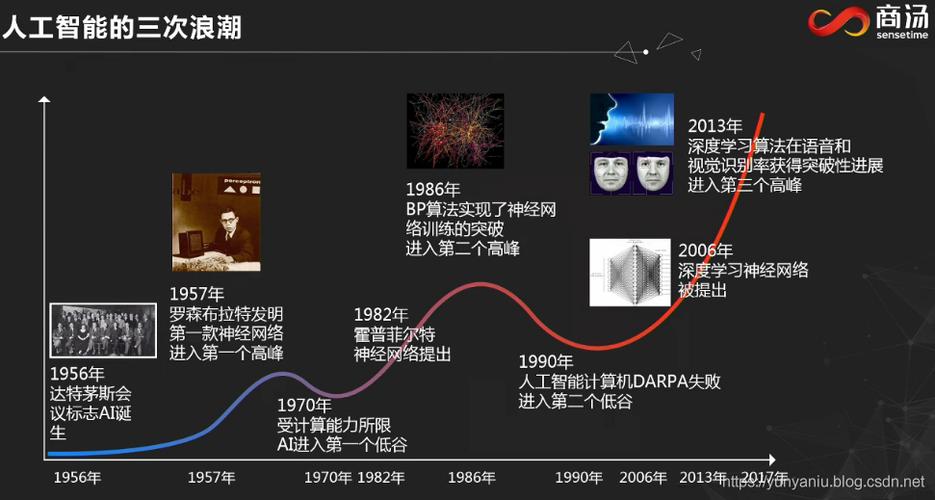

这三次浪潮并非严格的时间划分,而是以核心技术驱动力、社会关注度、产业应用深度和期望值为标志的周期性演进过程。

第一次浪潮:符号主义与逻辑推理的兴起 (20世纪50年代 - 70年代末)

这次浪潮也被称为“AI的黄金时代”或“寒冬前的繁荣”。

核心驱动力:符号主义

这一时期的主流思想是“符号主义”(Symbolism),也被称为“老式人工智能”(Good Old-Fashioned AI, GOFAI),其核心观点是:智能可以通过对符号(如单词、概念、逻辑规则)的运算和操作来模拟,人类的知识可以被编码成一套逻辑规则,计算机通过执行这些规则来解决问题。

标志性成就:

- 达特茅斯会议 (1956年): 这次会议被公认为人工智能学科诞生的标志,约翰·麦卡锡等人首次提出了“人工智能”这个术语,并设想了创造能够像人一样思考的机器。

- 逻辑理论家 (Logic Theorist, 1956): 由艾伦·纽厄尔和赫伯特·西蒙开发,被认为是第一个真正意义上的人工智能程序,能够证明数学定理。

- LISP语言 (1958): 约翰·麦卡锡发明的LISP语言,成为早期AI研究最主要的编程语言,至今仍有影响。

- 早期机器人: 如“Shakey the Robot”(1966-1972),它能够感知环境、进行逻辑推理并规划行动,是机器人学和AI结合的早期典范。

- 专家系统的雏形: 如“DENDRAL”(1965年),它能根据质谱数据推断有机化合物的分子结构,展现了AI在特定领域的应用潜力。

局限性导致第一次“AI寒冬”:

- 计算能力严重不足: 当时的计算机性能远不足以处理复杂的符号运算和大规模的知识库。

- 组合爆炸问题: 随着问题复杂度的增加,可能的组合数量会呈指数级增长,计算机很快就会陷入“状态空间爆炸”而无法求解。

- 常识知识的缺失: 符号主义系统依赖于明确编码的知识,但人类拥有的海量、模糊、不成文的常识知识,几乎不可能被完全罗列和编码。

- 数据驱动能力的匮乏: 这个时代主要依赖专家手动编写规则,而不是从数据中自动学习。

到20世纪70年代末,由于上述瓶颈以及过高期望的落空,研究经费被大幅削减,AI领域进入了第一次“寒冬”。

第二次浪潮:机器学习与统计主义的崛起 (20世纪80年代 - 2010年代初)

这次浪潮的核心驱动力从“手动编写规则”转向了“从数据中学习”。

核心驱动力:机器学习 & 统计主义

研究者们意识到,与其让计算机遵循硬编码的规则,不如给它提供大量数据,让它自己发现其中的模式和规律,这标志着“连接主义”(Connectionism,即神经网络)和“机器学习”(Machine Learning)的兴起,其背后是强大的统计学和概率论支持。

标志性成就:

- 专家系统的繁荣与衰落 (80年代): 虽然专家系统也属于符号主义,但它在80年代迎来了商业上的短暂春天,它们维护成本高、知识获取困难(“知识瓶颈”)、适应性差的缺点,使其最终未能成为主流。

- 反向传播算法的普及 (80年代中后期): 这个算法解决了多层神经网络的训练问题,使得“深度学习”在理论上成为可能,为第三次浪潮埋下了伏笔。

- 支持向量机等算法的成功: 在90年代末和21世纪初,SVM、决策树、随机森林等机器学习算法在各种分类和回归任务上取得了巨大成功,并广泛应用于垃圾邮件过滤、推荐系统、金融风控等领域。

- IBM深蓝战胜国际象棋世界冠军卡斯帕罗夫 (1997年): 这被视为AI的又一个里程碑,深蓝的成功并非模仿人类思维,而是通过强大的计算能力暴力搜索棋局,并结合人类专家知识进行评估,是“计算智能”的胜利。

局限性与过渡期:

尽管机器学习取得了巨大成功,但在很长一段时间里,它主要集中在“监督学习”上,需要大量人工标注的数据,以SVM为代表的“浅层模型”在处理图像、语音等高维、非结构化数据时,能力依然有限,公众和产业界对AI的关注度有所回升,但远未达到狂热程度,这更像是一个积蓄力量的“长冬”。

第三次浪潮:深度学习与大模型的爆发 (2012年至今)

这次浪潮由深度学习引爆,其特点是大数据、大算力、大模型,并带来了前所未有的技术突破和社会影响力。

核心驱动力:深度学习 & 大数据

深度学习是机器学习的一个分支,它使用多层神经网络(“深”网络)来自动学习数据的层次化特征,这种“端到端”的学习方式,无需人工设计特征,能够直接从原始数据(如图像像素、音频波形)中学习到复杂抽象的表示。

标志性成就:

- ImageNet竞赛的转折点 (2012年): 杰弗里·辛顿团队的AlexNet模型,在基于深度学习的卷积神经网络架构下,将图像识别的错误率大幅降低,震惊了整个学术界和工业界,正式开启了深度学习的时代。

- AlphaGo击败李世石 (2025年): DeepMind的AlphaGo结合了深度神经网络和强化学习,其“直觉”和“大局观”远超基于暴力搜索的传统程序,标志着AI在策略性、创造性思维上达到了新的高度。

- Transformer架构的提出 (2025年): 谷歌提出的Transformer模型彻底改变了自然语言处理领域,其“自注意力机制”能够更有效地处理长距离依赖,成为后来所有大型语言模型的基石。

- 生成式AI的爆发:

- GPT系列 (2025年起): OpenAI发布的GPT模型展示了强大的自然语言理解和生成能力。

- DALL-E, Midjourney, Stable Diffusion (2025年前后): 文本生成图像的技术实现了质的飞跃,让普通人也能创造出高质量的艺术作品。

- ChatGPT (2025年底): 它将大型语言模型的能力推向了公众视野,成为现象级应用,标志着通用人工智能的曙光似乎已经出现。

当前特点与挑战:

- “三驾马车”: 深度学习的成功依赖于大数据、大算力、大模型三者缺一不可。

- 从感知智能到认知智能: AI正在从“看、听、说”等感知能力,向“理解、推理、创造”等认知能力迈进。

- 面临的挑战:

- 数据依赖与偏见: 模型性能严重依赖海量高质量数据,且会学习并放大数据中的偏见。

- 可解释性差(黑箱问题): 深度模型的决策过程难以解释,这在医疗、金融等高风险领域是巨大障碍。

- 能耗巨大: 训练和运行大模型需要消耗惊人的计算资源和能源。

- 伦理与安全风险: 虚假信息、隐私泄露、就业冲击、AI对齐等问题日益凸显。

总结与展望

| 浪潮 | 时期 | 核心思想 | 关键技术 | 标志性成就 | 主要局限 |

|---|---|---|---|---|---|

| 第一次浪潮 | 1950s-1970s | 符号主义、逻辑推理 | LISP语言、逻辑推理 | 达特茅斯会议、逻辑理论家 | 计算力不足、常识缺失、组合爆炸 |

| 第二次浪潮 | 1980s-2010s | 机器学习、统计主义 | 专家系统、SVM、反向传播 | 深蓝战胜卡斯帕罗夫 | 需大量标注数据、浅层模型能力有限 |

| 第三次浪潮 | 2012s-至今 | 深度学习、端到端学习 | CNN、RNN、Transformer、GAN | ImageNet、AlphaGo、ChatGPT | 数据偏见、黑箱问题、能耗、伦理风险 |

未来展望: 我们正处在第三次浪潮的巅峰,未来AI的发展方向可能包括:

- 多模态融合: 让AI能同时理解和处理文本、图像、声音、视频等多种信息。

- 小样本/零样本学习: 降低对海量数据的依赖,让AI能像人一样“举一反三”。

- 可解释AI (XAI): 打开“黑箱”,让AI的决策过程透明可信。

- 具身智能: 将AI与机器人技术结合,让智能体在物理世界中通过交互来学习和进化。

- AI for Science: 利用AI加速科学发现,如在材料科学、药物研发、气候变化等领域发挥巨大作用。

每一次浪潮的兴起,都源于核心理论的突破和关键要素(算力、数据)的成熟,而每一次的“寒冬”,也并非技术的终结,而是对过高期望的理性回归和技术的蓄力,理解这三次浪潮,能帮助我们更清醒地看待今天AI的辉煌与挑战,并对未来保持审慎而乐观的期待。

标签: 人工智能三次浪潮特点 AI发展三次浪潮区别 人工智能三次浪潮对比