iPhone最早的人工智能:不止Siri,那些被遗忘的AI启蒙 从iOS 1到如今,iPhone的AI之路远比你想象的更早

(引言 - 吸引眼球,点明主旨)

当我们谈论iPhone与人工智能(AI)时,脑海中首先浮现的往往是Siri的俏丽声音或Face ID的精准识别,如果我们将时钟拨回到iPhone诞生之初,会发现苹果与AI的缘分,远比Siri的诞生(2011年)要早得多,那些看似简单的功能背后,实则蕴含着苹果早期AI探索的智慧火花,本文将作为你的AI考古向导,带你重温iPhone最早的人工智能应用,揭秘苹果如何在智能手机的黎明时代,悄然埋下AI的种子。 第一部分:重新定义“最早”——iPhone AI的起点并非Siri)**

很多用户搜索“iPhone最早的人工智能”,核心诉求是想知道“除了Siri,iPhone一开始就有AI吗?”答案是肯定的,Siri确实是iPhone AI发展史上的一个重要里程碑,但它并非起点,苹果的AI布局,早在第一代iPhone(2007年,iOS 1)发布时,就已经以更基础、更嵌入式的方式存在。

理解这一点,我们需要明确“人工智能”在移动设备早期并非以复杂的对话系统或深度学习模型呈现,更多体现在“智能化”的行为和决策上,这正是iPhone早期AI的核心特征。 第二部分:iPhone“初代AI”核心应用深度解析)**

iPhone最早的人工智能究竟体现在哪些“不起眼”的地方呢?让我们一同揭晓:

-

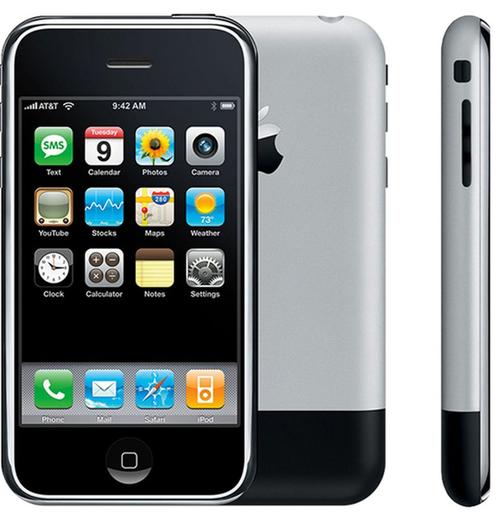

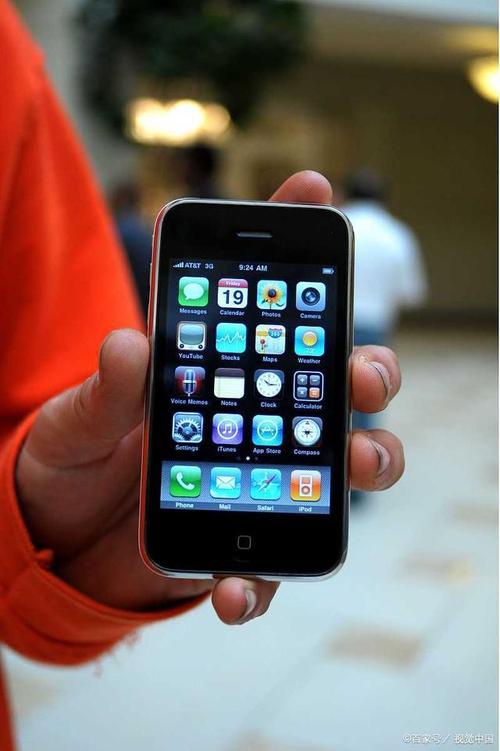

智能键盘预测与自动修正 (iOS 2.0+, 2008年)

- 功能回顾:随着iPhone 3G和iOS 2.0的推出,苹果引入了第三方应用和App Store,更重要的是,带来了更完善的文本输入体验——智能键盘预测和自动修正。

- AI内核:这绝对是iPhone早期AI的代表作之一,它基于统计语言模型和机器学习算法,当你在键盘上输入文字时,iPhone会根据你输入的上下文、常用词汇、甚至你的个人输入习惯,实时预测你可能想输入的单词,并在候选栏中显示,如果你输入了错误的拼写(teh”),它会自动修正为“the”,这背后是模型对海量语言数据的学习和对用户行为的智能分析。

- 用户价值:极大地提升了输入效率和准确性,降低了用户的学习成本,让iPhone的触屏键盘变得“可用”甚至“好用”,这比后来很多Android手机的类似功能要早。

-

智能联系人搜索与排序 (iOS 1.0+, 2007年)

- 功能回顾:在第一代iPhone的“电话”应用中,用户可以快速搜索联系人,输入名字的一部分,联系人列表会实时过滤并高亮显示匹配项。

- AI内核:虽然看似简单,但这种实时模糊搜索和排序算法已经具备了AI的雏形,它不仅仅是简单的字符串匹配,还考虑了联系人的使用频率(常用联系人会优先显示)、姓名拼音等多维度因素,以最快的速度为用户提供最可能的结果。

- 用户价值:在联系人日益增多的今天,这种智能搜索功能是提升用户体验的关键,iPhone从一开始就做到了这一点,体现了对用户需求的深刻洞察。

-

iPod智能播放列表与音乐推荐 (早期iOS,与iTunes联动)

(图片来源网络,侵删)

(图片来源网络,侵删)- 功能回顾:iPhone作为iPod的延续,其音乐管理功能强大。“智能播放列表”允许用户根据特定规则(如风格、评级、播放次数等)自动生成播放列表。

- AI内核:这背后是规则引擎和初步的数据挖掘,通过分析用户的听歌历史、评分、播放次数等数据,iPhone能够理解用户的音乐偏好,并主动为其整理和推荐音乐,虽然不如现在的个性化推荐算法复杂,但“智能”二字已经名副其实。

- 用户价值:让用户从海量音乐中轻松发现和管理自己喜欢的歌曲,提升了音乐消费的体验。

-

照片应用的智能分类与面部识别萌芽 (iOS 5+, 2011年)

- 功能回顾:在iOS 5中,照片应用引入了“地点相册”功能,可以根据照片拍摄的地理位置自动分类,虽然不是严格的面部识别,但已经具备了基于元数据进行智能分类的AI思维。

- AI内核:这涉及到地理信息数据(GIS)的处理和关联,通过读取照片中的EXIF信息中的GPS数据,iPhone能够将照片按地点组织起来,这是一种基于规则和数据的智能化处理,这为后来iOS 10中真正的“人物相册”(面部识别)奠定了基础。

- 用户价值:让用户能够更便捷地回忆和查找特定场景下的照片,管理海量图片变得更加轻松。

-

语音控制的雏形 (iOS 3.0+, 2009年)

- 功能回顾:在iOS 3.0中,苹果引入了“语音控制”功能,用户可以通过按住Home键来拨打电话、播放音乐等。

- AI内核:这可以看作是Siri的“前身”,它主要基于命令词识别和语法解析,虽然远不如Siri自然语言理解能力强,但已经实现了通过语音指令控制设备的初步尝试,是语音交互AI的重要一步。

- 用户价值:解放双手,提供了更便捷的交互方式,尤其是在驾驶等场景下。 第三部分:早期iPhone AI的特点与苹果的AI哲学)**

回顾iPhone最早的人工智能应用,我们可以总结出几个显著特点:

- 嵌入式与实用性:AI并非作为独立的应用存在,而是深度集成到系统的核心功能中,解决用户的实际痛点。

- 数据驱动与用户习惯学习:早期AI虽然模型简单,但已经开始利用用户行为数据(如输入习惯、联系人使用频率、听歌历史等)来优化体验。

- “润物细无声”:苹果的AI设计哲学更强调“感知智能”而非“认知智能”的过早暴露,用户能感受到智能,但无需关心其背后的复杂技术。

- 软硬件结合的优势:iPhone的AI早期就得益于苹果对硬件(如处理器、传感器)的深度掌控,能够针对特定硬件优化算法,实现更流畅的体验。

这些特点也奠定了苹果后续AI发展的基调:注重隐私保护、用户体验与硬件性能的协同优化。 第四部分:为什么这些“早期AI”容易被忽略?)**

既然这些功能如此重要,为何很多人对iPhone最早的人工智能没有印象?原因在于:

- “智能”的相对性:在当时,这些功能被认为是“理所当然”的智能化进步,而非刻意宣传的“AI技术”。

- 与Siri的“光环效应”对比:Siri作为苹果首款真正面向消费者的AI产品,其颠覆性的交互体验掩盖了早期AI的功绩。

- 技术迭代太快:随着AI技术的飞速发展,早期的简单模型和功能显得“原始”,容易被后人遗忘。

(- 总结升华,引导互动)

从智能键盘的精准预测到联系人列表的快速排序,从音乐播放列表的智能生成到照片应用的初步分类,iPhone最早的人工智能并非空中楼阁,而是深深植根于用户体验的每一个细节之中,它们是苹果在移动互联网浪潮中,以用户为中心,巧妙运用数据与算法的智慧结晶。

回顾这段历史,不仅让我们对iPhone的“智能”有了更深刻的理解,也让我们看到了AI技术如何在潜移默化中改变我们的生活,AI已经渗透到iPhone的方方面面,从面容ID、神经网络引擎到更强大的Siri,但其“为用户服务”的初心,与早期一脉相承。

你还记得iPhone给你带来惊喜的早期“智能”功能吗?对于iPhone未来的AI发展,你又有哪些期待?欢迎在评论区留言分享你的看法!

策划与SEO优化要点:**

- 核心关键词布局:

- 标题、副标题、引言、正文各部分自然融入核心关键词“iPhone最早的人工智能”。

- 使用相关长尾关键词,如“iPhone初代AI”、“iOS早期人工智能功能”、“iPhone AI历史”、“Siri之前iPhone有AI吗”、“iPhone智能键盘预测原理”等,覆盖更多搜索意图。

- 用户需求洞察:

- 回答用户心中“最早是哪个?”“具体有什么?”“为什么不知道?”等疑问。

- 提供有价值的信息增量,满足用户的求知欲和好奇心。

- 内容结构清晰:

- 采用引言-分论点-总结的结构,逻辑性强,易于阅读。

- (H2/H3)分隔不同内容模块,提升用户体验和搜索引擎抓取效率。

- 原创性与深度:

- 避免简单罗列功能,深入分析其AI内核和用户价值。

- 提出独特观点

标签: iPhone最早人工智能功能 iPhone 4S Siri语音助手 iOS 15 机器学习照片编辑