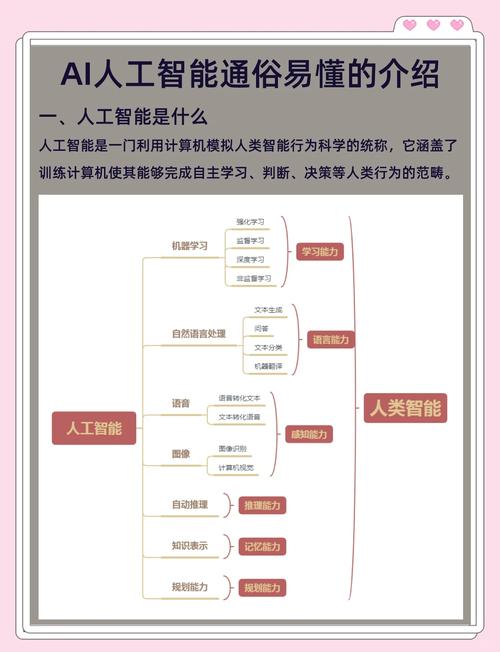

核心计算硬件:AI的“发动机”

这是最底层、最物理的部分,直接决定了AI模型能跑多快、能处理多大的数据。

通用处理器

- CPU (中央处理器): 传统计算机的大脑,擅长逻辑控制、串行处理和复杂指令,在AI任务中,它通常负责数据预处理、任务调度、与其他硬件的通信等辅助工作,而不是执行核心的AI计算。

- GPU (图形处理器): 现代AI计算的基石,最初为图形渲染设计,其核心特点是拥有数千个小型计算核心,非常适合进行大规模的并行计算,而这恰好是深度学习(如矩阵乘法)的核心需求。

- 代表: NVIDIA的Tesla系列(如A100, H100)是当今AI训练和推理的王者,其Tensor Core等专用单元能极大地加速混合精度计算。

- 关键优势: 强大的并行计算能力,成熟的软件生态(如CUDA)。

AI专用处理器

为了解决GPU在能效比、成本和特定场景下的不足,专门为AI设计的芯片应运而生。

- TPU (张量处理器): Google自研的ASIC(专用集成电路),专为TensorFlow等机器学习框架设计,它在矩阵运算(Tensor Core)上做了极致优化,能效比远超GPU,特别适合大规模模型的训练和推理。

- ASIC (专用集成电路): 为特定AI算法或任务定制的芯片,如用于自然语言处理的NPU(神经网络处理器)或用于计算机视觉的VPU(视觉处理器),优点是极致的性能和能效,缺点是缺乏灵活性。

- FPGA (现场可编程门阵列): 一种半定制化芯片,用户可以根据需求重新配置其硬件电路,优点是灵活性高、能效比好,适合小批量、定制化的AI任务,缺点是开发难度大,成本较高。

- NPU (神经网络处理器): 这是一个更宽泛的术语,常指集成在手机、边缘设备上的小型AI加速单元,用于处理本地化的AI任务(如人脸解锁、语音助手),如苹果的Neural Engine、华为的NPU。

新型计算架构

- 存算一体: 试图打破传统的“冯·诺依曼”瓶颈,将计算单元直接集成在存储单元中,极大减少数据搬运的能耗和时间,被认为是未来AI计算的重要方向。

- 光子计算: 利用光子进行计算,理论上具有极高的速度和极低的能耗,但目前仍处于研究早期阶段。

计算架构:AI的“身体和骨架”

单个计算单元能力有限,需要通过特定的架构将它们连接起来,形成强大的计算集群。

单机多卡

在单个服务器内,通过高速互联技术(如NVIDIA的NVLink)将多块GPU连接起来,实现GPU间的高速通信,共享显存,从而训练更大的模型。

分布式计算

这是当今训练大规模语言模型(如GPT系列)的关键,将成千上万个计算节点(每个节点包含多个GPU)通过网络连接起来,协同工作。

- 数据并行: 将数据切分,每个GPU处理一部分数据,然后同步梯度,这是最常用的并行方式。

- 模型并行: 将模型的不同层分配到不同的GPU上,用于处理单个GPU无法容纳的超大模型。

- 流水线并行: 将模型的不同层像工厂流水线一样分配到不同的GPU上,实现数据的顺序处理和计算的重叠。

- 混合并行: 结合以上多种并行方式,是目前训练万亿参数模型的标配。

高速网络

在分布式系统中,节点间的通信带宽和延迟是性能瓶颈,需要使用InfiniBand等超低延迟、超高带宽的网络技术来连接计算集群。

软件与编程模型:AI的“灵魂和语言”

硬件需要软件的驱动才能发挥最大效能。

深度学习框架

- TensorFlow, PyTorch, JAX: 这些高层框架封装了复杂的底层计算细节,提供了自动求导、模型定义、优化器等工具,让开发者可以更专注于算法本身,它们是连接上层应用和底层硬件的桥梁。

计算后端

框架本身不执行计算,而是将计算任务调度到不同的后端执行。

- CUDA: NVIDIA的GPU并行计算平台和编程模型,是GPU生态的核心,它提供了一套完整的工具链,让开发者能直接在GPU上进行编程。

- ROCm: AMD的开放计算平台,是CUDA的竞争对手,旨在提供跨平台的GPU计算能力。

- oneAPI: Intel推出的跨架构(CPU, GPU, FPGA等)编程模型,旨在统一软件开发体验。

编程优化

- cuDNN, TensorRT: NVIDIA提供的深度学习库和推理优化库,针对特定操作(如卷积)进行极致优化,能显著提升训练和推理速度。

- 混合精度训练: 使用16位(如FP16或BF16)甚至8位(INT8)浮点数进行计算,可以大幅减少显存占用和计算量,同时借助专门的硬件(如Tensor Core)保持精度损失在可接受范围内,这是训练大模型的必备技术。

云计算与服务平台:AI的“水电煤”

对于大多数研究者和企业而言,自建庞大的AI计算集群成本高昂、运维复杂,云服务商提供了按需付费的AI计算服务。

- AWS (Amazon Web Services): 提供EC2 P4d/P4de等搭载NVIDIA A100/H100的实例,以及专为AI优化的Trainium和Inferentia芯片。

- Google Cloud Platform (GCP): 提供基于TPU的AI Platform和Vertex AI服务。

- Microsoft Azure: 提供NDm A100系列虚拟机,并深度整合了OpenAI的服务。

- 阿里云, 腾讯云, 华为云: 国内领先的云服务商,也提供了强大的GPU和自研AI芯片算力服务。

这些平台不仅提供算力,还集成了数据存储、模型管理、部署等一站式服务,极大地降低了AI技术的使用门槛。

一个协同演进的生态系统

支撑人工智能的计算能力是一个协同演进的生态系统:

- 算法驱动: 模型越来越大(如从ResNet到GPT-4),对算力的需求呈指数级增长,这是推动硬件发展的根本动力。

- 硬件创新: GPU的出现引爆了深度学习,TPU、NPU等专用芯片则在特定场景下提供了更优的性价比。

- 软件栈成熟: 框架和编译器的进步,让复杂的并行计算变得简单易用,最大化地利用了硬件性能。

- 云服务普及: 将强大的计算能力像水电一样输送给千行百业,加速了AI技术的应用和普及。

随着大模型、生成式AI、自动驾驶等应用的深入,对计算能力的需求只会越来越旺盛,这个生态系统也将继续朝着更高性能、更低能耗、更强灵活性的方向不断演进。

标签: 算力支撑人工智能发展的核心逻辑 人工智能发展依赖的算力技术类型 算力不足如何限制人工智能突破