这是一个至关重要且复杂的问题,人工智能的伦理并非一套僵化的规则,而是一个动态演进的框架,旨在确保这项强大的技术能够被负责任地、有益地、公平地发展与应用。

(图片来源网络,侵删)

我们可以从以下几个核心原则和具体实践层面来探讨人工智能应当遵循的伦理:

核心伦理原则

这些是指导AI研发和应用的基石,构成了伦理框架的基础。

以人为本

- 内涵:AI的设计、开发和应用都应以增进人类福祉、尊重人类尊严和权利为最终目的,技术是为人服务的工具,而不是主宰。

- 实践:在开发任何AI系统前,必须明确回答:“这个系统为谁解决什么问题?如何让人的生活变得更好?” 而不是“我们能用这个技术做什么?”

公平与公正

- 内涵:AI系统应避免和消除偏见,不得因种族、性别、年龄、宗教、国籍、性取向等特征而产生歧视,算法的决策不应复制或放大现实世界中的不平等。

- 实践:

- 数据审计:在训练模型前,严格审查和清洗数据,剔除其中的历史偏见。

- 算法透明:理解模型为何做出特定决策,特别是对敏感决策(如贷款审批、司法量刑)。

- 结果测试:持续监测AI系统在不同群体中的表现,确保其公平性。

透明与可解释性

- 内涵:AI系统的决策过程应该是可理解、可解释的,尤其是在高风险领域,人们有权知道AI为何做出影响他们的决定。

- 实践:

- “黑箱”问题:对于复杂的深度学习模型,开发“可解释性AI”(XAI)工具,用人类能理解的语言和方式呈现其决策依据。

- 信息披露:当用户在与AI系统互动时,应明确告知对方其身份,并在必要时解释其决策逻辑。

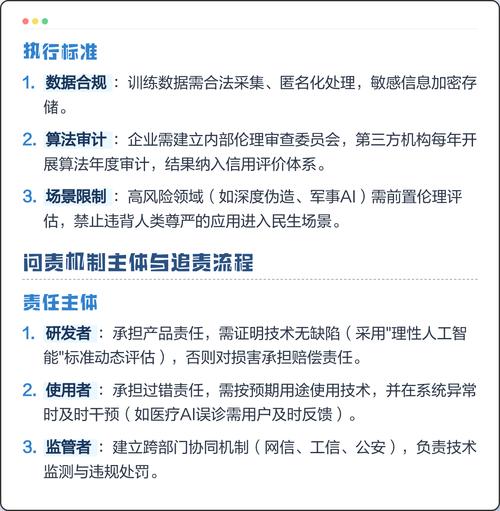

责任与问责

- 内涵:当AI系统造成损害时,必须有明确的责任归属机制,不能因为“是AI做的”就逃避责任。

- 实践:

- 明确责任链:明确开发者、部署者、使用者等各方的责任。

- 建立追溯机制:记录AI系统的关键决策日志,以便在出现问题时进行调查和追责。

- 法律框架:推动立法,明确AI事故的法律责任。

安全与稳健

- 内涵:AI系统必须是可靠、安全且能抵御恶意攻击的,它应在预期的和不可预见的环境下都能稳定运行,避免造成物理或数字世界的伤害。

- 实践:

- 鲁棒性测试:对AI系统进行各种压力测试和对抗性攻击测试,确保其在面对异常数据或恶意输入时不会崩溃或做出危险行为。

- 安全设计:将安全作为系统设计的核心要素,而非事后补充。

隐私保护

- 内涵:AI系统在收集、处理和使用个人数据时,必须严格遵守隐私法规,尊重个人对其数据的自主权。

- 实践:

- 数据最小化:只收集和实现目标所必需的最少数据。

- 匿名化与去标识化:对数据进行处理,使其无法追溯到个人。

- 用户同意:确保用户在知情的前提下自愿同意其数据被使用,并提供便捷的退出机制。

人类监督

- 内涵:在关键决策点上,人类应保留最终的监督权和否决权,AI应被视为强大的辅助工具,而非完全自主的决策者。

- 实践:

- 人机协作:在医疗、自动驾驶、金融风控等领域,AI提供建议和数据分析,但最终决策由人类做出。

- “关闭开关”:为高风险AI系统设计有效的干预和关闭机制。

关键应用领域的伦理考量

将上述原则应用于具体场景时,会有不同的侧重点:

自动驾驶汽车

- 伦理困境:不可避免的事故中,AI应如何选择?(撞向行人还是转向牺牲乘客?)

- 伦理要求:决策逻辑必须公开透明,接受社会伦理讨论;必须确保系统安全可靠,通过极端场景测试;明确事故责任方(车主、制造商、软件商)。

医疗健康

- 伦理困境:AI诊断的准确性如何保证?谁为AI的误诊负责?如何保护敏感的病人隐私?

- 伦理要求:AI作为辅助诊断工具,最终决策权在医生;确保训练数据的多样性和代表性,避免对特定人群的误诊;严格遵守医疗数据隐私法规(如HIPAA)。

司法与执法

- 伦理困境:预测性警务算法是否会加剧对少数族裔的偏见?AI量刑是否公平?

- 伦理要求:严禁使用有偏见的算法进行风险评估;法官对判决负有最终责任;算法的决策逻辑必须对被告方公开可解释。

内容审核与社交媒体

- 伦理困境:如何平衡言论自由与防止有害信息(如仇恨言论、虚假信息)的传播?算法推荐是否会制造“信息茧房”?

- 伦理要求:审核标准应公开透明,并接受公众监督;赋予用户对推荐算法的知情权和一定程度的控制权;防止算法被用于操纵舆论。

如何实现这些伦理原则?

伦理不能只停留在口号上,需要多方共同努力:

(图片来源网络,侵删)

-

技术层面:

- 研发伦理嵌入:在AI设计的整个生命周期(从数据收集到模型部署)中融入伦理考量。

- 开发工具:研发用于检测偏见、增强可解释性、保障隐私的技术工具。

-

政策与法规层面:

- 制定法规:政府和监管机构应出台明确的法律法规,为AI划定红线,明确责任。

- 建立标准:推动建立行业标准和认证体系,鼓励企业遵守伦理规范。

-

企业层面:

- 设立伦理委员会:大型科技公司应建立独立的AI伦理委员会,对产品进行伦理审查。

- 推动伦理文化:将伦理意识纳入企业文化和员工培训中。

-

社会与教育层面:

(图片来源网络,侵删)

(图片来源网络,侵删)- 公众教育:提升公众对AI的理解和批判性思维能力,让社会能够参与到关于AI未来的讨论中。

- 跨学科研究:鼓励计算机科学家、社会学家、法学家、哲学家等共同研究AI伦理问题。

人工智能的伦理不是一个需要“解决”的问题,而是一个需要持续“管理”和“对话”的过程,它要求我们保持一种审慎、谦逊和负责任的态度,我们追求的不是一个完美无缺的AI,而是一个能够与人类价值观对齐、能够增强而非削弱人类尊严、能够为全人类带来共同福祉的强大工具,这需要技术开发者、政策制定者、企业和社会公众的共同努力,以确保AI的发展方向始终符合我们共同的利益和期望。

标签: 人工智能伦理四大准则 AI伦理原则有哪些 人工智能伦理核心内容

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。