- 核心概念拆解:什么是语音识别?什么是语义理解?它们如何结合?

- 技术原理:AI是如何实现语音语义识别的?

- 应用场景:这项技术已经深入到我们生活的哪些地方?

- 挑战与未来:当前面临哪些难题?未来会如何发展?

核心概念拆解

语音识别

- 目标:将人类说的声音信号转换成计算机可以处理的文本。

- 简单来说:“听懂”你在说什么字。

- 例子:你说“今天天气真好”,语音识别技术会输出文本:“今天天气真好”。

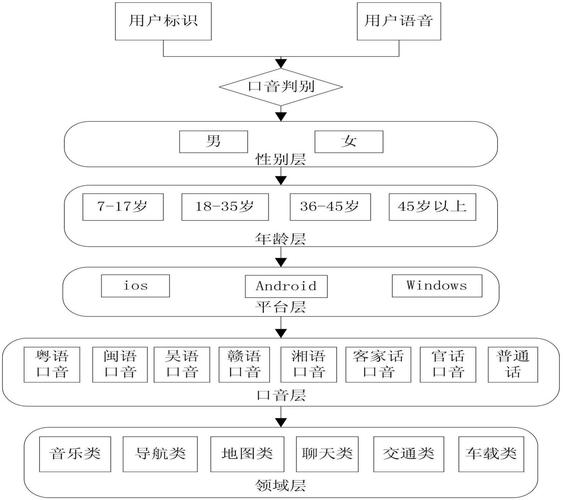

- 挑战:口音、噪音、语速、背景音、同音字(如“在”和“再”)等。

语义识别 / 语义理解

- 目标:在识别出文本的基础上,理解这些文字背后真正的含义、意图和情感。

- 简单来说:“明白”你为什么这么说,以及你想做什么。

- 例子:

- 你说:“把空调调低两度。”

- 语义理解会分析出:

- 意图:控制设备(空调)

- 动作:调低

- 参数:两度

- 它不仅知道你说了什么,更知道你需要执行一个具体的操作。

语音语义识别

- 定义:这是一个端到端的技术流程,它不仅仅是孤立地完成“语音转文字”,而是直接从语音信号中提取出语义和意图,它将语音识别和语义理解两个步骤深度融合,形成一个完整的闭环。

- 简单来说:AI直接“听懂”你的意思,并知道下一步该做什么。

- 例子:智能音箱

- 你说:“小爱同学,明天早上七点叫我起床。”

- 语音语义识别系统会:

- 接收语音:捕捉到你的声音。

- 识别语音:将声音转换成文本“明天早上七点叫我起床”。

- 理解语义:分析出意图是“设置闹钟”,时间是“明天早上七点”。

- 执行操作:在系统里创建一个闹钟任务。

技术原理(AI如何实现)

这项技术的实现,主要依赖于人工智能的几个核心分支,尤其是深度学习。

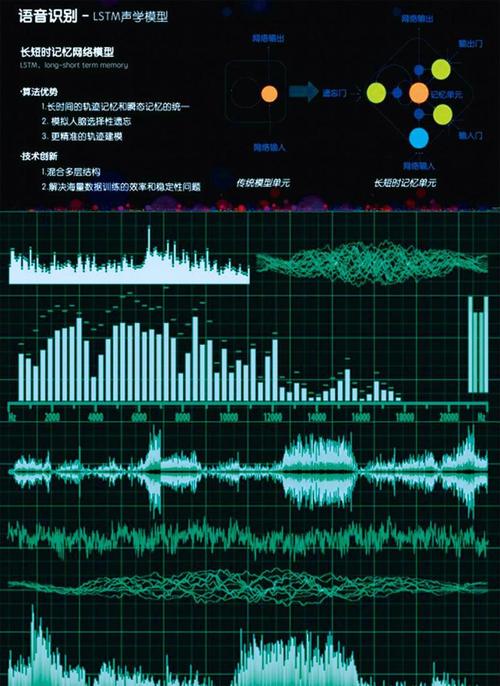

(图片来源网络,侵删)

第一阶段:语音识别 - 从声音到文字

-

信号处理:

- 麦克风采集的原始声音是模拟信号,需要通过傅里叶变换等技术转换成计算机能处理的数字信号(波形图)。

- 进行分帧和加窗,将连续的声音切成一个个小片段,并提取出每个片段的特征,比如梅尔频率倒谱系数,这些特征代表了声音的频谱信息,是机器能“读懂”的声音。

-

声学模型:

- 这是语音识别的核心,负责将声音特征映射成最可能的音素(语言中最小的发音单位,如汉语的拼音)。

- 早期:使用高斯混合模型-隐马尔可夫模型。

- 主流):使用深度神经网络,特别是循环神经网络和卷积神经网络,RNN擅长处理序列数据(如声音),能捕捉声音特征之间的时间依赖关系,CNN则擅长提取局部特征。

-

语言模型:

- 它的作用是判断哪个词序列在语法和语义上更合理。

- 声音特征可能对应“、“天气”、“真”、“好”四个音素,语言模型会计算出“今天天气真好”的概率远高于“今天天气真好笑”(虽然后者也合理),从而帮助系统做出正确的选择。

- 现代语言模型也大量使用深度学习,特别是Transformer架构,其注意力机制能更好地理解长距离的上下文关系。

第二阶段:语义理解 - 从文字到意图

-

自然语言处理:

(图片来源网络,侵删)

(图片来源网络,侵删)- 分词:将句子切分成词语(如“明天早上七点叫我起床” -> “明天/早上/七点/叫/我/起床”)。

- 词性标注:标记每个词的词性(名词、动词、时间词等)。

- 命名实体识别:识别出句子中的关键信息,如时间(“明天早上七点”)、人名、地点等。

-

意图识别与槽位填充:

- 这是语义理解的关键,常用于任务型对话系统。

- 意图识别:判断用户的核心目的是什么,在“明天早上七点叫我起床”中,意图是

set_alarm(设置闹钟)。 - 槽位填充:提取意图所需的关键参数(即“槽位”)。

time(时间)槽位被填充为“明天早上七点”。

-

上下文理解:

- 真实的对话是多轮的,AI需要记住之前的对话内容,才能理解当前语句的含义。

- 用户A:“周杰伦的歌有哪些?”

- 用户B:“他哪首歌最火?”

- AI需要知道“他”指的是“周杰伦”,这依赖于上下文记忆和指代消解技术,RNN和Transformer的记忆能力在这里至关重要。

端到端模型

为了简化流程并提升效果,现代AI系统越来越多地采用端到端模型,这种模型直接从原始语音输入映射到最终的语义输出(如意图和槽位),省去了中间的文本转换步骤,基于Transformer的Conformer模型,在语音识别和语义理解任务上都取得了顶尖的性能。

应用场景

语音语义识别技术已经无处不在,深刻地改变了我们的人机交互方式:

- 智能音箱/语音助手:如小爱同学、天猫精灵、Siri、Google Assistant,这是最典型的应用,用于控制智能家居、查询信息、播放音乐等。

- 智能客服:银行的语音客服、航空公司的订票热线等,通过语音语义识别,AI可以直接理解用户需求,提供自助服务,大幅提升效率。

- 车载系统:在驾驶中,通过语音控制导航、播放音乐、打电话,提升驾驶安全性和便利性。

- 实时字幕/翻译:会议、视频直播、在线课程中,实时将语音转换成文字字幕,甚至进行多语种翻译。

- 医疗听录:医生口述病历,AI自动转换成规范的电子病历,解放医生的双手。

- 司法听录:庭审记录,快速、准确地生成庭审笔录。

- 内容创作:通过语音快速输入文字,提高写作效率。

挑战与未来

当前挑战

- 鲁棒性:在噪音环境(如街道、商场)、多人同时说话(鸡尾酒会问题)、口音和方言、远场拾音(麦克风离人较远)等情况下,识别准确率会显著下降。

- 语境与常识:AI缺乏人类丰富的常识和世界知识,难以理解需要深层推理、比喻、讽刺或特定文化背景的复杂语义。

- 情感与个性化:目前的系统对语气、情感(如愤怒、喜悦)的识别能力有限,且难以进行个性化的交互。

- 数据隐私与安全:语音是极其敏感的个人生物信息,如何确保数据的安全和用户隐私是一个重大挑战。

- 计算资源:训练和运行高精度的语音语义模型需要巨大的计算资源(如GPU/TPU)。

未来发展趋势

- 多模态融合:结合视觉(如唇语、面部表情)、文本、声音等多种信息进行综合判断,提升理解的准确性和鲁棒性。

- 更强的上下文与推理能力:AI将更好地理解长对话,并能进行常识推理,像人类一样进行有逻辑的交互。

- 个性化与情感化:系统将能识别用户的情绪,并做出更具同理心和个性化的回应,让交互更自然、更温暖。

- 低资源与边缘计算:通过模型压缩、知识蒸馏等技术,让强大的模型可以在手机、智能手表等边缘设备上高效运行,保护隐私,降低延迟。

- 可解释性AI (XAI):让AI能够解释“它为什么会做出这样的判断”,这对于医疗、金融等高风险领域至关重要。

语音语义识别是人工智能皇冠上的一颗明珠,它不仅是让机器“听懂”声音的技术,更是实现自然、高效、智能的人机交互的关键桥梁,从早期的孤立词识别,到如今能够理解复杂意图的端到端系统,AI技术,特别是深度学习,已经让这个领域取得了革命性的突破,随着技术的不断演进,语音语义识别将更加智能、无处不在,真正成为连接人类与数字世界的无缝纽带。

标签: 语音语义识别技术突破瓶颈 人工智能瓶颈语音语义识别 语音语义识别瓶颈解决

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。