AI硬件可以分为两大类:

(图片来源网络,侵删)

- 训练硬件:用于训练大型AI模型,需要极高的计算能力、内存和带宽,这类设备通常体积大、功耗高、价格昂贵,集中在数据中心。

- 推理硬件:用于将训练好的模型部署到实际应用中,进行实时预测,这类设备对功耗、成本和响应速度要求更高,形态多样,从云端服务器到边缘设备都有。

下面是详细的硬件设备分类介绍:

核心计算硬件(AI的“大脑”)

这是执行AI计算最核心的部件,直接决定了AI性能的上限。

专用AI芯片

这类芯片是专门为AI计算的特定模式(尤其是矩阵运算)而设计的,能效比远高于通用CPU。

-

GPU (图形处理器):

(图片来源网络,侵删)

(图片来源网络,侵删)- 简介:虽然最初为游戏渲染设计,但其并行计算架构(数千个小核心)使其成为深度学习训练的事实标准,NVIDIA凭借其CUDA生态系统占据了主导地位。

- 代表产品:NVIDIA的 A100, H100, H200 系列数据中心GPU,消费级的 RTX 4090 等也被许多研究者和开发者用于训练。

- 特点:拥有巨大的显存和极高的并行计算能力,非常适合大规模矩阵运算。

-

TPU (张量处理器):

- 简介:谷歌专为机器学习,特别是TensorFlow框架而设计的ASIC(专用集成电路),它专注于矩阵乘法等核心运算。

- 代表产品:Google Cloud TPU v4, v5等。

- 特点:在特定任务上能效比极高,与谷歌云深度集成,但灵活性不如GPU。

-

ASIC (专用集成电路):

- 简介:为特定AI模型或应用定制的芯片,性能和能效达到极致,但开发成本高、周期长、灵活性差。

- 代表产品:

- Google TPU (可视为ASIC的一种)。

- 寒武纪、地平线 等公司为特定场景(如智能驾驶、边缘计算)设计的AI芯片。

-

FPGA (现场可编程门阵列):

- 简介:一种半定制芯片,用户可以编程配置其硬件电路,它提供了比ASIC更高的灵活性,比GPU更高的能效比。

- 代表产品:AMD/Xilinx的 Alveo 系列加速卡。

- 特点:适合需要频繁调整算法或进行硬件原型验证的场景,但编程难度较大。

通用及混合计算硬件

-

CPU (中央处理器):

(图片来源网络,侵删)

(图片来源网络,侵删)- 简介:计算机的“大脑”,擅长处理复杂的逻辑运算和串行任务,虽然不是AI计算的主力,但在整个AI系统中扮演着“总指挥”的角色,负责数据预处理、任务调度、结果后处理等。

- 代表产品:Intel Xeon系列、AMD EPYC系列。

- 特点:通用性强,但在大规模并行计算上远不如GPU。

-

NPU (神经网络处理器):

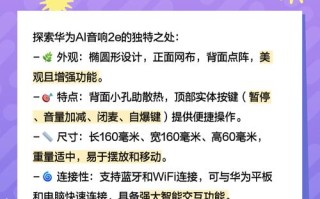

- 简介:这是一个更广义的术语,通常指集成在SoC(片上系统)中的、用于处理AI任务的专用单元,它已经成为现代智能手机、智能汽车等设备的标配。

- 代表产品:苹果的 Neural Engine、华为的 NPU(如麒麟芯片中的达芬奇架构)、高通的 Hexagon DSP。

- 特点:低功耗、高效率,专门在设备端处理AI推理任务,如人脸识别、语音助手等。

存储硬件(AI的“记忆”)

AI,特别是深度学习,需要处理海量的数据集和模型参数,对存储的要求极高。

-

高速内存:

- GPU显存:训练时,模型和数据必须加载到GPU显存中,显存的大小直接决定了能训练多大的模型和数据集。HBM (高带宽内存) 是目前高端GPU的标准配置,提供了极高的带宽。

- 系统内存:DDR5等系统内存用于存储数据集和模型,作为CPU和GPU之间数据传输的缓冲。

-

高速存储:

- NVMe SSD (固态硬盘):相比传统SATA SSD,NVMe SSD通过PCIe总线连接,读写速度极快,能快速加载大规模的数据集,是AI服务器的标配。

- 分布式存储系统:对于超大规模的训练任务,需要使用如HDFS、Ceph等分布式文件系统来存储PB级别的数据。

系统硬件平台(AI的“身体”)

将上述核心部件整合起来,形成完整的计算系统。

-

AI服务器/工作站:

- 简介:专门为AI计算优化的计算机,通常包含多个高性能GPU(如4个、8个A100/H100)、大容量内存(TB级)、高速NVMe存储和强大的电源和散热系统。

- 代表产品:NVIDIA DGX SuperPOD、Dell PowerEdge、H3C等厂商的AI服务器。

-

边缘计算设备:

- 简介:部署在数据源附近的设备,用于执行AI推理,减少数据上传到云端的延迟和成本。

- 代表形态:

- 智能摄像头:内置NPU,可实时进行人脸识别、行为分析。

- 工业PC:在工厂中用于产品质量检测。

- 智能网关:在物联网设备中聚合数据并进行本地AI分析。

- 自动驾驶平台:如NVIDIA DRIVE Orin,集成了强大的SoC用于实时环境感知和决策。

专用硬件设备(AI的“感官”和“工具”)

这些设备是AI与物理世界交互或辅助AI开发的工具。

-

传感器:

- 摄像头:为计算机视觉提供图像和视频数据。

- 麦克风阵列:为语音识别、声纹识别提供音频数据。

- 激光雷达:为自动驾驶、三维建模提供高精度的点云数据。

- 其他传感器:如毫米波雷达、惯性测量单元、温度传感器等,为AI提供多模态的输入。

-

机器人:

- 简介:AI赋予了机器人“大脑”,使其能够感知环境、进行决策并执行物理任务,机器人是AI在物理世界中的“化身”。

- 代表产品:工业机器人、服务机器人、波士顿动力的Atlas等。

-

开发工具与原型平台:

- 开发套件:如NVIDIA Jetson系列(面向边缘AI开发)、Google Coral Dev Board(TPU加速),让开发者可以快速验证AI应用原型。

- 云平台:AWS, Google Cloud, Azure等提供各种GPU/TPU实例、托管AI服务和数据集,是绝大多数AI开发和训练的基础设施。

总结表格

| 类别 | 设备类型 | 核心功能 | 关键指标 | 典型代表 |

|---|---|---|---|---|

| 核心计算 | GPU | 大规模并行计算,AI训练主力 | 核心数量、显存大小、显存带宽 | NVIDIA A100, H100 |

| TPU | 高效张量运算,与谷歌生态集成 | 算力、能效比 | Google Cloud TPU | |

| NPU | 低功耗AI推理,集成于移动/边缘设备 | 性能/功耗比 | Apple Neural Engine, 华为NPU | |

| FPGA | 灵活可编程,硬件原型验证 | 可编程性、能效 | AMD/Xilinx Alveo | |

| 存储 | 高速内存 | 暂存数据和模型参数 | 容量、速度 | HBM (GPU显存), DDR5 |

| 高速存储 | 快速加载海量数据集 | 读写速度、IOPS | NVMe SSD | |

| 系统平台 | AI服务器 | 整合计算、存储、网络资源,提供强大算力 | GPU数量、内存容量、网络带宽 | NVIDIA DGX, Dell AI Server |

| 边缘设备 | 在本地执行AI推理,降低延迟 | 功耗、算力、尺寸 | 智能摄像头、工业PC、Jetson | |

| 专用设备 | 传感器 | 为AI提供原始感知数据 | 精度、分辨率、刷新率 | 摄像头、麦克风、激光雷达 |

| 机器人 | 执行AI的物理决策和动作 | 精度、灵活性、负载能力 | 工业机器人、波士顿动力Atlas |

AI硬件是一个从云端到边缘、从通用到专用的庞大生态系统,不同的应用场景会选用不同的硬件组合,以在性能、成本、功耗和灵活性之间找到最佳平衡点。

标签: 人工智能硬件设备清单 AI电脑配置要求 深度学习硬件推荐

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。