下面我将从核心原理、实现步骤、技术挑战、现有方案和未来展望五个方面,详细阐述如何实现手势操控无人机。

(图片来源网络,侵删)

核心原理

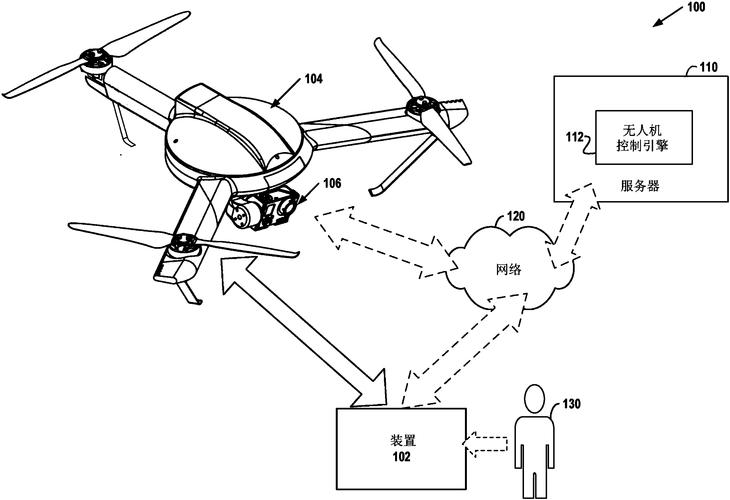

手势操控无人机的核心原理可以概括为“感知-理解-执行”三个步骤:

- 感知:通过传感器捕捉用户的手势信息,这是所有后续步骤的基础。

- 理解:利用算法识别出捕捉到的手势信息代表的具体指令(如“起飞”、“向左飞”、“悬停”等)。

- 执行:将识别出的指令转换成无人机的具体控制信号(如电机转速、云台角度等),并下发给无人机飞控系统执行。

实现步骤详解

硬件选型与搭建

这是实现手势控制的基础,你需要一个“眼睛”和一个“大脑”。

-

无人机平台:

- 选择:可以选择市面上支持二次开发的开源无人机平台(如 Intel Aero RTF、Holybro Pixhawk 系列),或者使用支持 SDK 的商业无人机(如 DJI Tello、Parrot Anafi),对于 DIY 爱好者,也可以用四轴飞行器(如 F450/F550)搭配飞控板(如 Pixhawk)自行组装。

- 关键要求:无人机必须支持通过 API 或串口等外部方式接收控制指令,而不是只能用遥控器。

-

传感器(无人机的“眼睛”):

(图片来源网络,侵删)

(图片来源网络,侵删)- 摄像头:这是最核心的传感器,可以选择:

- 机载摄像头:安装在无人机上,俯拍下方区域,优点是无人机视角不受限制,但需要强大的机载计算能力或实时图传。

- 地面端摄像头:安装在电脑或手机上,对着操作者,优点是计算可以放在地面端,对无人机负担小,但操作范围受限,且需要无人机和摄像头之间的相对位置关系。

- 深度相机(可选,但强烈推荐):如 Intel RealSense、Orbbec Astra 等,它能提供像素级的深度信息,极大地提升手势识别的准确性和鲁棒性,尤其是在复杂背景下。

- IMU(惯性测量单元):无人机自带的传感器,用于感知自身的姿态、加速度等,可以帮助稳定飞行。

- 摄像头:这是最核心的传感器,可以选择:

-

计算平台:

- 地面端计算:将摄像头连接到电脑(PC)或笔记本电脑,所有图像处理和手势识别算法在电脑上运行,优点是计算能力强,算法复杂度高,缺点是依赖数据线或Wi-Fi,有延迟。

- 机载计算:在无人机上搭载一个嵌入式计算单元,如 NVIDIA Jetson Nano/Xavier NX、Intel NUC 或 Raspberry Pi,优点是延迟低,真正实现“无线自由”,缺点是对功耗、尺寸和重量有要求,计算能力相对有限。

-

通信模块:

- 用于连接计算平台和无人机,通常使用 Wi-Fi(如 Tello)或 数传电台(用于连接 Pixhawk 飞控),低延迟和稳定性至关重要。

软件与算法开发

这是将硬件“激活”的关键。

-

图像采集与预处理:

(图片来源网络,侵删)

(图片来源网络,侵删)- 使用 OpenCV 等库从摄像头获取视频流。

- 对图像进行预处理,如灰度化、高斯模糊、背景减除等,以突出手部特征,减少环境干扰。

-

手部检测与追踪:

- 检测:在图像中找到手的位置,常用算法有:

- 基于颜色:利用 HSV 颜色空间隔离肤色区域,简单易实现,但对光照敏感。

- 基于机器学习:使用训练好的分类器(如 Haar 级联分类器)检测手部。

- 基于深度学习:使用 MediaPipe 或 OpenPose 等现成库,MediaPipe 的

Hand模型可以非常高效地检测手部关键点,是目前的主流方案。

- 追踪:在连续的视频帧中,追踪手的位置,可以使用光流法或卡尔曼滤波器,使手势更平滑。

- 检测:在图像中找到手的位置,常用算法有:

-

手势识别:

- 这是核心中的核心,检测到手部后,需要识别出这是什么手势。

- 基于关键点:

- 方案:使用 MediaPipe 检测到手部的 21 个关键点。

- 逻辑:通过分析这些关键点之间的相对位置、角度和距离来定义手势。

- 握拳:所有手指弯曲,指尖到手腕的距离小于某个阈值。

- 张开手掌:所有手指伸直,指尖到手腕的距离大于某个阈值。

- 比“OK”:拇指和食指指尖接近,形成闭环。

- 指向:食指伸直,其他手指弯曲。

- 比“耶”:食指和中指伸直,形成 V 字。

- 基于轮廓:

- 方案:获取手的轮廓,分析轮廓的凸包和凹点。

- 逻辑:通过计算手指的数量(凸包的凹点数量)来识别不同的手势。

- 基于机器学习模型:

- 方案:收集大量手势图像,训练一个分类模型(如 CNN、SVM)。

- 优点:可以识别更复杂、更细微的手势。

- 缺点:需要大量标注数据,训练过程复杂。

-

指令映射与无人机控制:

- 将识别出的手势映射成具体的无人机控制指令。

- 张开手掌 ->

起飞 - 握拳 ->

降落 - 向左挥手 ->

向左平移 - 向右挥手 ->

向右平移 - 向上挥手 ->

上升 - 向下挥手 ->

下降 - 比“OK” ->

悬停 - 双手合十 ->

拍照或录制视频

- 张开手掌 ->

- 通过无人机的 SDK(如 Tello SDK, MAVLink)将这些指令打包发送给飞控系统,控制电机转速,实现飞行。

- 将识别出的手势映射成具体的无人机控制指令。

系统集成与测试

- 代码整合:将上述所有模块(图像采集、手势识别、指令发送)整合到一个程序中。

- 调试:

- 手势识别准确性:在不同光照、不同背景、不同距离下测试识别率。

- 控制延迟:测试从做出手势到无人机做出反应的时间,确保延迟在可接受范围内(< 200ms)。

- 飞行稳定性:测试无人机在手势控制下的飞行是否平稳,有无抖动或漂移。

- 安全第一:始终在开阔、安全的环境下进行测试,并准备好紧急降落措施(如物理开关或紧急停止程序)。

主要技术挑战

- 环境光照变化:强光、弱光、阴影都会严重影响摄像头成像,导致手部检测失败。

- 背景复杂性:当背景中存在与手部颜色或形状相似的物体时,容易产生误检。

- 识别延迟:图像处理、算法计算、无线通信都会引入延迟,延迟过高会导致操控体验极差,甚至失控。

- 手势歧义性:有些手势在不同文化或不同视角下可能有不同含义,需要明确定义。

- 计算资源限制:如果使用机载计算,嵌入式设备的算力有限,无法运行过于复杂的深度学习模型。

- 鲁棒性:系统需要能够处理遮挡(部分手被挡住)、快速移动等情况,保持稳定识别。

现有方案与参考

-

商业产品:

- DJI Goggles / Motion Controller:这是 DJI 无人机(如 Inspire 2)的配件,通过手柄的传感器感知姿态,实现手势控制,它更多是姿态感应,而非视觉识别。

- 部分 AR 眼镜:一些 AR 眼镜集成摄像头,可以通过特定手势进行拍照、录像等交互,但通常不直接控制无人机飞行。

-

开源项目与教程(非常适合学习):

- Tello 手势控制:这是入门级最佳实践,DJI Tello 无人机开放了 SDK,并且有很多基于 Python 和 OpenCV 的开源项目,可以直接参考,搜索 "Tello Hand Gesture Control" 能找到大量代码和教程。

- MediaPipe 官方示例:Google 的 MediaPipe 库提供了手部追踪的官方 Python 和 C++ 示例,你可以基于此快速开发自己的手势识别功能。

- GitHub 上的开源项目:在 GitHub 上搜索 "drone hand gesture control",可以找到许多由爱好者分享的完整项目,从硬件连接到算法实现都有详细说明。

未来展望

手势操控无人机正朝着更智能、更自然的方向发展:

- 与 AR/VR 结合:通过 AR 眼镜,用户可以看到叠加在真实世界上的无人机状态和控制界面,手势操作更加直观。

- 多模态交互:结合语音指令(“无人机,飞过来”)、头部追踪和手势,实现更丰富、更自然的交互方式。

- 更复杂的意图识别:不仅是识别单个手势,而是理解一系列连续手势组成的“手势语言”,先向左飞,然后上升,最后悬停”。

- 边缘计算与 AI 芯片:更强大的机载 AI 芯片将使复杂的深度学习模型可以在无人机上本地运行,实现低延迟、高精度的实时控制。

- 脑机接口:这是终极目标之一,通过脑电波直接控制无人机,实现“意念飞行”。

对于初学者或爱好者来说,实现手势操控无人机的最佳路径是:

选择 Tello + 电脑 + OpenCV + MediaPipe 的组合。

- 硬件简单:Tello 无人机自带摄像头和 Wi-Fi,无需额外复杂的传感器和计算平台。

- 社区活跃:有大量现成的教程和开源代码可供参考。

- 学习曲线平缓:使用 Python 语言,可以专注于核心的图像处理和手势识别算法,而无需深入底层飞控。

通过这个项目,你可以完整地走完“感知-理解-执行”的全过程,为未来更复杂、更专业的无人机控制系统开发打下坚实的基础。

标签: 手势操控无人机精准方法 无人机手势控制精准技巧 手势操控无人机精准实现技巧

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。