核心概念解析

我们分别理解这两个概念:

(图片来源网络,侵删)

人工智能

- 定义:计算机科学的一个分支,旨在创造能够执行通常需要人类智能的任务的机器,如学习、推理、问题解决、感知和理解语言。

- 当前主流技术:以深度学习为代表,特别是神经网络,这种模型通过在海量数据上进行训练,学习数据中的复杂模式和特征。

- 核心特点:

- 数据驱动:极度依赖大量标注数据进行训练。

- 计算密集:训练和推理过程需要巨大的计算资源(如GPU、TPU)。

- 能耗高:进行大规模矩阵运算时,功耗非常高。

- 非实时学习:学习(训练)和执行(推理)通常是两个分离的阶段。

神经形态芯片

- 定义:一种模仿生物大脑结构和信息处理方式的芯片,它不是简单地模拟软件算法,而是在硬件层面模拟大脑神经元和突触的功能。

- 设计灵感:源于对人类大脑的研究,大脑由约860亿个神经元通过数万亿个突触连接而成,功耗极低(约20瓦),却能进行高效的感知、学习和决策。

- 核心特点:

- 事件驱动:只有当神经元“激活”或数据发生变化时,芯片才进行计算,类似于大脑只在接收新信息时才消耗能量,这使其在处理稀疏数据时能效极高。

- 并行处理:数以万计的神经元和突触可以并行工作,天然适合处理复杂的、并行的任务。

- 在线学习:能够在运行过程中实时学习和适应新信息,无需像传统AI那样进行耗时的“再训练”。

- 低功耗:由于其事件驱动和模拟计算的特性,功耗远低于传统芯片。

人工智能与神经形态芯片的完美结合

传统AI(深度学习)在特定任务上取得了巨大成功,但它面临着“三座大山”:数据饥渴、能耗巨大、泛化能力差,神经形态芯片的出现,正是为了解决这些瓶颈,为AI的发展提供新的硬件基础。

它们的关系可以概括为:神经形态芯片是为下一代AI(特别是类脑智能)量身定制的“大脑”硬件。

结合的优势与互补性

| 特性 | 传统AI (在GPU/TPU上运行) | AI + 神经形态芯片 | 优势互补 |

|---|---|---|---|

| 计算范式 | 冯·诺依曼架构:数据和指令分开,需要频繁搬运数据,造成“内存墙”问题。 | 存内计算:计算和存储在神经元和突触中同时进行,数据搬运开销极小。 | 解决“内存墙”,大幅提升计算效率。 |

| 能效 | 高能耗:需要为庞大的数据中心提供大量电力和冷却。 | 超低功耗:事件驱动机制,只在需要时才消耗能量。 | 绿色AI,使AI在边缘设备(如手机、传感器)上大规模部署成为可能。 |

| 学习方式 | 离线训练,在线推理:模型在云端训练好后,部署到设备上执行,无法实时学习。 | 在线学习:芯片可以在运行中根据新环境实时调整突触权重,持续进化。 | 实现真正的自适应智能,让机器人、自动驾驶等系统能动态应对未知情况。 |

| 数据处理 | 批量处理:对数据流进行固定周期的处理。 | 事件驱动处理:对异步、稀疏、不规则的数据流(如摄像头像素变化)天生敏感。 | 完美匹配真实世界,更适合处理传感器数据,实现更高效的感知。 |

| 鲁棒性 | 脆弱:对对抗性攻击、数据噪声和分布偏移比较敏感。 | 鲁棒性强:类似大脑的分布式、并行式处理方式,对局部损伤和噪声不敏感。 | 构建更可靠、更安全的AI系统。 |

应用场景与实例

这种结合并非遥不可及,已经在一些领域展现出巨大潜力:

-

边缘计算与物联网

(图片来源网络,侵删)

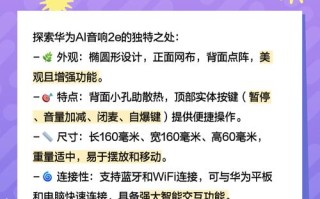

(图片来源网络,侵删)- 场景:智能家居设备、可穿戴设备、工业传感器。

- 优势:这些设备功耗和计算能力有限,神经形态AI芯片可以在本地实时处理语音、图像、传感器数据,而无需将数据上传到云端,既保护了隐私,又大大降低了延迟和功耗。

-

机器人与自主系统

- 场景:服务机器人、无人机、自动驾驶汽车。

- 优势:机器人需要实时感知环境、做出决策并控制身体,神经形态芯片的低延迟、在线学习和高能效特性,使其能够像生物一样快速、流畅地与物理世界互动。

-

科学发现

- 场景:粒子物理数据分析、材料科学模拟、脑科学研究。

- 优势:这些领域需要处理海量、复杂且不规则的数据,神经形态芯片的高效并行处理能力,可以加速发现隐藏在数据中的新规律。

-

脑机接口

- 场景:帮助残障人士控制义肢或与外界交流。

- 优势:神经形态芯片可以直接解码大脑中复杂、异步的神经信号,实现更自然、更高效的信号翻译和控制。

实际案例:

(图片来源网络,侵删)

- IBM的TrueNorth芯片:是神经形态计算领域的先驱,它拥有100万个神经元和2.56亿个突触,功耗仅为65毫瓦(相当于一个节能灯泡的功耗),研究人员用它成功实现了实时手势识别和视频目标跟踪。

- Intel的Loihi芯片:第二代神经形态芯片,支持更复杂的在线学习算法,它已被用于研究优化问题、控制无人机群、模拟嗅觉处理等。

- 高通的Zeroth平台:旨在将神经形态计算引入移动设备,让手机能够以极低的功耗持续“感知”周围环境,实现更智能的交互。

挑战与未来展望

尽管前景广阔,但这条路依然充满挑战:

- 软件与算法生态:神经形态芯片需要全新的编程模型和算法(如脉冲神经网络,SNN),而目前深度学习领域成熟的框架(如TensorFlow, PyTorch)并不适用,建立新的软件生态是最大的瓶颈。

- 编程难度:为神经形态芯片编程比传统编程复杂得多,需要开发者具备跨学科的知识(神经科学、计算机科学、电子工程)。

- 成熟度与标准化:该技术仍处于早期阶段,不同公司的芯片架构差异很大,缺乏统一的标准。

- 应用验证:需要更多杀手级应用来证明其在商业上的可行性和优越性。

未来展望:

- 混合计算架构:未来的计算系统很可能不是单一的神经形态芯片,而是传统高性能计算单元(如GPU)与神经形态芯片的异构融合,CPU负责逻辑控制和通用计算,GPU负责大规模并行计算,而神经形态芯片则专门负责高效、实时的感知和在线学习任务。

- 从“专用智能”到“通用智能”:当前的AI是“窄AI”,只能在特定领域表现出色,神经形态计算有望推动AI向更接近“通用人工智能”的方向发展,即具备学习、推理和适应多种任务的能力。

- 赋能“AI民主化”:随着神经形态芯片成本的降低和性能的提升,强大的AI能力将不再局限于大型数据中心,而是可以部署到每一个角落,赋能万物智能。

人工智能与神经形态芯片的结合,并非简单的硬件升级,而是一场计算范式的革命,它试图将AI从当前依赖海量数据和算力的“暴力计算”模式,转向更接近生物大脑的“高效、智能、自适应”模式。

虽然前路仍有挑战,但这个方向代表了计算的未来:更智能、更高效、更贴近自然,它将不仅重塑AI技术本身,更将深刻影响我们与科技互动的方式,开启一个万物智能、实时响应的新时代。

标签: 人工智能神经形态芯片协同突破 神经形态芯片AI算力突破 AI与神经形态芯片技术协同

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。