为什么需要发布AI伦理准则?(背景与动因)

AI伦理准则的出台并非偶然,而是多种因素共同推动的结果:

(图片来源网络,侵删)

- 技术飞速发展的迫切需求:以深度学习、大语言模型为代表的AI技术发展速度远超预期,其应用已渗透到金融、医疗、教育、司法、交通等关键领域,技术的力量越大,潜在的风险和负面影响也越大,必须有相应的规范来引导。

- 规避潜在风险与危害:

- 算法偏见与歧视:如果训练数据本身存在偏见(如种族、性别歧视),AI系统会放大这些偏见,导致招聘、信贷、司法判决中的不公平。

- 隐私侵犯:AI系统需要海量数据,这可能导致个人隐私被过度收集、滥用和泄露。

- 安全与失控风险:自主武器系统、AI驱动的网络攻击等,可能带来难以预估的安全威胁。

- 责任归属模糊:当自动驾驶汽车发生事故,或AI医疗诊断出现失误时,责任应该由谁承担?是开发者、使用者还是AI本身?

- 建立公众信任:公众对AI技术的信任是其广泛应用的前提,如果社会普遍担忧AI的“黑箱”操作、不可预测性和潜在威胁,就会抵制其发展,伦理准则是建立信任、推动技术与社会良性互动的重要工具。

- 全球竞争与合作的需要:AI已成为大国科技竞争的焦点,各国和地区通过发布伦理准则,不仅是为了规范本国技术,也是为了争夺全球AI治理的话语权和主导权,塑造有利于自身发展的国际规则。

AI伦理准则通常包含哪些核心原则?(核心内容)

虽然不同组织和国家发布的准则在表述上略有差异,但其核心思想高度趋同,通常围绕以下几个基本原则展开:

-

以人为本,增进人类福祉

- 核心思想:AI的发展应以促进人类繁荣、提升人类生活品质为最终目的,而不是损害人类利益或取代人类。

- 具体体现:AI应用应致力于解决气候变化、疾病、贫困等全球性挑战,改善教育、医疗等公共服务。

-

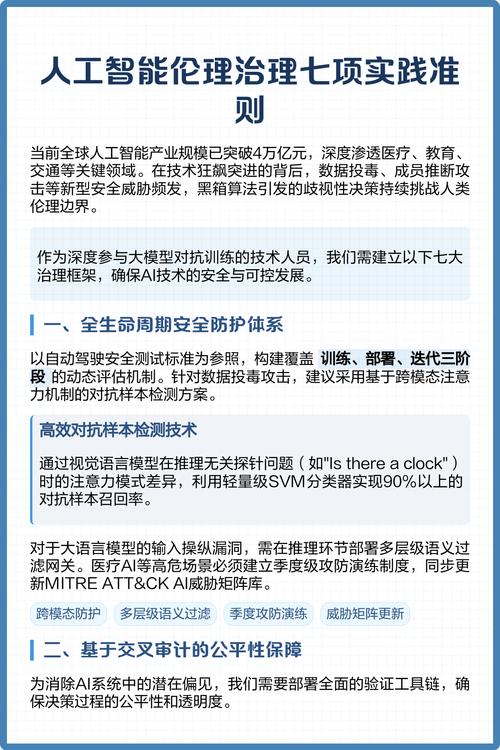

公平性与非歧视

- 核心思想:AI系统应避免和消除偏见,确保对所有个体和群体都公平对待,不因种族、性别、年龄、国籍等特征而产生歧视。

- 具体体现:在数据收集、算法设计、模型评估等环节,要进行严格的偏见检测和修正。

-

透明度与可解释性

(图片来源网络,侵删)

(图片来源网络,侵删)- 核心思想:AI系统的决策过程应该是“透明”的,至少在一定程度上是“可解释”的,尤其是在高风险领域,用户有权知道他们为何会得到某个特定的结果。

- 具体体现:开发“可解释AI”(XAI)技术,对AI的决策逻辑进行说明,避免“黑箱”操作。

-

安全、可靠与稳健

- 核心思想:AI系统必须在各种预期和非预期的条件下都能安全、稳定地运行,具备足够的鲁棒性,能够抵御恶意攻击(如对抗性攻击)和意外故障。

- 具体体现:进行严格的安全测试、建立故障安全机制、定期进行风险评估和审计。

-

问责制与追责

- 核心思想:必须明确AI系统从研发、部署到运维全生命周期中的责任主体,当AI造成损害时,必须有清晰的法律和机制来确定责任并进行追责。

- 具体体现:建立日志记录、影响评估、第三方审计等制度,确保责任可追溯。

-

隐私保护与数据安全

- 核心思想:在AI应用中,必须严格遵守数据保护法规,确保个人数据收集、使用的合法性、正当性和安全性。

- 具体体现:采用数据最小化原则、匿名化/假名化处理、加密技术,并保障用户的知情权和数据控制权。

-

促进包容与多样

(图片来源网络,侵删)

(图片来源网络,侵删)- 核心思想:在AI的研发团队、数据来源和应用场景中,应鼓励多元化和包容性,以确保AI能服务于更广泛的社会群体,避免特定群体的声音被忽视。

- 具体体现:鼓励跨学科、跨文化背景的人才参与AI研发。

谁在发布这些准则?(主要发布方)

全球范围内,多个层级的主体都在积极发布AI伦理准则:

-

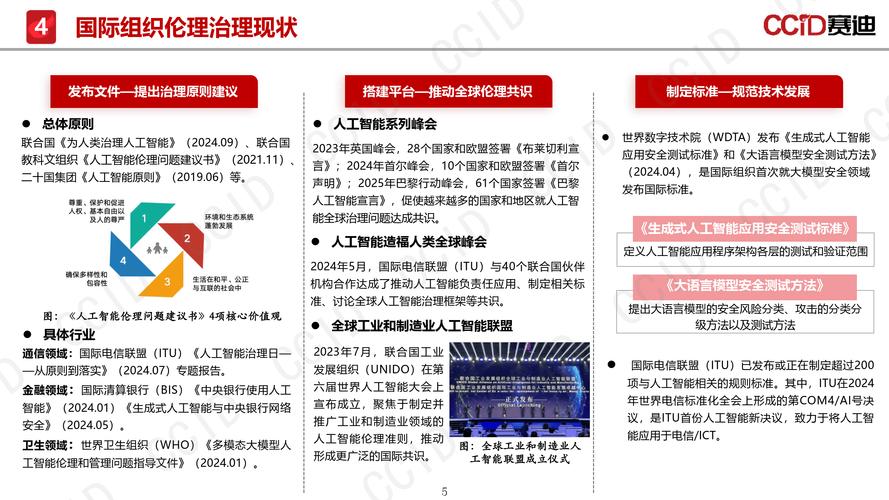

国际组织:

- 联合国教科文组织:2025年,全球首个关于AI伦理的全球性共识性文件——《人工智能伦理问题建议书》获得通过,为各国制定政策提供了重要参考。

- 经济合作与发展组织:2025年发布了《OECD人工智能原则》,提出了“包容性增长、以人为本的价值观和公平、透明、可解释、稳健、安全”等五大原则,影响深远。

- 欧盟:发布了《可信人工智能伦理指南》,提出了实现“可信AI”的七个关键要求,并以此为基础推动了全球首个具有法律约束力的《人工智能法案》。

-

国家与地区政府:

- 中国:发布了《新一代人工智能伦理规范》,明确了增进人类福祉、促进公平公正、保护隐私安全、保障安全可控、促进包容共享、坚持敏捷治理等六大原则。

- 美国:虽然没有全国统一的AI伦理法典,但白宫科技政策办公室发布了《人工智能权利法案蓝图》,并推动各行业和机构制定具体标准。

- 其他:加拿大、新加坡、日本、阿联酋等国也纷纷发布了本国的AI伦理框架或指南。

-

科技行业与学术机构:

- 科技公司:如谷歌、微软、IBM、百度、腾讯等巨头公司都发布了各自的AI原则或负责任的AI框架。

- 学术与研究机构:艾伦人工智能研究所、斯坦福大学以人为本人工智能研究院等也发布了大量研究报告和准则,为政策制定提供智力支持。

准则发布后带来了什么影响与挑战?(影响与未来展望)

积极影响:

- 提供行动指南:为政府、企业和科研人员提供了清晰的价值导向和行为规范。

- 推动技术向善:引导研发资源更多地投入到解决伦理问题的技术,如可解释AI、公平性算法等。

- 促进国际合作:为全球在AI治理领域开展对话与合作奠定了共同基础。

面临的挑战:

- 原则的抽象性与执行的复杂性:伦理原则往往是宏观和抽象的,如何将其转化为具体、可操作的技术标准、法律法规和管理流程,是一个巨大的挑战。

- “伦理漂移”与“原则声明”陷阱:一些企业可能只是将伦理准则作为公关宣传的工具,而未能真正将其融入产品开发和公司治理中,导致“说一套,做一套”。

- 全球标准的差异与冲突:不同文化、政治体制的国家对AI伦理的理解和侧重点可能不同(对隐私和监控的看法),这可能导致全球治理的碎片化。

- 动态发展的技术 vs. 相对静态的准则:AI技术日新月异,而伦理准则的制定和更新速度往往滞后于技术发展,如何保持准则的时效性是一个长期难题。

人工智能伦理准则的发布,是人类社会在拥抱技术革命的同时,主动进行自我反思和制度构建的体现,它不是一个终点,而是一个起点,关键在于如何将这些“纸面上的原则”真正“落地生根”,通过技术创新、法律完善、教育普及和国际合作,共同塑造一个安全、可靠、公平、可控且造福全人类的AI未来。

标签: AI伦理准则落地路径 人工智能发展边界界定 AI伦理与技术创新平衡

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。