核心观点:定位不同,分工明确

-

C 语言:AI 的“基石”与“引擎” C 语言是一种系统级编程语言,它的核心优势在于极致的性能、硬件的直接控制能力和对底层资源的精细管理,在 AI 领域,它不常用于快速搭建复杂的 AI 模型,而是用于构建那些对性能要求极高的底层组件和运行时环境。

(图片来源网络,侵删)

(图片来源网络,侵删) -

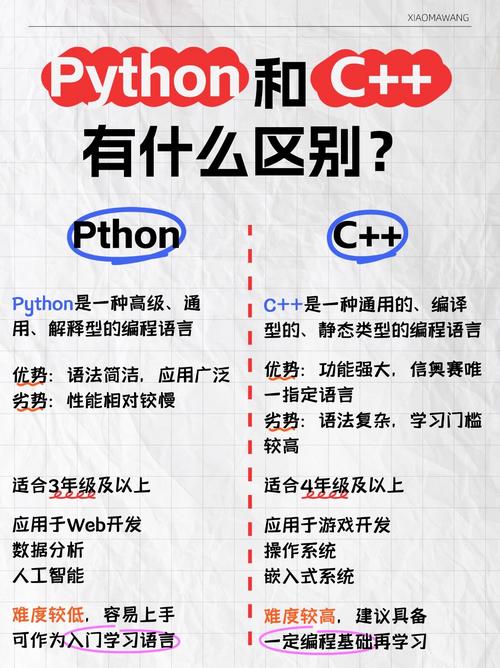

AI 编程语言(如 Python):AI 的“胶水”与“画笔” 以 Python 为代表的 AI 编程语言,是高级解释型语言,其核心优势在于简洁的语法、丰富的库、强大的社区支持和快速的开发效率,它们是 AI 研究人员和工程师用来快速设计、实验、构建和部署 AI 模型的首选工具,就像是“胶水”一样,将各种组件粘合起来,并用“画笔”描绘出 AI 的蓝图。

详细对比

| 特性 | C 语言 | AI 编程语言 (以 Python 为例) |

|---|---|---|

| 核心定位 | 系统编程、操作系统、嵌入式、高性能计算 | 快速原型、数据分析、机器学习、深度学习 |

| 性能 | 极高,编译为机器码,执行速度快,内存占用小。 | 相对较低,解释执行,有全局解释器锁,速度较慢,但可通过调用 C/C++ 库来优化。 |

| 开发效率 | 低,语法繁琐,需要手动管理内存(malloc/free),代码量大,调试复杂。 | 极高,语法简洁,像伪代码,无需关心内存管理,拥有海量的第三方库。 |

| 生态系统 | 基础但强大,标准库小,专注于系统级操作,有用于科学计算的 GSL 等库。 | 极其丰富,拥有 NumPy, SciPy, Pandas, Matplotlib, Scikit-learn, TensorFlow, PyTorch 等海量库,覆盖 AI 全流程。 |

| 易用性 | 难,对初学者不友好,概念复杂(如指针、内存管理)。 | 非常容易,入门门槛低,社区活跃,教程和文档完善。 |

| 应用场景 | - AI 框架的底层实现(如 TensorFlow Core) - GPU/CPU 内核加速(CUDA, cuDUM) - 嵌入式 AI 系统(如手机端、边缘设备上的 AI 推理) - 操作系统和驱动程序 |

- AI 模型的快速设计和实验 - 数据预处理和可视化 - 训练和评估模型 - 部署模型为 API 服务 |

C 语言在 AI 领域的具体角色

虽然 AI 的上层应用大多用 Python 实现,但其性能瓶颈部分几乎都离不开 C/C++ 的身影。

AI 框架的底层核心

几乎所有的主流 AI 框架,其核心计算引擎都是用 C++(C 的超集)编写的。

- TensorFlow: 其核心部分

TensorFlow Core是用 C++ 实现的,Python 接口(tf.keras等)只是一个高级封装,当你调用 Python API 时,实际上是在调用底层的 C++ 代码来执行张量运算。 - PyTorch: 与 TensorFlow 类似,其核心 C++ 库

ATen(A Tensor Library) 负责了所有张量的核心操作。 - 为什么? 因为神经网络的训练和推理涉及海量的矩阵运算,这些计算需要极致的速度,C++ 提供了这种性能保证,并且可以针对特定的硬件(如 CPU 的 AVX 指集)进行深度优化。

硬件加速的桥梁

现代 AI 严重依赖 GPU、TPU 等专用硬件。

- CUDA: NVIDIA 的 CUDA 编程模型就是基于 C/C++ 的,开发者使用 CUDA C/C++ 来编写在 GPU 上并行执行的内核函数,从而实现对海量数据的并行计算,这是深度学习训练能够成功的关键。

- cuDNN, cuBLAS: 这些是 NVIDIA 提供的用于深度学习的基础库(如卷积、BLAS 矩阵运算),它们也是用 C/C++ 编写的,并提供了高度优化的实现。

高性能推理部署

当 AI 模型训练完成后,需要部署到生产环境中进行推理(预测),在很多场景下,推理速度至关重要。

- 边缘计算: 在手机、嵌入式设备、自动驾驶汽车等资源受限的环境中,通常使用 C++ 来编写推理引擎,因为它能提供更低的延迟和更小的内存占用。

- 高性能服务器: 即使在服务器上,为了处理高并发请求,也会用 C++ 或 Rust 等语言将训练好的模型封装成一个高性能的推理服务。

科学计算基础

很多 AI 算法的基础是数学和统计学,C 语言拥有一些经典的科学计算库,

- GNU Scientific Library (GSL): 提供了大量的数学函数,如随机数生成、线性代数、特殊函数等,是构建底层算法的基石。

AI 编程语言(以 Python 为例)的角色

快速原型设计与研究

研究人员可以用 Python 几行代码就实现一个复杂的神经网络结构,并立即看到结果,这种“胶水语言”的特性极大地加速了 AI 算法的创新和迭代。

数据处理与分析

AI 的第一步是数据,Python 的 Pandas 和 NumPy 库让数据清洗、转换、分析和可视化变得异常简单和高效。

模型训练与评估

Scikit-learn 提供了几乎所有经典机器学习算法的简单接口。TensorFlow 和 PyTorch 则让构建和训练深度学习模型变得非常直观。Matplotlib 和 Seaborn 等库则方便地可视化训练过程和结果。

统一的生态系统

Python 将数据获取、处理、模型训练、评估、部署等所有环节无缝地连接起来,形成一个强大的工作流,开发者无需在多种语言之间切换,极大地提高了生产力。

总结与未来趋势

| C 语言 | AI 编程语言 (Python) | |

|---|---|---|

| 形象比喻 | 发动机、骨骼、地基 | 车身、内饰、设计师 |

| 关系 | 提供动力和支撑 | 提供便捷的实现和用户体验 |

C 语言和 AI 编程语言(如 Python)不是竞争对手,而是合作伙伴,它们共同构成了现代 AI 技术的完整栈:

- 顶层 (应用层):用 Python 进行快速开发、模型训练和业务逻辑实现。

- 底层 (系统层):用 C/C++ 实现高性能计算核心、硬件驱动和优化算法,为上层提供强大的动力。

未来趋势:

- 更深度的融合:AI 框架会继续用 C++/Rust 等语言来提升性能,同时提供更友好的 Python API 和其他语言接口(如 JavaScript, Java)。

- 新兴语言的挑战:像 Julia 这样的语言,旨在兼具 Python 的易用性和 C 的高性能,正在科学计算和 AI 领域崭露头角,试图打破 C 和 Python 之间的壁垒。

- 端侧 AI 的兴起:随着物联网和边缘计算的发展,在资源受限的设备上运行 AI 模型变得越来越重要,这将进一步巩固 C/C++ 在 AI 部署端的核心地位。

对于 AI 理解这种关系至关重要:先用 Python 快速上手 AI 的核心思想和应用,再根据需要深入学习 C/C++ 来理解底层原理或解决性能瓶颈,是成长为一名优秀 AI 工程师的必经之路。

标签: C语言与AI编程语言选择 C语言协同AI开发场景 AI编程语言vs C语言优劣势