什么是基于人工智能的视觉识别?

人工智能视觉识别就是利用计算机(人工智能系统)来“看懂”和理解图像或视频中的内容,它模拟人类视觉系统的工作原理,让机器能够自动识别、分类、检测和跟踪图像中的物体、场景、行为甚至情感。

与传统的计算机视觉不同,AI视觉识别的核心驱动力是深度学习,特别是卷积神经网络,传统方法依赖人工设计的特征提取器(如SIFT、HOG),而AI方法能够从海量数据中自动学习最有效的特征表示,从而在复杂度和准确度上实现了质的飞跃。

技术演进:从“看”到“看懂”的飞跃

AI视觉识别的发展历程可以看作是深度学习技术不断突破的过程:

-

早期(2006年前):传统计算机视觉时代

- 特点:依赖专家手动设计的算法和特征提取器。

- 局限:处理能力有限,对光照、角度、遮挡等变化非常敏感,泛化能力差,人脸识别早期主要基于PCA(主成分分析)等方法。

-

突破期(2012年):AlexNet的诞生

(图片来源网络,侵删)

(图片来源网络,侵删)- 事件:在2012年的ImageNet大规模视觉识别挑战赛中,由Geoffrey Hinton团队开发的AlexNet横空出世,其错误率远低于所有传统方法。

- 意义:这标志着深度学习,特别是卷积神经网络,正式成为视觉领域的主流技术,AlexNet的成功证明了深层网络和GPU并行计算在处理大规模图像数据上的巨大潜力。

-

深化期(2025-2025年):架构的创新与成熟

- VGGNet (2025):证明了通过增加网络深度(如16层、19层)可以有效提升性能,结构简洁规整。

- GoogLeNet (Inception, 2025):提出了“Inception模块”,通过在单一层内使用不同尺寸的卷积核,增加了网络宽度和计算效率。

- ResNet (2025):解决了“深度网络退化”问题,通过引入“残差连接”(Shortcut Connection),成功训练了上百层甚至上千层的网络,使得性能得到进一步提升,成为后续许多模型的基础。

- YOLO/SSD (2025-2025):将目标检测的速度提升到了实时级别,实现了“单次前向传播”即可完成检测,为自动驾驶、视频监控等应用铺平了道路。

-

变革期(2025年至今):Transformer与大模型时代

- ViT (Vision Transformer, 2025):将自然语言处理领域大获成功的Transformer架构引入视觉领域,它将图像切分成小块,像处理单词序列一样处理这些图像块,在足够大的数据集上训练后,性能可以媲美甚至超越CNN。

- DALL-E, Midjourney, Stable Diffusion (2025-):基于扩散模型的文生图模型,实现了从文本到图像的生成,展示了AI在“创造”视觉内容方面的惊人能力,是视觉领域的又一次革命。

- SAM (Segment Anything Model, 2025):一个强大的图像分割基础模型,具有“提示”能力,用户只需点击一个点,它就能分割出对应的物体,展现了AI模型的泛化和零样本学习能力。

核心任务与应用

AI视觉识别已经发展出多种核心任务,每种任务都有其独特的应用场景。

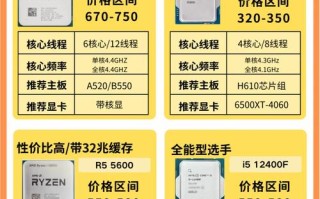

| 任务类型 | 核心目标 | 简单例子 | 典型应用 |

|---|---|---|---|

| 图像分类 | 判断一张图片中主要是什么物体。 | 输入一张猫的图片,输出“猫”。 | 相机自动分类相册、垃圾邮件图片过滤、商品识别。 |

| 目标检测 | 在图片中找到特定物体的位置(用方框标出)并识别其类别。 | 在一张街景图中,框出并识别出所有的“汽车”、“人”、“交通灯”。 | 自动驾驶(行人、车辆检测)、安防监控(异常闯入检测)、工业质检(缺陷检测)。 |

| 图像分割 | 将图像中的每个像素分配到一个类别,实现像素级的精细划分。 | 将一张风景图中的天空、建筑、草地、道路等区域精确地分割开来。 | 医学影像分析(肿瘤区域分割)、自动驾驶(可行驶区域分割)、背景虚化(人像模式)。 |

| 人脸识别 | 验证或识别图像中的人脸身份。 | 手机解锁、门禁系统、移动支付身份验证。 | 公安安防(犯罪嫌疑人追踪)、金融风控、身份认证。 |

| 姿态估计 | 识别图像中人物或动物的关键关节点(如手肘、膝盖)。 | 识别出一个人在做瑜伽时的动作是否标准。 | 体育分析、动作捕捉、人机交互(手势控制)、健身应用。 |

| 光学字符识别 | 识别图像中的文字信息。 | 识别一张发票上的金额、识别一张路牌上的文字。 | 文档数字化、车牌识别、翻译软件拍照取词。 |

| 图像生成 | 根据文本描述或其他输入,创建全新的图像。 | 输入“一只穿着宇航服的柴犬在月球上”,生成对应的图片。 | 创意设计、游戏美术、广告制作、内容创作。 |

关键挑战与局限性

尽管AI视觉识别取得了巨大成功,但仍面临诸多挑战:

- 数据依赖:高性能模型需要海量、高质量、经过精确标注的数据,数据获取和标注成本高昂,且在特定领域(如医疗)数据稀疏。

- 鲁棒性与泛化能力:

- 对抗性攻击:人眼几乎无法察觉的微小扰动,就能导致模型做出完全错误的判断(将“熊猫”识别为“长臂猿”)。

- 域偏移:在一种数据集上训练的模型,在另一种风格或场景的数据上表现会急剧下降,在晴天街道上训练的自动驾驶模型,在雨雪天可能无法工作。

- 可解释性差(黑箱问题):深度学习模型像一个“黑箱”,我们知道它输入和输出,但很难理解其内部的决策逻辑和原因,这在医疗、金融等高风险领域是致命的。

- 计算资源消耗大:训练顶尖的视觉模型需要强大的GPU/TPU集群和巨大的能耗,限制了个人和小型机构的参与。

- 偏见问题:如果训练数据本身存在偏见(如某些种族或性别在特定场景下数据不足),模型学习到的结果也会带有偏见,造成社会不公。

典型应用领域

AI视觉识别已经渗透到我们生产和生活的方方面面:

- 医疗健康:辅助医生进行医学影像分析(如CT、MRI中的肿瘤检测)、病理切片分析、手术导航。

- 自动驾驶:实时感知周围环境,识别车辆、行人、交通标志、车道线,做出驾驶决策。

- 安防监控:人脸识别门禁、异常行为检测(如摔倒、打架)、客流统计、失踪人员搜寻。

- 工业制造:产品质量检测(如划痕、裂纹)、机器人引导、安全生产监控(如工人是否佩戴安全帽)。

- 零售电商:无人商店(拿了就走)、商品智能搜索(拍照搜同款)、货架管理、客流分析。

- 娱乐与社交媒体:人脸美颜/滤镜、照片自动分类与打标签、视频内容审核、虚拟偶像/数字人。

- 农业:无人机巡检农田,识别作物长势、病虫害、杂草区域,实现精准农业。

未来趋势

- 多模态融合:将视觉与文本、声音、传感器数据等多种信息融合,让AI获得更全面的理解能力,GPT-4V就能理解图像内容并进行复杂的逻辑推理。

- 自监督学习与小样本学习:减少对人工标注数据的依赖,让模型能够从未标注的数据中学习,或仅用少量样本就能快速适应新任务。

- 边缘计算与端侧智能:将AI模型直接部署在手机、摄像头、汽车等终端设备上,实现实时响应、保护用户隐私、降低云端延迟。

- 生成式AI的普及:以Diffusion Models为代表的生成技术将进一步成熟,成为设计师、开发者和普通人的创意工具,推动AIGC(AI Generated Content)产业的爆发。

- 可解释性与可信AI:开发能够解释自己决策过程的AI模型,增强人类对技术的信任,使其在关键领域得到更安全的应用。

基于人工智能的视觉识别已经从一个前沿的学术研究领域,转变为驱动社会进步和产业变革的核心引擎,它不仅让机器“看见”,更重要的是让机器“看懂”,赋予其感知和理解世界的能力,随着技术的不断突破,AI视觉识别将更加智能、高效、普惠,深刻地改变我们的工作和生活方式。

标签: 人工智能视觉识别技术瓶颈突破 视觉识别AI技术瓶颈解决方案 突破AI视觉识别技术瓶颈方法