核心概念:什么是图像识别?

图像识别,更准确地说是计算机视觉 的一个核心任务,其目标是让计算机能够像人一样“看懂”图像或视频中的内容,它不仅仅是简单地“看到”,而是要理解图像中的信息,

- 分类: 这张图片里是什么?(猫、狗、汽车)

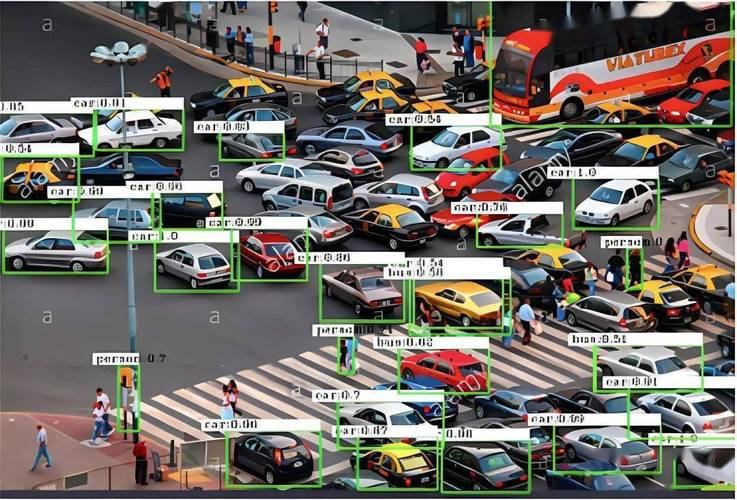

- 定位: 图像中某个物体在哪里?(用方框框出猫的位置)

- 检测: 图像中有哪些物体,它们分别在哪里?(图像中有2个人和1辆汽车)

- 分割: 图像中的每个像素分别属于哪个物体?(精确地勾勒出猫的轮廓,背景是草地)

发展历程:从传统方法到深度学习

图像识别算法的演进是人工智能发展的一个缩影,大致可以分为三个阶段:

传统机器学习方法 (约 1980s - 2012)

在深度学习兴起之前,图像识别主要依赖手动设计的特征提取器。

-

核心思想:

- 人工设计特征: 研究人员需要根据先验知识,手动设计算法来提取图像中有效的、有区分度的特征。

- SIFT (尺度不变特征变换): 对图像的缩放、旋转和光照变化不敏感。

- HOG (方向梯度直方图): 统计图像局部区域的梯度方向,常用于行人检测。

- HAAR 特征: 用于人脸检测,通过黑白矩形模板计算图像区域的像素差值。

- 分类器: 将提取的特征输入到一个传统的机器学习分类器中进行训练和预测,常用的分类器有:

- 支持向量机

- 决策树

- Adaboost

- 人工设计特征: 研究人员需要根据先验知识,手动设计算法来提取图像中有效的、有区分度的特征。

-

缺点:

(图片来源网络,侵删)

(图片来源网络,侵删)- 特征依赖人工设计: 设计出好的特征需要大量的领域知识和经验,且泛化能力有限。

- 性能瓶颈: 对于复杂场景(如自然场景下的物体识别),手工设计的特征往往无法捕捉到深层语义信息,导致准确率不高。

深度学习革命 (约 2012 - 至今)

以 AlexNet 在 2012 年 ImageNet 竞赛中的“碾压式”胜利为标志,深度学习彻底改变了图像识别领域。

-

核心思想:

- 自动特征学习: 神经网络,特别是卷积神经网络,能够从原始像素数据中自动学习和提取从低级到高级的特征,第一层可能学习到边缘和颜色,第二层学习到纹理和形状,深层网络则能学习到物体的部件乃至整个物体。

- 端到端学习: 省去了手动设计特征的繁琐步骤,直接将原始图像输入网络,输出最终的识别结果。

-

优点:

- 性能卓越: 在各种图像识别任务上达到了前所未有的高度。

- 自动化特征提取: 减少了对人工经验的依赖,可处理更复杂的视觉任务。

主流图像识别算法模型

现代图像识别算法几乎全部基于深度学习,特别是卷积神经网络,以下是一些里程碑式和当前主流的模型架构:

CNN 基础架构

CNN 是所有图像识别算法的基石,其核心组件包括:

- 卷积层: 使用卷积核 在图像上滑动,提取局部特征(如边缘、角点),这是 CNN 的核心,它具有参数共享 和稀疏连接 的特性,大大减少了模型参数。

- 激活函数: 通常使用 ReLU (Rectified Linear Unit),为网络引入非线性,使其能够学习更复杂的模式。

- 池化层: 对特征图进行下采样,降低特征维度,减少计算量,并增加模型的平移不变性,常用最大池化。

- 全连接层: 将所有特征进行加权组合,用于最终的分类或回归任务。

经典模型 (奠基者)

- LeNet-5 (1998): 由 Yann LeCun 提出,是早期用于手写数字识别的 CNN,奠定了 CNN 的基本结构。

- AlexNet (2012): Krizhevsky 等人提出,是深度学习在图像识别领域取得突破性胜利的标志,它使用了更深的网络、ReLU 激活函数、Dropout 和数据增强等技术。

- VGGNet (2025): 牛津大学团队提出,其特点是结构简洁、规整,使用非常小的 3x3 卷积核堆叠来构建深层网络,证明了网络的深度对性能至关重要。

- GoogLeNet / Inception (2025): Google 提出,其核心是 Inception 模块,它在一个模块内并行使用不同大小的卷积核,并将结果拼接起来,既能捕捉多尺度特征,又控制了计算量。

- ResNet (2025): 何恺明等人提出,引入了残差连接,解决了深度网络中的梯度消失/爆炸问题,使得训练数百甚至上千层的网络成为可能,这是图像识别领域最重要的工作之一。

当前主流与前沿模型

为了追求更高的精度和效率,研究者们在 CNN 的基础上提出了许多改进模型。

-

轻量化网络 (移动端部署):

- MobileNet: 使用深度可分离卷积,将标准卷积分解为深度卷积和逐点卷积,极大减少了计算量和参数量,非常适合手机等移动设备。

- ShuffleNet: 引入通道混洗 操作,解决了分组卷积带来的信息流通问题,进一步优化了效率。

- EfficientNet: 提出了一种复合缩放方法,统一地缩放网络的深度、宽度和分辨率,在精度和效率之间取得了最佳平衡。

-

基于 Vision Transformer 的模型 (颠覆性架构):

- Vision Transformer (ViT, 2025): 受 NLP 领域 Transformer 模型的启发,ViT 将图像分割成一系列小块,像处理单词序列一样处理这些图像块,完全抛弃了 CNN 的卷积结构,在足够大的数据集上预训练后,其性能可以超越最先进的 CNN 模型。

- Swin Transformer: 对 ViT 进行了改进,引入了层级结构和滑动窗口注意力机制,使其能够更好地处理不同尺度的物体,并且计算复杂度更低,成为当前图像识别和分割任务的 SOTA (State-of-the-Art) 模型之一。

关键技术与训练方法

要训练出强大的图像识别模型,离不开以下关键技术:

-

大规模数据集:

- ImageNet: 包含 1400 万张图片,涵盖 2 万个类别,是深度学习时代最重要的“燃料”。

- COCO (Common Objects in Context): 不仅包含分类标签,还有物体检测、实例分割、关键点标注等,是多任务学习的标杆数据集。

- 其他: CIFAR-10/100, MNIST, Pascal VOC 等。

-

迁移学习:

- 概念: 由于从头训练一个大型模型需要海量数据和巨大的计算资源,实践中通常采用迁移学习,即利用在大型数据集(如 ImageNet)上预训练好的模型权重,然后在自己的特定任务数据集上进行微调。

- 优点: 大大减少了训练时间和所需数据量,并能获得更好的性能,是当前工业界和学术界的主流做法。

-

数据增强:

为了防止模型过拟合并提升其泛化能力,会对训练数据进行随机变换,生成新的“虚拟”样本,常见方法包括:随机裁剪、旋转、翻转、颜色抖动、添加噪声等。

-

正则化技术:

- Dropout: 在训练过程中随机“丢弃”一部分神经元,强制网络学习更鲁棒的特征。

- 权重衰减: 通过在损失函数中加入 L2 范数惩罚项,限制权重的大小,防止过拟合。

-

优化器:

- Adam (Adaptive Moment Estimation): 目前最常用的优化器,它结合了动量法和自适应学习率,能快速稳定地收敛。

应用场景

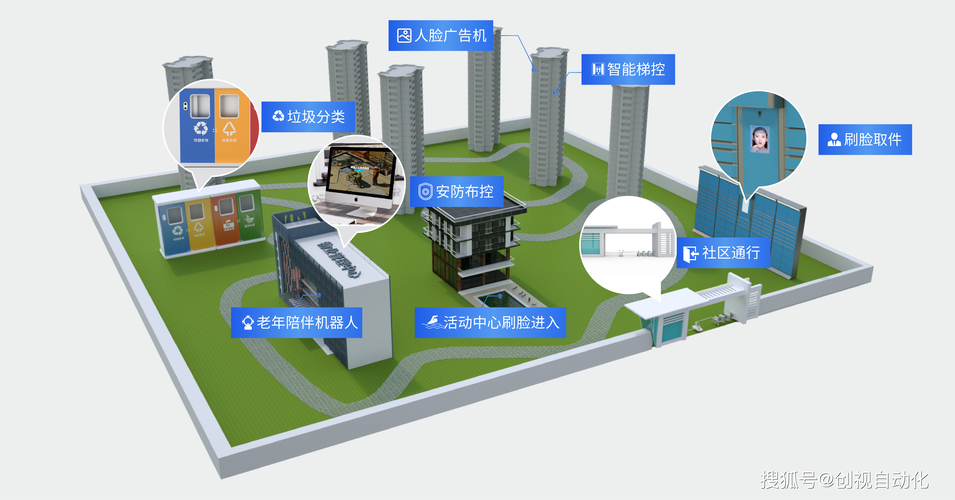

图像识别技术已经渗透到我们生活的方方面面:

- 人脸识别: 手机解锁、移动支付、门禁系统、安防监控。

- 自动驾驶: 车辆、行人、交通标志、车道线的检测与识别。

- 医疗影像: 辅助医生识别 CT、X 光、MRI 中的病灶(如肿瘤、骨折)。

- 工业质检: 在生产线上自动检测产品缺陷,如划痕、裂纹。

- 零售与电商: 商品识别、以图搜图、无人商店的结算。

- 农业: 无人机通过图像识别作物长势、病虫害和估产。

- 内容审核: 自动识别和过滤图片中的暴力、色情等不良信息。

未来趋势与挑战

-

趋势:

- 多模态融合: 结合图像、文本、声音等多种信息进行理解。

- 自监督学习: 减少对大规模标注数据的依赖,让模型从海量无标签数据中自主学习。

- 可解释性 AI (XAI): 理解模型“为什么”会做出某个决策,尤其是在医疗、金融等高风险领域。

- 边缘计算: 将轻量级模型部署在终端设备上,实现实时、低延迟的本地处理。

-

挑战:

- 鲁棒性: 模型在对抗性攻击(故意添加微小干扰的图像)、恶劣光照、天气变化等情况下的表现。

- 偏见与公平性: 训练数据中的偏见可能导致模型对特定人群产生不公平的判断。

- 数据隐私: 图像数据包含大量个人敏感信息,如何保护隐私是一个重要问题。

- 计算成本: 训练顶级模型需要巨大的算力,存在资源壁垒。

图像识别算法已经从依赖人工设计的传统方法,演进到了由深度学习主导的、能够自动学习特征的全新阶段,以 CNN 为基础,ResNet、EfficientNet 等模型不断刷新性能记录,而 Vision Transformer 等新架构的出现又带来了新的范式革命,随着技术的不断进步,图像识别将在更多领域发挥关键作用,同时也面临着鲁棒性、公平性和隐私等深刻挑战。

标签: 人工智能图像识别算法瓶颈突破 图像识别算法优化新思路 深度学习图像识别性能提升