什么是 NPU?—— 它是什么?

NPU 是一种专门为高效处理人工智能任务,特别是神经网络计算而设计的硬件加速器。

您可以把它想象成:

- CPU (中央处理器):是“全能选手”,负责处理各种通用任务,但做复杂的数学计算(比如神经网络中的大量乘加运算)时效率不高。

- GPU (图形处理器):是“并行计算专家”,拥有成千上万个核心,非常适合同时处理大量数据(如渲染游戏画面),虽然也能用来跑AI模型,但并非为其专门优化。

- NPU (神经网络处理单元):是“AI专项运动员”,它的架构和指令集都经过深度优化,专门为了执行神经网络中的矩阵运算而生,就像一个“数学计算器”,在处理AI任务时速度最快、功耗最低。

为什么需要 NPU?—— 它解决了什么问题?

在NPU出现之前,移动设备上的AI任务主要依赖CPU或GPU来完成,这带来了几个关键问题:

- 功耗高:CPU和GPU处理AI计算时非常耗电,会迅速消耗设备电量,导致发热严重。

- 性能瓶颈:复杂的AI模型(如大型语言模型、高精度图像识别)需要巨大的计算量,CPU/GPU的处理能力有限,导致响应慢,体验卡顿。

- 发热严重:高功耗必然带来高热量,影响设备稳定性和用户握持体验。

NPU的出现就是为了解决这些问题:

- 极致的能效比:NPU通过专用架构,在执行相同AI任务时,其功耗远低于CPU和GPU,从而在保证性能的同时,大大降低功耗和发热。

- 强大的算力:现代NPU的算力(通常以 TOPS,即万亿次运算/秒为单位)已经非常惊人,足以支持复杂的本地AI应用。

- 解放CPU/GPU:将AI任务卸载给NPU,可以让CPU专注于操作系统、应用逻辑等任务,GPU专注于图形渲染,整个系统运行更流畅。

NPU 是如何工作的?—— 核心原理

NPU的核心优势在于其架构。

- 传统CPU/GPU:采用的是冯·诺依曼架构,计算和内存是分开的,数据需要从内存中取出,送到运算单元处理,然后再送回内存,这个过程需要不断地搬运数据,耗时耗能(被称为“内存墙”)。

- NPU:采用的是数据流架构 或 脉动阵列。

- 想象一个工厂流水线:NPU内部有大量的计算单元,它们之间直接连接,数据像流水一样在各个计算单元之间流动、处理,而不需要频繁地与外部内存交互。

- 矩阵运算的利器:神经网络的核心是大量的矩阵乘法和加法运算,脉动阵列这种架构天生就适合这种重复性高、并行性强的计算模式,可以实现极高的计算效率。

NPU 在手机上有哪些具体应用?—— 我们每天都在用它

您可能没有意识到,但很多手机上的“黑科技”背后都有NPU的强力支撑:

-

计算摄影:

- 实时背景虚化:通过AI算法精确识别人像和背景,实现单摄也能拍出类似单反的虚化效果。

- 夜景模式:通过多帧合成和AI降噪,在暗光下拍出明亮、清晰、低噪点的照片。

- AI HDR:智能优化画面的高光和阴影细节,让照片更自然。

- 视频防抖:利用AI算法预测和补偿手部抖动,拍出更稳定流畅的视频。

-

人脸识别与解锁:快速、安全地识别人脸特征,完成解锁和支付。

-

智能语音助手:如Siri、小爱同学、小布等,NPU负责在本地实时处理你的语音指令,实现“离线唤醒”和快速响应,无需将语音数据上传到云端,保护隐私且更省电。

(图片来源网络,侵删)

(图片来源网络,侵删) -

实时翻译:在相机或输入法中,实现语音、文字、图片的实时互译。

-

AI视频增强:在线观看视频时,NPU可以实时提升视频分辨率、修复老旧电影的画质、优化色彩。

-

大型本地AI模型:这是最新的趋势,NPU的强大算力使得在手机上运行轻量级的大语言模型成为可能,实现端侧AI。

- 本地AI聊天机器人,无需联网即可使用。

- 基于手机相册的AI总结和搜索。

- 实时代码生成和解释。

主流手机厂商的 NPU 技术与命名

各大厂商都有自己的NPU技术,并赋予了不同的品牌名称:

| 厂商 | NPU 架构/系列 | 代表芯片 | 特点 |

|---|---|---|---|

| 华为 | 达芬奇架构 | 麒麟9000S、麒麟9000 | 行业先行者,NPU与CPU、GPU等通过麒麟芯协同,性能和能效比极高。 |

| 苹果 | 神经网络引擎 | A17 Pro、M系列芯片 | 深度集成于SoC中,与iOS系统无缝配合,在隐私保护和性能上表现出色。 |

| 高通 | Hexagon DSP | 骁龙8 Gen 3 | 利用其Hexagon数字信号处理器作为AI引擎,不断迭代,性能强大。 |

| 联发科 | APU (AI Processing Unit) | 天玑9300 | 强调“大核+小核”的异构设计,在AI性能和能效上持续进步。 |

| 三星 | NPU | 骁龙8 Gen 3 for Galaxy | 与高通合作,集成其Hexagon NPU。 |

衡量NPU性能的关键指标是算力,单位是 TOPS (Trillion Operations Per Second)。 苹果A17 Pro的NPU算力约为35 TOPS,而一些旗舰芯片的NPU算力已超过40 TOPS。

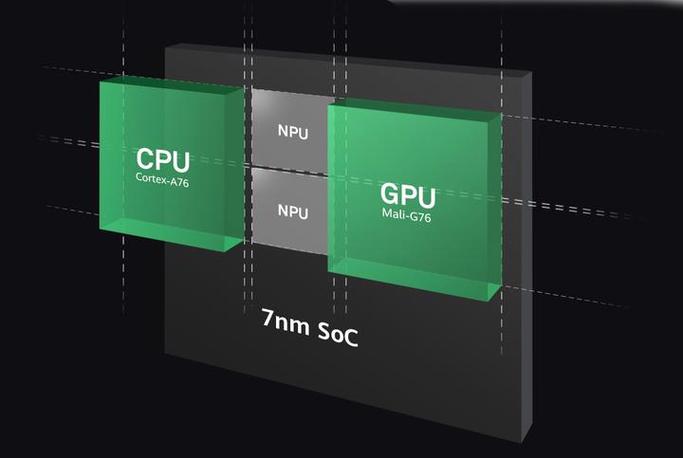

NPU、CPU、GPU 的协同工作

现代手机SoC(System on a Chip,片上系统)是一个异构计算平台,NPU、CPU、GPU等各司其职,协同工作:

- 任务调度:操作系统或AI框架(如Android的NNAPI)会根据任务的类型和需求,将AI计算任务分配给最合适的处理器。

- NPU上场:对于实时、低延迟、高能效的AI任务(如拍照、语音唤醒),系统会优先将其交给NPU处理。

- GPU/CPU辅助:对于一些不那么紧急或需要高精度的AI任务,或者NPU无法处理的复杂任务,可能会交给GPU(利用其并行计算能力)或CPU(处理通用逻辑)。

- 结果返回:计算完成后,结果返回给应用程序,呈现给用户。

这种“异构计算”模式,是实现移动设备强大性能和长续航的关键。

NPU 是移动AI时代的“发动机”。 它通过专门化的硬件架构,解决了传统处理器在AI任务上的性能瓶颈和功耗问题,使得在手机上运行复杂、实时的AI应用成为可能。

从我们每天使用的拍照、解锁,到未来可能普及的本地AI助手,NPU正在深刻地改变我们的移动体验,并将推动人工智能从云端走向每个人的口袋,实现真正的“端侧智能”,随着技术的不断进步,NPU的能力将越来越强大,成为智能手机不可或缺的核心竞争力。

标签: 移动NPU赋能智能终端计算 人工智能NPU提升终端性能 智能终端NPU应用场景