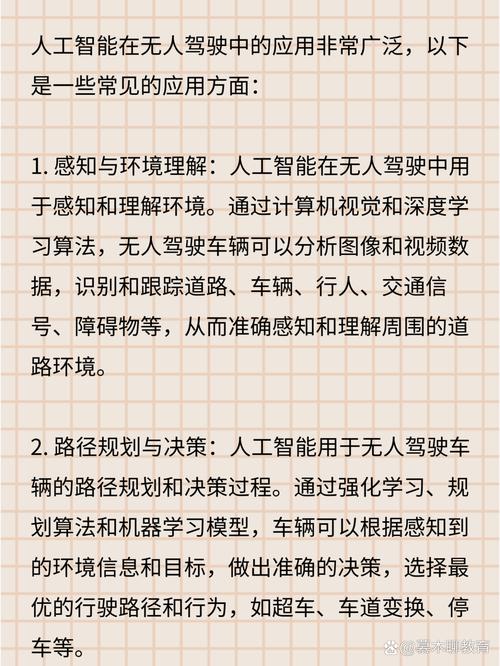

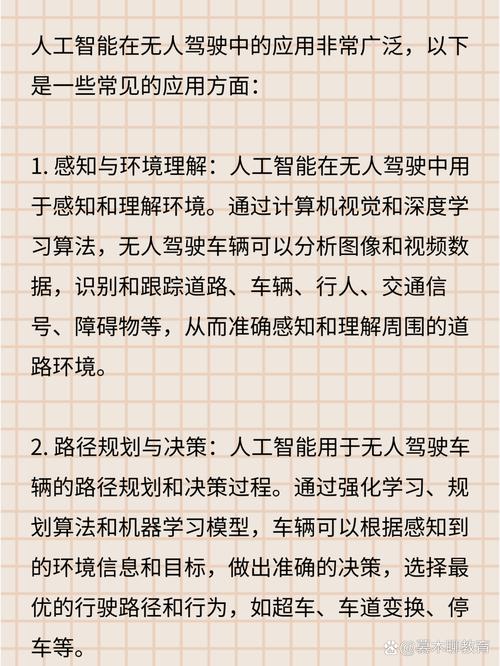

这不仅仅是一个单一的算法,而是一个极其复杂、多层次的系统,融合了计算机视觉、传感器融合、规划与决策、控制等多个领域的尖端AI技术。

我们可以将无人驾驶的AI算法体系想象成一个“智能驾驶员”的大脑,它需要完成从“感知”到“思考”再到“行动”的全过程。

核心框架:四大模块

无人驾驶系统通常被划分为四个核心功能模块,每个模块都由复杂的AI算法驱动:

- 环境感知 - “眼睛”和“耳朵”:负责通过传感器数据理解车辆周围的世界。

- 定位与建图 - “我在哪?”:精确确定车辆自身在地图中的位置。

- 预测与决策规划 - “我该做什么?”:基于感知结果,预测其他交通参与者的行为,并规划出安全的行驶路径。

- 车辆控制 - “如何做?”:将规划好的路径转化为具体的车辆控制指令(如转向、油门、刹车)。

下面我们详细拆解每个模块所使用的核心AI算法。

环境感知

这是无人驾驶的基石,目标是识别和理解车辆周围的动态和静态物体。

输入数据:

- 摄像头:提供丰富的颜色和纹理信息。

- 激光雷达:提供精确的3D点云数据,用于测距和建模。

- 毫米波雷达:不受光照和天气影响,能精确测速和测距。

- 超声波传感器:主要用于近距离泊车辅助。

核心AI算法:

A. 计算机视觉 - 主要处理摄像头数据

-

目标检测:识别图像中的物体(车辆、行人、骑行者、交通标志、信号灯等)并定位其边界框。

- 经典算法:R-CNN系列、YOLO (You Only Look Once)、SSD (Single Shot MultiBox Detector)。

- 技术特点:YOLO和SSD等单阶段检测器速度快,非常适合实时性要求高的自动驾驶场景,它们将检测问题回归为一个回归问题,直接预测物体的类别和位置。

-

语义分割:对图像中的每个像素进行分类,理解场景的完整结构(如道路、人行道、建筑、天空)。

- 经典算法:FCN (Fully Convolutional Network)、U-Net、DeepLab系列。

- 技术特点:U-Net因其编码器-解码器结构和跳跃连接,在分割任务中表现出色,能很好地保留细节信息。

-

实例分割:在语义分割的基础上,进一步区分同一类别的不同实例(区分多辆不同的车)。

(图片来源网络,侵删)

(图片来源网络,侵删)- 经典算法:Mask R-CNN。

- 技术特点:它不仅能检测物体,还能生成物体的精确轮廓掩码,为后续的跟踪和行为分析提供更精细的数据。

B. 点云处理 - 主要处理激光雷达数据

-

目标检测:从3D点云中识别物体。

- 经典算法:

- PointNet:直接处理无序点云的 pioneering 网络结构。

- VoxelNet:将点云划分为三维体素,然后使用3D CNN进行特征提取和检测。

- PointPillars:将点云转化为“柱状图”(Pillars),再使用2D CNN处理,效率很高。

- SECOND:一种高效的基于体素的检测器。

- 经典算法:

-

点云分割:将点云中的每个点分类到不同的物体或区域。

- 经典算法:PointNet++(PointNet的改进版,能更好地处理局部几何结构)。

C. 传感器融合

单一传感器有局限性(如摄像头怕恶劣天气,LiDAR成本高且怕雨雾),因此必须将多源数据融合,取长补短,得到比任何单一传感器都更鲁棒、更准确的环境模型。

- 融合层级:

- 前融合:在原始数据层进行融合,将摄像头图像和LiDAR点云投影到同一个坐标系,然后输入一个统一的网络进行联合处理,优点是信息损失最少,缺点是算法设计复杂。

- 后融合:每个传感器独立进行目标检测,然后在结果层(如目标框、置信度)进行融合,用卡尔曼滤波器对多个传感器的检测结果进行加权融合,优点是算法模块化,缺点是可能丢失原始数据中的关联信息。

- 现代趋势:基于深度学习的端到端前融合是当前的研究热点,能更好地利用多模态信息的互补性。

定位与建图

车辆需要知道“我在哪里”,才能在规划时做出正确决策。

- 核心任务:确定车辆在预先构建的高精度地图中的精确位置和姿态(6自由度:x, y, z, roll, pitch, yaw)。

- 核心AI算法:

- SLAM (Simultaneous Localization and Mapping) - 即时定位与地图构建:

- LIO-SAM (LiDAR-Inertial Odometry with Smoothing and Mapping):一种流行的基于LiDAR和惯性测量单元的SLAM算法,它将前端紧耦合的里程计计算和后端的图优化相结合,精度高,实时性好。

- VIO (Visual-Inertial Odometry):基于摄像头和IMU的视觉里程计。

- 高精地图匹配:

- 将实时感知到的环境特征(如道路边缘、建筑轮廓、交通标志)与预先存储的高精度地图进行匹配,从而实现厘米级的精确定位。

- 算法:迭代最近点、正态分布变换等经典算法,以及基于深度学习的特征匹配网络。

- SLAM (Simultaneous Localization and Mapping) - 即时定位与地图构建:

预测与决策规划

这是无人驾驶的“大脑”,负责做出安全、高效、符合人类驾驶习惯的决策。

-

A. 预测模块:预测其他交通参与者(车辆、行人等)在未来几秒内的行为轨迹。

- 传统方法:基于物理模型(如恒定速度、恒定加速度模型)和交互模型(如社交力场模型)。

- 现代AI方法:

- 基于深度学习的轨迹预测:使用循环神经网络、图神经网络来建模交通参与者之间的交互关系,预测多条可能的未来轨迹及其概率,LSTM (Long Short-Term Memory) 和 Transformer 模型被广泛用于处理时序数据,预测车辆和行人的行为。

-

B. 决策规划模块:决定车辆接下来要做什么(变道、超车、跟车、停车等)。

- 分层规划架构:

- 行为规划:高层决策,决定车辆的宏观行为,在“跟车”、“变道到左”、“准备转弯”等行为中选择,常用有限状态机或行为决策树。

- 运动规划:中层决策,生成具体的行驶轨迹,常用算法:

- A (A-Star) / RRT (快速随机树):经典的路径搜索算法,在静态或动态障碍物中寻找最优路径。

- 优化方法:将规划问题建模成一个优化问题(如最小化行驶时间、舒适度、安全性等),使用二次规划、凸优化等方法求解。Frenet坐标系下的轨迹优化非常流行。

- 端到端决策:尝试用一个深度神经网络直接从原始传感器输入映射到控制指令,这种方法跳过了中间的感知、预测、规划等模块,简化了流程,但可解释性和安全性挑战巨大,目前仍处于研究阶段。

- 分层规划架构:

车辆控制

这是将“大脑”的决策转化为“四肢”动作的环节,要求平稳、精准、快速。

- 核心任务:将规划模块生成的期望轨迹(包括路径和速度)转化为具体的转向角、油门开度和刹车压力。

- 核心AI算法:

- 模型预测控制:这是目前最主流的控制算法。

- 原理:在每个控制周期内,它会预测车辆在未来一小段时间内的状态,然后根据预测结果优化当前的控制指令,使得车辆的实际轨迹尽可能地跟踪期望轨迹,它能很好地处理系统的动态约束(如物理极限)和外部干扰。

- PID (Proportional-Integral-Derivative) 控制:经典的控制算法,简单可靠,常用于对速度的闭环控制。

- LQR (Linear Quadratic Regulator) / LQI (Linear Quadratic Integrator):基于线性系统理论的优化控制器,在特定工况下表现优异。

- 模型预测控制:这是目前最主流的控制算法。

挑战与未来趋势

- 长尾问题:AI模型在常见场景下表现很好,但在罕见、极端的“长尾场景”(如 unusual pedestrian behavior, complex construction zones)下容易失败。

- 可解释性与安全性:深度学习模型是“黑箱”,当系统出错时,很难追溯原因,如何让AI的决策过程透明、可验证,是安全落地的关键。

- 仿真与测试:如何在虚拟世界中安全、高效地测试和验证海量复杂的驾驶场景。

- 多模态大模型:类似ChatGPT的思路,将感知、预测、决策等模块统一到一个大的、可学习的模型中,利用海量数据进行端到端的训练,可能是未来的一个重要方向。

无人驾驶的AI算法是一个高度集成和复杂的系统,它深度依赖深度学习、强化学习、优化理论、机器人学等多种前沿技术,目标是让机器能够像经验丰富的人类驾驶员一样,安全、可靠地应对复杂的道路交通环境。