什么是“打标签”?

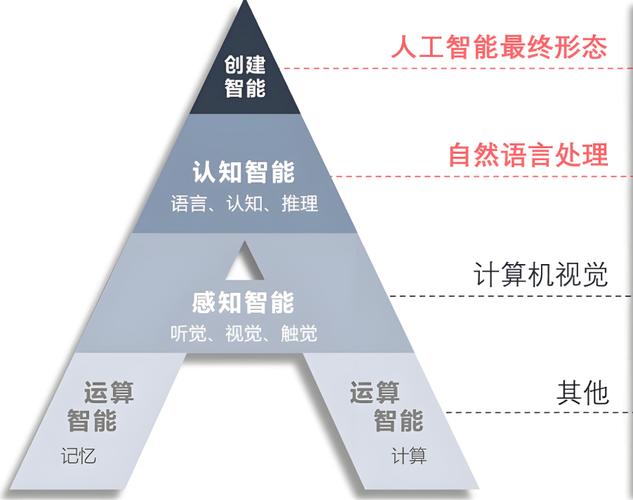

我们要理解“打标签”在AI领域是什么意思。

-

定义:打标签,也常被称为标注 或 标记,是指为原始数据(如文本、图片、音频、视频)附加有意义的信息(即“标签”)的过程,这个过程教会机器数据所代表的含义。

-

目的:打标签是监督学习 的基石,没有高质量的标签数据,就无法训练出能够进行预测或分类的监督学习模型。标签是机器的“答案册”。

-

例子:

- 图片分类:给一张猫的图片打上“猫”的标签。

- 情感分析:给一句话“这部电影太棒了!”打上“正面”的标签。

- 命名实体识别:在句子“苹果公司的CEO是库克”中,为“苹果公司”打上“ORG”(组织)标签,为“库克”打上“PER”(人名)标签。

- 目标检测:在一张街景图片中,框出所有的汽车、行人和交通灯,并分别打上相应的标签。

打标签算法的演进:从人工到智能

“打标签算法”本身也在不断演进,主要可以分为三个阶段:人工打标签、半自动打标签、全自动打标签。

纯人工打标签

这是最传统、最基础的方式。

- 方式:完全依赖人类标注员(如Amazon Mechanical Turk上的众包工作者)根据指定的规则,手动为数据打上标签。

- 优点:

- 质量高:人类能理解复杂的语境和模糊的含义,标签准确率高。

- 灵活性高:可以处理任何类型的数据和标签规则,无需考虑技术可行性。

- 缺点:

- 成本极高:需要支付大量人力成本。

- 速度慢:无法处理海量数据,成为数据瓶颈。

- 一致性差:不同标注员之间,甚至同一标注员在不同时间,标准可能不一致,导致“标签噪声”。

半自动打标签(人机协同)

这是目前工业界最主流的方式,结合了人类的智慧和机器的效率。

-

核心思想:先用一个预训练模型或弱监督模型对数据进行初步预测,然后由人类标注员进行校对、修正和确认。

-

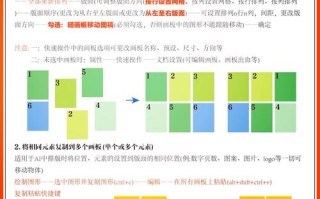

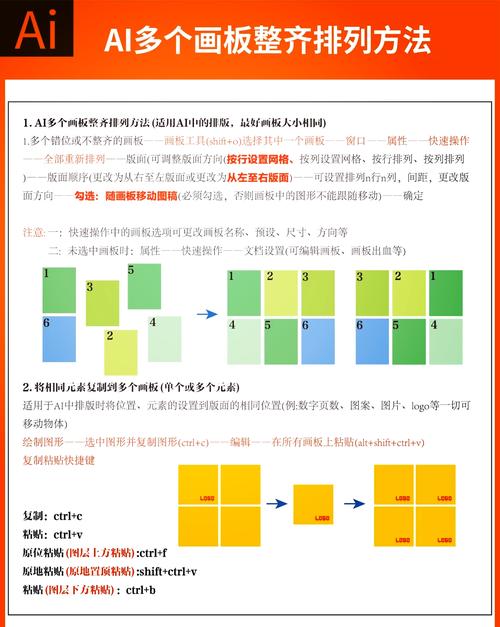

常见算法与技术:

(图片来源网络,侵删)

(图片来源网络,侵删)-

主动学习

- 原理:模型不是随机选择数据,而是主动选择那些“最不确定”或“对模型提升最大”的数据让人类标注,对于一个二分类问题,模型预测概率为50%的样本(即最“纠结”的样本)优先被送去标注。

- 优点:用最少的人工标注成本,达到最高的模型性能提升。

- 应用场景:标注数据成本极高,且模型可以快速迭代时。

-

预训练模型 + 人工校对

- 原理:使用一个在大型数据集上预训练好的强大模型(如BERT、GPT、ResNet)对全部或部分数据进行预测,人类标注员的工作不再是“从0到1”地创造标签,而是“从0.9到1”地确认和修正模型的预测结果。

- 优点:极大提高了标注效率,降低了成本和错误率。

- 应用场景:几乎所有NLP和CV领域的标注任务,用预训练的NER模型给文档打上初步的实体标签,人工再检查一遍。

-

启发式/规则 + 人工校对

- 原理:当没有预训练模型时,可以编写一些简单的规则或启发式算法来生成初步标签,在情感分析中,可以设定包含“好”、“棒”、“差”、“烂”等词的句子分别为正面或负面,然后由人工修正这些规则的错误。

- 优点:实现简单,成本低。

- 缺点:规则覆盖面窄,容易出错。

-

全自动打标签(零样本/少样本学习)

这是最前沿、最智能的方式,目标是让机器在没有或只有极少人工标签的情况下完成标注。

-

核心思想:利用模型强大的泛化能力,直接从任务描述或极少量示例中学会如何打标签。

-

常见算法与技术:

-

零样本学习

- 原理:模型从未见过的类别标签上进行预测,这通常依赖于“文本描述”或“类名嵌入”,模型虽然没见过“斑马”的图片,但知道“斑马是一种像马的、有黑白条纹的动物”,通过将这个文本描述与图片的特征进行比对,模型就能识别出斑马。

- 代表模型:CLIP (OpenAI),它可以将任何文本和图片映射到同一个向量空间,实现“看图说话”和“看文字识图”。

- 优点:彻底摆脱了对特定类别标注数据的依赖,扩展性极强。

- 缺点:性能可能略逊于有监督学习,且严重依赖于文本描述的质量。

-

少样本学习

- 原理:模型只需要看到每个类别的一两个(或几个)示例,就能学会识别该类别,它通过学习一个“度量”或“匹配”函数,来判断新样本与哪个类别的示例最相似。

- 代表模型:Siamese Networks, Prototypical Networks。

- 优点:能用极少的数据启动标注流程,非常适合冷启动场景。

- 缺点:对示例的质量和代表性要求很高。

-

主流打标签算法的具体分类与应用

从算法类型来看,打标签(作为监督学习任务)可以分为以下几大类:

分类

为数据分配一个或多个离散的类别标签。

- 多分类:每个样本只属于一个类别。

- 算法:逻辑回归、支持向量机、决策树、随机森林、神经网络(CNN, Transformer)。

- 应用:图片分类(猫/狗/鸟)、新闻主题分类(体育/财经/科技)。

- 多标签分类:每个样本可以同时属于多个类别。

- 算法:使用多个二元分类器(如One-vs-Rest),或使用专门的神经网络结构(如输出层用Sigmoid激活函数)。

- 应用:文章标签(一篇文章可以同时有“NLP”和“Python”标签)、电影类型(一部电影可以是“动作”和“科幻”)。

- 层次分类:类别之间存在层级关系。

- 算法:在训练时考虑类别间的层次关系,可以使用专门的损失函数或模型结构。

- 应用:生物分类学(动物 -> 脊椎动物 -> 哺乳动物 -> 灵长类)。

序列标注

为序列数据(如文本、语音)中的每个元素分配标签。

- 算法:条件随机场、循环神经网络、长短期记忆网络、Transformer (如BERT)。

- 应用:

- 命名实体识别:识别文本中的人名、地名、机构名等。

- 词性标注:为句子中的每个词标注其词性(名词、动词、形容词等)。

- 语音识别:将音频信号序列映射到文字序列。

目标检测与分割

在图像或视频数据中定位并识别出感兴趣的物体。

- 目标检测:用边界框框出物体,并给出类别标签。

- 算法:R-CNN系列、YOLO系列、SSD。

- 应用:自动驾驶中的车辆和行人检测、安防监控。

- 图像分割:对图像中的每个像素进行分类,实现更精细的分割。

- 语义分割:同一类别的所有像素被标记为同一个标签(如所有“汽车”像素都是“汽车”标签)。

- 实例分割:区分同一类别的不同实例(如区分图片中的A车和B车)。

- 算法:U-Net, Mask R-CNN。

- 应用:医疗影像分析(分割肿瘤区域)、自动驾驶(分割可行驶区域)。

挑战与最佳实践

- 数据质量是核心:“垃圾进,垃圾出”,不准确的标签会误导模型,导致性能下降,建立清晰的标注指南和进行标注员培训至关重要。

- 成本与效率的权衡:根据项目预算和时间,选择合适的标注策略(纯人工、半自动或全自动)。

- 一致性:建立质量控制机制,如交叉验证(让多个标注员标注同一数据,并解决分歧)。

- 偏见:标注数据可能包含人类社会的偏见(如性别、种族偏见),这会被模型学习并放大,需要在标注和模型训练阶段进行审查和缓解。

- 迭代标注:标注不是一次性的,可以先标注一部分数据训练一个“种子模型”,然后用这个模型去预测和筛选下一批需要标注的数据,形成一个迭代优化的闭环。

| 阶段 | 核心思想 | 常用技术/算法 | 优点 | 缺点 |

|---|---|---|---|---|

| 纯人工 | 人类完全手动标注 | 人工标注平台(如Labelbox, Scale AI) | 质量高,灵活 | 成本高,速度慢,一致性差 |

| 半自动 | 人机协同,机器辅助人类 | 主动学习、预训练模型+校对 | 效率高,成本低,质量好 | 仍需大量人工,依赖初始模型质量 |

| 全自动 | 机器自主学习 | 零样本学习、少样本学习 | 成本极低,扩展性强 | 性能可能受限,技术门槛高 |

“人工智能打标签算法”是一个动态发展的领域,其核心目标始终是:以更低的成本、更高的效率、更好的质量,为监督学习模型提供高质量的“答案册”,在实际应用中,通常会根据具体任务、数据量和预算,灵活组合使用上述各种方法。

标签: 人工智能标签算法优化技巧 高效AI打标签算法方法 机器学习标签算法优化策略