我们需要明确“人工智能合作组织”的定义,它并非指某一个特定的、广为人知的实体,而是一个概念性或类别性的描述,指的是那些由多个参与者(如科技公司、研究机构、政府、非营利组织等)共同组建,旨在推动人工智能技术发展、制定行业标准、进行联合研究或解决特定社会问题的组织。

这类组织的核心在于“合作”,但其处理的数据和开发的AI模型对隐私构成了前所未有的挑战,隐私保护是这类组织能否成功获得公众信任、实现其长远目标的关键。

AI合作组织面临的隐私挑战

当多个实体合作时,隐私风险会显著增加,主要体现在以下几个方面:

-

数据共享与融合的复杂性

- 问题:合作的核心往往是数据,不同组织拥有不同来源、不同格式、不同敏感度的数据,将这些数据集中或联合使用,可以训练出更强大的AI模型,但也意味着将分散的隐私风险汇聚到了一起。

- 风险:一旦共享的数据集中发生泄露,影响的范围和深度远超单一机构,一个医疗机构和一个金融公司合作开发健康风险评估AI,如果数据泄露,可能导致一个人的健康和财务信息同时暴露。

-

数据来源的合规性与伦理性

(图片来源网络,侵删)

(图片来源网络,侵删)- 问题:合作组织的数据可能来自全球各地,各国的数据隐私法律(如欧盟的GDPR、中国的《个人信息保护法》、美国的CCPA等)各不相同,如何确保所有参与方提供的数据都符合所有相关法律法规,是一个巨大的挑战。

- 风险:违反任何一国的法律都可能导致巨额罚款、法律诉讼和声誉损失,数据是否经过了“知情同意”(Informed Consent)也是一个核心伦理问题。

-

模型隐私与成员隐私

- 问题:在联合建模过程中(如联邦学习、安全多方计算),各方希望利用彼此的数据来提升模型性能,但又不想泄露自己的原始数据或商业秘密。

- 风险:

- 模型逆向攻击:攻击者可能通过分析合作组织发布的模型(或API接口),反向推导出训练数据中的敏感信息。

- 成员推断攻击:通过分析模型的行为或输出,判断某个特定数据集是否参与了模型的训练,从而泄露合作成员的身份或业务范围。

-

算法的透明度与可解释性

- 问题:AI合作组织开发的模型可能极其复杂,涉及多个参与方的贡献,当模型做出可能影响个人权益的决策时(如信贷审批、招聘筛选),如何解释其决策依据变得非常困难。

- 风险:缺乏透明度会加剧公众的“算法黑箱”焦虑,难以进行有效的监督和问责,个人无法知道自己的信息是如何被使用的,也无法对不公平的决策提出申诉。

-

数据生命周期管理

- 问题:合作项目有始有终,项目结束后,如何安全地处理、销毁或归还各方贡献的数据?谁来负责?标准是什么?

- 风险:数据被遗忘权被侵犯,或者在项目结束后被不当使用或泄露,会严重损害组织的公信力。

AI合作组织如何应对隐私挑战(隐私保护策略)

为了应对上述挑战,负责任的AI合作组织必须将隐私保护嵌入到其整个运作流程中,通常采用“隐私增强技术”(PETs)和健全的治理框架。

技术层面:采用隐私增强技术

- 联邦学习:各方在本地用自己的数据训练模型,只将模型参数(梯度)上传到中央服务器进行聚合,不共享原始数据,这是目前数据合作最主流的技术方案之一。

- 安全多方计算:允许多个参与方在不泄露各自私有输入数据的前提下,共同计算一个函数的结果,可以计算多方数据的平均值,而无需任何人看到具体数值。

- 差分隐私:在数据或查询结果中注入经过精确计算的“噪音”,使得攻击者无法判断某个特定个体是否在数据集中,它提供了一种可量化的隐私保护 guarantees。

- 同态加密:允许在加密数据上直接进行计算,得到的结果解密后与在原始数据上计算的结果相同,这可以实现对加密数据的“可用而不可见”。

- 数据脱敏与匿名化:在数据共享前,移除或泛化个人身份信息(PII),如姓名、身份证号、地址等,但需注意,重新识别攻击的风险始终存在,单纯的匿名化可能不够。

治理与管理层面:建立健全的隐私框架

- 制定明确的隐私政策和数据治理章程:

- 目的限制:明确规定数据只能用于特定的合作项目,不得挪作他用。

- 最小化原则:只收集和使用实现目标所必需的最少数据。

- 数据分类:根据敏感度对数据进行分类,实施不同级别的保护措施。

- 建立数据伦理审查委员会:在项目启动前,对数据使用的伦理影响、隐私风险进行独立评估和审查。

- 强化访问控制和权限管理:确保只有经过授权的人员才能访问特定数据,并记录所有访问日志。

- 保障用户权利:建立机制,确保数据主体(个人)能够行使其访问、更正、删除、撤回同意等权利。

- 第三方审计与认证:邀请独立的第三方机构对组织的隐私保护措施进行定期审计,并寻求国际通用的隐私认证(如ISO 27701),以增强公信力。

透明度与问责制

- 发布透明度报告:定期向公众和成员报告数据使用情况、隐私保护措施的有效性、以及任何安全事件。

- 明确责任主体:在合作组织中明确指定“数据保护官”(DPO)或类似角色,负责监督隐私政策的执行。

- 建立问责机制:当发生隐私泄露或算法歧视时,必须有清晰的责任认定和补救流程。

典型案例分析

-

Partnership on AI (PAI):这是一个由科技巨头(如Google, Microsoft, Facebook)、学术机构和非营利组织组成的AI合作组织,PAI非常重视伦理和治理,其工作小组中专门有“隐私与安保”小组,致力于研究AI系统中的隐私保护技术、制定最佳实践,并发布相关报告,推动整个行业在隐私保护方面的共识。

-

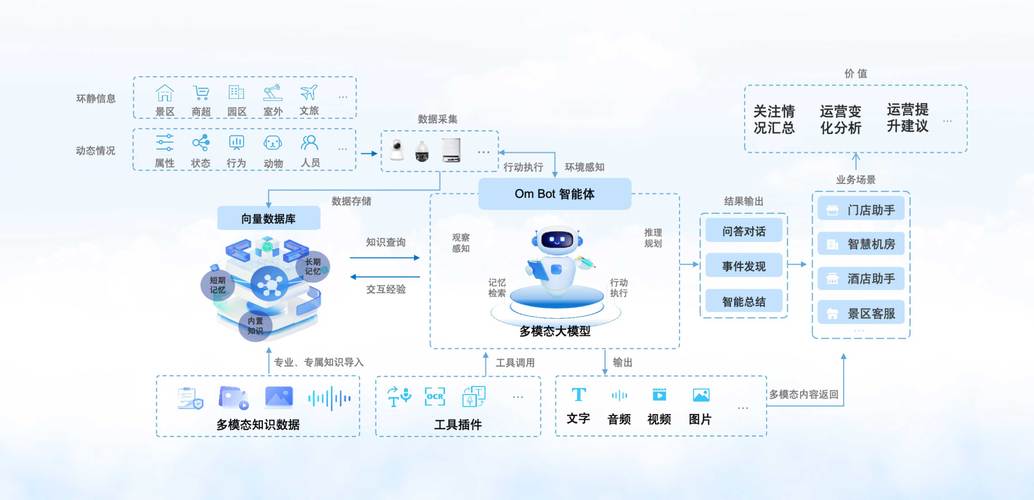

AI合作组织在医疗领域的应用:多家医院和研究机构合作开发疾病预测AI,他们通常采用联邦学习技术,医院A的数据不出本地,只与医院B分享模型更新,共同构建一个比任何单一医院都更准确的模型,同时完美保护了病人的隐私数据。

人工智能合作组织与隐私的关系是共生与博弈的,合作是AI发展的必然趋势,而隐私是合作得以持续和成功的基石。

一个成功的AI合作组织,必须超越简单的“数据堆砌”,将隐私保护设计(Privacy by Design)作为其核心原则,通过技术手段(如联邦学习、差分隐私)和治理框架(如明确的政策、伦理审查、透明度报告)双管齐下,才能在推动技术创新的同时,有效化解隐私风险,最终赢得公众的信任,实现其“科技向善”的最终目标,反之,忽视隐私的合作组织,无论其技术多么先进,都可能在信任危机面前寸步难行。

标签: 人工智能合作组织隐私保障机制 AI合作组织数据隐私保护措施 人工智能联盟隐私安全策略