- 什么是直接采样? (核心定义与思想)

- 为什么需要直接采样? (动机与应用场景)

- 直接采样的工作原理 (以简单例子说明)

- 一个经典的直接采样算法:拒绝采样

- 直接采样的优缺点

- 与其他采样方法的对比

什么是直接采样?

直接采样是一种从给定的概率分布中生成随机样本的方法,它的核心思想是:如果我们能找到一个“逆变换”函数,就可以从一个简单的、已知的分布(如均匀分布)中采样,然后通过这个函数变换,得到我们想要的复杂分布的样本。

这个“逆变换”函数,就是累积分布函数 的逆函数。

为了理解这一点,我们需要回顾两个概率论中的基本概念:

- 概率密度函数: 描述了连续随机变量在不同取值上的“密度”或“可能性”,正态分布的PDF是一个钟形曲线。

- 累积分布函数: 描述了随机变量小于或等于某个特定值的概率,它是PDF从负无穷到该值的积分,CDF是一个单调不减的函数,值域在[0, 1]之间。

直接采样的核心步骤:

假设我们想从目标分布 p(x) 中采样。

-

计算CDF: 首先计算

p(x)的累积分布函数F(x)。F(x) = P(X ≤ x) = ∫(-∞ to x) p(t) dt -

求逆函数: 计算

F(x)的逆函数F⁻¹(u),这个函数将一个概率值u映射回对应的x值。 -

生成样本:

- 从一个标准的均匀分布

U(0, 1)中随机抽取一个值u,这个u代表一个随机概率。 - 将

u代入逆函数,计算x = F⁻¹(u)。 - 这样得到的

x就是从目标分布p(x)中采出的一个样本。

- 从一个标准的均匀分布

直观理解:

CDF F(x) 告诉我们,对于任何一个 x,它左边区域的面积(概率)是多少,它的逆函数 F⁻¹(u) 则反过来问:“如果我们想要面积为 u 的区域,这个区域的边界 x 在哪里?”,由于 u 是均匀采样的,x 的自然分布就会符合 p(x) 的密度。

为什么需要直接采样?

在机器学习和人工智能领域,我们经常需要处理复杂的概率模型,

- 贝叶斯推断: 需要从后验分布

P(θ|Data)中采样来估计模型参数 。 - 强化学习: 需要采样探索策略或评估动作价值。

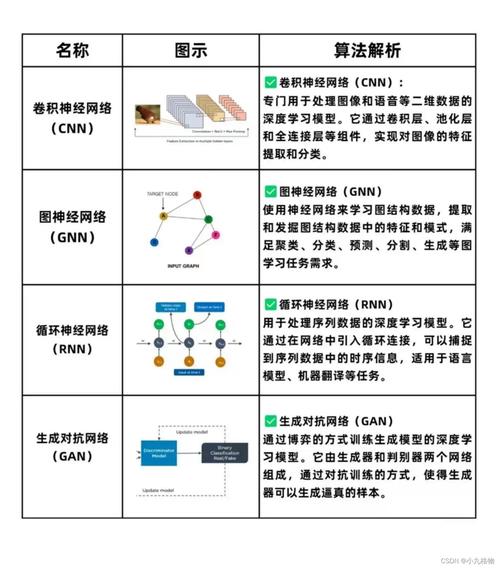

- 生成模型: 如GANs、VAEs,需要生成逼真的新数据样本。

- 蒙特卡洛方法: 用随机采样来估计复杂的积分或期望值。

这些模型的后验分布或目标分布往往非常复杂,没有简单的数学表达式,或者其CDF的逆函数无法解析地求解,直接采样提供了一种理论上非常优美和直接的解决方案,只要我们能找到CDF的逆函数,问题就迎刃而解。

直接采样的工作原理 (以指数分布为例)

假设我们想从指数分布 p(x) = λe^(-λx) (x ≥ 0) 中采样。

步骤1: 计算CDF F(x)

F(x) = ∫(0 to x) λe^(-λt) dt = [-e^(-λt)] (from 0 to x) = 1 - e^(-λx)

步骤2: 求逆函数 F⁻¹(u)

我们设 u = F(x) = 1 - e^(-λx),然后解出 x:

1 - u = e^(-λx)

ln(1 - u) = -λx

x = -ln(1 - u) / λ

因为 u 是 U(0, 1) 上的随机数,1 - u 也是 U(0, 1) 上的随机数,所以我们可以简化公式为:

x = -ln(u) / λ

步骤3: 生成样本

- 从均匀分布

U(0, 1)中生成一个随机数u。 - 计算

x = -ln(u) / λ。 x就是我们从参数为 的指数分布中采出的一个样本。

这个例子完美展示了直接采样如何将一个简单的均匀分布随机数,通过一个精心设计的逆变换,变成符合目标分布的样本。

一个经典的直接采样算法:拒绝采样

上面的例子很完美,但现实是,对于很多复杂的分布,我们无法计算出CDF的解析表达式,更不用说它的逆函数了,这时,拒绝采样就派上了用场,它是一种基于直接采样思想的、更通用的算法。

目标:从任意复杂的、未归一化的目标分布 p(x) 中采样。

思想:用一个我们容易采样的提议分布 q(x) (例如正态分布) 来“覆盖” p(x),然后通过一个“接受-拒绝”机制,来确保最终接受的样本服从 p(x) 的分布。

算法步骤:

-

选择提议分布

q(x)和一个缩放因子M:q(x)必须容易采样(如正态分布、均匀分布)。M是一个常数,需要满足p(x) ≤ M * q(x)对所有x成立,这意味着M*q(x)的曲线必须完全在p(x)的上方。M越小,效率越高。

-

采样:

- 从提议分布

q(x)中采样一个点x*。 - 从均匀分布

U(0, 1)中采样一个值u。

- 从提议分布

-

接受或拒绝:

- 计算接受概率:

α = p(x*) / (M * q(x*))。 u ≤ α,则接受x*作为我们想要的样本。- 否则,拒绝

x*,并回到第2步重新采样。

- 计算接受概率:

直观理解:

想象一下 p(x) 和 M*q(x) 的曲线,我们在 M*q(x) 曲线下随机投点(这等价于先从 q(x) 采样 x*,再从 U(0, M*q(x*)) 采样 u),如果这个点落在 p(x) 曲线的下方,我们就接受它;否则就拒绝,因为投点是随机的,所以最终被接受的点的分布自然就符合 p(x)。

直接采样的优缺点

优点

- 概念简单直观:核心思想就是“逆变换”,易于理解和实现。

- 精确性高:只要能正确实现,生成的样本严格来自目标分布,没有偏差。

- 计算高效:在某些情况下(如指数分布、正态分布的Box-Muller变换),只需要几次数学运算就能生成一个样本,效率非常高。

缺点

- 适用性受限:这是最大的缺点。只有当目标分布的CDF逆函数可以解析求解时,才能使用直接采样,对于大多数复杂的、高维的分布(如贝叶斯后验),这是不可能的。

- 难以找到合适的提议分布 (针对拒绝采样):在拒绝采样中,找到一个既能很好地覆盖

p(x)又容易采样的q(x),并找到一个合适的M,可能非常困难且具有挑战性。 - 效率问题 (针对拒绝采样):

M*q(x)和p(x)的形状差异很大,大部分采样点都会被拒绝,导致算法效率低下,浪费大量计算资源。

与其他采样方法的对比

| 采样方法 | 核心思想 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| 直接采样 | 通过CDF的逆函数变换均匀分布 | 精确、高效、概念简单 | 适用性极窄,仅限少数简单分布 | 指数分布、均匀分布、正态分布(Box-Muller)等有解析解的分布。 |

| 拒绝采样 | 用一个简单分布 q(x) 来“覆盖” p(x),通过接受-拒绝机制 |

适用性比直接采样广,无需归一化 p(x) |

效率依赖 q(x) 和 M 的选择,可能很低 |

当 p(x) 形状不太复杂,且能找到好的 q(x) 时。 |

| 马尔可夫链蒙特卡洛 | 构建一个马尔可夫链,使其平稳分布为目标分布 p(x) |

适用性最广,几乎可以处理任何复杂的、高维的分布 | 产生样本之间有自相关性,需要“burn-in”期,收敛性难以判断 | 贝叶斯推断、复杂概率模型,是现代AI中最常用的采样方法,代表算法:Metropolis-Hastings, Gibbs Sampling。 |

| 重要性采样 | 用一个容易采样的分布 q(x) 来估计关于 p(x) 的期望 |

不需要从 p(x) 直接采样,可用于估计 |

估计方差可能很大,结果有偏(除非用于期望估计) | 用于蒙特卡洛积分和期望值估计,而不是直接生成样本。 |

直接采样是概率采样方法中的“理想”方案,它简单、精确、高效,但它的适用范围非常有限,像一把“手术刀”,只能处理少数有解析解的经典分布。

在现实世界中,我们面对的AI问题(如复杂的贝叶斯网络、深度生成模型)所涉及的分布通常是高维、复杂且没有解析形式的,我们更常使用马尔可夫链蒙特卡洛 这类更通用、更强大的“重型武器”。

拒绝采样则是一个很好的“折中方案”,它扩展了直接采样的思想,使其能处理一些更复杂的分布,但仍然无法与MCMC的普适性相比。

理解直接采样至关重要,因为它不仅是许多其他采样算法的理论基础,也为我们提供了理解采样问题的第一性原理,在解决实际问题时,我们通常会先尝试看能否用直接采样,如果不行,再考虑拒绝采样,最后才求助于MCMC等更复杂的方法。

标签: 人工智能直接采样算法优化技巧 高效实现直接采样算法方法 AI直接采样算法快速实现策略