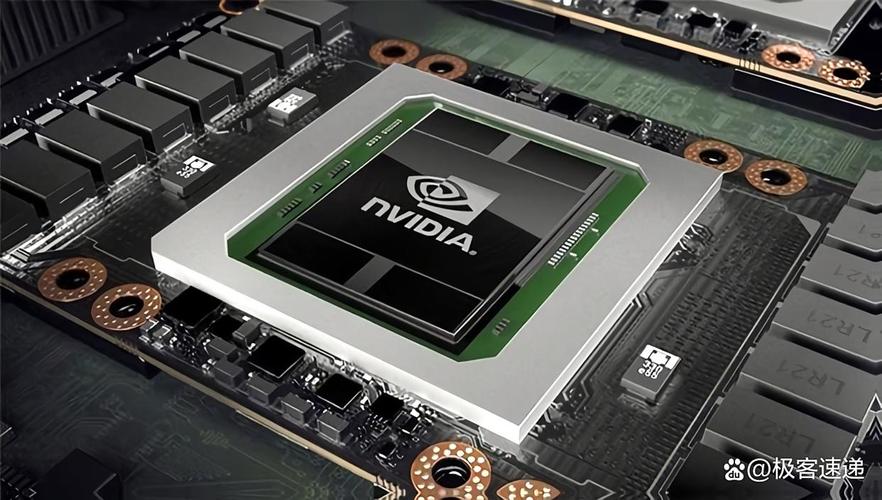

英伟达GPU是现代人工智能革命的“发动机”和“炼丹炉”

如果说数据是AI的“燃料”,算法是AI的“蓝图”,那么英伟达的GPU就是驱动这一切高效运转的“发动机”和进行模型训练的“炼丹炉”,没有GPU的强大并行计算能力,我们今天所熟知的深度学习、大语言模型、AIGC(生成式人工智能)等都将是纸上谈兵。

为什么是GPU?—— CPU vs. GPU 的根本区别

要理解英伟达的成功,首先要明白为什么GPU天生适合AI任务。

- CPU (中央处理器):设计目标是低延迟和通用性,它有几个到几十个强大的核心,擅长处理串行任务,比如操作系统、游戏逻辑、办公软件等,它像一位全能的瑞士军刀,什么都能做,但单项任务不够快。

- GPU (图形处理器):设计目标是高吞吐量和大规模并行计算,它拥有成千上万个相对简单的小核心,就像一支庞大的军队,可以同时执行成千上万个简单的计算任务,这完美契合了AI,特别是深度学习的需求。

AI计算的“炼丹”过程: 深度学习的核心是神经网络的训练,这个过程可以分解为亿亿次重复的数学运算:

- 矩阵乘法:这是深度学习的基石,将一个包含百万个参数的模型矩阵,与一个包含百万个数据点的输入矩阵相乘。

- 并行性:这些矩阵中的每一个元素的计算都是独立的,互不干扰,这正是GPU大规模并行计算能力施展拳脚的绝佳场景。

一个形象的比喻:

- CPU 像一位经验丰富的外科医生,处理复杂、精细、需要串行操作的任务。

- GPU 像一支庞大的建筑工地工人队伍,每个人(核心)都在重复着简单的砌砖、浇筑任务(并行计算),共同在短时间内建造起一座摩天大楼(训练模型)。

英伟达的“护城河”:不仅仅是硬件

英伟达的成功,绝不仅仅是因为它卖出了最多的GPU,它构建了一个强大到难以逾越的生态系统,这个生态系统包含了硬件、软件、库、工具和平台。

硬件:从游戏卡到AI超级计算机

- GeForce系列 (消费级):最初为游戏而生,但其强大的并行计算能力被早期的研究者发掘,用于AI实验,这为英伟达积累了最初的用户和开发者社区。

- Tesla系列 (数据中心/专业级):这是英伟达在AI领域的王牌,它们是专为数据中心设计的GPU,拥有更大的显存、更高的计算精度、更快的互联技术(如NVLink)和更好的稳定性。

- 里程碑产品:A100 和 H100 GPU,H100被誉为“全球第一款加速计算GPU”,为训练像GPT-3这样的大语言模型而生,其性能和架构专门为Transformer等AI模型进行了优化。

- Grace Hopper超级芯片:这是英伟达的“杀手锏”,它将一个CPU(Grace)和一个GPU(Hopper)通过超高速的片间互联技术集成在一个封装内,解决了CPU和GPU之间数据传输的瓶颈,为未来的AI超级计算机提供了蓝图。

软件与库:让硬件发挥最大威力的“灵魂”

如果说硬件是身体,那么软件就是灵魂,英伟达的CUDA(Compute Unified Device Architecture)是其生态系统的基石。

- CUDA (并行计算平台和编程模型):这是英伟达最核心的资产,CUDA不是一个简单的驱动,而是一个完整的生态系统,包括:

- CUDA核心库:如 cuBLAS (基础线性代数)、cuDNN (深度神经网络库) 等,这些库对GPU上的核心AI计算(如卷积、矩阵乘法)进行了极致优化,开发者调用几行代码就能实现普通代码需要几天甚至几周才能完成的计算量。

- CUDA编程语言:基于C/C++,让开发者可以轻松地为GPU编写并行程序。

- CUDA工具包:提供编译器、调试器、性能分析器等全套开发工具。

CUDA就是英伟达为GPU打造的“操作系统”和“开发工具链”,它将GPU的强大能力以标准化的方式交付给开发者。

软件栈:从模型开发到部署的全套解决方案

英伟达提供了一整套软件,覆盖了AI工作的每一个环节,形成了“AI工厂”的流水线。

- 上层框架:与PyTorch、TensorFlow等主流深度学习框架深度集成,开发者无需关心底层硬件细节,即可享受GPU加速。

- NVIDIA AI Enterprise:一套企业级的AI软件套件,包含用于数据科学、模型训练和推理的优化软件,提供企业级支持和安全保障。

- RAPIDS:一个开源的软件库,将GPU加速的数据科学和机器学习工具(如cuDF, cuML)带到Python生态中,让数据科学家可以在GPU上无缝进行数据处理和模型训练,速度比CPU快几个数量级。

- NVIDIA NeMo:用于对话式AI的框架,简化了大语言模型的训练、微调和部署。

- NVIDIA Triton Inference Server:一个高性能的推理服务器,可以高效地部署训练好的AI模型到生产环境中。

平台与生态系统:构建AI的“朋友圈”

- NVIDIA DGX SuperPOD:这是英伟达的“AI超级计算机”解决方案,它将成百上千块H100 GPU通过高速网络连接起来,形成一个统一的计算集群,像OpenAI、Meta、Google等公司都使用DGX系统来训练他们的顶级模型。

- Omniverse (元宇宙平台):这是一个用于3D协作和模拟的开放式平台,其核心是物理模拟和AI,完全由NVIDIA的技术驱动,旨在构建数字孪生和下一代元宇宙应用。

- 开发者社区与合作伙伴:英伟达通过GTC(GPU技术大会)、在线课程、认证等方式,培养了一个庞大的开发者社区,它与全球的云服务商(AWS, Azure, Google Cloud, 阿里云等)、服务器制造商、软件公司建立了紧密的合作关系,确保其技术无处不在。

实际应用案例:GPU如何驱动AI浪潮

- 大语言模型 (LLM):像GPT-4、Llama 2、Claude这样的模型,其训练过程需要处理数万亿个单词的文本,没有成千上万个H100 GPU组成的集群进行数月的并行计算,训练这些模型是不可想象的。

- 生成式AI (AIGC):Stable Diffusion、Midjourney、DALL-E 2等图像生成模型,每一次生成图片都需要进行数百万次扩散模型的迭代计算,GPU的并行能力让实时生成成为可能。

- 自动驾驶:特斯拉的自动驾驶系统、Waymo的无人车,其核心是“神经网络大脑”,这个大脑需要实时处理来自多个摄像头、雷达的海量传感器数据,进行环境感知、路径规划和决策,GPU提供了进行如此复杂计算所需的算力。

- 科学计算:在天气预报、新药研发、基因测序、流体力学模拟等领域,AI正在加速科学发现,GPU可以极大地缩短模拟和计算时间,AlphaFold 2利用GPU预测蛋白质结构,取得了革命性突破。

挑战与未来

尽管英伟达在AI领域占据绝对主导地位,但也面临着挑战:

- 竞争加剧:AMD的MI系列GPU、英特尔(通过收购)的Gaudi系列正在努力追赶,像Google的TPU(张量处理单元)、亚马逊的Trainium/Inferentia等自研AI芯片也在云服务领域占据一席之地。

- 成本与能耗:训练顶级AI模型的成本高达数千万甚至上亿美元,并且消耗巨大的电力,这促使业界开始探索更高效的芯片架构(如Chiplet设计)和算法(如模型量化、稀疏化)。

- 技术瓶颈:虽然GPU算力在飞速增长,但数据传输(内存带宽、CPU-GPU通信)和编程模型的复杂性仍然是瓶颈,这也是英伟达推出Grace Hopper等产品的原因。

未来趋势:

- 从“训练”到“推理”:随着更多模型的部署,AI推理(即应用已训练好的模型)的算力需求将超过训练,英伟达也在大力发展针对推理优化的硬件和软件。

- 端侧AI (Edge AI):将AI模型部署在手机、汽车、机器人等终端设备上,这对芯片的能效比提出了更高要求,英伟达的Jetson系列平台就是为此而生。

- 量子计算与异构计算:未来的计算可能是GPU、CPU、专用AI芯片(NPU)、甚至量子计算单元协同工作的异构计算架构,英伟达也在积极布局,通过收购Mellanox等公司,构建其“数据中心全栈”的愿景。

英伟达与人工智能的关系是共生共荣的,英伟达凭借其革命性的GPU硬件架构、以CUDA为核心的软件生态以及全栈式的平台解决方案,为AI的爆发提供了不可或缺的算力基石,反过来,AI的巨大成功也驱动了对英伟达产品的海量需求,使其从一个游戏显卡公司,一跃成为全球最具价值的科技公司之一,定义了整个AI时代的技术范式,可以说,我们今天所享受的几乎所有AI成果,背后都有着英伟达GPU的强大身影。

标签: 英伟达GPU驱动AI突破的核心技术 英伟达GPU如何加速人工智能发展 英伟达GPU对人工智能突破的关键作用