核心概念:为什么选择 Jetson 无人机?

传统的无人机(如基于 Pixhawk 的无人机)主要负责飞行控制(姿态稳定、航点跟踪等),而 Jetson 无人机则在此基础上,增加了一个“大脑”,使其具备人工智能能力。

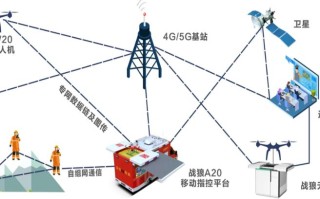

(图片来源网络,侵删)

- 传统无人机 (飞控大脑):负责“如何飞”,通过传感器(IMU、GPS等)维持稳定,执行遥控指令或预设航线。

- Jetson 无人机 (AI大脑):负责“看什么、想什么、做什么”,通过摄像头等传感器,进行实时图像识别、目标检测、路径规划,并向飞控发送高级指令。

典型应用场景:

- 自主航拍与目标跟踪:无人机自动识别并跟踪特定人物或物体(如人脸、车辆)。

- 智能巡检:检查电力线路、风力发电机、桥梁等,自动识别设备缺陷(如绝缘子破损、螺栓松动)。

- 农业监测:低空飞行,通过多光谱或高光谱相机分析作物健康状况,精准施药。

- 搜索与救援:在灾区自动识别幸存者或求救信号。

- 3D建模与测绘:自动规划航线,对指定区域进行拍照,生成高精度的三维模型。

硬件选型:搭建你的 Jetson 无人机平台

一个完整的 Jetson 无人机系统主要由以下几个部分组成:

飞控

飞控是无人机的“小脑”,负责实时控制电机和螺旋桨,保证飞行稳定。

- 首选:NVIDIA Flight Stack (PX4 + NVIDIA onboard SDK)

- PX4:是目前最主流的开源飞控固件,功能强大,社区支持好。

- NVIDIA onboard SDK:这是连接 Jetson 和 PX4 的关键,它允许 Jetson 作为“协处理器”,通过 MAVLink 协议与 PX4 通信,Jetson 可以将 AI 视觉计算的结果(如目标的位置和速度)作为“外部定位”信息发送给 PX4,PX4 则利用这些信息进行更高级的飞行控制(如自动跟踪)。

- 兼容性:确保你的飞控支持 PX4 固件,并留有 UART 或 USB 接口与 Jetson 通信。

计算单元:Jetson 模块选择

根据你的性能、功耗和预算需求,选择合适的 Jetson 模块:

- 入门级:Jetson Nano

- 优点:价格便宜,功耗低(约5-10W),社区资源丰富,非常适合学习和验证 AI 算法。

- 缺点:性能有限,只能处理简单的 AI 任务(如人脸识别、YOLOv4-tiny)。

- 适用场景:学习、原型验证、简单的目标跟踪。

- 主流级:Jetson Xavier NX / AGX Xavier

- 优点:性能强大(特别是 AGX Xavier),功耗适中(约10-30W),能够运行复杂的深度学习模型(如 YOLOv5/v7, Faster R-CNN),实现实时目标检测和分割。

- 缺点:价格较高,对电源和散热要求更高。

- 适用场景:复杂的视觉任务、多传感器融合、SLAM(即时定位与地图构建)。

- 旗舰级:Jetson Orin Nano / AGX Orin

- 优点:目前最顶级的性能,功耗比(性能/瓦)极高,可以运行最新的、更大的 AI 模型,支持多路高分辨率视频输入。

- 缺点:价格昂贵,是面向专业和商业应用的。

- 适用场景:高精度工业检测、实时 3D 物体追踪、复杂的自主导航。

机架与动力系统

- 机架:选择一个尺寸合适的四旋翼、六旋翼或八旋翼机架,要考虑能容纳 Jetson 模块、飞控、电池等所有组件。

- 电机和电调:根据无人机的总重量选择合适的无刷电机和电调。

- 螺旋桨:与电机匹配的螺旋桨。

- 电池:高倍率(C数)的锂聚合物电池或智能电池,确保能提供足够的电流并满足飞行时间需求。

传感器

- 视觉传感器:

- 摄像头:CSI/MIPI 接口的摄像头(如 Raspberry Pi Camera V2)是首选,因为它能直接与 Jetson 的 MIPI CSI-2 接口连接,延迟低,性能好,也可以使用 USB 摄像头,但延迟和带宽可能受限。

- 立体相机 / 深度相机:如 Intel RealSense,可用于深度感知、避障和 3D 建模。

- 其他传感器:

- GPS模块:提供位置信息,用于航点飞行。

- 光流传感器:在无GPS环境下(如室内)提供精确的悬停和位置信息。

- 激光雷达:用于高精度的 3D 建图和避障,但成本较高。

电源管理与通信

- 电源模块:需要一个可靠的电源分配板,将电池电压转换为 5V 和 12V 等,为飞控、Jetson 和传感器供电。非常重要:为 Jetson 单独提供一个稳定的 5V 电源输入。

- 图传系统:如 Holybro/HobbyWing 的 ELRS 或 TBS Tramp 系统用于遥控接收和遥测数据下行。

- 遥控器和地面站:用于手动控制和监控无人机状态。

软件开发环境搭建

系统与工具

- 操作系统:NVIDIA 提供专门为 Jetson 优化的 JetPack,它基于 Ubuntu,包含了 CUDA、cuDNN、TensorRT 等深度学习加速库。

- 安装方式:使用 NVIDIA 提供的 SDK Manager 可以方便地为 Jetson 模块刷入 JetPack。

- 核心开发库:

- CUDA:并行计算平台和模型。

- cuDNN:用于深度神经网络的 GPU 加速库。

- TensorRT:NVIDIA 的推理优化引擎,能将训练好的模型(如 TensorFlow, PyTorch)优化到极致,实现低延迟、高吞吐量的推理。

- VPI (Vision Programming Interface):NVIDIA 提供的跨平台视觉加速库,可以方便地利用 GPU 加速传统计算机视觉算法。

飞行控制软件栈

- PX4 Autopilot:在飞控上运行的固件,负责飞行控制逻辑。

- NVIDIA Onboard SDK:这是连接 Jetson 和 PX4 的桥梁。

- 工作流程:

- Jetson 通过摄像头捕获视频流。

- Jetson 上的 AI 应用(Python/C++)对视频进行实时推理,检测到目标后,计算出目标在图像中的像素坐标。

- Onboard SDK 将这个像素坐标转换成地理坐标(经纬度)或相对于无人机的相对位置。

- SDK 通过 MAVLink 协议将这个“外部定位”信息发送给 PX4。

- PX4 的控制器(如

offboard模式下的vision_position_estimate)接收到这个信息,调整无人机的位置,使其始终保持在目标上方。

- 工作流程:

AI 应用开发

这是 Jetson 无人机的核心,通常使用 Python 进行快速原型开发。

- 深度学习框架:

- PyTorch:学术界和工业界的主流,灵活易用。

- TensorFlow/Keras:生态系统完善,部署工具链成熟。

- 预训练模型:

- 目标检测:YOLO 系列 (v5, v7, v8)、SSD、Faster R-CNN,YOLO 因其速度和精度的平衡,是无人机应用的绝佳选择。

- 图像分割:DeepLabv3+、U-Net,可用于精确识别物体轮廓。

- 其他:人脸识别、姿态估计等。

- 开发流程:

- 模型训练/选择:根据任务选择或训练一个合适的模型。

- 模型转换与优化:使用 TensorRT 将模型从 PyTorch/TensorFlow 格式转换为

.engine文件,进行量化、层融合等优化,以达到最佳推理性能。 - 推理应用编写:编写一个 Python 脚本,使用 OpenCV 或 GStreamer 读取摄像头视频流,加载优化后的 TensorRT 模型进行推理,并将结果通过 Onboard SDK 发送给 PX4。

项目实战:一个简单的目标跟踪无人机

这是一个经典的入门项目,让 Jetson 无人机自动识别并跟踪一个特定颜色的物体(如一个红色的球)。

步骤 1:硬件组装

将 Jetson、飞控、摄像头、电池等安装在机架上,并连接好所有线缆(特别注意电源线和 MAVLink 通信线)。

步骤 2:软件环境配置

- 为 Jetson 刷入 JetPack。

- 安装 PX4 并烧录到飞控中。

- 按照 NVIDIA Onboard SDK 官方文档 进行配置,确保 Jetson 和 PX4 之间的 MAVLink 通信正常。

步骤 3:编写目标跟踪脚本 (Python + OpenCV)

这是一个简化的脚本逻辑:

import cv2

import time

import numpy as np

from onboard_sdk import OnboardSDK

# 1. 初始化

sdk = OnboardSDK() # 连接到 PX4

cap = cv2.VideoCapture(0) # 打开摄像头 (0通常是CSI摄像头)

# 2. 目标颜色定义 (HSV颜色空间)

lower_red = np.array([0, 50, 50])

upper_red = np.array([10, 255, 255])

# 3. 主循环

while True:

ret, frame = cap.read()

if not ret:

break

# 4. 图像处理

hsv = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

mask = cv2.inRange(hsv, lower_red, upper_red)

contours, _ = cv2.findContours(mask, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

# 5. 目标检测与定位

if contours:

# 找到最大的轮廓(假设是目标)

largest_contour = max(contours, key=cv2.contourArea)

x, y, w, h = cv2.boundingRect(largest_contour)

# 在图像上画框

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2)

# 计算目标在图像中心的位置

center_x = x + w / 2

center_y = y + h / 2

img_center_x = frame.shape[1] / 2

img_center_y = frame.shape[0] / 2

# 6. 发送控制指令 (简化版,实际应使用OnboardSDK)

# 计算偏移量,并转换为PX4能理解的位置偏移

# 这部分需要更复杂的坐标转换逻辑

print(f"Target found at: ({center_x}, {center_y})")

# sdk.send_position_offset(...)

# 显示结果

cv2.imshow('Drone Vision', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 7. 清理

cap.release()

cv2.destroyAllWindows()

sdk.stop()

步骤 4:飞行测试

- 安全第一:在室内或开阔无人的地方进行首次测试。

- 手动模式:先确保手动遥控正常。

- 辅助模式:尝试进入 PX4 的

offboard模式,让无人机接受外部指令。 - 启动脚本:运行你的目标跟踪脚本,观察无人机是否尝试跟随目标。

挑战与进阶方向

-

挑战:

- 功耗与散热:Jetson 在高负载下发热严重,需要设计良好的散热方案(如散热片、风扇),否则会降频甚至关机。

- 实时性:AI 推理必须在几十毫秒内完成,否则会影响控制效果,优化模型和代码至关重要。

- 系统稳定性:一个复杂的系统(Linux + PX4 + AI 应用)可能出现各种未知问题,需要仔细调试。

- 坐标转换:从图像像素坐标到地理坐标的转换(即“PnP”问题)需要相机标定和复杂的数学计算。

-

进阶方向:

- 多传感器融合:结合视觉、IMU、GPS、激光雷达的数据,实现更鲁棒的定位和导航。

- SLAM (即时定位与地图构建):让无人机在未知环境中自主飞行并绘制地图。

- 强化学习:用强化学习训练无人机的复杂行为,如敏捷飞行、群体协作等。

- 部署 Docker 容器:使用 NVIDIA NIM (Inference Microservice) 将 AI 模型打包成容器,方便部署和管理。

学习资源

- NVIDIA 官方资源:

- PX4 官方资源:

- 社区与论坛:

- NVIDIA Jetson 论坛

- PX4 论坛

- GitHub:搜索 "Jetson Drone"、"PX4 Onboard" 等关键词,能找到大量开源项目。

希望这份详细的指南能帮助你顺利开启 Jetson 无人机的开发之旅!这是一个充满挑战和乐趣的领域,祝你成功!

标签: Jetson无人机开发入门教程 Jetson无人机开发学习路径 Jetson无人机开发新手指南

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。