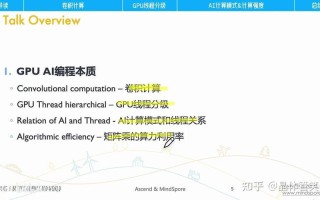

核心思想:为什么GPU是AI的“心脏”?

要理解GPU在AI中的作用,首先要明白AI(特别是深度学习)的本质是什么。

AI的核心是“计算”,尤其是大规模的并行计算。

- 传统计算 vs. 并行计算:

- 传统CPU(中央处理器):像一个“博士”,它非常聪明,擅长处理复杂的逻辑判断、串行任务和少量数据的快速计算,它有少数几个强大的“核心”(比如8个、16个),每个核心都很强,但数量有限。

- GPU(图形处理器):像一个“庞大的施工队”,它不那么聪明,但数量极其庞大(成千上万个“核心”),非常适合同时处理大量简单、重复的任务。

AI模型(尤其是神经网络)的工作方式,恰好完美匹配GPU的特点。

一个神经网络由大量的神经元和连接组成,当它进行计算时,会把输入数据(一张图片、一句话)分解成无数个非常小的、简单的数学运算(主要是乘法和加法),这些小运算之间没有复杂的逻辑依赖关系,可以同时进行。

这就好比:

- CPU:一个博士,一张一张地看图片,对每张图片进行复杂的分析和判断。

- GPU:一个施工队,把一张图片分成几万个小块,同时让几万个人去计算每个小块的颜色、亮度等信息,最后再汇总起来。

显然,对于处理海量数据(如百万张图片)的AI训练任务,GPU这种“人海战术”的效率远远高于CPU的“专家战术”。

GPU在AI中的具体应用场景

GPU几乎贯穿了人工智能,特别是深度学习的整个生命周期,主要分为三个阶段:

训练 - GPU最核心的战场

什么是训练? 训练就是“教”AI模型学习的过程,模型会通过处理海量的标注数据(比如数百万张已标明是“猫”还是“狗”的图片),不断调整内部数以亿计的参数,直到它能准确地识别出新的、未见过的图片。

为什么GPU对训练至关重要?

- 巨大的计算量:一个现代的AI模型(如GPT-3)可能有数千亿甚至上万亿个参数,每一次训练迭代,都需要对这些参数进行一次完整的计算更新,这涉及天文数字级别的乘加运算。

- 并行计算能力:GPU的成千上万个核心可以同时处理模型中不同部分的数据,在处理一张图片时,GPU可以同时计算图片中不同区域的特征,而不是像CPU那样一个区域一个区域地处理,这种并行性极大地缩短了训练时间。

- 高内存带宽:训练模型需要在GPU的高速显存中加载庞大的数据集和模型参数,GPU拥有极高的内存带宽,能快速地为这些核心“喂”数据和“取”结果,避免核心“饥饿”等待。

一个简单的比喻: 训练一个AI模型就像解一道超复杂的数学题,里面有亿万个小问号,CPU是一个学生,他只能一步一步地解,而GPU是一整个教室的学生,老师可以把每个小问号分给一个学生,大家一起算,速度自然快了成千上万倍,没有GPU,训练一个复杂的AI模型可能需要几年甚至几十年;有了GPU,这个过程缩短到几天或几小时。

推理 - GPU让AI“思考”得更快

什么是推理? 推理就是训练好的AI模型在实际应用中提供服务的过程,你用手机拍照时,AI模型在后台识别照片中的物体;你使用语音助手时,AI模型在后台识别你的语音指令。

为什么GPU也用于推理? 虽然推理的计算量通常比训练小,但对速度要求极高,尤其是对于需要实时响应的应用(如自动驾驶、实时翻译、游戏AI)。

- 低延迟:GPU强大的并行计算能力可以确保AI模型在极短时间内完成一次推理,提供流畅的用户体验。

- 高吞吐量:对于同时处理大量请求的服务器(如云服务),GPU可以并行处理成千上万个用户的推理请求,大大提高了服务器的承载能力。

对于一些对功耗和成本极其敏感的场景(如手机、嵌入式设备),人们也会使用专门的NPU(神经网络处理器)或TPU(张量处理单元),但这些专用芯片的设计理念也源于GPU的并行计算思想。

数据预处理 - GPU的“前奏工作”

在正式训练或推理之前,原始数据往往需要清洗、转换和增强。

- 将图片缩放到统一尺寸。

- 进行颜色归一化。

- 随机旋转、裁剪图片以增加数据多样性。

这些操作同样涉及对大量数据的并行处理,GPU也能在这里发挥作用,加速整个AI流水线的效率。

GPU如何具体执行AI计算的?—— 硬件与软件的结合

硬件层面:Tensor Core(张量核心)

这是现代NVIDIA GPU(如Volta, Turing, Ampere及之后架构)的革命性创新,传统的GPU核心擅长处理浮点数运算,而AI计算中大量使用的是矩阵乘法。

- 什么是矩阵乘法? 神经网络的核心计算就是大量的矩阵乘法,将一个1000维的输入向量,通过一个1000x1000的权重矩阵,转换成另一个1000维的输出向量。

- Tensor Core的作用:它是一种专门为矩阵乘法和累加运算设计的硬件单元,它可以在单个时钟周期内完成一次大规模的矩阵运算,这相当于给GPU的“施工队”配备了“超级工具”,让他们干得更快。

软件层面:CUDA与深度学习框架

光有强大的硬件还不够,还需要软件来“驾驭”它。

- CUDA(Compute Unified Device Architecture):这是NVIDIA推出的并行计算平台和编程模型,它允许开发者使用C/C++等语言来编写代码,直接调用GPU的成千上万个核心进行计算,可以说,CUDA是连接上层AI应用和底层GPU硬件的“桥梁”。

- 深度学习框架:像 TensorFlow, PyTorch 这样的框架,底层都封装了对CUDA的支持,开发者不需要直接写CUDA代码,只需要用框架定义好神经网络模型和数据,框架就会自动将计算任务高效地分配给GPU执行。

主流GPU厂商

-

NVIDIA (英伟达):绝对的领导者。

- 硬件:其GeForce(消费级)、RTX(游戏/创作者)、Data Center(数据中心,如A100, H100)系列GPU是AI训练和推理的事实标准。

- 软件生态:CUDA平台拥有最完善、最成熟的软件生态系统,几乎所有主流AI框架都对其有最佳支持,这也是其统治力的关键。

-

AMD:主要竞争者。

- 硬件:其Radeon Instinct系列GPU在性能上很有竞争力,价格有时更具优势。

- 软件生态:使用ROCm平台,虽然近年来发展迅速,但生态和兼容性仍与CUDA有一定差距。

-

Google (TPU):AI专用芯片。

- 硬件:TPU(Tensor Processing Unit)是Google为其AI工作负载设计的ASIC(专用集成电路),不用于通用计算,在特定AI任务(如矩阵运算)上能效比极高。

- 定位:主要用于Google内部的云服务和AI研究,不对外销售硬件。

-

Cloud (云厂商):AWS, Google Cloud, Azure等。

它们不仅提供NVIDIA和AMD的GPU实例,还自研AI芯片(如AWS的Trainium/Inferentia, Google的TPU),以降低成本并优化自己的云服务。

| 特性 | CPU (中央处理器) | GPU (图形处理器) |

|---|---|---|

| 设计理念 | 低延迟、强逻辑处理 | 高吞吐、大规模并行 |

| 核心数量 | 少而精 (几到几十个) | 多而简单 (几千到几万个) |

| 擅长任务 | 操作系统、串行任务、复杂逻辑判断 | 图形渲染、科学计算、AI/深度学习 |

| 在AI中的角色 | 数据预处理、系统调度、小规模模型推理 | AI模型训练、大规模模型推理 |

GPU凭借其大规模并行计算架构和专为AI优化的硬件(如Tensor Core),成为了驱动现代人工智能革命的核心引擎,它将原本需要数年才能完成的模型训练缩短到几天,使得过去只存在于科幻中的AI应用(如ChatGPT、DALL-E)成为现实,可以说,没有GPU,就没有今天我们看到的AI繁荣。

标签: GPU加速AI训练 GPU人工智能计算优势 GPU深度学习应用