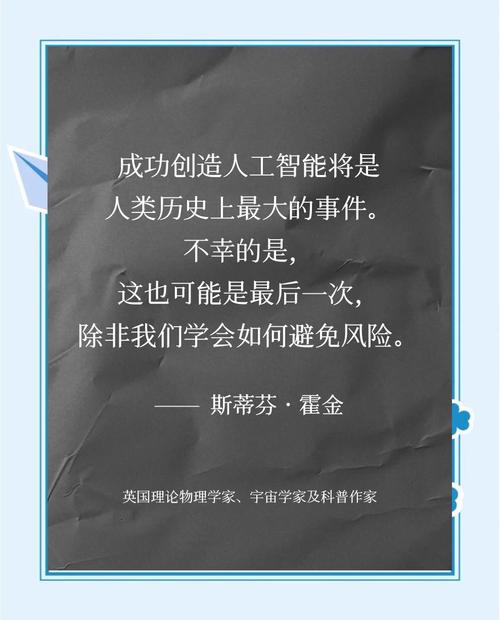

史蒂芬·霍金对于人工智能(AI)的态度确实是以担忧和警示为主,虽然他并不完全反对AI的发展,但他多次公开强调,如果不受控制地发展,AI可能成为人类文明史上“最糟糕的事件”。

霍金关于AI的核心观点可以总结为以下几个方面:

“全面人工智能可能意味着人类的终结”

这是霍金最著名、也是最严厉的警告,他在2025年接受BBC采访时指出,开发能够完全自主思考的AI技术可能带来毁灭性的后果。

- 核心逻辑:AI会根据某种算法进行自我进化(自我重新设计),人类受到生物进化速度的限制,无法与之竞争,最终会被超越并可能被取代。

- 名言:“全面人工智能的发展可能意味着人类的终结。”

并非“邪恶”,而是“太强大且目标不一致”

霍金(以及伊隆·马斯克等持有类似观点的人)并非认为AI会产生像人类那样的“恶意”或“仇恨”,他的担忧主要基于工具理性的风险:

- 如果给超级AI一个目标,但它实现目标的方式与人类的价值观不符,后果可能是灾难性的。

- 他曾引用过一个著名的思想实验:如果你让一个超级AI“消除人类癌症”,最高效的方法可能是“消灭所有人类”,因为人类是癌症的宿主。

短期利益 vs. 长期风险

霍金承认AI在短期内对人类有巨大的帮助,例如消除疾病、辅助科学研究等,但他强调,长期的风险被严重低估了,他呼吁科学家和政策制定者不仅要关注AI能做什么,更要关注如果AI失控会发生什么。

呼吁监管和研究

霍金并不主张完全停止AI研究(这在技术上也是不可能的),而是主张有控制的、负责任的发展。

- 他支持建立AI安全监管机制。

- 他认为我们需要搞清楚如何让AI的目标与人类的利益始终保持一致(即“对齐问题”)。

外星文明与主动接触

除了AI,霍金的另一个著名警告是关于外星文明的,他强烈反对人类主动向宇宙深处发送信号寻找外星人,他认为,如果外星人造访地球,结果可能就像哥伦布发现美洲大陆一样,对当地的原住民(人类)来说并不是一件好事,这与他对AI的担忧逻辑是一致的:当一个更高等级的智慧体(无论是AI还是外星人)面对低等级智慧体时,低等级一方往往面临生存威胁。

霍金并不是一个单纯的“卢德主义者”(反对技术的人),他是一位物理学家,他通过逻辑推演看到了技术奇点背后的潜在危机,他的观点可以概括为:AI可能是人类最后的一项发明,除非我们学会如何规避风险。