这三者结合在一起,可以说是当前科技领域最重要、最具革命性的力量。

(图片来源网络,侵删)

- 英伟达 是提供“发动机”和“燃料”的公司。

- 显卡 是这台“发动机”的核心硬件。

- 人工智能 是这台“发动机”正在驱动的、改变世界的“应用”。

下面我们从几个层面来深入解析。

英伟达:从游戏显卡巨头到AI算力霸主

英伟达成立于1993年,最初以图形处理器起家,其GeForce系列显卡曾是无数游戏玩家的挚爱,公司创始人黄仁勋极具前瞻性地洞察到GPU的并行计算潜力,并成功地将公司的战略重心转向了人工智能领域。

核心战略转变:GPU + CUDA + 软件

英伟达的成功并非仅仅因为硬件本身,而在于其构建了一个强大且难以被复制的生态系统:

-

GPU - 硬件基础

(图片来源网络,侵删)

(图片来源网络,侵删)- 架构优势:与CPU(中央处理器)擅长处理串行任务不同,GPU拥有成千上万个小型计算核心,特别适合执行大规模的并行计算,而训练和运行AI模型(尤其是深度学习)本质上就是一个巨大的并行数学运算过程,GPU的架构天生就为此而生。

- 产品线:针对AI市场,英伟达推出了专门的数据中心级GPU,如A100、H100、H200以及最新的B200(“Blackwell”架构),这些显卡拥有海量的显存、强大的计算能力和高速的互联技术,专门为处理AI大模型而设计。

-

CUDA - 技术灵魂

- 是什么:CUDA(Compute Unified Device Architecture)是英伟达推出的并行计算平台和编程模型,它是一个“翻译器”和“工具包”,允许开发者使用C/C++等语言来编写程序,让GPU能够执行通用计算任务,而不仅仅是图形渲染。

- 为什么重要:在CUDA出现之前,用GPU进行通用计算非常困难,CUDA的出现极大地降低了AI开发的门槛,使得全球绝大多数AI研究者和开发者都选择在英伟达的平台上进行工作,它构建了一个强大的护城河,使得竞争对手很难吸引到成熟的开发者生态。

-

软件与生态系统 - 生态闭环

- 深度学习框架:英伟达的软件栈(如CUDA Toolkit、cuDNN、TensorRT)与主流的AI框架(如TensorFlow、PyTorch)深度集成,可以极大地提升AI模型的训练和推理速度。

- 库与工具:提供针对各种AI任务(如计算机视觉、自然语言处理)的优化库,让开发者能“站在巨人的肩膀上”。

- CUDA-X AI:这是一个包含了从AI训练、推理到数据分析、科学计算等一系列软件的集合,进一步巩固了其生态优势。

英伟达卖的早已不只是一块硬件,而是一个包含顶尖GPU硬件、CUDA编程平台和全套软件工具的AI计算解决方案,这个“三位一体”的模式,使其在AI浪潮中占据了绝对的领导地位。

显卡:AI时代的“新石油”开采机

在AI时代,显卡的角色发生了根本性的变化。

(图片来源网络,侵删)

从“游戏卡”到“AI加速卡”

- 过去(游戏用途):显卡的核心是渲染管线,负责将3D模型实时绘制成2D图像,追求的是高帧率和高画质。

- AI用途):显卡的核心是计算核心,负责执行海量的矩阵乘法和浮点运算,追求的是算力(以TFLOPS为单位)和显存大小。

为什么显卡对AI如此关键?

- 算力需求爆炸:以OpenAI的GPT-4模型为例,其参数量超过万亿,训练这样的模型需要进行数百万亿次的计算,这需要持续数周甚至数月的时间,消耗巨大的计算资源,没有强大的GPU算力,训练这些模型是不可想象的。

- 显存至关重要:AI模型在训练时需要将整个模型(或部分模型)加载到显存中,显存的大小直接决定了模型能训练多大、能使用多大的批次大小,从而影响训练速度和最终效果,这也是为什么H100拥有80GB甚至GB200拥有144GB超大显存的原因。

- 并行计算的天堂:AI的神经网络计算可以被看作是成千上万个简单的数学运算同时进行,GPU的上万个核心正好可以完美匹配这种工作负载,实现远超CPU的并行计算效率。

显卡的关键指标(针对AI)

- CUDA核心数量:越多越好,代表并行处理能力越强。

- 显存大小与带宽:越大、越快越好,决定了能处理多大的模型和数据。

- Tensor Cores(张量核心):这是英伟达为AI矩阵运算专门设计的硬件单元,能提供数十倍于传统浮点核心的AI计算性能。

- 功耗与散热:数据中心级GPU功耗极高(可达700W甚至上千瓦),需要强大的散热和供电系统。

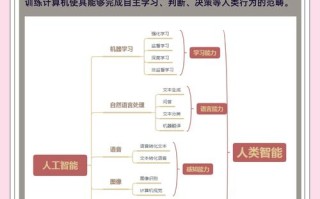

人工智能:驱动显卡需求狂潮的“超级应用”

人工智能,特别是生成式AI(Generative AI)的崛起,是引爆显卡需求的直接原因。

- 大语言模型:如ChatGPT,需要海量GPU进行训练和推理。

- 文生图模型:如Midjourney, Stable Diffusion,每一张图片的生成都需要GPU进行复杂的计算。

- 科学计算:在药物研发、气候模拟、材料科学等领域,AI加速了传统上需要超级计算机才能完成的计算任务。

- 自动驾驶:汽车需要强大的车载GPU来实时处理传感器数据,做出驾驶决策。

结果:所有这些应用都极度依赖英伟达的GPU,导致其显卡供不应求,价格飙升,成为全球科技巨头和初创公司争相抢夺的战略资源。

总结与未来展望

| 关系方 | 角色 | 核心贡献 |

|---|---|---|

| 英伟达 | 平台与生态构建者 | 提供以GPU硬件为基础,以CUDA为核心,以软件栈为工具的完整AI计算解决方案。 |

| 显卡 | 算力核心引擎 | 提供AI模型训练和推理所需的大规模并行计算能力和大容量显存。 |

| 人工智能 | 革命性应用 | 创造了对海量算力的爆炸性需求,是驱动显卡技术迭代和市场规模扩张的根本动力。 |

未来展望:

- 竞争加剧:AMD、Intel等竞争对手正在努力追赶,同时像Google(TPU)、亚马逊(Trainium/Inferentia)等科技巨头也在自研AI芯片,以降低对英伟达的依赖。

- 技术演进:英伟达将继续推出更强大的架构(如Blackwell、后续的“Rubin”),专注于提高能效比、互联速度和专用计算能力(如针对推理的优化)。

- 应用深化:AI将渗透到更多行业,从软件到硬件(机器人、自动驾驶、AI PC),对算力的需求只会越来越大,形式也会更加多样化。

英伟达、显卡和人工智能形成了一个完美的正向循环:AI的发展需求,推动了显卡技术的进步;而英伟达在显卡上的绝对优势,又加速了AI技术的创新和应用落地。 这三者共同定义了我们正在进入的智能时代。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。