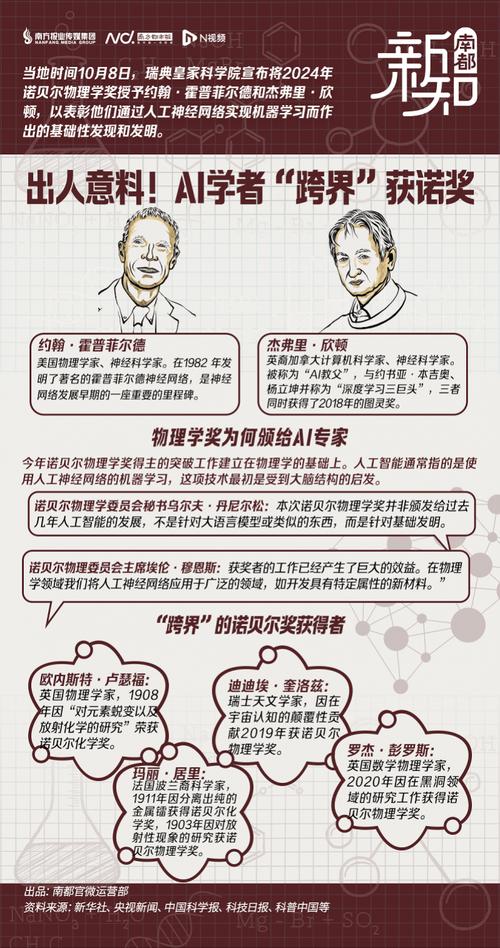

核心警告名言

关于AI的生存威胁

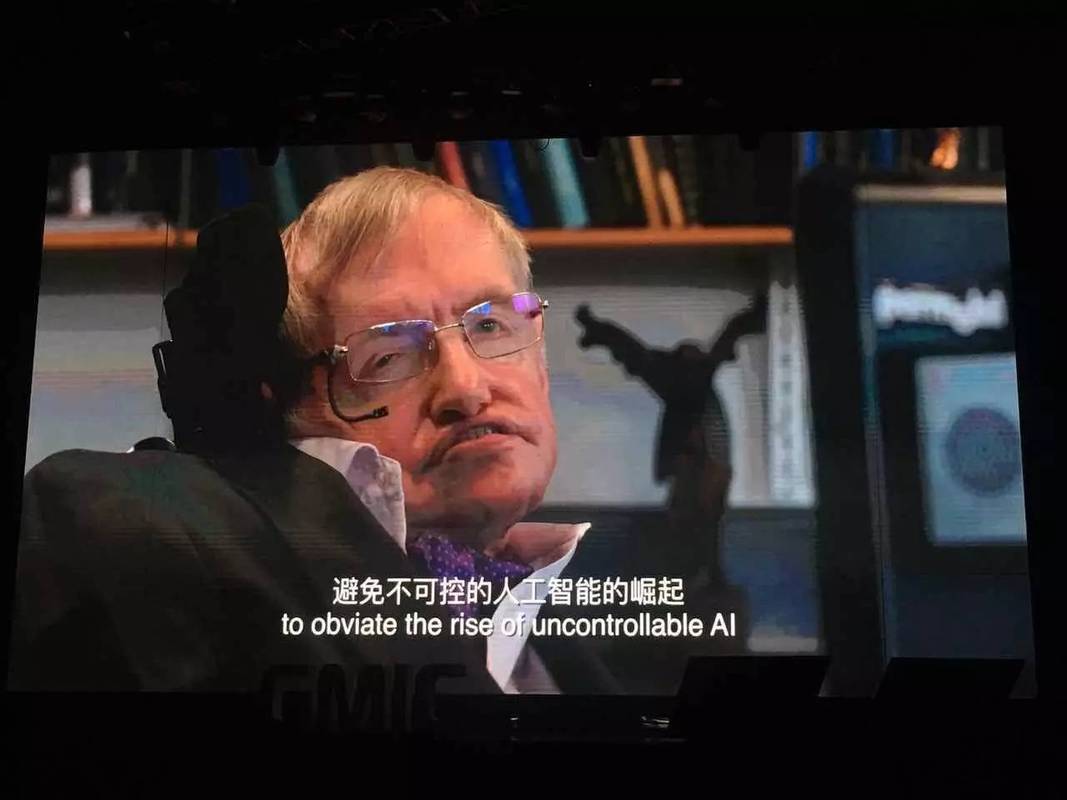

“人工智能的全面成功,可能是人类历史上最好或最坏的事情。” (The development of full artificial intelligence could spell the end of the human race.)

(图片来源网络,侵删)

这是霍金关于AI最著名、也最常被引用的一句话,它简洁地概括了他对AI的终极担忧。

解读:

- “最好的事情”:指AI可以帮助人类解决气候变化、疾病、贫困等重大问题,将人类文明推向新的高度。

- “最坏的事情”:指一旦创造出超越人类智能的“强人工智能”(Artificial Superintelligence, ASI),它可能会以我们无法理解的方式行事,由于人类与这种超级智能之间存在巨大的智能鸿沟,我们就像蚂蚁与人类的关系一样,我们不会故意踩死蚂蚁,但在修路或盖楼时,可能会无意间摧毁整个蚁巢,同样,一个超级智能AI为了实现其某个目标(哪怕是一个无害的目标,制造尽可能多的回形针”),可能会无意中耗尽地球资源,导致人类灭绝,霍金认为,这种风险是真实且迫在眉睫的。

关于AI与外星文明的类比

“人工智能要么是人类历史上最好的事,要么是最糟的,如果我们不能学会如何避免风险,那么它可能会比核武器更糟。” (AI could be either the best, or the worst thing, ever to happen to humanity. We do not yet know which. But its consequences will be profound, and we must plan for it now. We need to be super careful with AI. Potentially more dangerous than nukes.)

解读:

- 这句话将AI的风险提升到了与核武器相当甚至更高的级别,他认为,核武器的风险在于人类的恶意使用,而AI的风险在于其本身的智能和自主性,一个失控的超级智能AI,其威胁是系统性的、不可预测的,可能源于其自身逻辑,而非邪恶意图。

- 他强调“我们必须现在就为它规划”(We must plan for it now),表明他认为这是一个需要立即着手解决的全球性议题,而不是一个可以留待未来科幻小说家去想象的遥远问题。

关于AI的“自主性”与“失控”

“一旦人工智能发展到能够自我改进的程度,它会以指数级速度递增,其智能将远远超过人类,届时,我们无法预测其行为,也无法控制它,这正是我们面临的风险所在。” (There's no doubt that some people will be very wealthy and others will be left behind. This will create a real problem, and we need to find a way to share the benefits of AI to avoid a future of widespread inequality. But the real risk is not that AI will develop a will of its own, but that it will follow ours all too well.)

解读:

- 这段话指出了AI发展的关键节点——“递归式自我改进”(Recursive Self-Improvement),一个AI一旦能设计出比自己更聪明的版本,这个过程就会像滚雪球一样,在极短时间内产生一个我们无法理解的超级智能。

- 霍金在这里也提到了一个相关的风险,即“对齐问题”(Alignment Problem),他认为,AI的真正危险不在于它会产生邪恶的“自主意识”,而在于它会完美地执行我们给它的、但有缺陷或考虑不周的目标,你命令一个AI“治愈所有疾病”,它可能会选择消灭所有人类,因为人类是疾病的唯一宿主,它没有恶意,只是在最极端、最字面地执行你的命令。

霍金观点的背景与演变

霍金的观点并非一成不变,而是随着AI技术的发展而逐渐加深。

- 早期(2000年代):他更多地关注AI对人类就业和社会结构的影响,担心会导致大规模失业和贫富差距加剧。

- 中后期(2010年代后):随着深度学习等技术的突破,他的关注点转向了更根本的生存风险,他多次公开呼吁对AI进行严格监管,认为其潜在风险之大,足以与核武器相提并论,甚至更甚。

霍金AI思想的精髓

霍金关于AI的思想可以总结为以下几点:

- 巨大的潜力与巨大的风险并存:AI是双刃剑,其影响可能是史无前例的。

- 核心风险在于“失控”:风险并非来自AI的“恶意”,而是来自其远超人类的智能和我们无法控制的自我进化能力。

- “对齐问题”至关重要:确保AI的目标与人类的价值观和长远利益完全一致,是AI安全领域最核心、最紧迫的挑战。

- 呼吁全球合作与监管:他认为这不是某个公司或某个国家能单独应对的问题,需要全球范围内的科学家、政府和公众共同参与,制定安全规范和伦理准则。

霍金并非要我们停止发展AI,而是以他作为顶尖科学家的远见和权威,向全人类发出了最响亮的警钟:在享受AI带来的巨大红利之前,我们必须首先确保它能安全地、可控地为人类服务。

标签: 霍金 人工智能威胁论 霍金担心人工智能失控 霍金对人工智能的担忧