核心概念解析

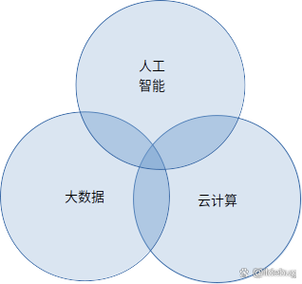

我们明确一下这三个概念在这个组合中的定位:

-

Java (编程语言):基础工具和粘合剂。

- 优势:成熟、稳定、跨平台、拥有庞大的企业级生态系统(尤其是Spring框架),在大型、高并发、要求稳定性的企业级应用中,Java是首选。

- 角色:它不仅仅是用来写算法,更重要的是用来构建整个人工智能/大数据挖掘应用的“骨架”,包括API服务、业务逻辑、数据处理流水线、任务调度等。

-

大数据挖掘:应用领域和目标。

- 目标:从海量、高增长、多类型的数据中,通过算法探索和分析,发现其中有价值的模式、知识和信息。

- 核心:它包含了从数据采集、存储、清洗、处理、分析到结果可视化的全过程,它关注的是如何“处理”和“分析”数据。

-

人工智能:核心技术引擎。

- 目标:让机器模拟人类的智能行为,如学习、推理、决策、创造等。

- 核心:在这个组合中,AI主要指机器学习和深度学习,它提供了算法模型(如分类、聚类、回归、神经网络等),这些模型是“挖掘”出知识的关键工具。

一句话总结它们的关系:

Java 作为强大的编程语言,构建了稳定、可扩展的大数据挖掘平台;在这个平台上,我们利用人工智能(机器学习/深度学习)算法模型,对海量数据进行训练和分析,最终挖掘出有价值的商业洞察。

Java 在这个组合中的具体作用

Java 不仅仅是用来调用算法库,它在整个数据价值链中扮演着多重角色:

大数据处理层

- 数据流处理:

- Flink:目前最主流的流处理框架,有专门的Java/Scala API,用于实时数据采集、清洗、转换和分析,例如实时用户行为分析、金融风控预警等。

- Spark Streaming:Spark生态系统的一部分,也是Java编写的重要应用,用于准实时处理。

- 批处理:

- Hadoop MapReduce:虽然现在Spark更流行,但Hadoop生态(HDFS, YARN)依然是许多大数据平台的基石,MapReduce作业通常用Java编写。

- Spark Core:Spark的批处理引擎,同样提供强大的Java API,用于处理大规模数据集。

人工智能/机器学习层

-

主流算法库:

- Deeplearning4j (DL4J):Java生态中最成熟的深度学习框架,对标Python的TensorFlow和PyTorch,它支持各种神经网络模型,可以运行在Hadoop和Spark之上,非常适合大数据场景下的深度学习。

- Weka:一个经典的、用于数据挖掘和机器学习的Java库,它提供了大量的算法实现(分类、回归、聚类等),界面友好,非常适合学术研究和快速原型验证。

- Apache Mahout:一个专注于可扩展机器学习的库,提供了许多可分布式运行的机器学习算法。

- Tribuo:由Oracle Labs开发,是一个现代化的机器学习库,设计上借鉴了Python的scikit-learn,易于使用且与Java生态系统无缝集成。

-

模型集成与部署:

(图片来源网络,侵删)

(图片来源网络,侵删)- 模型服务化:使用 Spring Boot 框架,可以将训练好的AI模型(无论是DL4J的模型还是其他模型)封装成一个RESTful API,其他业务系统(如Web应用、移动App)就可以通过HTTP请求调用这个AI服务,实现模型预测。

- 模型训练流水线:使用 Spring Batch 或自定义的Java程序,可以构建自动化的模型训练、评估和重新部署的流水线,当有新数据时,系统可以自动触发模型重新训练,保证模型的时效性。

应用与业务层

- 构建完整的数据应用:一个数据挖掘项目最终要落地成一个应用,一个用户画像系统,后台用Java(Spring Boot)提供API,前端调用API展示用户标签;一个推荐系统,Java服务接收用户ID,调用推荐算法模型,返回推荐结果。

- 企业级集成:Java可以轻松地与公司的其他系统(如ERP、CRM、数据库)进行集成,将AI能力无缝融入到现有业务流程中。

一个典型的项目工作流程

假设我们要做一个“电商用户流失预警”项目,流程如下:

-

数据采集与存储:

- 使用 Flink (Java API) 实时采集用户的行为日志(点击、浏览、购买等)存入 Kafka。

- 历史订单、用户信息等结构化数据存入 Hive (基于HDFS) 或 MySQL。

-

数据清洗与特征工程:

- 编写一个 Spark (Java API) 批处理作业,从Hive/MySQL中读取数据,进行数据清洗(处理缺失值、异常值)。

- 进行特征工程:计算用户最近7天的活跃度、平均购买金额、最后一次购买时间等,生成用于模型训练的特征向量,这个复杂的逻辑非常适合用Java来编写。

-

模型训练:

- 使用 Deeplearning4j (Java) 或 Weka (Java) 库,基于处理好的训练数据,训练一个分类模型(如逻辑回归、随机森林、神经网络),目标是预测用户是否会流失。

-

模型评估与部署:

- 在测试数据集上评估模型性能(准确率、召回率等)。

- 将训练好的模型序列化保存。

- 使用 Spring Boot 创建一个Web服务,该服务加载模型,并提供一个

POST /predict-churn接口,接收用户ID,返回流失概率。

-

业务集成:

电商平台的营销系统调用这个Java服务,对高流失风险的用户自动发放优惠券,进行精准营销。

技术栈总结

| 层次 | 核心技术 | 说明 |

|---|---|---|

| 编程语言 | Java | 基础,贯穿始终。 |

| 大数据基础 | Hadoop (HDFS, YARN) | 分布式文件系统和资源管理的基础。 |

| Spark | 核心计算引擎,用于批处理和流处理。 | |

| Flink | 专业的流处理引擎,低延迟。 | |

| Kafka | 高性能的消息队列,用于数据管道。 | |

| Hive / MySQL | 数据存储(数据仓库/关系型数据库)。 | |

| AI/机器学习 | Deeplearning4j (DL4J) | Java生态的深度学习框架。 |

| Weka / Tribuo | 机器学习算法库,适合快速原型和传统算法。 | |

| Spring Boot | 构建AI模型API服务和业务应用的框架。 | |

| Spring Batch | 构建自动化数据处理和模型训练流水线。 | |

| 运维与部署 | Docker / Kubernetes | 容器化部署AI服务。 |

| Maven / Gradle | 项目构建和依赖管理。 |

学习路径建议

如果你希望掌握这个组合,可以按照以下路径学习:

-

第一阶段:Java基础与进阶

- 掌握Java核心语法、面向对象、集合、多线程、IO。

- 学习 Spring Boot 框架,理解如何构建RESTful API。

-

第二阶段:大数据技术基础

- 学习 Linux 基本操作。

- 了解 Hadoop 生态的基本概念(HDFS, MapReduce)。

- 重点学习 Spark Core,掌握其基本原理和Java API,能编写简单的批处理程序。

- 了解 Kafka 的基本概念和使用。

-

第三阶段:机器学习理论与实践

- 学习机器学习的基本理论:监督学习、无监督学习、分类、回归、聚类等。

- 学习 Weka 或 Tribuo,动手用Java实现一些经典算法(如线性回归、决策树)。

- 理解数据预处理和特征工程的重要性。

-

第四阶段:深度学习与高级应用

- 学习神经网络的基本原理。

- 深入学习 Deeplearning4j (DL4J),尝试构建和训练一个简单的神经网络模型(如图像分类、文本分类)。

- 学习如何将训练好的模型通过 Spring Boot 服务化。

-

第五阶段:项目实战与整合

- 寻找一个公开的数据集(如Kaggle上的数据)。

- 完

标签: Java AI大数据融合技术 Java大数据挖掘AI实现 Java AI与大数据整合方法