硬件、视觉和决策。

(图片来源网络,侵删)

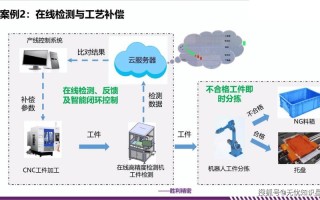

项目概述

一个 Flappy Bird 机器人通常的工作流程如下:

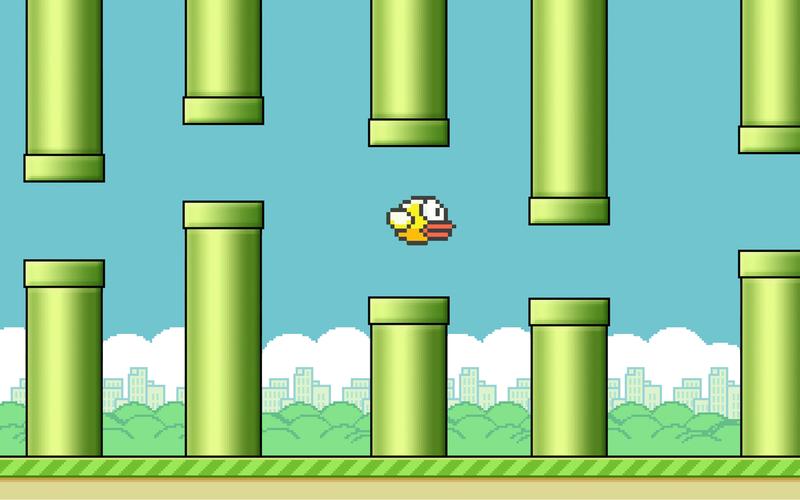

- 观察:通过摄像头捕捉电脑屏幕上 Flappy Bird 游戏的画面。

- 分析:图像处理算法从画面中识别出关键元素:小鸟的位置、管道的空隙位置(上沿和下沿)。

- 决策:一个 AI 模型(通常是强化学习模型)根据当前状态(小鸟与管道的相对位置、速度等)计算出最佳的“点击”动作。

- 执行:机器人程序模拟鼠标点击,让小鸟跳跃,避开管道。

核心技术栈

A. 硬件

- 电脑:任何可以运行游戏的电脑即可。

- 摄像头:用于捕捉屏幕,一个普通的 USB 摄像头就足够了。

- 机器人执行器:这是“点击”动作的物理执行者,主要有两种方案:

- 软件模拟(最简单):直接通过程序控制鼠标点击,这是最常见、最简单的方式,无需额外硬件。

- 物理机械臂(更硬核):使用 Arduino 或 Raspberry Pi 控制一个舵机或机械臂,去按压鼠标按键或触摸屏幕,这需要额外的电子知识和硬件搭建。

B. 软件

- 游戏:Flappy Bird(可以是网页版、PC版或模拟器)。

- 编程语言:Python 是这个领域的不二之选,因为它拥有丰富的库。

- 核心库:

- OpenCV:用于图像处理,如截屏、识别小鸟和管道的位置。

- PyAutoGUI 或 PyTesseract:用于模拟鼠标点击,PyAutoGUI 更常用。

- 深度学习框架:TensorFlow 或 PyTorch,用于构建和训练 AI 模型。

- 强化学习库:Stable Baselines3, Ray RLlib, 或 CleanRL,这些库封装了各种先进的强化学习算法,可以大大简化开发过程。

实现步骤详解

数据采集与预处理

-

屏幕捕获:使用 OpenCV 的

cv2.VideoCapture功能,将摄像头对准屏幕,持续捕获游戏画面。import cv2 cap = cv2.VideoCapture(0) # 0 代表默认摄像头 while True: ret, frame = cap.read() if not ret: break # 在这里处理 frame cv2.imshow('Screen Capture', frame) if cv2.waitKey(1) & 0xFF == ord('q'): break cap.release() cv2.destroyAllWindows() -

图像识别:这是最关键的一步,你需要从复杂的游戏中准确地提取出小鸟和管道的位置。

- 模板匹配:截取一个干净的小鸟图像和一个管道图像作为模板,然后在每一帧的游戏画面中用

cv2.matchTemplate去寻找它们,这种方法简单,但对游戏画面变化(如不同皮肤、分辨率)很敏感。 - 颜色/轮廓检测:分析游戏画面的颜色和形状,小鸟通常是一个圆形或方形的特定颜色,管道是长条形的特定颜色,通过设定颜色阈值(

cv2.inRange)和寻找轮廓(cv2.findContours)来定位它们,这种方法更鲁棒一些。 - 目标检测模型:如果你追求极致的准确性和鲁棒性,可以训练一个简单的 YOLO 或 SSD 模型来专门识别小鸟和管道,这是最专业的方法,但需要标注数据集。

输出:对于每一帧,你的程序应该能输出:

(图片来源网络,侵删)

(图片来源网络,侵删)- 小鸟的坐标

(bird_x, bird_y)。 - 下一对管道的空隙坐标

(pipe_top_y, pipe_bottom_y)和管道的 x 坐标。

- 模板匹配:截取一个干净的小鸟图像和一个管道图像作为模板,然后在每一帧的游戏画面中用

AI 模型(决策大脑)

这里我们使用强化学习,因为它最符合“试错学习”的本质。

-

定义环境:

- 状态:AI 观察到的信息。

[小鸟的 y 坐标, 小鸟的垂直速度, 下一管道的 x 坐标, 上管道的 y 坐标, 下管道的 y 坐标],这些状态信息都是从步骤一中获取的。 - 动作:AI 可以执行的操作,对于 Flappy Bird,只有两个动作:

0(不点击,保持下落)和1(点击,向上飞)。 - 奖励:评估动作好坏的信号。

- 成功通过一对管道:+10 分。

- 撞到管道或地面:-100 分(游戏结束)。

- 每存活一帧:+0.1 分(鼓励活下去)。

- 状态:AI 观察到的信息。

-

选择算法并训练:

- 经典算法:DQN (Deep Q-Network) 是入门强化学习的经典算法,它通过一个神经网络来学习在某个状态下,执行每个动作的“期望收益”(Q值)。

- 更先进的算法:PPO (Proximal Policy Optimization) 是目前最流行、最稳定的强化学习算法之一,非常适合这种任务。

使用 Stable Baselines3 训练 PPO 的伪代码示例:

(图片来源网络,侵删)

(图片来源网络,侵删)import gym from stable_baselines3 import PPO # 1. 创建一个自定义的 Gym 环境类,封装你的游戏逻辑 # class FlappyBirdEnv(gym.Env): # def __init__(self): # # 初始化状态、动作空间等 # pass # def step(self, action): # # 执行动作,获取新状态、奖励、是否结束 # pass # def reset(self): # # 重置游戏到初始状态 # pass # 2. 创建环境实例 # env = FlappyBirdEnv() # 3. 创建并训练 PPO 模型 # model = PPO("MlpPolicy", env, verbose=1) # model.learn(total_timesteps=100000) # 训练 10 万步 # 4. 保存模型 # model.save("flappy_bird_ppo")注意:直接在真实游戏上训练非常慢且不稳定,通常的做法是先在一个模拟器上训练,或者使用预训练模型。

执行与闭环

- 加载模型:训练完成后,加载你的模型。

- 实时循环:

- 捕获当前游戏帧。

- 识别出小鸟和管道的位置,构建状态向量。

- 将状态向量输入到加载的 AI 模型中。

- 模型会输出一个动作(0 或 1)。

- 如果动作是 1,就调用

pyautogui.click()来模拟鼠标点击。 - 等待一小段时间(如 50ms),然后重复以上步骤。

项目挑战与优化

- 延迟:从“看到”到“点击”的延迟是致命的,需要优化代码,尽量减少每一步的处理时间。

- 识别准确性:如果图像识别出错,AI 会得到错误的状态,导致做出错误的决策,提高识别的鲁棒性是关键。

- 模型泛化性:训练好的模型可能只对特定版本或分辨率的 Flappy Bird 有效,你需要确保你的识别和决策逻辑具有足够的泛化能力。

- 游戏速度:不同的游戏速度会影响 AI 的决策,可能需要根据帧率动态调整策略。

现成的项目和资源

如果你想快速体验,可以先看看别人已经做好的项目:

- GitHub 上的开源项目:搜索 "Flappy Bird Bot Python" 或 "Flappy Bird AI",可以找到很多完整的代码实现,这个项目就非常经典:lengstrom/fast-flappy-bird,它结合了 OpenCV 和深度学习,并提供了训练好的模型。

- YouTube 视频:搜索 "Flappy Bird AI" 或 "Flappy Bird Robot",有大量视频展示了项目的成果和实现过程,非常直观。

制作一个 Flappy Bird 机器人是一个绝佳的入门项目,它融合了计算机视觉、强化学习和机器人控制等多个热门领域。

- 对于初学者:建议从软件模拟开始,并使用现成的开源代码进行学习和修改,理解其工作流程。

标签: 机器人玩Flappy Bird算法 AI通关Flappy Bird技巧 机器人Flappy Bird训练方法

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。