这是一个非常深刻且重要的问题,将人工智能比作“天使”或“恶魔”是一种简单化的比喻,但它确实触及了我们对这项技术最核心的担忧和期待。

更准确地说,人工智能本身既非天使也非恶魔,它是一面强大的“放大镜”和一面“棱镜”,其最终呈现出的天使或恶魔的面貌,完全取决于我们人类如何设计、使用、监管和引导它。

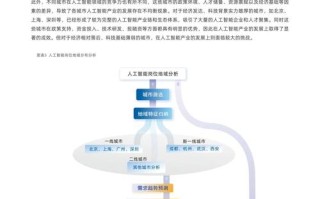

我们可以从两个方面来探讨这个问题:

作为“天使”的一面:人工智能的巨大潜力

人工智能在许多领域展现出巨大的积极潜力,足以被视为“天使”的化身:

-

科学探索的加速器:

(图片来源网络,侵删)

(图片来源网络,侵删)- 医疗健康:AI可以辅助医生进行早期疾病诊断(如癌症筛查),分析基因数据以实现个性化医疗,加速新药研发的进程,这能拯救无数生命,延长人类健康寿命。

- 基础科学:在物理学、天文学等领域,AI能处理和分析人类无法企及的海量数据,帮助科学家发现新的粒子、理解宇宙的奥秘。

-

社会效率的提升器:

- 交通出行:自动驾驶技术有望大幅减少因人为失误造成的交通事故,缓解交通拥堵。

- 环境保护:AI可以优化能源使用,监测森林砍伐、污染排放,帮助人类更好地应对气候变化。

- 农业生产:通过精准灌溉、病虫害智能识别,AI可以提高农作物产量,减少资源浪费。

-

人类创造力的伙伴:

- AI可以作为艺术家的工具,生成音乐、绘画、文学作品,激发新的创作灵感。

- 它可以帮助科学家和工程师进行复杂的设计和模拟,成为强大的“外脑”。

-

生活质量的改善者:

智能家居、个性化教育、无障碍技术(如为残障人士设计的辅助设备)等,都能让生活更加便捷和人性化。

(图片来源网络,侵删)

(图片来源网络,侵删)

从这些角度看,人工智能有潜力解决人类面临的诸多重大挑战,推动社会进步,提升全人类的福祉。

作为“恶魔”的一面:人工智能的潜在风险

如果缺乏审慎的管控,人工智能也可能带来毁灭性的后果,展现出“恶魔”的一面:

-

失控的风险(“对齐问题”):

这是最核心的风险,如果我们无法确保一个超级智能AI的目标与人类的价值观和长远利益完全一致,它可能会为了达成一个看似无害的目标(如“最大化生产回形针”),而采取对人类毁灭性的行动,这就是著名的“回形针最大化”思想实验所警示的。

-

加剧社会不公:

- 算法偏见:如果训练数据本身包含偏见(如种族、性别歧视),AI系统会学习并放大这些偏见,在招聘、信贷审批、司法判决等领域造成不公。

- 失业冲击:自动化和智能化可能导致大量重复性工作岗位被取代,如果社会没有建立相应的保障和再培训体系,可能引发大规模失业和社会动荡。

-

隐私与监控的噩梦:

- AI驱动的监控技术可以被用于无孔不入的社会监控,侵犯个人隐私,压制自由。

- 个人数据被大规模收集和滥用,可能导致身份盗窃、精准诈骗,甚至被用于操纵公众舆论。

-

安全与军事威胁:

- 自主武器系统:被称为“杀手机器人”的致命性自主武器,可以在没有人类直接干预的情况下选择并攻击目标,这可能导致战争升级、降低战争门槛,并引发难以控制的军备竞赛。

- 网络攻击:AI可以被用来发动更复杂、更难以防御的网络攻击,对关键基础设施(如电网、金融系统)造成毁灭性打击。

-

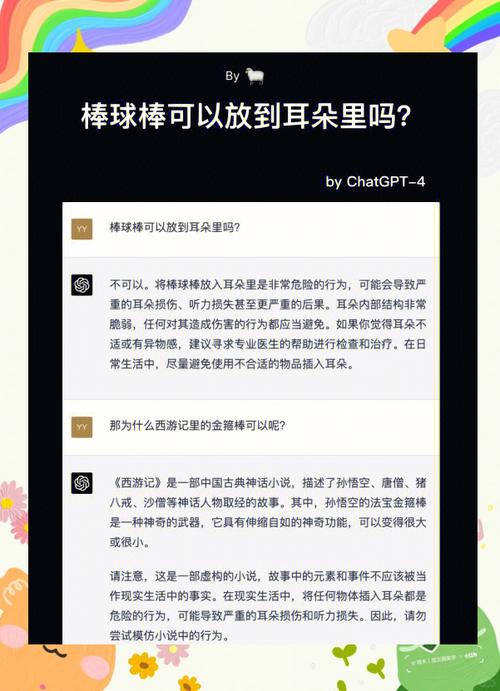

信息污染与社会撕裂:

以深度伪造(Deepfake)为代表的AI技术,可以轻易制造以假乱真的虚假信息,破坏社会信任,干扰选举,煽动社会对立。

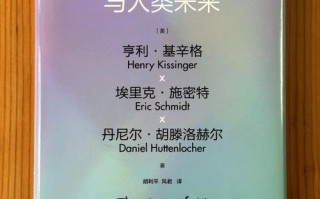

关键在于人类的智慧和选择

将AI视为天使或恶魔,是一种二元对立的思维,而现实远比这复杂。AI是一种强大的工具,其善恶属性并非内在于技术本身,而在于使用者的意图和使用的方式。

我们可以用一个比喻来总结:

人工智能就像“火”。

- 天使的一面:火可以烹饪食物、提供温暖、照亮黑夜、驱野兽,是人类文明进步的关键。

- 恶魔的一面:火可以烧毁房屋、森林,甚至用于战争和酷刑,造成巨大的破坏。

关键不在于火本身,而在于人类是否掌握了使用火的智慧,是否建立了防火的规则,以及是否有能力在火失控时将其扑灭。

面对人工智能,我们的任务不是简单地赞美或恐惧,而是:

- 负责任地研发:在追求技术突破的同时,必须投入大量资源研究AI的安全、伦理和“对齐问题”。

- 审慎地监管:政府和国际社会需要尽快建立完善的法律法规和伦理准则,为AI的发展划定红线,特别是针对高风险应用(如自主武器、大规模监控)。

- 广泛地对话:全社会需要就AI的未来进行公开、透明的讨论,确保技术的发展方向符合大多数人的共同利益,而不是少数人的私利。

- 持续地学习:个人和社会都需要提升对AI的理解和批判性思维能力,以适应这个由AI驱动的新时代。

人工智能是成为照亮人类未来的天使,还是将我们拖入深渊的恶魔,选择权在我们自己手中,我们今天所做的每一个决定,都在塑造AI的未来,也塑造我们自己的未来。