ARM是AI硬件革命的基石,而AI是ARM未来最重要的增长引擎,它们的关系可以从两个主要维度来理解:ARM如何赋能AI,以及AI如何反向塑造ARM。

ARM如何赋能AI:为AI提供无处不在的“神经末梢”

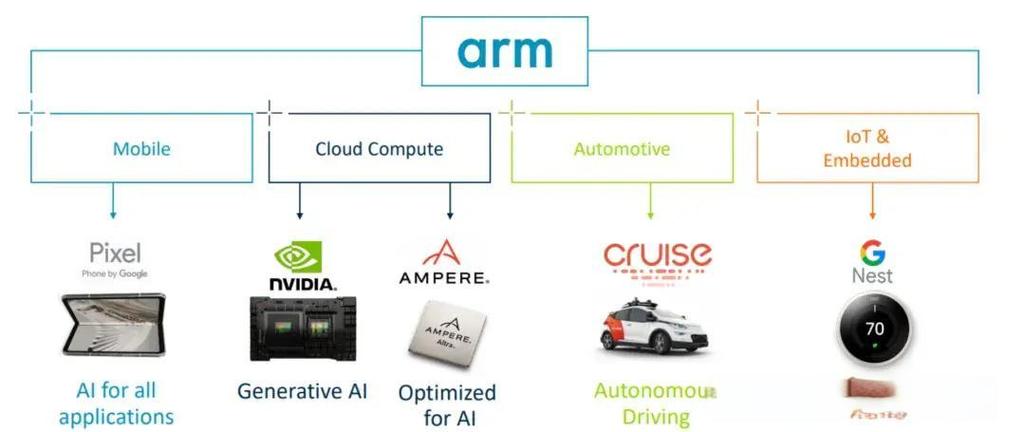

AI,特别是深度学习,其核心是海量数据的矩阵运算,这需要强大的计算能力,AI的计算需求并非都集中在云端的数据中心,AI的应用场景极其广泛,从智能手机、可穿戴设备,到智能家居、自动驾驶、工业机器人等,这些场景对芯片的要求是:高性能、低功耗、高能效比、低成本。

ARM正是凭借其独特的商业模式和架构优势,完美地满足了这些需求,成为了AI芯片领域当之无愧的王者。

架构优势:能效比之王

- RISC(精简指令集)架构:相比于传统的x86架构(如Intel、AMD的CPU),ARM的RISC架构指令更简单,执行效率更高,因此功耗极低,这对于依赖电池的移动设备和边缘计算设备至关重要,一个能效比高的芯片,意味着可以用更少的电量完成同样的AI任务,从而延长设备续航。

- 模块化设计:ARM不直接生产芯片,而是将其IP(知识产权)授权给芯片设计公司(如苹果、高通、联发科、英伟达等),客户可以根据自己的需求,像搭积木一样选择不同的CPU、GPU、NPU等IP核进行组合,这种灵活性使得AI芯片可以针对特定应用进行高度优化,实现“恰到好处”的性能与功耗平衡。

核心产品:构建AI计算的全栈能力

为了应对AI的计算需求,ARM提供了一套完整的、从端侧到云侧的IP产品组合:

-

CPU (中央处理器):所有计算的基础,ARM的高性能Cortex-A系列(如A710, A715, X4)是手机、服务器等设备的大脑,负责运行操作系统和上层AI应用。

(图片来源网络,侵删)

(图片来源网络,侵删) -

GPU (图形处理器):GPU天生擅长并行计算,是早期进行AI加速的重要单元,ARM的Mali系列和Immortalis系列GPU(支持硬件光线追踪,也能用于AI计算)为设备提供了基础的AI推理能力。

-

NPU (神经网络处理器):这是ARM针对AI计算的“定制化武器”,NPU是专门为神经网络运算而设计的硬件单元,其能效比远超CPU和GPU。

- Ethos系列NPU:ARM推出的NPU产品,如Ethos-U(用于超低功耗设备)、Ethos-N(用于高性能设备),它们可以直接集成到SoC中,为设备提供强大的本地AI推理能力,

- 智能手机:实时的人像背景虚化、AI拍照、智能语音助手。

- 可穿戴设备:健康监测(如心率异常检测)、跌倒检测。

- 智能家居:智能门锁的人脸识别、摄像头的物体识别。

- 汽车:驾驶员监控系统、高级辅助驾驶系统的感知层。

- Ethos系列NPU:ARM推出的NPU产品,如Ethos-U(用于超低功耗设备)、Ethos-N(用于高性能设备),它们可以直接集成到SoC中,为设备提供强大的本地AI推理能力,

-

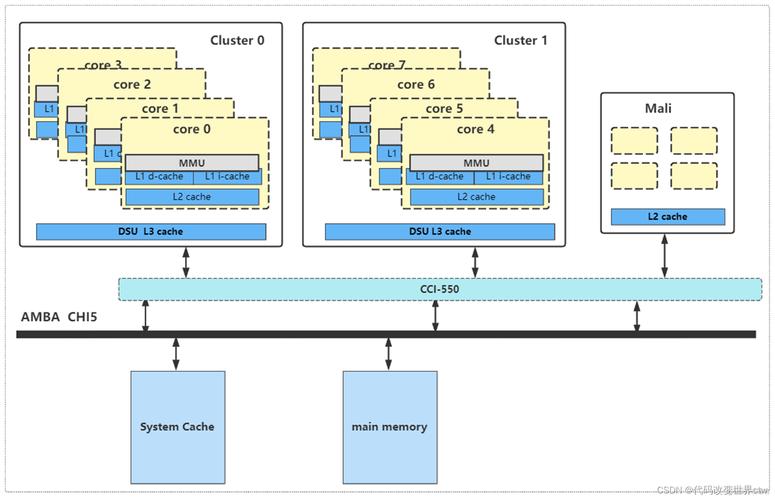

CPU + GPU + NPU 的异构计算:现代ARM-based SoC普遍采用这种异构计算架构,系统可以将不同的AI任务分配给最合适的处理单元:

- CPU:处理逻辑控制、复杂任务调度。

- GPU:处理需要大规模并行计算的AI任务。

- NPU:专门处理神经网络推理,实现最高能效。 这种协同工作方式,使得手机等设备在保持低功耗的同时,也能流畅地运行复杂的AI应用。

生态优势:构建庞大的AI应用版图

ARM的授权模式使其生态极其庞大,全球绝大多数智能手机、平板电脑以及大量物联网设备都采用ARM架构,这意味着:

- 开发一次,处处运行:AI开发者可以为ARM架构开发一次模型,然后运行在从手表到服务器的各种设备上,大大降低了开发和部署成本。

- 庞大的应用市场:数以百万计的设备为AI应用提供了广阔的落地场景,形成了良性循环。

AI如何反向塑造ARM:驱动ARM不断创新

AI不仅是ARM的客户,更是ARM技术发展的“指南针”和“驱动力”,AI的飞速发展对计算能力提出了前所未有的要求,这直接推动了ARM在架构、产品和技术上的持续演进。

驱动CPU架构的革新

AI工作负载(尤其是大模型训练)需要强大的单线程性能和巨大的内存带宽,为了应对这一挑战,ARM对其CPU架构进行了重大升级:

- 超大核心:推出了 Cortex-X 系列(如X1, X2, X3, X4),这些核心不追求能效比的极致,而是追求绝对的性能,作为SoC中的“性能担当”,专门处理最繁重的计算任务,如AI模型的本地运行或部分训练。

- 统一内存架构:传统的“大核+小核”(大小核)架构中,不同核心可能访问不同的内存池,数据搬运效率低,而AI应用需要海量数据快速流动,为此,ARM推出了统一内存架构,让所有核心(包括大小核和NPU)共享同一个统一的、高带宽的内存系统,这极大地提升了数据访问效率,对AI性能提升至关重要。

驱动专用AI硬件的演进

AI算法的不断迭代(如Transformer架构的兴起)对硬件提出了新的要求,ARM的NPU产品线也在快速迭代:

- 更高的算力:新一代NPU(如Ethos-N78)提供更高的TOPS(每秒万亿次运算)性能。

- 更灵活的架构:支持更复杂的AI模型和算子,特别是对稀疏计算的支持,因为AI模型中存在大量冗余数据,只计算非零值能大幅提升效率。

- 软件生态的完善:ARM提供了强大的软件工具链(如Arm Compute Library),让开发者能够轻松地将AI模型(如TensorFlow, PyTorch模型)编译和优化到其硬件上,降低了AI上手的门槛。

拓展全新的市场:数据中心AI训练

长期以来,AI训练市场被英伟达的GPU垄断,但AI的巨大功耗和成本问题,以及ARM在能效比上的固有优势,为ARM提供了颠覆市场的机会。

- Neoverse平台:ARM推出的数据中心级平台,专门为云、网络和AI等高性能计算场景设计。

- 挑战英伟达:亚马逊的 Graviton 系列服务器CPU(基于Neoverse)已在AWS上大获成功,证明了ARM在数据中心的可行性,ARM正联合合作伙伴(如Ampere Computing, Marvell)推出基于Neoverse的高性能AI训练芯片,试图在AI训练这个“巨无霸”市场中分一杯羹,这些芯片虽然算力峰值可能不及顶级GPU,但其总拥有成本(TCO)可能更低,因为它们在能效和功耗上具有优势。

共生共荣的未来

ARM与人工智能的关系是一个典型的“共生共荣”的范例。

- 对于AI而言,ARM提供了一套从终端到云端、兼具性能与能效的、可扩展的硬件解决方案,使得AI能够走出数据中心,赋能万物,实现了AI的“民主化”和普及化。

- 对于ARM而言,AI是其历史上最重要、最强劲的增长引擎,AI的需求倒逼ARM不断进行技术创新,从一家移动芯片IP公司,成功转型为一家覆盖PC、服务器、数据中心的全场景计算平台公司,打开了远超移动市场的巨大空间。

可以预见,随着AI向更广泛的边缘设备渗透,以及大模型向终端侧(On-Device AI)发展,ARM的架构和IP将在未来智能世界中扮演更加核心和基础的角色,而AI的每一次浪潮,也都会为ARM这家芯片架构巨头带来新的机遇与挑战。

标签: ARM架构AI加速技术 ARM处理器人工智能应用 ARM AI芯片发展路径