与传统GPU(主要用于渲染3D图形)相比,AI GPU在架构上进行了深刻的优化,核心目标是高效、快速地执行大规模并行矩阵和向量运算,这正是深度学习训练和推理的基础。

我们可以从三个层面来理解AI GPU的组成:物理硬件层面、核心计算单元层面,以及关键支撑技术层面。

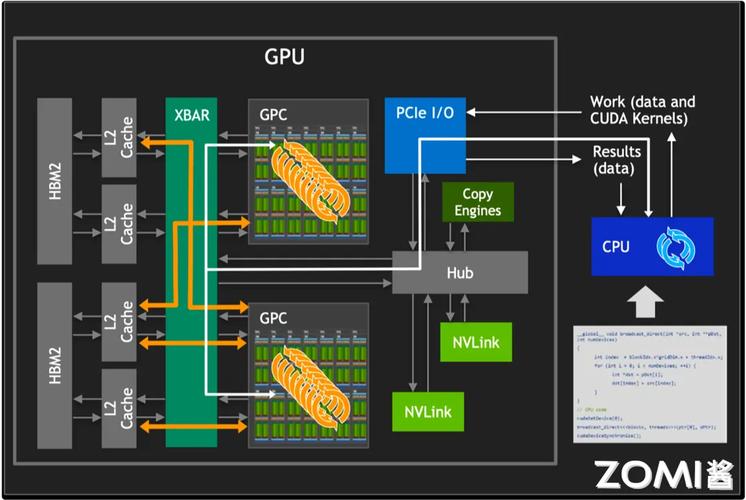

物理硬件层面:芯片的宏观构成

一块AI GPU芯片(如NVIDIA A100、H100,或AMD Instinct MI300)在物理上主要由以下几个核心部分组成,它们通过一个高带宽的互联网络(如NVIDIA的NVLink)连接在一起。

计算核心

这是AI GPU的“心脏”,是执行实际计算的地方,它不再是传统GPU中单一的图形渲染架构,而是被划分为多个专门的处理单元集群。

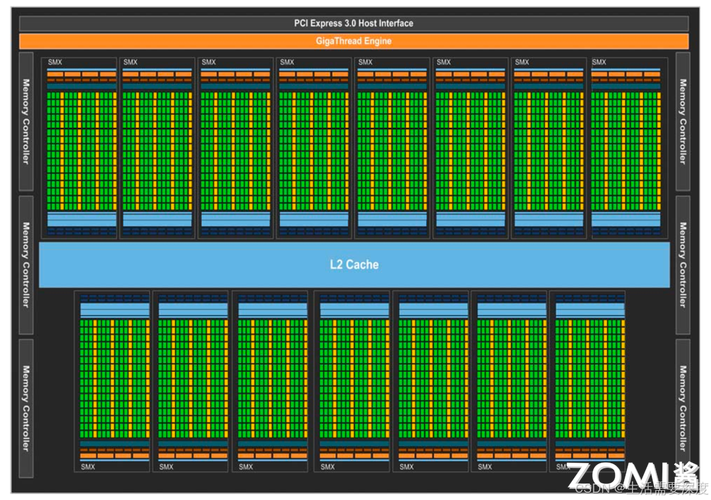

- 流多处理器 / 计算单元阵列:

- 这是最核心的部分。 AI GPU将成百上千个SM/CU排列成一个巨大的阵列,每个SM/CU内部都包含:

- CUDA核心 / 流处理器: 负责执行基本的整数和浮点数运算,虽然AI计算更依赖Tensor Cores,但这些核心处理数据预处理、后处理和部分逻辑运算。

- 张量核心: 这是AI GPU的“秘密武器”,它们是专门为矩阵乘法和累加运算设计的硬件单元,这是深度神经网络中最核心、最耗时的操作,它们能以极高的效率执行混合精度运算(如FP16、BFLOAT16、TF32),极大地加速了训练和推理速度。

- 特殊功能单元: 如用于插值的纹理单元、用于双精度运算的单元等。

- 寄存器文件 和共享内存: 为每个SM/CU提供超高速的本地数据存储,减少对片外显存的访问延迟,对性能至关重要。

- 这是最核心的部分。 AI GPU将成百上千个SM/CU排列成一个巨大的阵列,每个SM/CU内部都包含:

内存子系统

AI模型(尤其是大模型)和训练数据都极其庞大,因此内存子系统是决定GPU性能上限的关键。

- 高带宽内存:

位于GPU芯片旁边或封装内部,提供比传统GDDR/GDDR6内存高得多的带宽(例如HBM2e/HBM3可达数TB/s),这使得计算核心可以快速获取海量数据,避免“饿肚子”。

- 显存控制器:

管理HBM与计算核心之间的数据流,是连接内存和计算的桥梁,其效率直接影响数据吞吐量。

- 二级缓存:

在SM/CU和HBM之间设置一个容量较大的L2缓存,用于存储中间计算结果和热点数据,再次减少对慢速HBM的访问。

片上网络

AI GPU内部有成百上千个计算核心,它们之间需要高效地通信以协同工作。

- 交叉开关 或片上互联网络:

一个复杂的、高带宽的通信系统,负责将芯片内的所有SM/CU、内存控制器、I/O接口等连接起来,确保数据可以在任何两个单元之间快速、低延迟地传输,这就像一个城市的高速公路网,保证了整个城市的交通顺畅。

I/O 和接口

负责GPU与外部世界(如CPU、其他GPU、存储设备)的通信。

- PCIe 接口:

GPU通过PCIe插槽与主板上的CPU通信,用于加载模型、数据和控制指令。

- NVLink 接口:

- AI集群的关键。 提供远超PCIe带宽的GPU-to-GPU直接通信能力,在训练大模型时,不同GPU需要频繁地交换中间梯度数据,NVLink使得这种交换速度极快,极大地扩展了多GPU系统的有效规模。

- 显存扩展接口:

允许连接多个GPU节点,形成一个统一的、超大容量的内存池,用于训练前所未有的巨大模型。

核心计算单元层面:AI优化的精髓

除了宏观结构,AI GPU在计算单元的内部设计上也有其独到之处。

张量核心 - 专为AI而生

这是AI与传统GPU最根本的区别。

- 工作原理: 它们被设计来执行 GEMM (General Matrix Multiply),即

C = A * B + D这种运算,深度学习的核心——神经网络的前向传播和反向传播,本质上就是大量这样的矩阵运算。 - 混合精度计算: 它们可以同时处理不同精度的数据(用低精度的FP16或BFLOAT16进行计算,用高精度的FP32累加结果),这既能加速计算,又能节省内存和带宽,是现代大模型训练的标配。

- 结构: 一个Tensor Core内部有多个处理单元,可以并行计算矩阵中的一个或多个元素,实现极高的算力密度。

多精度支持能力

AI GPU不仅擅长FP32(单精度),更对低精度计算进行了深度优化。

- FP16 (半精度): 最早被广泛用于加速训练,模型大小和显存占用减半。

- BFLOAT16 (脑浮点数): 由Google提出,拥有与FP32相同的动态范围(指数位数相同),但数值精度较低,这使得它在训练时更稳定,不易出现数值溢出问题,成为当前大模型训练的主流选择。

- INT8/INT4 (整数量化): 主要用于推理阶段,将模型从浮点数转换为整数,可以进一步提升速度并降低功耗,非常适合部署在边缘设备上。

关键支撑技术层面:让硬件发挥最大效能

强大的硬件需要优秀的软件和系统技术来驱动,才能发挥全部威力。

软件栈与编程模型

- CUDA / ROCm: NVIDIA的CUDA和AMD的ROCm是GPU的“灵魂”,它们提供了编程接口、编译器和库,让开发者能够将计算任务分解成成千上万个可以在GPU上并行执行的“线程”,没有这些软件生态,GPU只是一块昂贵的硅片。

- AI框架优化: TensorFlow、PyTorch等主流AI框架都深度集成了CUDA/ROCm后端,并针对Tensor Cores等硬件特性进行了大量优化,开发者几乎可以无感知地享受到硬件加速带来的好处。

先进封装技术

随着摩尔定律放缓,单纯依靠缩小晶体管尺寸越来越困难,先进封装成为提升芯片性能的关键。

- Chiplet (芯粒) 设计: 将原本一块巨大、复杂的芯片,拆分成多个功能更小、更专一的“小芯片”(如计算芯粒、I/O芯粒、内存芯粒),然后像拼积木一样封装在一起。

- 优点: 提高良率、降低成本、允许使用不同制程工艺(计算部分用最先进的3nm,I/O部分用成熟的工艺)、通过封装内的互连提供极高的带宽。

- 例子: NVIDIA的Hopper架构GPU和AMD的MI300X都采用了Chiplet技术。

专用指令集

除了通用的CUDA指令,AI GPU还引入了专门针对AI负载的指令,进一步优化特定操作的性能。

AI GPU与传统GPU的核心差异

| 特性 | 传统GPU (用于图形) | AI GPU (用于深度学习) |

|---|---|---|

| 核心目标 | 高效渲染3D图形(光栅化、纹理映射) | 高效执行大规模并行矩阵运算 |

| 核心单元 | 侧重于光栅化引擎、纹理单元、ROP光栅操作单元 | 张量核心成为绝对主角,专为矩阵乘法优化 |

| 内存需求 | 需要存储纹理、帧缓冲,带宽要求高 | 需要存储海量模型参数和激活值,对容量和带宽要求都极高 |

| 精度 | 主要使用FP32,对FP64有一定要求 | 全面支持FP32,并深度优化FP16、BFLOAT16、INT8/INT4 |

| 互联 | 依赖PCIe进行GPU间通信 | 强大的NVLink等GPU直连技术,构建大规模计算集群 |

| 软件生态 | OpenGL, DirectX, Vulkan | CUDA, ROCm, 专为AI优化的库和框架 |

AI GPU芯片是一个高度专业化、系统化的计算平台,它通过大规模并行计算阵列、专为矩阵运算设计的张量核心、超高带宽的内存子系统、高效的片上网络以及强大的软件生态,共同构成了驱动当今人工智能浪潮的强大引擎。

标签: 人工智能GPU芯片核心部件 AI GPU芯片组成结构 人工智能显卡芯片主要构成