核心概念:模型、算法与数据的关系

在深入之前,我们首先要理解三个核心概念的关系:

- 数据:这是AI的“燃料”,高质量、大规模、经过标注的数据是训练出优秀模型的基础,数据的质量和数量直接决定了模型性能的上限。

- 算法:这是AI的“大脑”或“菜谱”,它定义了模型如何从数据中学习,算法是一种数学过程,包含了模型需要优化的规则和逻辑,梯度下降就是一种算法,它告诉模型如何调整自己以减少错误。

- 模型:这是算法在特定数据上训练后产出的“成品”,模型是一个包含大量参数(权重和偏置)的数学函数,它已经从数据中学习到了规律,可以用来对新数据进行预测或分类。

简单比喻:

- 数据:成千上万张标注了“猫”和“狗”的图片。

- 算法:一个学习如何识别猫和狗的“菜谱”(神经网络的结构和学习方法)。

- 模型:根据这个“菜谱”和“图片”训练出来的一个“识别器”,现在它能看懂新图片里是猫还是狗。

人工智能训练的核心算法

AI算法种类繁多,但主要可以分为三大类:监督学习、无监督学习和强化学习,近年来,生成式AI和自监督学习也变得异常重要。

监督学习

这是最常见、最成熟的范式,模型通过学习“输入-输出”对来进行训练,目标是找到一个函数,能够将新的输入映射到正确的输出。

- 核心思想:老师(标注数据)告诉学生(模型)什么是正确的答案,学生通过不断练习来学习。

- 典型任务:

- 分类:输出是离散的类别。

- 算法举例:

- 支持向量机:寻找一个最佳的超平面来分离不同类别的数据。

- 决策树 / 随机森林:通过一系列“是/否”问题来做决策,随机森林是多个决策树的集成,效果更稳定。

- 逻辑回归:虽然名字里有“回归”,但它主要用于解决二分类问题。

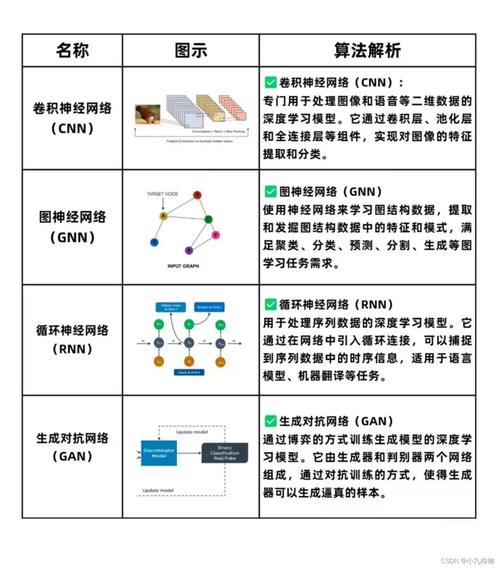

- 神经网络:特别是深度神经网络,是当前图像、语音和自然语言处理领域分类任务的王者。

- 算法举例:

- 回归:输出是连续的数值。

- 算法举例:

- 线性回归:寻找数据之间的线性关系。

- 多项式回归:寻找数据之间的非线性关系。

- 梯度提升树:如 XGBoost, LightGBM,在表格数据预测任务中表现出色。

- 算法举例:

- 分类:输出是离散的类别。

无监督学习

模型在没有标注数据的情况下进行学习,目标是探索数据内在的结构和模式。

- 核心思想:给学生一堆未分类的资料,让他自己找出其中的规律和分组。

- 典型任务:

- 聚类:将相似的数据点分到同一个组中。

- 算法举例:

- K-Means:最经典的聚类算法,预先设定要分成K个簇,然后迭代计算。

- DBSCAN:基于密度的聚类,可以发现任意形状的簇,并能识别噪声点。

- 算法举例:

- 降维:在保留数据主要信息的前提下,减少数据的特征数量。

- 算法举例:

- 主成分分析:找到数据方差最大的方向,并将数据投影到这些方向上。

- t-SNE:一种非线性降维方法,常用于高维数据的可视化。

- 算法举例:

- 关联规则学习:发现数据项之间的关联关系。

- 算法举例:

- Apriori:经典的购物篮分析算法,用于发现“买了A的人也倾向于买B”这样的规则。

- 算法举例:

- 聚类:将相似的数据点分到同一个组中。

强化学习

模型通过与环境进行交互来学习,模型在某个状态下做出一个动作,环境会给出一个奖励或惩罚,模型的目标是学习一套策略,以最大化长期累积奖励。

- 核心思想:像训练宠物或玩游戏一样,模型通过“试错”来学习什么行为是好的,什么行为是坏的。

- 典型任务:

- 游戏AI:AlphaGo下围棋,游戏AI玩电子游戏。

- 机器人控制:训练机器人走路、抓取物体。

- 资源调度:优化数据中心的服务器分配。

- 算法举例:

- Q-Learning:学习一个“状态-动作”的价值函数。

- 策略梯度:直接学习一个策略函数,告诉在某个状态下应该采取哪个动作的概率。

- 深度强化学习:结合了深度神经网络和强化学习,能处理高维度的状态(如图像),是当前RL的主流。

生成式AI 与自监督学习

这是当前AI领域最火热的方向,它颠覆了传统的学习范式。

-

自监督学习:

- 核心思想:从海量无标注数据中“创造”自己的监督信号,在一句话中,把一个词盖住,让模型去预测被盖住的词是什么,通过这种方式,模型可以学习到语言的深层结构和语义。

- 重要性:它是现代大型语言模型(如GPT系列)能够成功的关键,通过在海量文本上进行自监督预训练,模型获得了强大的语言理解能力,然后只需少量标注数据即可进行微调。

-

生成式AI:

(图片来源网络,侵删)

(图片来源网络,侵删)- 核心思想:学习数据的分布,并生成与训练数据相似但全新的数据。

- 典型模型:

- 生成对抗网络:包含一个“生成器”(Generator)和一个“判别器”(Discriminator),生成器试图生成假数据骗过判别器,判别器则努力分辨真假,两者相互博弈,共同进化。

- 扩散模型:通过一个“加噪”和“去噪”的过程来生成数据,先给一张真实图片不断加噪直到变成纯噪声,然后学习如何逆转这个过程,从噪声中一步步恢复出清晰的图片,这是当前图像生成领域(如Midjourney, Stable Diffusion)的主流技术。

- 大型语言模型:基于Transformer架构,通过自监督学习训练,不仅能生成文本,还能理解和执行各种复杂的语言任务。

AI模型的训练流程

无论使用哪种算法,训练一个AI模型通常遵循以下标准流程:

-

数据准备:

- 收集:获取原始数据。

- 清洗:处理缺失值、异常值、重复数据。

- 标注:对于监督学习,需要对数据进行人工或半自动标注。

- 划分:将数据集划分为三部分:

- 训练集:用于训练模型,让模型学习。

- 验证集:在训练过程中用于调整模型超参数(如学习率、网络层数)和防止过拟合。

- 测试集:在模型训练完成后,用于评估模型在完全未见过的数据上的最终性能。

-

模型选择与构建:

- 根据任务类型(分类、回归等)选择合适的算法和模型架构(如CNN用于图像,RNN/Transformer用于文本)。

- 初始化模型的参数(权重和偏置)。

-

模型训练:

- 前向传播:将训练数据输入模型,通过模型的数学计算得到预测结果。

- 计算损失:使用损失函数(如均方误差、交叉熵)来衡量预测结果与真实标签之间的差距,损失值越大,说明模型“错得越离谱”。

- 反向传播:这是训练的核心,算法(最常用的是梯度下降及其变种,如Adam)从损失值开始,反向计算损失函数对模型每个参数的梯度(即“坡度”),梯度指明了参数调整的方向,以使损失值减小。

- 参数更新:根据计算出的梯度,使用优化器来更新模型的参数,这个过程会反复迭代成千上万次,直到模型性能收敛。

-

模型评估:

- 使用测试集来评估模型的最终性能,常用的评估指标包括:

- 分类任务:准确率、精确率、召回率、F1分数、ROC曲线。

- 回归任务:均方误差、平均绝对误差、R²分数。

- 生成任务:Inception Score, FID分数,以及人工评估。

- 使用测试集来评估模型的最终性能,常用的评估指标包括:

-

模型部署与监控:

- 将训练好的模型集成到实际应用中(如APP后端、网站、嵌入式设备)。

- 持续监控模型在真实环境下的表现,并可能需要随着新数据的到来进行再训练。

挑战与未来趋势

-

挑战:

- 数据依赖:高质量标注数据成本高昂。

- 可解释性差:很多深度学习模型是“黑箱”,难以解释其决策过程。

- 算力消耗巨大:训练大型模型需要昂贵的计算资源。

- 偏见与公平性:模型可能从有偏见的数据中学习并放大社会偏见。

-

未来趋势:

- 多模态AI:模型能同时理解和处理文本、图像、音频、视频等多种模态的信息(如GPT-4V)。

- 更高效的算法:研究更少依赖算力的模型,如小样本学习、零样本学习。

- 可解释AI (XAI):让AI的决策过程更加透明和可信。

- AI for Science:利用AI加速科学发现,如新药研发、材料科学、气候变化模拟等。

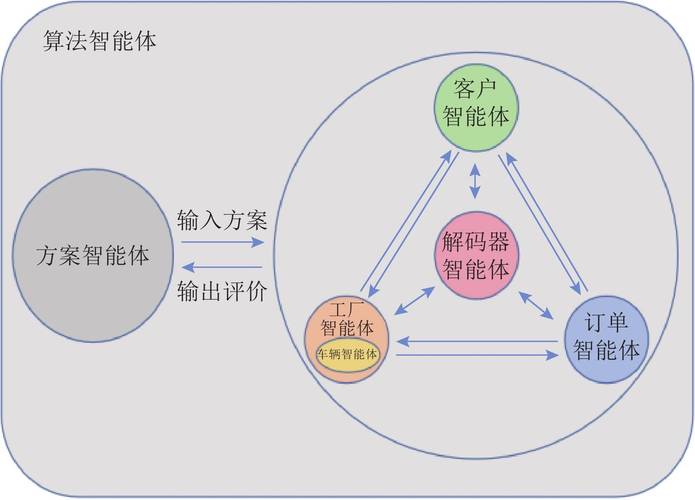

- AI Agent (智能体):AI不仅能执行单一任务,还能根据目标自主规划、执行一系列复杂任务,并与环境和其他AI进行交互。

人工智能的训练是一个系统工程,它始于数据,通过精心设计的算法,在反复迭代中优化模型参数,最终得到一个能够解决实际问题的智能体,从传统的监督学习到前沿的生成式AI,算法的演进不断拓展着AI的能力边界,理解这些核心概念和流程,是进入和深入AI领域的基石。

标签: 人工智能算法模型协同训练方法 模型算法协同进化优化策略 AI训练模型与算法协同发展路径