- 普通芯片(CPU)就像一位“博学多才的教授”:他知识渊博,能够处理各种各样复杂的、逻辑性强的任务,无论是做数学题、写文章、管理操作系统,还是进行复杂的逻辑判断,他都能胜任,但他处理一项特定任务的速度可能不是最快的。

- 人工智能芯片(如GPU、TPU、NPU等)就像一支“专项特训的体育队”:这支队伍由成千上万个只擅长做一件事的“短跑运动员”(核心)组成,他们无法进行复杂的逻辑推理,但在进行大规模、重复性的简单计算(比如矩阵乘法)时,他们的整体速度远超那位教授。

下面我们从几个关键维度进行详细的对比。

(图片来源网络,侵删)

核心差异对比表

| 特性维度 | 普通芯片 | 人工智能芯片 |

|---|---|---|

| 核心目标 | 通用计算 | 专用计算 |

| 主要任务 | 执行复杂的逻辑运算、分支判断、系统调度、运行操作系统和各种应用程序。 | 执行大规模的、并行的、重复性的数学运算,特别是矩阵和向量运算,这是深度学习的核心。 |

| 架构设计 | 低延迟、低吞吐 • 少量但功能强大的核心(如4-64个)。 • 拥有复杂的控制单元和缓存,擅长处理逻辑跳转。 |

高延迟、高吞吐 • 大量但相对简单的核心(从数千到数万个)。 • 采用SIMD(单指令多数据流)或SIMT(单指令多线程)架构,同时对大量数据进行相同操作。 |

| 硬件结构 | • 强大的ALU(算术逻辑单元) • 复杂的控制单元 • 大容量的缓存和分支预测器 |

• 海量的计算单元 • 专门的矩阵/张量运算单元 • 高带宽的内存子系统(如HBM) • (部分芯片)专门的片上网络用于数据在核心间高效流动 |

| 内存访问 | 相对较慢,依赖多级缓存来弥补CPU与主内存之间的速度差距。 | 访问模式非常规整(顺序访问),因此对内存带宽要求极高,通常会配备大带宽的内存(如HBM)来“喂饱”庞大的计算阵列。 |

| 能效比 | 相对较低,在执行AI任务时,大量通用逻辑单元闲置,浪费了能源和晶体管空间。 | 极高,专为特定任务设计,晶体管空间和能源都用在刀刃上,完成同样AI任务的能耗远低于CPU。 |

| 灵活性 | 极高,可以运行任何类型的软件,从操作系统到办公软件、游戏,无所不能。 | 较低,通常通过特定的编程框架(如CUDA, TensorFlow, PyTorch)来编程,主要用于AI模型训练和推理。 |

深入解析关键区别

架构设计的根本不同:串行大师 vs. 并行军团

- CPU (串行大师):CPU的核心是“延迟优化”,它的单个核心非常强大,擅长处理复杂的指令序列,当你玩游戏时,CPU需要处理物理碰撞、AI行为、渲染逻辑等,这些任务往往前后关联,有大量的“就…”(if-then-else)逻辑判断,CPU强大的分支预测和控制单元就是为了高效处理这些串行任务而生的。

- AI芯片 (并行军团):AI计算,尤其是深度学习,其本质是大量的矩阵乘法,一个图像识别模型可能需要将一个

224x224x3的图像矩阵与一个巨大的权重矩阵相乘,这个操作可以分解为成千上万个独立的乘法和加法运算,这些运算之间没有依赖关系,可以同时进行,AI芯片的设计就是为了让这些“短跑运动员”(计算核心)同时开跑,从而在短时间内完成海量的计算。

“冯·诺依曼瓶颈”的挑战与应对

传统的计算机遵循“冯·诺依曼架构”,即CPU和内存是分开的,数据需要在两者之间来回搬运,这个数据搬运的过程(内存访问)比计算本身慢得多,形成了“冯·诺依曼瓶颈”。

- CPU:通过多级缓存来缓解这个问题,它预测接下来需要哪些数据,提前放到更快的缓存里。

- AI芯片:由于需要的数据量巨大,缓存显得杯水车薪,AI芯片采用“近内存计算”(Near-Memory Computing)甚至“存内计算”(In-Memory Computing)的理念,将计算单元尽可能靠近内存,甚至直接集成在内存芯片上,同时使用高带宽内存(如HBM),提供像“消防水管”一样粗的数据通道,确保计算单元不会因为“断粮”而闲置。

能效比的极致追求

能效比 = 性能 / 功耗。

- 在运行AI任务时,CPU大部分晶体管都用在那些用不上的控制逻辑上,就像开着大卡车去送一封信,油耗巨大,效率极低。

- AI芯片则将晶体管密度全部用于最核心的计算单元上,就像用一支庞大的自行车队去送一车信,虽然每辆车慢,但整体运力极强,总能耗却低得多,这对于数据中心、边缘设备(如手机、摄像头)等场景至关重要,可以大幅降低运营成本和散热需求。

主流的人工智能芯片类型

- GPU (图形处理器):最初为游戏渲染而生,其天生并行架构与AI计算需求不谋而合,NVIDIA的GPU通过CUDA生态系统,几乎成为了AI训练的行业标准。AI革命的最大功臣之一。

- TPU (张量处理器):谷歌专为自家AI工作负载(如TensorFlow)设计的ASIC(专用集成电路),它直接针对矩阵乘法进行优化,能效比极高,在谷歌云服务中广泛应用。

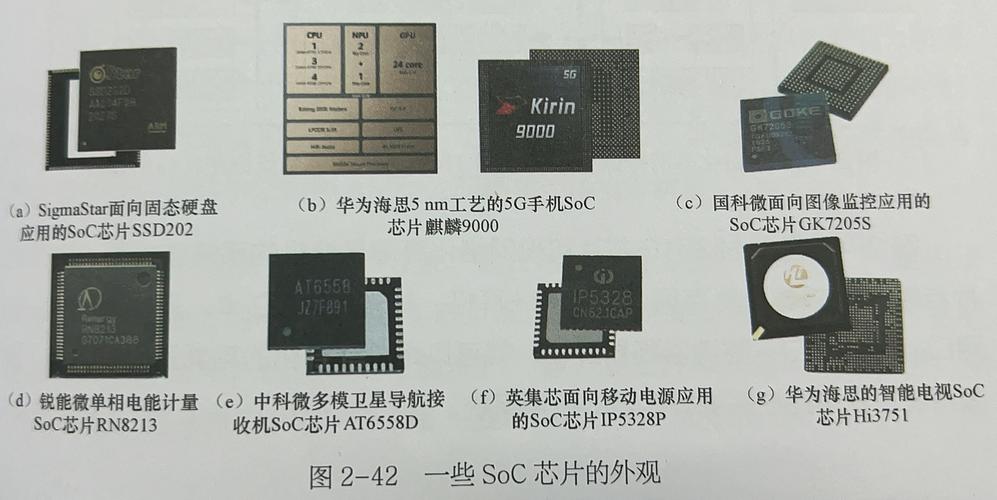

- NPU (神经网络处理器):通常集成在手机SoC(如苹果的A系列、华为的麒麟、高通的骁龙)中,专门用于在设备端高效运行AI模型(如人脸识别、语音助手),保护用户隐私并减少云端依赖。

- ASIC (专用集成电路):为特定AI算法或模型量身定制的芯片,如TPU,优点是性能和能效比达到极致,缺点是缺乏灵活性,一旦算法改变,芯片就可能过时。

- FPGA (现场可编程门阵列):一种半定制芯片,用户可以编程配置其硬件逻辑,它比ASIC灵活,比通用芯片(CPU/GPU)在特定任务上更高效,常用于AI研究的快速原型验证和一些特定的高性能计算场景。

总结与未来趋势

- CPU是“通才”,负责处理各种复杂、多样的任务,是计算机的大脑和指挥官,AI芯片是“专才”,在特定的大规模并行计算领域(如AI)拥有绝对的性能和能效优势,是执行特定任务的“超级士兵”。

- 关系:它们不是完全替代的关系,而是协同工作的关系,在一个典型的AI系统中,CPU负责数据预处理、任务调度、模型管理和结果后处理,而AI芯片(如GPU)则负责执行最耗时的模型训练和推理计算。

- 未来趋势:

- 融合:未来的芯片架构将是“异构计算”的天下,即在一个芯片或一个系统内集成CPU、GPU、NPU等多种类型的计算核心,让最合适的任务交给最合适的单元处理。

- 存算一体:突破“冯·诺依曼瓶颈”的终极方案之一,直接在存储单元中进行计算,有望带来计算效率和能效比的革命性飞跃。

- 领域专用化:针对大语言模型、自动驾驶、科学计算等不同领域,会出现更多高度定制化的AI芯片,以解决特定场景下的性能瓶颈。

(图片来源网络,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。