第一部分:什么是基础研究?

我们需要明确“基础研究”(Basic Research 或 Fundamental Research)的定义。

核心定义: 基础研究是指为了获取关于现象和可观察事实的新知识,而进行的实验性或理论性工作,它不以任何特定的、具体的应用或商业化为直接目的。

核心特征:

- 探索未知,好奇心驱动: 它源于人类对世界运行规律的好奇心,试图回答“为什么”和“怎么样”这类根本性问题。“宇宙的起源是什么?”或“意识的本质是什么?”

- 没有特定商业目标: 研究者通常不会在项目开始时就设定一个“要发明一种新药”或“要开发一个新APP”的目标,成果的应用是长期的、间接的,甚至是不可预见的。

- 成果形式: 通常是论文、理论模型、数据集、算法原理、科学发现等公共知识,这些知识通常公开发表,供整个科学界共享和进一步研究。

- 高风险、高回报: 大部分基础研究可能最终没有产生实际价值,但一旦取得突破,往往会带来颠覆性的技术和产业变革,其长期回报是巨大的。

一个经典的例子: 爱因斯坦的广义相对论(1915年),在当时,这是一个纯粹的理论物理研究,探讨的是时空、引力和宇宙的结构,它没有任何直接的实用目的,近一百年后,它成为了全球定位系统的理论基础,GPS卫星上的原子钟必须根据广义相对论和狭义相对论进行时间校准,否则定位误差每天会累积数公里,这个例子完美地展示了基础研究的长期性和深远影响。

第二部分:基础研究与人工智能的关系

人工智能,特别是当前的深度学习热潮,其发展历程是基础研究与应用研究紧密结合、相互促进的典范。

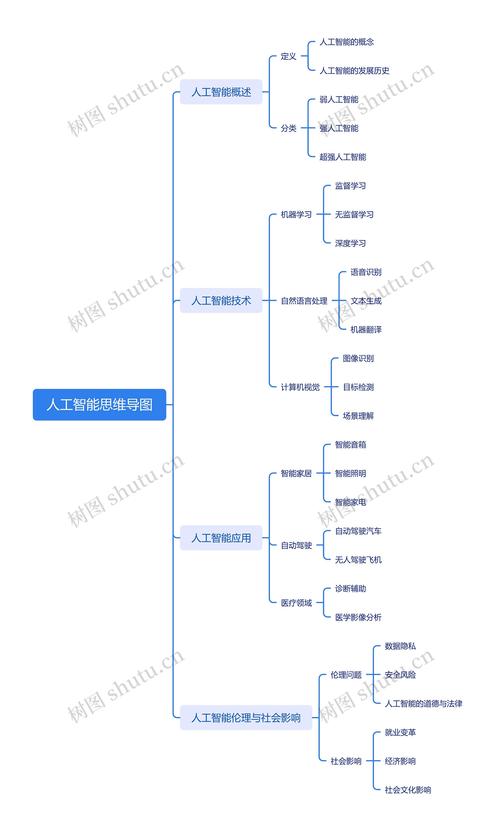

我们可以将人工智能的发展分为几个阶段来看:

AI的诞生——纯粹的数学和逻辑基础研究(1940s-1950s)

人工智能的源头并非工程学,而是数学、逻辑学和哲学。

- 理论基础:

- 数理逻辑: 哥德尔、图灵等人的工作,为“可计算性”奠定了理论基础。

- 控制论: 诺伯特·维纳提出,研究在动物和机器中控制和通讯的科学。

- 信息论: 克劳德·香农的工作,为信息处理和通信提供了数学框架。

- 标志性事件:

- 1950年,艾伦·图灵发表论文《计算机器与智能》,提出了著名的“图灵测试”,这本身就是一个思想实验,是典型的基础研究,它定义了“思考”的边界,开启了人工智能这一领域。

- 1956年,达特茅斯会议,正式确立了“人工智能”(Artificial Intelligence)这个术语,这次会议的初衷是探讨“让机器像人一样使用语言和形成抽象概念与解决问题的可能性”,这是一个充满探索性的基础研究议程。

在这个阶段,AI完全是在基础研究的土壤中孕育的。

AI的起伏——从基础到应用的探索(1960s-1990s)

这个时期,AI的研究在“符号主义”(基于逻辑和规则)和“连接主义”(基于神经网络)两条路线上发展。

- 符号主义: 基于逻辑推理,试图用符号表示知识,这本身也是基于逻辑学和认知科学的基础研究。

- 连接主义/神经网络:

- 基础研究: 1943年,麦卡洛克和皮茨提出了第一个人工神经网络的数学模型,1957年,弗兰克·罗森布拉特发明了“感知机”(Perceptron),这是最早的神经网络模型之一,这些都是开创性的基础研究。

- 遭遇瓶颈: 1969年,马文·明斯基和西摩尔·帕普特在《感知机》一书中指出了单层神经网络的局限性(无法解决XOR等非线性问题),导致神经网络研究进入了长达十余年的“AI寒冬”,这表明,基础研究需要更深厚的理论突破才能继续前进。

深度学习的复兴——基础研究的重大突破(1980s-2010s)

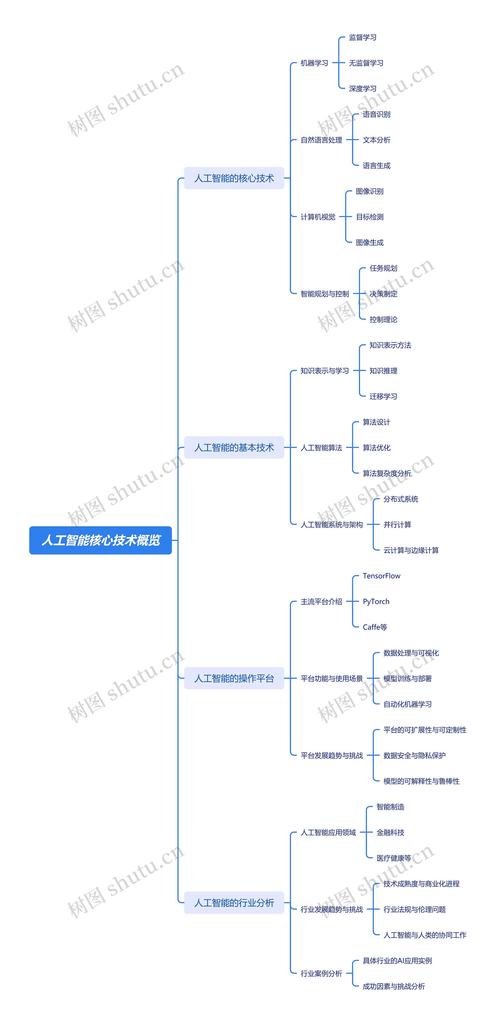

AI的第二次复兴,直接源于几个关键的基础研究突破:

- 反向传播算法(Backpropagation, 1986年): 杰弗里·辛顿等人重新发明并推广了该算法,使得多层神经网络的训练成为可能,这是深度学习的核心引擎,是一项里程碑式的基础算法研究。

- 计算能力的飞跃: 摩尔定律使得GPU等并行计算硬件变得强大和廉价,为训练复杂的深度学习模型提供了物质基础。

- 大数据时代的到来: 互联网产生了海量的数据,为训练深度学习模型提供了前所未有的“燃料”。

当前AI的爆发——基础研究与商业应用的“完美风暴”(2010s至今)

我们今天所看到的大语言模型(如GPT系列)、图像识别、自动驾驶等应用,是以下因素结合的产物:

- 坚实的理论基础: 上述提到的反向传播、概率图模型等。

- 关键的基础研究突破:

- AlexNet(2012年): 在ImageNet竞赛中取得突破性胜利,证明了深度卷积神经网络的巨大潜力,点燃了深度学习的燎原之火。

- Transformer模型(2025年): 谷歌研究人员发表了论文《Attention Is All You Need》,提出了全新的Transformer架构,这个基础模型架构彻底改变了自然语言处理领域,是当前所有大语言模型的基石,这无疑是近十年最重要的基础研究成果之一。

- 海量数据和算力: 为这些复杂模型的训练提供了可能。

一个重要的启示: 今天我们看到的ChatGPT等应用,其核心——Transformer模型,是由谷歌研究团队公开发表的基础研究成果,OpenAI、谷歌等公司在此基础上进行了巨大的工程化、产品化和商业化投入,但所有玩家都站在了这个基础研究的“肩膀”上。

第三部分:为什么AI领域持续需要基础研究?

尽管AI应用取得了巨大成功,但基础研究的重要性从未减弱,反而更加凸显,当前AI面临的核心挑战,恰恰是基础研究需要攻克的难关:

- 可解释性(Explainability / XAI): 深度学习模型像一个“黑箱”,我们知道它有效,但不知道它为什么有效,以及它是如何做出决策的,在医疗、金融、自动驾驶等高风险领域,这是一个致命缺陷。如何让AI的决策过程变得透明、可理解? 这是当前AI领域最重要的基础研究问题之一。

- 鲁棒性与安全性(Robustness & Safety): AI模型很容易受到微小的、人眼无法察觉的对抗性攻击(Adversarial Attacks)而做出完全错误的判断,如何构建从根本上更安全、更鲁棒的AI理论和方法?这是保障AI系统可靠性的基础。

- 常识与推理(Common Sense & Reasoning): 当前的AI模型(尤其是LLM)擅长模式匹配和生成流畅的文本,但缺乏人类与生俱来的常识和复杂的逻辑推理能力,如何让AI真正“理解”世界,而不仅仅是“模仿”语言?这需要认知科学、逻辑学和AI的深度融合。

- 数据效率与小样本学习(Data Efficiency & Few-shot Learning): 人类学习新技能往往只需要很少的例子,而AI则需要海量的标注数据,如何让AI像人一样,从少量数据中快速学习?这是提升AI学习能力和降低应用成本的基础。

- 通用人工智能(AGI): 最终目标是创造具有人类水平智能,甚至超越人类智能的通用人工智能,通往AGI的道路,必然依赖于一系列颠覆性的基础理论突破,而不是对现有模型的简单放大。

| 特征 | 基础研究 | 人工智能中的基础研究 |

|---|---|---|

| 目标 | 探索未知,获取新知识,理解世界规律。 | 理解智能的本质,探索AI的理论极限,解决AI的根本性瓶颈(如可解释性、鲁棒性、常识)。 |

| 例子 | 爱因斯坦的相对论、图灵的计算理论、孟德尔的遗传定律。 | 反向传播算法、Transformer模型、强化学习的理论框架、对抗性样本的研究。 |

| 与AI应用的关系 | 根基与源泉,为AI应用提供源源不断的新思想、新模型、新算法,没有基础研究的突破,AI应用的创新终将枯竭。 | 引擎与指南针,它不仅驱动着现有应用的优化,更指明了下一代AI技术的发展方向。 |

结论是:基础研究是人工智能的“发动机”和“指南针”。 当前AI的辉煌成就,是过去几十年基础研究积累的果实;而未来AI能否走向更高级、更安全、更可靠,则完全取决于我们今天在基础研究领域投入多少智慧和资源,对人工智能的持续投资,必须包含对相关数学、计算机科学、认知科学等基础研究的坚定支持。

标签: 人工智能基础研究核心方向 AI基础研究关键领域 人工智能基础研究重点方向