赞誉与乐观派:AI是革命性的生产力引擎

这部分专家通常来自产业界、部分应用型学术界以及技术乐观主义者,他们认为AI是自电力和互联网以来最重大的通用技术,其潜力是革命性的。

核心观点:

-

生产力的大幅提升:

- 自动化与效率: AI能自动化处理大量重复性、规则性的脑力劳动(如数据分析、文档撰写、代码编写、客户服务),极大地提高工作效率,让人类专注于更具创造性和战略性的工作。

- 科学发现加速器: AI正在成为继理论、实验、计算之后的“第四种科学研究范式”,它能处理和分析海量数据,帮助科学家在材料科学、药物研发、气候变化、基因测序等领域取得突破,大大缩短研发周期。

-

赋能创新与创造:

- “副驾驶”模式: 以GitHub Copilot、Midjourney、ChatGPT为代表的AI工具,正在成为各行各业的“副驾驶”或“创意伙伴”,它们能辅助编程、设计、写作、音乐创作,降低了创新的门槛,激发了新的可能性。

- 个性化体验: AI能根据个人偏好和行为数据,提供高度个性化的推荐、教育和医疗服务,提升生活品质。

-

解决全球性挑战:

(图片来源网络,侵删)

(图片来源网络,侵删)- 医疗健康: AI辅助诊断(如识别癌症影像)、新药研发、个性化治疗方案制定。

- 环境保护: AI优化能源使用、监测森林砍伐、预测极端天气、管理水资源。

- 粮食安全: 精准农业利用AI优化灌溉和施肥。

代表人物/机构:

- 英伟达CEO黄仁勋: 称AI是“继PC和移动设备之后的第三次计算浪潮”,将重塑所有行业。

- OpenAI创始人萨姆·奥尔特曼: 相信AGI(通用人工智能)将解决人类目前面临的几乎所有重大问题。

- 谷歌CEO桑达尔·皮查伊: 认为AI比火电和互联网更深刻,将比以往任何技术都更快速地影响社会。

警惕与悲观派:AI是潘多拉魔盒,风险巨大

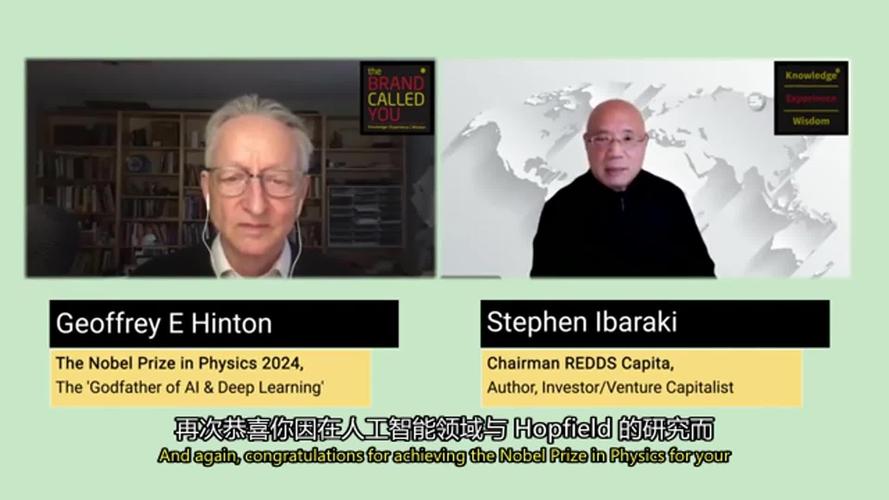

这部分专家包括许多顶尖的AI伦理学家、社会学家、部分安全研究专家以及像“AI教父”这样的资深研究者,他们看到了技术失控的巨大风险。

核心观点:

-

生存性风险:

(图片来源网络,侵删)

(图片来源网络,侵删)- 对齐问题: 这是AI安全领域的核心担忧,如果未来出现远超人类智慧的超级智能,我们如何确保它的目标和价值观与人类的福祉完全一致?一个目标设定稍有偏差的超级智能,可能会为了实现其看似无害的目标(如“制造尽可能多的回形针”)而对人类造成毁灭性打击。

- 失控风险: 人类可能无法理解和控制比我们聪明得多的AI系统的决策过程,导致不可预测的灾难性后果。

-

系统性风险与偏见:

- 算法偏见: AI系统通过数据学习,如果训练数据本身就包含人类社会的历史偏见(如种族、性别歧视),AI会放大这些偏见,导致在招聘、信贷、司法等领域的歧视性决策。

- 信息茧房与社会撕裂: AI驱动的推荐算法会不断强化用户的既有偏好,导致人们越来越难以接触到不同的观点,加剧社会极化和虚假信息的传播。

- 虚假信息与深度伪造: AI可以轻易生成以假乱真的文本、图片和视频,严重冲击新闻真实性、社会信任和民主进程。

-

经济与社会冲击:

- 大规模失业: AI不仅替代蓝领工作,还将大量替代白领工作(如律师助理、分析师、程序员),可能导致前所未有的结构性失业,加剧贫富差距。

- 权力集中: 掌握最先进AI技术的少数公司或国家将获得巨大的经济和军事优势,形成“AI霸权”,打破现有的全球权力平衡。

代表人物/机构:

- “AI教父”杰弗里·辛顿: 曾在谷歌工作,因担心AI的失控风险而辞职,他认为,在没有确保安全的情况下,让AI变得比人类更聪明是“非常不明智的”。

- 图灵奖得主斯图尔特·罗素: 长期致力于研究“价值对齐”问题,主张人类需要重新设计AI,使其“知道它不知道什么”,并始终以人类利益为最高准则。

- 未来生命研究所: 由众多科学家和思想家组成,致力于降低AI带来的存在性风险,曾发表公开信呼吁暂停比GPT-4更强大的AI系统研发。

现实主义与平衡派:关键在于“如何治理”与“负责任地发展”

这是目前大多数专家的主流观点,他们既不盲目乐观,也不因噎废食,认为AI本身是中性的,其最终影响取决于我们如何引导、规范和使用它。

核心观点:

-

技术双刃剑: AI既能为人类带来巨大福祉,也可能被滥用或带来意想不到的负面后果,技术本身没有善恶,但使用技术的人和社会制度有善恶之分。

-

治理与监管是当务之急:

- 建立“护栏”: 需要政府、企业、学术界和公民社会共同努力,建立明确的法律法规和伦理准则,为AI的发展设立“安全护栏”,欧盟的《人工智能法案》就是这方面的积极探索。

- 可解释性与透明度: 推动“可解释AI”(XAI)的发展,让人们理解AI做出特定决策的原因,避免“黑箱”操作。

- 问责制: 明确AI系统出错时,责任应由谁来承担。

-

以人为本,AI向善:

- 强调人的主体性: AI的发展应以增强人类能力、服务于人类福祉为最终目标,而不是取代或控制人类。

- 投资教育与再培训: 面对AI带来的就业冲击,社会需要大力投资于教育体系改革和劳动力的再培训,帮助人们适应新的工作需求。

- 促进全球合作: AI是全球性技术,其风险和机遇也是全球性的,需要国际合作,共同制定标准,防止恶性竞争和军备竞赛。

代表人物/机构:

- 联合国教科文组织: 发布了《人工智能伦理问题建议书》,是全球首个为AI伦理制定的规范框架。

- 世界经济论坛: 积极推动“负责任地采用人工智能”,关注AI在商业和社会治理中的正面应用与风险管理。

- 许多大型科技公司(如Google, Microsoft)的AI伦理部门: 也在内部制定原则,试图在商业利益和伦理责任之间找到平衡。

专家评价的共识与分歧

| 维度 | 乐观派观点 | 悲观派观点 | 现实主义派观点 |

|---|---|---|---|

| 技术潜力 | 革命性的生产力工具,解决人类终极问题的钥匙 | 潘多拉魔盒,可能带来无法挽回的灾难 | 强大的工具,其价值取决于应用场景 |

| 核心风险 | 无(或可通过技术进步自然解决) | 生存性风险、失控、超级智能威胁 | 系统性风险(偏见、歧视、失业)、虚假信息、权力集中 |

| 对未来的态度 | 积极拥抱,加速发展 | 呼吁暂停或严格限制,先解决安全问题 | 在发展中治理,边发展边规范,负责任地创新 |

| 解决之道 | 技术创新、市场驱动 | 安全研究、伦理先行 | 多利益相关方治理(政府、企业、学界、公众)、法律、教育 |

专家们已经达成一个重要共识:AI的影响力是巨大的,必须严肃对待其风险。

- 最大的分歧点在于风险的性质和紧迫性: 悲观派认为存在“末日级”的生存风险,需要立即采取极端措施;而主流观点则认为,当前最紧迫的风险是眼前的、可感知的社会经济问题,应优先解决。

- 从“能否实现”到“如何控制”的转变: 早期讨论更多集中在“强人工智能/超级智能能否实现”,而现在,随着AI能力的飞速发展,讨论的焦点已经迅速转向“我们如何控制它,确保它对人类有益”。

专家们的评价共同指向了一个核心命题:我们正处在一个决定人类未来的十字路口,AI的未来,不取决于技术本身,而取决于我们今天的选择、智慧和远见。

标签: 专家预测人工智能未来趋势 人工智能未来发展专家观点 专家解读AI未来前景