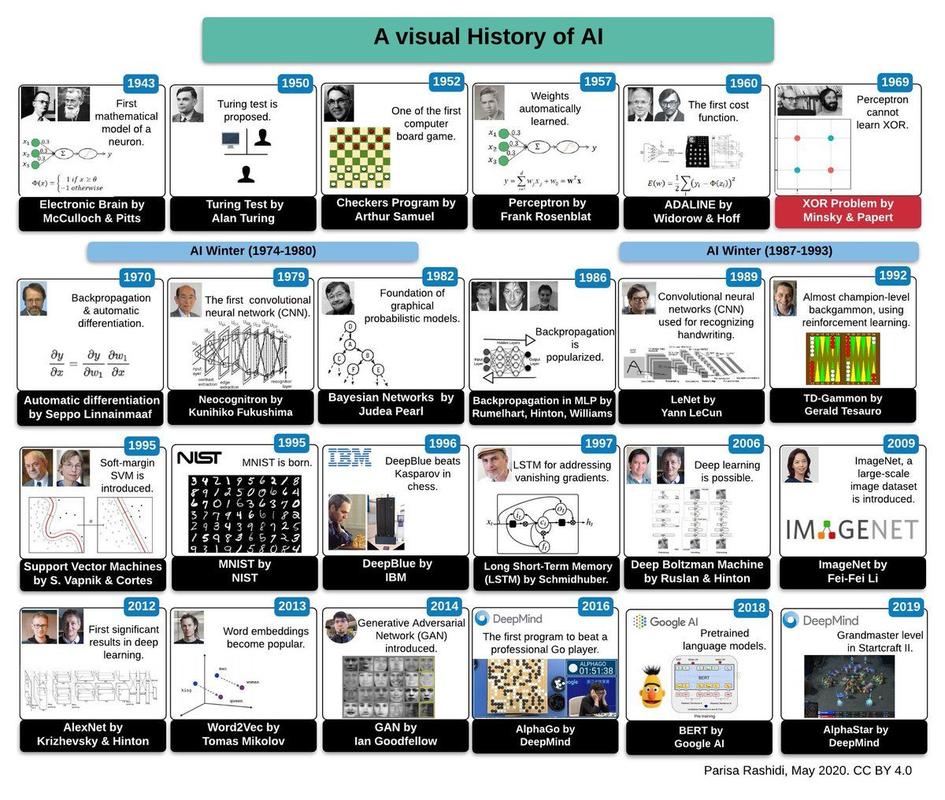

在前两卷中,我们见证了人工智能从达特茅斯会议的“黄金童年”,到遭遇寒冬的“青年迷茫”,再到专家系统的短暂复兴,专家系统的脆弱和“知识瓶颈”问题,再次将AI推向了低谷,进入20世纪90年代,整个领域似乎又一次陷入了停滞。

但历史的转折点,往往就孕育在最深的寂静之中,这一次,拯救AI的并非某种全新的理论,而是一场源自不同领域的、姗姗来迟的“思想革命”——连接主义的全面复兴。

人工智能简史 Vol.3: 深度学习革命与智能觉醒 (约1990年 - 2010年代)

第一章:寒冬后的曙光:统计学习与机器学习崛起

专家系统的失败,让AI研究者们深刻反思:试图用人类的“逻辑规则”去硬编码智能,这条路可能从一开始就走错了,真正的智能,或许并非源于清晰的规则,而是源于从海量数据中自动“学习”和“归纳”的能力。

这一时期,一个全新的范式——机器学习——开始占据舞台中央,它不再执着于让机器“思考”,而是专注于让机器“学习”。

- 从符号到统计: AI的核心思想发生了根本转变,从基于符号的逻辑推理,转向了基于概率和统计的模型,研究者们不再试图告诉机器“猫有四条腿和一条尾巴”,而是给机器成千上万张猫的图片,让它自己总结出“猫”这个概念的特征。

- 关键算法登场:

- 支持向量机: 由Vladimir Vapnik在1995年提出,它像是在不同类别数据之间画一条最优的“分界线”,在分类问题上表现出惊人的威力,成为90年代到21世纪初最主流的机器学习算法之一。

- 隐马尔可夫模型: 在语音识别和自然语言处理领域大放异彩,它擅长处理序列数据,比如将声音信号识别为文字,或将词语序列识别为句子。

这个时代,AI不再仅仅是计算机科学家的专属领域,统计学、数学家们的加入,为AI注入了严谨的理论基础,AI开始变得务实、低调,但根基却前所未有的扎实。

第二章:连接主义的王者归来:神经网络再出发

在80年代末被边缘化的连接主义(神经网络)也并未完全死去,一位名叫杰弗里·辛顿的英国科学家,成为了这场复兴的旗手。

-

关键的“钥匙”——反向传播: 辛顿和他的团队在80年代中期改进了反向传播算法,这个算法解决了多层神经网络(即“深度神经网络”)的“训练”难题,想象一下,教一个多层神经网络识别图片,就像教一个学生通过层层考试,反向传播算法就像一个高效的“批改作业”工具,它能精确计算出网络中每一层、每一个“神经元”的“错误”有多大,并指导如何调整这些连接的“权重”,从而让整个网络越来越“聪明”。

-

“深度学习”概念的提出: 2006年,辛顿在《科学》杂志上发表了一篇里程碑式的论文,正式提出了“深度信念网络”(Deep Belief Networks)和“深度学习”的概念,他证明了,通过一种叫做“逐层预训练”的方法,可以有效训练出具有很多隐藏层(即“深”)的神经网络,从而解决传统方法训练深度网络时的梯度消失问题。

这声呐喊,在当时并未引起巨大轰动,但它像一颗种子,埋下了未来十年革命的火种,AI的“深”度,终于有了理论和算法的支撑。

第三章:大数据、大算力、大模型:引爆革命的“三驾马车”

如果说辛顿的论文是点燃引线的人,那么21世纪前十年兴起的“三驾马车”,则为深度学习革命提供了最强大的燃料和引擎。

-

大数据:

互联网的普及和Web 2.0的兴起,产生了前所未有的海量数据,谷歌、百度等搜索引擎每天抓取数十亿网页;Facebook、Twitter等社交平台产生用户上传的图片、视频和文本;电商记录着每一次点击和购买,这些数据不再是实验室里的小样本,而是真实世界复杂模式的巨大宝库,深度学习模型,正是需要这种规模的“饲料”才能茁壮成长。

-

大算力:

- 深度学习模型的训练过程,需要进行海量的矩阵运算,对计算能力的要求是指数级的,传统的CPU已经无法胜任。GPU(图形处理器)的崛起成为了关键,GPU最初是为游戏渲染设计的,拥有数千个核心,极度并行,恰好完美契合了深度学习的计算需求,2009年,吴恩达和他的团队成功将GPU应用于神经网络训练,训练速度比CPU快了数十倍,这彻底改变了游戏规则。

-

大模型:

- 有了数据,有了算力,研究者们开始尝试构建前所未有的巨大模型,2012年,辛顿团队的学生亚历克斯·克里热夫斯基设计的AlexNet横空出世。

- 在当年的ImageNet(一个包含1400万张图片、涵盖2万类别的巨大数据库)图像识别大赛中,AlexNet以远超第二名的惊人成绩夺冠,它使用了8层深的神经网络,并在两个GPU上进行了训练,AlexNet的成功,如同一声惊雷,宣告了深度学习时代的正式到来,它证明了,足够深、足够大的模型,在足够的数据和算力支持下,可以展现出惊人的能力。

第四章:智能的奇点:从“能听会说”到“能看会认”

深度学习的革命,首先在感知领域取得了决定性胜利。

- 计算机视觉的飞跃: AlexNet之后,深度学习迅速成为图像识别、目标检测、图像分割等任务的绝对王者,自动驾驶汽车能够准确识别路上的行人和车辆;医疗影像分析系统能够比人类医生更早发现癌细胞;手机拍照的美颜、背景虚化等功能,背后都是深度学习算法。

- 语音识别的突破: 基于深度学习的语音识别系统,其准确率首次在特定场景下超越了人类速记员,Siri、Google Assistant、Alexa等智能语音助手开始走进千家万户,人机交互方式发生了革命性变化。

- 自然语言处理的进展: 虽然进展稍慢,但深度学习也开始在机器翻译、情感分析、文本生成等领域崭露头角,机器翻译的质量从“勉强能看”提升到“基本可用”。

第五章:卷积、循环与生成:AI工具箱的扩充

在这一时期,多种强大的深度学习网络架构被发明和完善,构成了现代AI的“工具箱”。

- 卷积神经网络: 专为处理网格状数据(如图像)而设计,通过“卷积”和“池化”操作,能有效提取图像的局部特征和空间层次结构,是计算机视觉的基石。

- 循环神经网络: 专为处理序列数据(如文本、语音、时间序列)而设计,它具有“记忆”功能,能捕捉序列中的时序依赖关系,是早期NLP和语音识别的核心。

- 生成模型: AI不再仅仅满足于“理解”世界,开始尝试“创造”世界。生成对抗网络和变分自编码器等模型,能够学习数据的分布,并生成全新的、以假乱真的图像、音乐甚至文本,这为后来的AIGC(AI生成内容)浪潮埋下了伏笔。

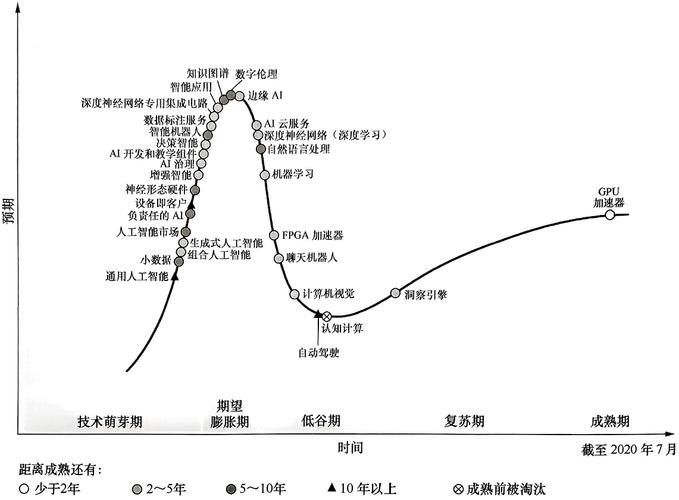

卷三结语:黎明已至

到2010年代中期,人工智能已经走出了长达数十年的“AI寒冬”,它不再是科幻小说里的遥远幻想,而是实实在在、无处不在的技术,深度学习,这个曾经被边缘化的连接主义思想,最终凭借其强大的学习和泛化能力,带领AI迎来了真正的复兴。

新的问题也随之而来:这些“黑箱”模型为何如此有效?我们能解释它们的决策过程吗?当AI的能力越来越强,我们该如何控制它?更重要的是,这些模型只是从数据中学习模式,还是真正开始拥有了某种形式的“智能”?

《人工智能简史》的第四卷,将探讨这些问题,并讲述AI如何从一个“工具”,演变为一个能够与人类进行创造性对话的“伙伴”——生成式AI的时代。

标签: 人工智能技术瓶颈突破 AI发展瓶颈如何解决 人工智能技术突破路径