这是一个非常好的问题,也是很多人对人工智能最直观的疑问。

答案是:语音助手属于人工智能,但它是一种相对基础和特定领域的人工智能。

我们可以从几个层面来理解为什么它既是AI,又为什么它还不是我们想象中那种无所不能的“强人工智能”。

为什么语音助手是人工智能?

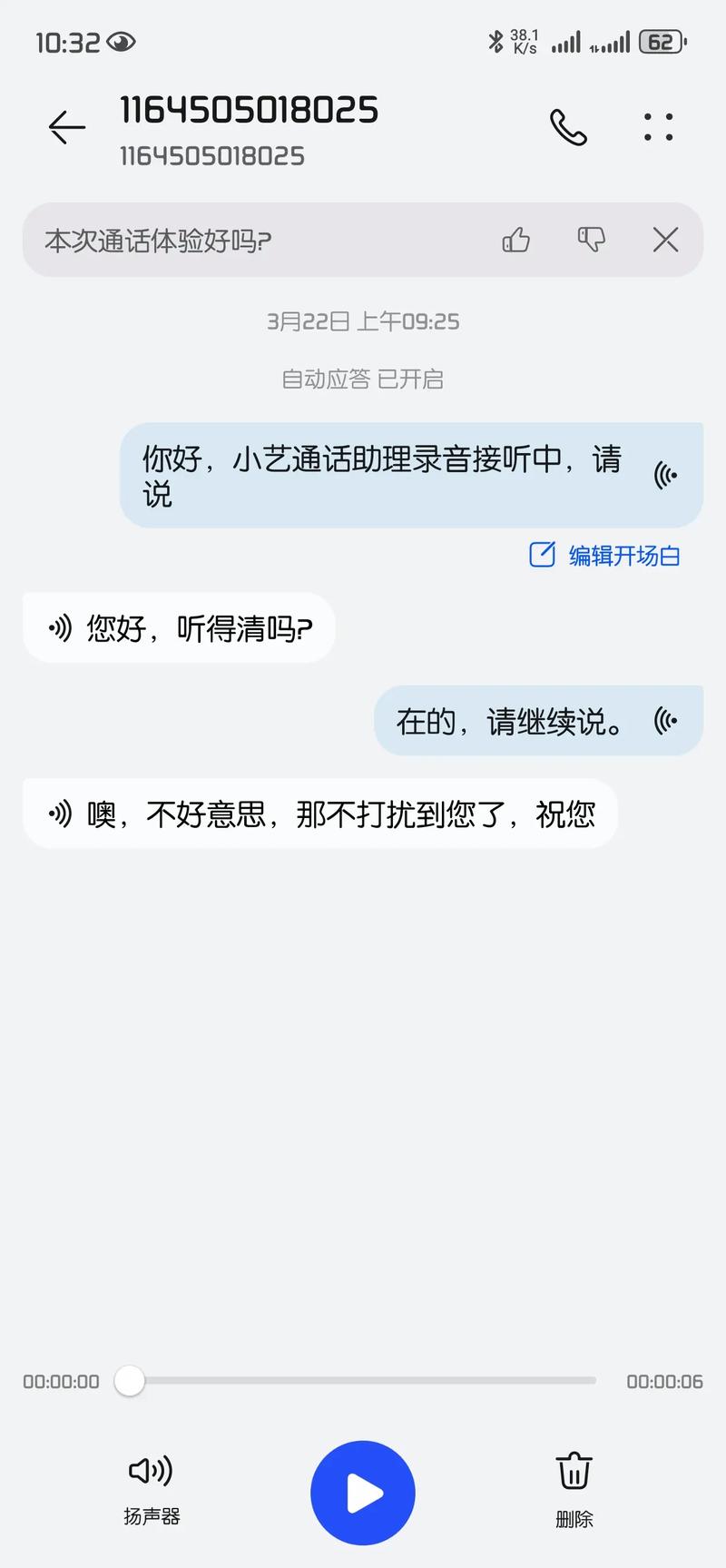

语音助手(如Siri、小爱同学、天猫精灵、Google Assistant等)确实应用了多项AI核心技术,使其能够模拟人类进行交互,这些技术包括:

a) 自动语音识别 这是语音助手最基础也是最核心的AI技术,它负责将你说的口语(今天天气怎么样?”)转换成机器可以理解的文字,这个任务极其复杂,因为它需要处理:

- 口音和方言: 识别不同人的口音、语速和地方口音。

- 背景噪音: 在嘈杂的环境中准确捕捉你的声音。

- 自然语言: 理解口语中不连贯、有重复、有停顿的特点。

b) 自然语言处理 光听懂还不行,机器还必须理解这句话的意图和实体,这是NLP的范畴。

- 意图识别: 判断你到底想干什么,你说“帮我订一张去北京的机票”,NLP会识别出你的意图是“订票”。

- 实体提取: 从句子中提取关键信息,在刚才的例子里,它会提取出“目的地:北京”、“动作:订票”等实体。

- 上下文理解: 记住对话的上下文,你如果说“它呢?”,它需要知道“它”指的是你刚才提到的某个事物。

c) 机器学习 以上所有技术都依赖于机器学习模型,这些模型通过海量的语音和文本数据进行训练,不断优化自己的识别准确率和理解能力,你用得越多,它有时“学”得就越懂你(这也是一种AI的体现)。

d) 知识图谱与信息检索 在你表达完意图后,语音助手需要去寻找答案,它会连接到庞大的知识库(知识图谱)和搜索引擎,通过语义匹配找到最相关的信息,并以语音形式合成后反馈给你。

语音助手通过“听懂(ASR)-> 理解(NLP)-> 行动(检索/调用API)-> 说出来(TTS)”这一整套流程,模拟了人类的对话行为,而这整套流程的每一个环节都离不开人工智能技术的支撑,它毫无疑问是人工智能的应用。

为什么它又不是“完全”的人工智能?

尽管语音助手很强大,但它与我们通常在科幻电影里看到的、具备自我意识和通用智慧的“强人工智能”(AGI)还有着天壤之别,它的局限性体现在:

a) 狭窄领域 语音助手是“弱人工智能”或“专用人工智能”的典型代表,它只在“语音交互和任务执行”这个特定领域表现出色,一旦超出这个范围,它就会“变傻”,它无法像人类一样进行跨领域的抽象思考、情感共鸣或创造性工作。

b) 缺乏真正的理解 它更像一个“模式匹配和规则执行”的专家,它知道“天气”这个词通常和查询温度、降雨概率相关,但它并不真正理解“天气”是什么,也不关心你出门是否会淋雨,它处理的是数据关联,而非概念理解。

c) 没有自主意识 语音助手没有自我意识、情感、欲望或主观体验,它的一切行为都是基于程序和算法的驱动,它不会“想”要做什么,也不会“感觉”到高兴或悲伤,它是一个非常复杂的“信息处理工具”,而不是一个“生命体”。

d) 依赖预设数据和规则 它的能力边界很大程度上取决于其背后数据库的广度和工程师设定的规则,当遇到一个完全新颖、超出其训练数据范围的问题时,它往往会回答“我无法理解”或给出一个风马牛不相及的答案。

一个生动的比喻

你可以把语音助手想象成一个“超级专业的图书管理员+翻译官”。

- 翻译官: 能准确听懂你说的话(ASR),并翻译成机器能懂的“图书馆编码”(NLP)。

- 图书管理员: 根据你给的“编码”,迅速在巨大的图书馆(知识库)里找到最相关的书籍(信息),然后摘录出你需要的内容。

- 翻译官: 再把摘录好的内容,用自然流畅的语言(TTS)念给你听。

这个图书管理员非常博学、反应迅速,但他本身并没有创造知识的能力,也无法和你讨论人生哲学。

语音助手是人工智能,而且是AI技术走向大众化、普及化最成功、最直观的应用之一。 它将复杂的AI技术(ASR、NLP等)封装在一个简单的对话界面背后,让我们每个人都能够体验到AI的便利。

它也清晰地展示了当前AI技术的水平:在特定任务上可以超越人类,但在通用智能和意识层面,与人类还有着本质的区别。 它是AI发展历程中的一个重要里程碑,但绝不是终点。

标签: 语音助手属于人工智能技术范畴 语音助手人工智能原理 语音助手与人工智能关系