当然可以!使用AMD显卡来训练人工智能是完全可行的,而且在很多场景下,它是一个极具性价比和高性能的选择。

和目前市场领导者NVIDIA相比,AMD的AI训练生态有其独特的优势和需要考虑的挑战,下面我将从几个方面详细解释。

核心结论先行

- 可以吗? 完全可以。

- 主流吗? 不如NVIDIA主流,但生态正在飞速发展,社区和厂商支持力度很大。

- 适合谁? 预算有限、追求高性价比、进行特定规模(如7B、13B参数)大模型微调或推理、或从事科研/特定领域(如AMD Instinct MI300X用于超算)的开发者。

AMD显卡用于AI训练的优势

-

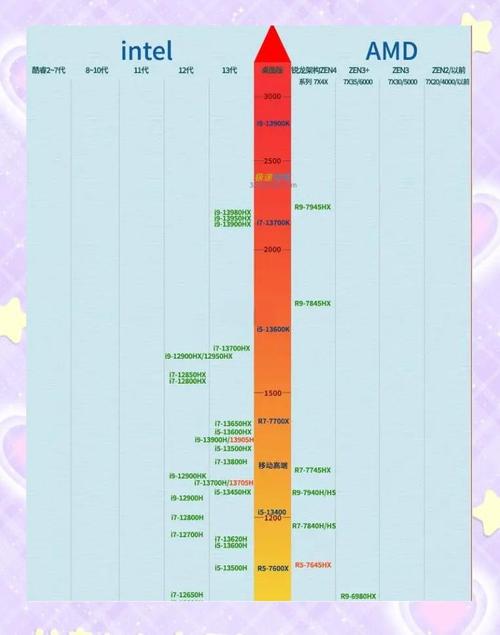

极高的性价比 这是AMD显卡最核心的优势,以消费级显卡为例,AMD Radeon RX 7900 XTX 在其发布时,其价格远低于性能对标的NVIDIA RTX 4090,但在AI计算方面提供了非常强大的算力。

- 显存巨大:RX 7900 XTX 拥有 24GB GDDR6 显存,而价格相近的RTX 4080只有16GB,在AI训练中,更大的显存意味着可以训练更大尺寸的模型、使用更大的批次大小,从而提升训练速度。

- 性价比突出:每单位算力的成本通常比同价位的NVIDIA显卡更低。

-

强大的计算能力 AMD的现代GPU,特别是基于 CDNA架构 的专业卡(如Instinct系列)和 RDNA架构 的游戏卡,拥有极高的内存带宽和大量的计算单元,这对于需要高吞吐量的AI训练任务至关重要,顶级专业卡如 Instinct MI300X,其性能已经可以媲美甚至超越NVIDIA的顶级产品,是超算中心训练超大规模模型的重要力量。

-

大显存优势 如前所述,AMD在高端消费级和专业级显卡上普遍配备了更大的显存,对于许多大语言模型的微调任务,显存往往是比算力更先耗尽的瓶颈,拥有24GB或更多显存的AMD显卡,让许多开发者无需昂贵的专业卡也能开始实践。

(图片来源网络,侵删)

(图片来源网络,侵删) -

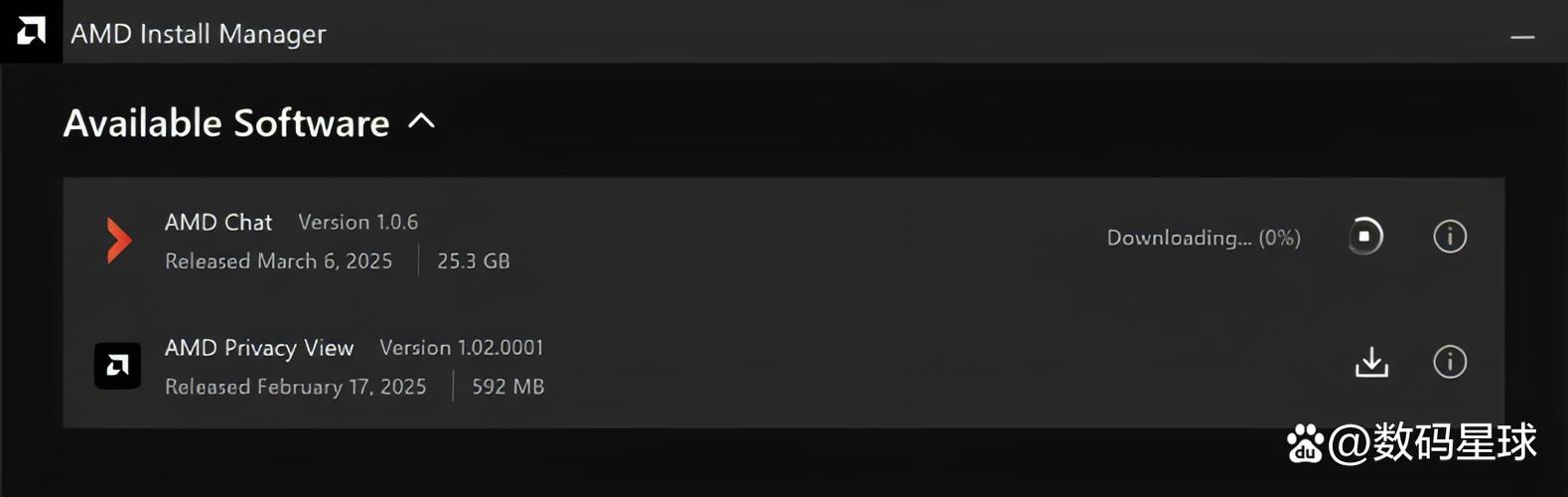

开源社区的强力支持 AMD是 ROCm™ (Radeon Open Compute Platform) 平台的创造者,ROCm是一个开源软件平台,旨在让开发者能够利用AMD的GPU进行通用计算和AI/ML任务,得益于其开源特性,全球的开发者社区为其贡献了大量力量,使其对主流AI框架的支持越来越好。

AMD显卡用于AI训练的挑战与考量

-

软件生态是最大挑战 这是目前AMD与NVIDIA最主要的差距所在。

- CUDA的统治地位:NVIDIA的 CUDA 平台已经发展了十多年,拥有最成熟、最完善、最易用的软件栈,绝大多数AI框架(如PyTorch, TensorFlow)都优先为CUDA进行优化,许多专用的库和工具都只支持CUDA。

- ROCm的追赶:ROCm虽然发展迅速,但在易用性、稳定性和某些库的覆盖面上与CUDA仍有差距,你需要花费更多精力来配置环境、解决兼容性问题。

-

驱动程序和兼容性问题

- Linux是主战场:ROCm在Linux系统(特别是Ubuntu)上的支持是最好的,在Windows上使用ROCm进行AI训练的支持相对有限且不稳定,通常不推荐。

- 版本锁定:ROCm、AMD驱动、AI框架版本之间需要严格匹配,否则很容易出现各种意想不到的错误,你需要仔细查阅官方文档,确保所有组件版本兼容。

-

特定库和优化的缺失 虽然主流的PyTorch和TensorFlow都支持ROCm,但一些更底层的、高度优化的AI库(如用于NLP的

FlashAttention、用于计算机视觉的CUTLASS等)可能对CUDA的支持更完善,对ROCm的支持较晚或仍在开发中。 (图片来源网络,侵删)

(图片来源网络,侵删) -

市场占有率和惯性 由于历史原因,绝大多数AI研究者和公司都习惯并依赖于NVIDIA的生态,这导致更多的教程、预训练模型、第三方工具都是基于CUDA的,使用AMD显卡需要你“摸着石头过河”。

如何开始使用AMD显卡训练AI?

如果你决定尝试,以下是关键步骤:

-

硬件选择

- 消费级:Radeon RX 7900 XTX (24GB) 是目前性价比最高的选择,非常适合入门和进行中等规模模型的微调。

- 专业级:AMD Instinct MI200/MI300系列,用于超大规模模型训练和科研,性能顶尖。

-

软件环境配置

- 操作系统:强烈推荐使用 Ubuntu Linux (20.04 或 22.04)。

- 安装驱动:从AMD官网下载并安装最新的Linux驱动(amdgpu-pro-driver)。

- 安装ROCm:按照 ROCm官方安装指南 进行安装,这个过程可能会比较复杂,请务必仔细阅读文档。

- 安装AI框架:安装支持ROCm的PyTorch或TensorFlow版本,通常需要从源码编译或使用官方提供的预编译包,在PyTorch官网上可以找到针对ROCm的安装命令。

# 示例:安装支持ROCm的PyTorch (请务必查看官网获取最新命令) pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm5.4.2

注意:

rocm5.4.2是一个示例版本号,你需要根据你的ROCm版本和硬件选择正确的版本。

-

验证安装 安装完成后,运行以下Python代码来验证PyTorch是否能正确识别你的AMD GPU:

import torch print(f"PyTorch version: {torch.__version__}") if torch.cuda.is_available(): print(f"CUDA is available! Version: {torch.version.cuda}") # 检查是否有AMD GPU amdgpu_available = False for i in range(torch.cuda.device_count()): device_name = torch.cuda.get_device_name(i) print(f"GPU {i}: {device_name}") if "AMD" in device_name or "Radeon" in device_name: amdgpu_available = True if amdgpu_available: print("成功检测到AMD GPU!") else: print("未检测到AMD GPU,请检查安装。") else: print("CUDA is not available. 请检查ROCm安装。")

| 特性 | AMD (ROCm) | NVIDIA (CUDA) |

|---|---|---|

| 硬件性能 | 非常强大,性价比高 | 行业标杆,性能顶尖 |

| 显存 | 消费级显存通常更大 | 专业卡显存容量巨大 |

| 软件生态 | 开源,发展迅速,社区支持强 | 闭源,绝对主导,生态最完善 |

| 易用性 | 较复杂,需要解决兼容性问题 | 非常简单,开箱即用 |

| 市场占有率 | 较低,但正在增长 | 绝对垄断 |

| 适用场景 | 预算敏感、大显存需求、特定科研、超算 | 几乎所有AI应用,尤其是商业级和大规模训练 |

给你的建议:

- 如果你是初学者或追求省心:从NVIDIA开始是最稳妥的选择,丰富的教程和现成的解决方案能让你专注于AI算法本身,而不是环境配置。

- 如果你有Linux经验,预算有限,或有大显存刚需:强烈推荐尝试AMD,RX 7900 XTX这样的显卡能让你以较低的成本获得强大的AI训练能力,体验开源社区的活力,特别是当你想微调一些中等规模的大模型时,它的24GB显存会是巨大的优势。

- 如果你从事前沿科研或超大规模模型训练:AMD的Instinct MI300X是NVIDIA H100/A100的有力竞争者,值得密切关注和评估。

用AMD显卡训练AI的道路上挑战与机遇并存,随着ROCm生态的日益成熟,它正变得越来越有吸引力,如果你不畏惧折腾,它将为你打开一扇通往高性能、低成本AI世界的大门。

标签: AMD显卡 AI训练 RX显卡 深度学习 AMD 显卡 人工智能训练