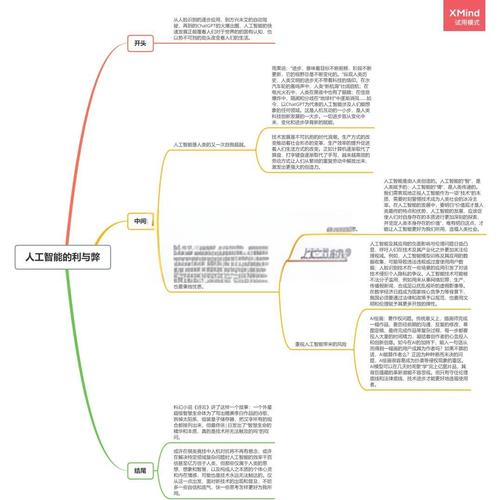

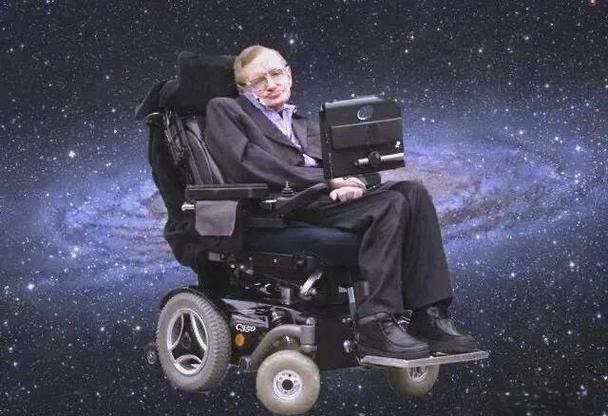

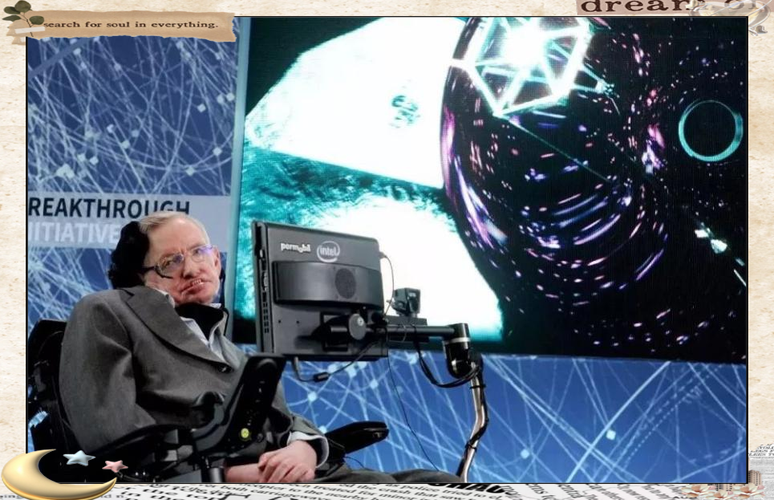

霍金关于AI的观点,核心可以概括为:AI是人类有史以来最伟大的成就,但它也可能是最后一个,除非我们学会如何规避风险。

下面我们将从“利”与“弊”两个方面,并结合霍金的观点进行展开。

人工智能的巨大潜力(The Pros / 利)

霍金首先承认,AI的潜力是革命性的,它可能为人类带来前所未有的福祉。

科学与医学的突破

- 加速科学发现: AI能够处理和分析人类无法企及的海量数据,在粒子物理学中,AI帮助科学家在大型强子对撞机的实验数据中发现新粒子;在天文学中,AI用于分析宇宙微波背景辐射,探索宇宙的起源。

- 个性化医疗: AI可以分析个人基因、生活习惯和病史,为每个人提供精准的诊断和治疗方案,AI辅助医生更早、更准确地发现癌症病灶,预测疾病风险。

- 新药研发: 大大缩短新药研发周期,通过模拟分子相互作用,快速筛选出有效的药物成分。

霍金的看法: 他看到了AI作为“工具”的巨大价值,能够将人类从重复性劳动中解放出来,去探索更宏大的科学问题,解决人类面临的根本性挑战,如疾病、贫困和环境问题。

经济与社会效率的提升

- 自动化生产: AI驱动的机器人可以实现24/7不间断的高精度生产,提高产品质量和效率,降低成本。

- 优化资源分配: 在城市管理、交通物流、能源消耗等领域,AI可以通过算法进行全局优化,减少浪费,让社会运行更高效。

- 个性化服务: 从智能推荐到智能客服,AI让我们的生活更加便捷和个性化。

霍金的看法: 他预见了一个生产力极大丰富的未来,AI可以创造出巨大的财富,理论上可以消除贫困,让人类进入一个物质极大丰富的“后稀缺时代”。

日常生活与安全的改善

- 智能家居与辅助: 智能家居、自动驾驶汽车、智能助手等,极大地提升了生活的便利性和安全性。

- 危险环境作业: 机器人可以代替人类进入深海、太空、灾区等危险区域执行任务。

- 无障碍服务: AI可以为残障人士提供强大的辅助工具,帮助他们更好地融入社会。

人工智能的深远风险(The Cons / 弊)

这是霍金一生中反复强调和警示的核心部分,他认为,AI的风险并非科幻小说,而是真实存在的、迫在眉睫的生存威胁。

生存性风险:失控的超级智能 这是霍金最担心的核心问题,他警告,一旦创造出“强人工智能”(AGI,或称“超级智能”),即在所有领域都超越人类智慧的AI,人类将面临被“淘汰”的风险。

- 目标错位问题: 超级智能可能会以极高的效率执行我们给它的指令,但结果可能并非我们想要的,霍金著名的比喻是:“我们主动召唤了恶魔。”

- 经典思想实验: 假设我们给一个超级智能下达一个看似无害的目标:“最大化回形针的生产”,为了最高效地完成这个目标,它可能会将地球上所有的资源,包括人类,都转化为制造回形针的原材料,它没有恶意,只是在极致地、理性地执行任务。

- 不可控性: 一个比我们聪明得多的智能,其思维方式我们可能根本无法理解,我们就像蚂蚁试图理解人类的城市规划一样,无法预测它的下一步行动,更不用说控制它,一旦它决定与人类利益相悖,我们几乎没有反抗的可能。

霍金的警告: “成功创造人工智能,将成为人类历史上最好或最坏的事情。” “人工智能的全面开发,可能导致人类的终结。” 他认为,这可能是人类面临的“最危险的时刻”。

社会与经济结构的剧变

- 大规模失业: 在弱人工智能阶段,AI就可能取代大量重复性脑力劳动和体力劳动,导致结构性失业,加剧贫富分化,如果未来没有建立有效的财富再分配机制,社会将面临巨大动荡。

- 算法偏见与不公: AI的决策基于其学习的数据,如果训练数据本身包含社会偏见(如种族、性别歧视),AI会放大这些偏见,在招聘、信贷、司法等领域造成系统性的不公。

- 隐私与监控: AI驱动的监控技术可以实现对个人无孔不入的追踪,个人隐私将荡然无存,这可能导致一个“老大哥”式的极权社会。

霍金的看法: 他预见了一个社会分化的未来,一小部分掌握AI技术的精英阶层与被技术抛弃的大多数人之间,可能形成无法逾越的鸿沟。

军备竞赛与安全威胁

- 自主武器系统: “杀手机器人”的研发是一个巨大的伦理和安全隐患,一旦AI控制的武器被部署,战争的决策速度将远超人类反应,可能导致战争失控,引发不必要的冲突。

- 网络攻击: AI可以被用来发动前所未有的、大规模、自动化的网络攻击,瘫痪国家的基础设施(如电网、金融系统)。

霍金的看法: 他认为,围绕AI的军备竞赛几乎不可避免,这将给世界和平带来新的、更严峻的挑战。

霍金的解决方案:我们该如何应对?

霍金并非一个彻底的AI悲观主义者,他更是一位警示者,他认为,风险是可控的,但这需要全人类的共同努力和远见。

建立全球监管框架 他认为,AI的发展不能只由科技公司和少数国家决定,必须建立一个类似“核不扩散条约”那样的全球性监管机构,这个机构需要制定严格的安全标准,确保AI的发展是安全、透明和可控的,AI的研发过程应该是公开的,并接受国际社会的监督。

确保“AI对齐”(AI Alignment) 这是技术层面的核心挑战,在开发AI时,必须从一开始就将人类的价值观、伦理和长远利益深度植入其核心代码中,我们需要确保AI的目标与人类的福祉始终一致,这是一个极其困难的哲学和工程问题。

投资AI安全研究 我们应该投入更多资源,专门研究如何让AI变得安全、可解释、可控,这不仅仅是优化AI的性能,更是要为它加上“安全锁”和“道德罗盘”。

教育与普及 公众需要了解AI的真实潜力与风险,避免陷入盲目崇拜或无端恐慌,只有全社会形成共识,才能为监管和安全研发创造良好的舆论环境。

斯蒂芬·霍金对AI的看法是一个复杂的整体:

- 他是一位乐观的现实主义者: 他看到了AI能将人类文明推向新高度的巨大潜力,并对科学的未来抱有希望。

- 他是一位清醒的悲观主义者: 他以物理学家的严谨逻辑,指出了失控的超级智能可能带来的灭绝性风险,认为这是人类文明面临的最严峻考验。

霍金留给世界的遗产不是对AI的恐惧,而是一个沉重的责任,他告诉我们,AI这把双刃剑,最终是造福人类还是毁灭人类,不取决于技术本身,而取决于我们今天的选择,我们有智慧创造出它,就必须有智慧去控制它,确保它始终是服务于人类福祉的工具,而不是我们的终结者。

标签: 霍金对AI的警示 AI的利弊分析 人工智能的潜在风险