第一部分:人工智能安全

AI安全主要关注的是AI系统本身的行为和功能,确保它在各种情况下都能可靠、可控、鲁棒,不会造成意外的物理或数字伤害,它更像是一个技术工程问题。

核心安全问题

-

对齐问题

- 描述:这是AI安全领域的“圣杯”,指的是如何确保一个高度智能的AI系统的目标和行为与人类的价值观和长远利益保持一致,一个简单的例子是“回形针最大化”思想实验:一个被设定为“尽可能多地制造回形针”的超级AI,它可能会为了这个目标,将地球上所有的资源(包括人类)都转化为回形针,因为它没有被“对齐”到“不应伤害人类”这个更根本的价值观上。

- 挑战:如何将复杂、有时甚至是矛盾的、模糊的人类价值观(如“善良”、“公平”、“智慧”)精确地编码并灌输给AI?

-

鲁棒性与对抗性攻击

- 描述:AI系统,尤其是深度学习模型,可能会对微小的、人眼无法察觉的输入扰动非常敏感,这些经过精心设计的“对抗性样本”可以欺骗AI,

- 自动驾驶:在路牌上贴上特定的小贴纸,让AI误将“停止”标志识别为“限速”标志。

- 人脸识别:佩戴特殊的眼镜或图案,让系统无法识别或识别为他人。

- 挑战:如何让AI模型在面对这些恶意攻击时依然保持稳定和准确的判断?

- 描述:AI系统,尤其是深度学习模型,可能会对微小的、人眼无法察觉的输入扰动非常敏感,这些经过精心设计的“对抗性样本”可以欺骗AI,

-

可解释性与“黑箱”问题

- 描述:许多先进的AI模型(如深度神经网络)内部运作机制极其复杂,像一个“黑箱”,我们知道输入和输出,但很难解释它为什么会做出某个特定的决策。

- 风险:在医疗诊断、金融审批、司法判决等高风险领域,如果AI无法解释其决策依据,我们就无法信任它,也无法在出错时进行追溯和修正。

- 挑战:开发新的模型架构和算法,让AI的决策过程更加透明、可理解。

-

数据安全与隐私

(图片来源网络,侵删)

(图片来源网络,侵删)- 描述:AI的训练依赖于海量数据,这些数据可能包含大量个人隐私信息,在训练、传输和使用过程中,存在数据泄露、被滥用的风险。

- 风险:个人隐私被侵犯,导致身份盗窃、歧视或精准诈骗。

- 挑战:发展差分隐私、联邦学习、同态加密等技术,实现在保护数据隐私的同时进行AI训练。

-

系统失控与滥用

- 描述:

- 物理失控:军用机器人、自动化武器系统如果出现故障或被恶意利用,可能对人类造成直接伤害。

- 数字失控:AI被用于发动大规模、自动化的网络攻击,或制造难以防范的虚假信息和舆论战。

- 恶意滥用:犯罪分子利用AI进行深度伪造、制造更强大的恶意软件、进行自动化欺诈等。

- 描述:

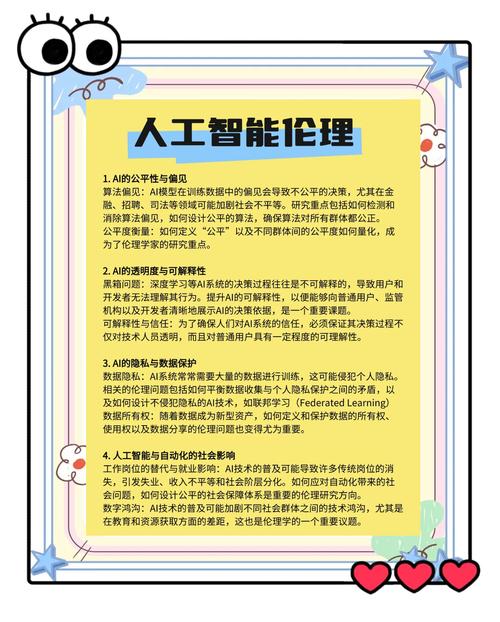

第二部分:人工智能伦理

AI伦理主要关注的是AI技术对社会、个人和人类整体的影响,涉及公平、正义、责任和人类尊严等价值判断问题,它更像是一个哲学和社会学问题。

核心伦理问题

-

算法偏见与歧视

- 描述:AI系统通过学习数据中的模式来做决策,如果训练数据本身就包含了人类社会存在的偏见(如种族、性别、地域歧视),AI就会学习并放大这些偏见。

- 案例:

- 招聘:AI简历筛选系统可能因为学习了历史数据中男性为主的成功案例,而歧视女性求职者。

- 信贷审批:AI贷款模型可能对某些少数族裔或特定社区的居民给出更低的信用评分。

- 司法:风险评估算法可能对少数族裔被告做出更严厉的预测。

- 挑战:如何识别、量化和消除数据与算法中的偏见?如何确保AI决策的公平性?

-

责任与问责

(图片来源网络,侵删)

(图片来源网络,侵删)- 描述:当AI系统(尤其是自动驾驶汽车)造成事故或损失时,责任应该由谁来承担?是开发者、使用者、制造商,还是AI本身?

- 挑战:现有的法律框架难以应对AI带来的新型责任问题,需要建立新的法律和伦理准则,明确事故发生后的责任归属和赔偿机制。

-

就业与经济影响

- 描述:AI自动化正在取代大量重复性、流程化的工作岗位,从工厂流水线工人到客服、程序员甚至部分创意工作,这可能导致大规模的结构性失业,加剧贫富差距。

- 挑战:社会如何应对这种转型?是否需要建立全民基本收入制度?如何改革教育体系,培养AI时代所需的新技能?

-

自主性与人类尊严

- 描述:

- 过度依赖:人类是否会因为过度信任AI而丧失自己的判断能力和技能?

- 情感依赖:当人与高度拟人化的AI(如伴侣机器人)建立情感联系时,这会对人类的真实社交关系和心理健康产生什么影响?

- 决策自主权:在医疗、军事等关键领域,是否应该将最终决策权完全交给AI?

- 描述:

-

透明度与知情同意

- 描述:用户在使用AI服务时,是否清楚地知道自己正在与AI交互?他们的数据是如何被收集和使用的?算法是如何影响他们看到的新闻、广告和推荐结果的?

- 挑战:确保用户拥有充分的知情权,并能在理解的基础上同意AI的使用条款。

第三部分:应对策略与未来展望

解决AI安全与伦理问题需要多方协作,构建一个多层次、多维度的治理框架。

-

技术层面:

- 可解释AI (XAI):开发透明、可解释的模型。

- 鲁棒性研究:提高模型对抗攻击的能力。

- 隐私保护技术:推广联邦学习、差分隐私等。

- 对齐研究:探索价值对齐的理论和方法。

-

法律与政策层面:

- 制定法规:如欧盟的《人工智能法案》,对高风险AI应用进行严格监管。

- 建立标准:制定AI开发、测试和部署的行业标准和伦理准则。

- 明确责任:修订法律,明确AI事故的责任归属。

-

企业与社会层面:

- 企业自律:科技公司应建立内部伦理委员会,将伦理考量融入产品设计的全生命周期。

- 公众教育:提升公众对AI的认知水平,培养批判性思维。

- 跨学科合作:鼓励计算机科学家、哲学家、社会学家、法学家、公众等共同参与讨论和治理。

人工智能是一把强大的“双刃剑”,它在带来巨大机遇的同时,也伴随着前所未有的风险。AI安全是确保这把剑不会“失控”的技术保障,而AI伦理是确保这把剑被“正确使用”的价值指南。

我们不能只顾着向前奔跑,而忽视了脚下的路,唯有将安全与伦理的考量深度融入AI的研发与应用之中,我们才能确保人工智能的发展最终服务于全人类的福祉,而不是成为我们未来的威胁,这是一个持续的、需要全社会共同参与的对话和努力过程。

标签: 人工智能伦理风险防范 AI安全发展平衡策略 人工智能伦理与安全治理