- 市场定义与核心特征

- 市场规模与增长动力

- 市场细分

- 主要参与者

- 技术趋势与挑战

- 未来展望

市场定义与核心特征

人工智能服务器 是一种专门为运行人工智能工作负载(如深度学习训练和推理)而优化的高性能计算服务器,与传统服务器相比,它具有以下核心特征:

(图片来源网络,侵删)

- 强大的计算能力:核心是搭载高性能GPU(图形处理器)或其他AI加速芯片(如TPU、NPU),GPU拥有数千个计算核心,特别适合AI模型中大规模的并行矩阵运算。

- 高速内存与互联:配备大容量、高带宽的内存(如HBM,高带宽内存)和高速互连技术(如NVLINK, InfiniBand),以快速处理和传输海量数据。

- 优化的软件生态:与主流AI框架(如TensorFlow, PyTorch)和深度学习库深度集成,提供高效的驱动、工具和软件栈。

- 可扩展性设计:支持多GPU并行计算,能够通过节点互联构建大规模AI计算集群,以满足超大型模型的训练需求。

市场规模与增长动力

市场规模: 全球AI服务器市场正处于爆发式增长阶段,根据多家市场研究机构(如IDC、TrendForce)的数据:

- 市场规模:2025年全球AI服务器市场规模已超过300亿美元,并预计在未来几年保持高速增长,年复合增长率超过25%。

- 占比:AI服务器在整个服务器市场中的占比持续提升,已成为服务器市场增长的主要驱动力。

增长动力:

- 大语言模型与生成式AI的浪潮:以GPT、LLaMA等为代表的大模型训练和推理,对计算能力提出了前所未有的需求,一个千亿参数级别的模型,其训练成本可能高达数千万美元,这直接拉动了高端AI服务器的采购。

- 数据量的爆炸式增长:全球产生的数据量持续激增,视频、图像、文本等非结构化数据需要AI技术进行分析和处理,这为AI服务器的应用提供了广阔的土壤。

- 各行业AI应用的深化:

- 互联网/云计算:头部科技公司(如Google, Meta, Microsoft, 阿里巴巴, 腾讯)是最大的采购方,用于训练自己的大模型和提供AI云服务。

- 金融:用于风险评估、量化交易、智能投顾。

- 医疗:用于医学影像分析、新药研发、基因测序。

- 制造:用于智能制造、预测性维护、质量检测。

- 自动驾驶:需要海量的数据训练和模拟验证,是AI服务器的重度用户。

- 国家战略与政策支持:各国政府(如中国的“新基建”、美国的“芯片与科学法案”)都在大力推动人工智能基础设施建设,为市场增长提供了政策保障。

- 云服务的普及:企业越来越多地通过云平台获取AI算力,降低了AI技术的使用门槛,进一步刺激了市场需求。

市场细分

AI服务器可以从不同维度进行细分:

按部署方式:

(图片来源网络,侵删)

- 云服务器:由大型云服务提供商(AWS, Azure, Google Cloud, 阿里云等)建设和运营,用户按需付费使用,这是目前市场的主流。

- 本地/边缘服务器:部署在企业或数据中心内部,用于处理对延迟敏感、数据隐私要求高的任务,如自动驾驶、工厂质检等。

按应用场景:

- 训练服务器:用于训练新的AI模型,特点是计算能力要求极高,通常配置多颗顶级GPU(如8颗NVIDIA H100),内存和网络带宽巨大。

- 推理服务器:用于部署已训练好的模型,为终端用户提供服务,特点是要求低延迟、高吞吐量,对功耗和成本更敏感,配置可能更灵活,例如使用GPU、CPU或专用NPU(神经网络处理器)。

按硬件架构:

- GPU加速服务器:目前绝对的主流,由NVIDIA主导。

- CPU服务器:用于轻量级AI任务或作为AI集群的管理节点。

- 其他加速架构:如Google的TPU、华为的昇腾、AMD的MI系列等,作为GPU的补充或替代方案。

主要参与者

AI服务器市场参与者众多,形成了“芯片 - 服务器 - 云服务”的完整产业链。

上游(核心芯片与组件):

- NVIDIA (英伟达):绝对的霸主,凭借其GPU硬件架构优势(CUDA生态系统)和软件栈(cuDNN, TensorRT),占据了AI加速芯片市场超过90%的份额,其H100/H200/B200等GPU是训练市场的标杆。

- AMD:通过收购赛灵思,推出了MI系列GPU,在性能和成本上与NVIDIA竞争,市场份额正在逐步提升。

- Intel (英特尔):通过收购Habana Labs,推出Gaudi系列AI加速器,试图在市场中分一杯羹。

- 其他芯片厂商:如Google (TPU), 华为 (昇腾/Ascend), Cerebras (Wafer-Scale Engine) 等,多在特定领域或生态内寻求突破。

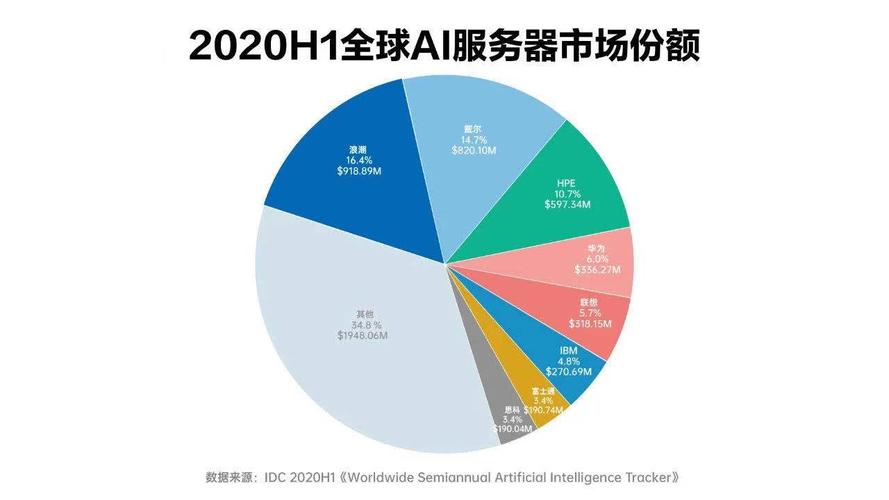

中游(服务器制造商/ODM/OEM):

- 传统服务器巨头:Dell Technologies, HPE (慧与), Lenovo (联想) 等,提供基于NVIDIA等芯片的标准化AI服务器解决方案。

- 专业AI服务器厂商:Supermicro (超微) 是这个领域的佼佼者,以其高度定制化、高性能和可靠性著称,深受数据中心和云厂商青睐。

- 中国本土厂商:浪潮信息、中科曙光、新华三等,在中国市场占据主导地位,并积极拓展海外市场。

下游(云服务提供商与终端用户):

- 云服务巨头:Amazon AWS, Microsoft Azure, Google Cloud, Alibaba Cloud (阿里云), Tencent Cloud (腾讯云) 等,是最大的采购方,将AI算力以服务形式提供给全球用户。

- 大型企业:各行业的领军企业,为了自身的数字化转型和AI应用,会采购或租用AI服务器。

技术趋势与挑战

技术趋势:

- 算力持续飙升:芯片从单GPU到多GPU,再到GPU+CPU+DPU(数据处理器)的异构计算架构,芯片制程不断进步(如4nm, 3nm),晶体管密度和性能持续提升。

- 液冷技术普及:随着GPU功耗不断突破700W甚至1000W,传统的风冷已难以满足散热需求,冷板式液冷甚至浸没式液冷正成为高密度AI数据中心的必然选择。

- 网络架构创新:为了解决多GPU之间的通信瓶颈,NVLINK、InfiniBand、以太网RoCE等技术不断演进,满足大规模集群训练的需求。

- 专用化与异构化:针对推理场景,功耗更低、成本更优的NPU、ASIC等专用芯片将获得更多应用,训练和推理的硬件架构将越来越分化。

- 软硬件协同设计:AI框架、编译器、操作系统与硬件的深度优化,将成为提升整体性能的关键。

主要挑战:

- 供应链与地缘政治风险:高端AI芯片(尤其是NVIDIA的高端GPU)的供应受国际政治环境影响巨大,成为市场发展的最大不确定性因素。

- 高昂的成本:高端AI服务器采购成本和运营成本(电费、冷却费)极其高昂,限制了部分企业和研究机构的进入。

- 能耗问题:AI数据中心是“耗电大户”,其巨大的能源消耗和碳足迹引发了越来越多的关注和监管压力。

- 人才短缺:既懂AI算法又懂高性能系统架构的复合型人才严重短缺。

- 软件生态壁垒:NVIDIA CUDA生态的强大形成了极高的用户粘性,新进入者难以在短期内撼动其地位。

未来展望

- 市场持续高景气:在生成式AI、自动驾驶等应用的驱动下,未来3-5年,AI服务器市场仍将保持高速增长。

- 竞争格局多元化:虽然NVIDIA短期内仍将占据主导,但AMD、Intel以及中国的芯片厂商(如华为昇腾)将在特定市场和领域加速追赶,市场格局将更加动态。

- “绿色AI”成为焦点:降低功耗、提高能效比将成为技术研发的重要方向,液冷技术将加速普及。

- 边缘AI崛起:随着5G和物联网的发展,部分AI计算将从云端下沉到边缘,对小型化、低功耗的边缘AI服务器需求将增加。

- 软件定义硬件:通过先进的编译器和软件,更灵活地调度和利用硬件资源,最大化AI算力的价值。

人工智能服务器市场正处于一个由技术驱动、资本追逐、政策扶持的黄金发展期,它不仅是科技产业的基石,更是未来数字经济的核心引擎,尽管面临供应链和成本等挑战,但其长期增长前景依然无比光明。

标签: AI服务器市场规模预测 AI服务器市场增长趋势 AI服务器市场前景分析

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。