AI芯片生态体系的目标是:让开发者能够高效、便捷地将AI算法和模型部署到特定硬件上,并最终在各类应用中创造价值。

下面我将从多个维度,系统地拆解这个生态体系。

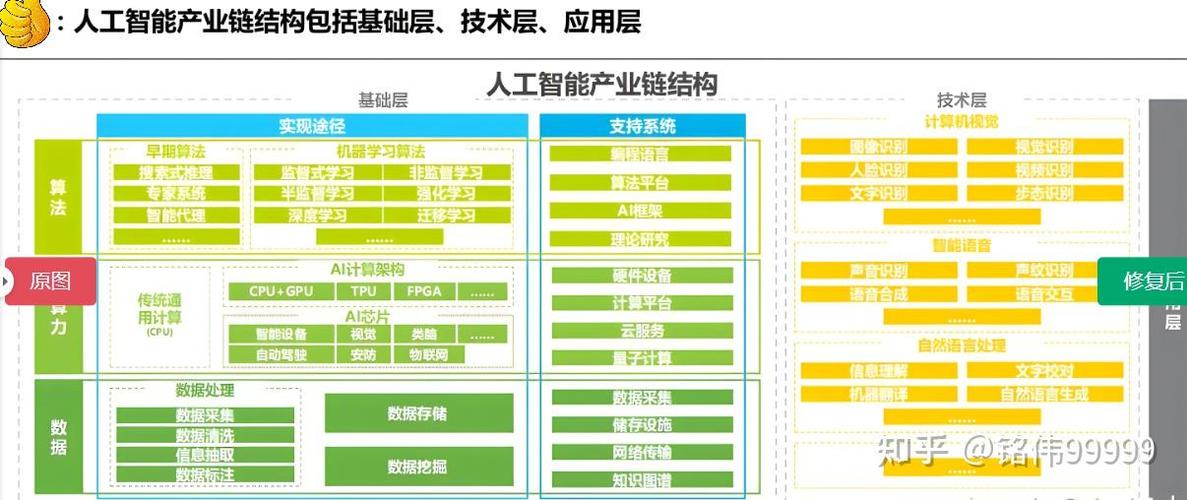

生态体系的层次结构

我们可以将AI芯片生态体系想象成一座金字塔,从底层到顶层依次是:

(这是一个概念图,帮助理解层次结构)

硬件层 - 基石

这是生态的物理基础,负责提供AI计算所需的算力,硬件是多样化的,没有一种芯片能通吃所有场景。

- 通用GPU (General-purpose GPUs):

- 代表厂商: NVIDIA (绝对领导者), AMD

- 特点: 拥有强大的并行计算能力和成熟的生态,CUDA平台是其“护城河”,虽然不是AI专用,但其灵活性和高性能使其成为AI研究和训练的绝对主流。

- 专用AI芯片:

- ASIC (Application-Specific Integrated Circuit - 专用集成电路):

- 代表厂商: Google (TPU), Huawei (昇腾/Ascend), Cambricon (寒武纪), Cerebras (Wafer-Scale Engine)

- 特点: 为特定AI算法或场景量身定制,能效比和性能远超通用芯片,缺点是开发周期长、成本高、灵活性差。

- FPGA (Field-Programmable Gate Array - 现场可编程门阵列):

- 代表厂商: Xilinx (已被AMD收购), Intel (Altera)

- 特点: 硬件可重构,灵活性极高,适合小批量、定制化或需要频繁迭代的AI场景,缺点是开发难度大,单位算力成本较高。

- ASIC (Application-Specific Integrated Circuit - 专用集成电路):

- 边缘/端侧AI芯片:

- 代表厂商: NVIDIA (Jetson系列), Qualcomm (骁龙), Apple (A/M系列芯片), 华为 (昇腾系列), 地平线, 联发科

- 特点: 追求低功耗、低成本、低延迟,用于手机、汽车、摄像头、智能家居等终端设备,实现本地化AI推理。

- 神经形态计算芯片:

- 代表厂商: Intel (Loihi), IBM (TrueNorth)

- 特点: 模拟人脑神经元结构和信息处理方式,能效极高,但尚处于早期研究阶段。

软件与工具链层 - 粘合剂

这是生态体系的核心和灵魂,它连接了算法和硬件,决定了开发者体验和开发效率,没有好的软件生态,再强的硬件也只是“废铁”。

- 核心计算框架:

- 代表: TensorFlow, PyTorch, MXNet

- 作用: 开发者使用这些框架定义、训练和调试AI模型,它们是上层应用和底层硬件之间的桥梁。

- 硬件驱动与运行时:

- 作用: 将计算框架的指令翻译成硬件能执行的底层操作,NVIDIA的CUDA、cuDNN库是其生态霸权的核心,其他芯片厂商(如华为的CANN、寒武纪的Neuware)都在努力构建自己的类似CUDA的软件栈。

- 编译器与优化工具:

- 作用: 将高级语言(如Python)编写的模型代码,通过编译器优化,生成针对特定硬件最高效的执行代码,这是AI芯片性能发挥的关键,NVIDIA的TensorRT。

- 模型库与算子库:

- 作用: 提供预训练好的模型(如ResNet, BERT)和常用的计算算子(如卷积、矩阵乘法),开发者可以直接调用,避免重复造轮子,NVIDIA的TensorFlow/PyTorch GPU加速库是典型代表。

- 开发工具与调试环境:

- 作用: 提供性能分析器(Profiler)、调试器、可视化工具等,帮助开发者定位性能瓶颈和代码错误。

算法与模型层 - 智慧源泉

这一层定义了AI要“思考”什么和如何“思考”。

- 基础模型:

- 代表: GPT系列 (OpenAI), LLaMA系列 (Meta), Claude (Anthropic), 文心一言 (百度), 通义千问 (阿里)

- 特点: 在海量数据上预训练的超大规模模型,成为许多下游应用的基础,它们对算力的需求是巨大的,直接推动了高端AI芯片的发展。

- 算法研究:

- 代表: 各大科技公司研究院、高校、研究机构。

- 作用: 持续创新新的网络结构(如Transformer)、训练方法(如强化学习),推动AI能力的边界。

- 模型优化技术:

- 技术: 量化、剪枝、蒸馏、知识蒸馏。

- 作用: 将庞大的基础模型压缩、简化,使其能够在资源受限的端侧设备上高效运行,这直接依赖芯片对低精度计算(如INT8, INT4)的支持。

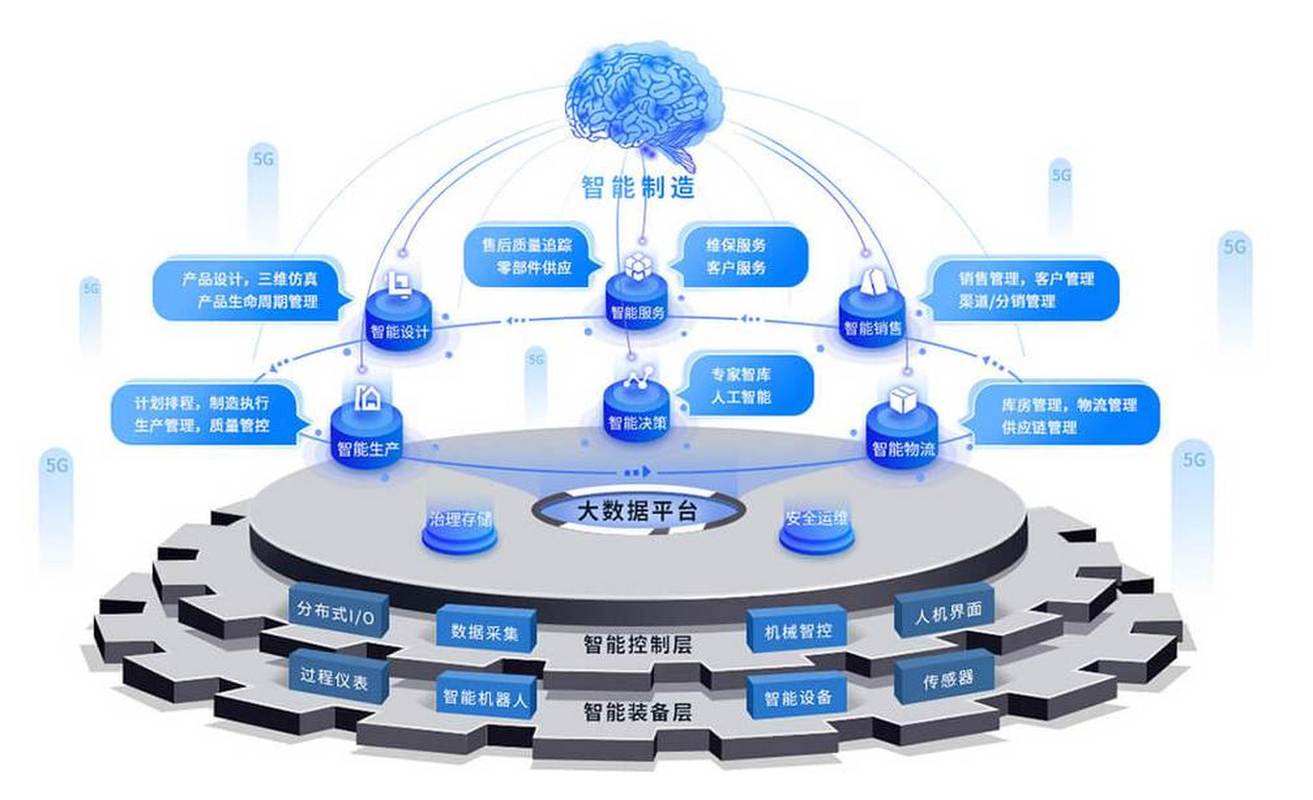

应用层 - 价值出口

这是生态体系的最终目的地,AI技术通过具体应用服务社会和用户。

- 云服务与数据中心:

- 应用: 大语言模型服务、AI绘画、AIGC内容生成、智能推荐、智能客服。

- 特点: 运行在云端,对算力要求最高,是NVIDIA数据中心GPU的主要市场。

- 边缘计算与物联网:

- 应用: 自动驾驶、智能安防、工业质检、智慧医疗、AR/VR。

- 特点: 要求低延迟和隐私保护,对端侧/边缘芯片的需求旺盛。

- 终端消费电子:

- 应用: 手机拍照美化、语音助手、人脸识别、智能手表的健康监测。

- 特点: 对功耗和成本极其敏感,集成在SoC中。

人才与社区层 - 活力引擎

生态的可持续发展离不开人才的培养和社区的活跃。

- 高等教育: 高校的AI、计算机科学专业是人才储备库。

- 开发者社区: Stack Overflow, GitHub, Hugging Face等平台上的开发者交流、贡献代码、分享经验,极大地加速了技术的普及和创新。

- 企业与研究机构合作: 产学研结合,共同培养符合产业需求的人才。

生态体系的竞争焦点

当前,AI芯片生态的竞争已经从单纯的“算力军备竞赛”转向了“生态系统”的全面较量。

-

软件生态的“护城河” (The Moat of Software Ecosystem):

- NVIDIA的成功秘诀: 它的成功不仅因为GPU硬件强大,更因为构建了以CUDA为核心的强大软件生态,数百万开发者已经习惯了CUDA的编程范式,更换其他芯片意味着巨大的学习成本和代码迁移成本,这是后来者最难逾越的鸿沟。

- 后来者的破局之道: 华为的CANN、寒武纪的Neuware等都在努力提供与PyTorch/TensorFlow无缝对接、体验相似的软件栈,并强调其在特定场景(如昇腾在昇腾云和华为终端)的优化优势。

-

“全栈自研”的能力 (Full-Stack Capability):

- 代表: Google (TPU + TensorFlow + TPU Pod), 华为 (昇腾芯片 + MindSpore框架 + CANN软件栈 + 昇腾云)

- 优势: 通过垂直整合,可以实现软硬件的深度协同优化,发挥出“1+1>2”的效果,同时也能构建一个封闭但高效的生态系统。

-

开放与合作的策略 (Openness and Collaboration):

- 代表: AMD, Intel, 以及众多初创公司。

- 策略: 它们选择拥抱主流开源框架(如PyTorch),并提供高质量的插件和优化,努力成为主流生态的“最佳配角”,而不是另起炉灶。

-

特定场景的垂直深耕 (Vertical Specialization):

- 策略: 不与NVIDIA在通用数据中心市场硬碰硬,而是专注于一个细分领域,做到极致。

- 例子:

- Cerebras: 专注于超大规模模型训练,其Wafer-Scale Engine芯片在单芯片性能上极具竞争力。

- 地平线、黑芝麻: 专注于自动驾驶芯片,提供“芯片+工具链+算法”的整体解决方案,深度绑定车企客户。

未来趋势

- 异构计算成为主流: 未来单一芯片无法满足所有需求,一个系统将集成CPU、GPU、NPU、DPU等多种处理器,协同工作。

- Chiplet (芯粒) 技术普及: 将不同功能的小芯片封装在一起,提高良率、降低成本、实现灵活组合,是应对先进制程瓶颈的重要方案。

- 软件定义硬件: 编译器和运行时的作用更加重要,可以通过软件优化来“压榨”硬件的极限性能。

- 绿色AI成为焦点: 随着AI模型越来越大,能耗问题日益突出,能效比将成为衡量芯片优劣的关键指标之一。

- 云-边-端协同: 模型将在云端训练,在云端进行推理,并根据需求分发到边缘和终端,形成一个协同工作的智能网络。

AI芯片的生态体系是一个“硬件是基础,软件是灵魂,应用是归宿,人才是动力”的复杂有机体,今天的竞争,早已超越了芯片本身,谁能够构建一个开发者友好、性能卓越、应用丰富的完整生态,谁就能在这场AI时代的竞赛中最终胜出,NVIDIA凭借其先发优势和强大的CUDA生态,目前处于领先地位,但华为、Google等巨头以及众多创新公司正在从不同维度奋力追赶,未来的格局仍充满变数。