太棒了!这是一个非常宏大且有趣的问题,制作人工智能软件是一个系统工程,融合了数据、算法、工程和产品思维,我会用一个从零到一的完整流程,为你详细拆解“人工智能软件怎么样制作”。

你可以把这个过程想象成盖房子:

- 数据:是盖房子的砖块、水泥和钢筋,没有高质量的数据,一切都是空谈。

- 算法/模型:是房子的设计图纸和建筑结构,它决定了房子能盖多高、多稳。

- 软件工程:是施工过程,它把图纸和材料变成一栋可以居住的实体建筑。

- 产品化/部署:是交付和运维,让住户(用户)能够方便地使用,并保证房子的安全和舒适。

下面,我们就按照这个“盖房子”的流程,一步步来讲解。

第一阶段:准备与规划

这是地基,决定了整个项目的成败。

定义问题与目标

这是最重要的一步!你必须用清晰的商业或技术语言,定义你的AI软件要解决什么问题。

- 错误示例:“做一个能聊天的机器人。”

- 正确示例:“开发一个客服机器人,用于回答用户关于‘订单状态’和‘退货政策’的常见问题,目标是减少50%的人工客服工作量,并将问题解决率提升到90%。”

关键点:

- 输入是什么? (用户的文字问题)

- 输出是什么? (标准化的答案、分类标签、一张图片)

- 如何衡量成功? (准确率、召回率、用户满意度、节省的成本)

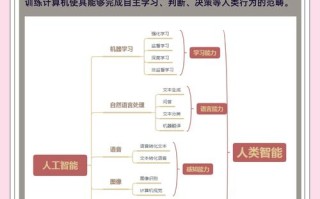

确定AI技术路径

根据你的问题,选择合适的AI技术。

- 计算机视觉:处理图像和视频。

- 应用:人脸识别、图片内容审核、自动驾驶中的物体检测、医疗影像分析。

- 自然语言处理:处理和理解文本/语音。

- 应用:智能客服、机器翻译、情感分析、文本摘要、语音助手。

- 推荐系统:预测用户可能喜欢什么。

- 应用:电商商品推荐、视频/音乐推荐、新闻流推荐。

- 预测分析:根据历史数据预测未来。

- 应用:股票价格预测、用户流失预警、销量预测。

数据规划

数据是AI的燃料,你需要规划:

- 数据从哪里来?

- 内部数据:公司数据库、用户日志、历史记录。

- 公开数据集:Kaggle、UCI Machine Learning Repository、政府开放数据平台。

- 网络爬虫:从网站上抓取数据(注意遵守法律法规和网站

robots.txt)。 - 数据标注:如果数据没有标签(如图片里的物体),需要人工或半自动工具进行标注。

- 需要多少数据?

对于深度学习,通常数据量越大越好,但有时,一个高质量的小数据集(几千条)比一个低质量的大数据集(几百万条)效果更好。

(图片来源网络,侵删)

(图片来源网络,侵删) - 数据质量与隐私

- 质量:数据要干净、准确、无噪声,数据清洗和预处理会占用大量时间。

- 隐私:处理用户数据时,必须遵守GDPR、CCPA等隐私法规,进行匿名化或脱敏处理。

第二阶段:模型开发与训练

这是将“设计图纸”和“材料”结合,打造核心“发动机”的过程。

数据预处理

原始数据通常是“脏”的,不能直接喂给模型,你需要:

- 清洗:处理缺失值、异常值、重复数据。

- 转换:将文本转换为数字(向量化),将图片缩放到统一尺寸。

- 标准化/归一化:让不同特征的数据处于同一量纲,有助于模型训练。

- 特征工程:从原始数据中提取或创造对模型预测有用的特征,这是传统机器学习的核心,深度学习可以部分自动化这个过程。

选择与构建模型

根据你的问题选择合适的模型架构。

- 传统机器学习模型:

- 场景:数据量不大,问题相对简单,可解释性要求高。

- 模型:逻辑回归、支持向量机、决策树、随机森林、XGBoost。

- 优点:训练快,资源消耗小,结果容易解释。

- 深度学习模型:

- 场景:数据量大,问题复杂(如图像、语音、自然语言理解)。

- 模型:

- CNN (卷积神经网络):用于图像处理。

- RNN/LSTM/GRU:用于序列数据(如文本、时间序列)。

- Transformer:当前NLP领域的主流架构,也是ChatGPT等大语言模型的基础。

- GAN (生成对抗网络):用于生成新数据(如图像、音乐)。

模型训练与调优

这是最核心的计算密集型步骤。

- 训练:将处理好的数据输入模型,通过不断迭代调整模型内部的参数,让模型的输出越来越接近真实结果。

- 评估:使用测试集(模型从未见过的数据)来评估模型性能,常用指标有准确率、精确率、召回率、F1分数、AUC等。

- 调优:如果模型表现不佳,需要调整:

- 超参数:如学习率、网络层数、神经元数量等。

- 模型结构:尝试不同的模型架构。

- 数据:增加数据量或进行数据增强(如对图片进行旋转、裁剪)。

模型验证

使用验证集在训练过程中监控模型,防止过拟合(模型在训练集上表现很好,但在新数据上表现很差)。

第三阶段:软件工程与集成

这是将“发动机”装进“车身”并连接好所有线路的过程,让AI能真正跑起来。

模型封装

训练好的模型只是一个文件(如.pkl, .h5, .pth),你需要把它封装成一个服务,能接收请求并返回结果。

- 常用工具:Python的

Flask或FastAPI框架可以轻松创建一个API接口。 - 流程:外部请求 -> API接口 -> 数据预处理 -> 模型推理 -> 结果后处理 -> 返回JSON格式响应。

软件后端开发

创建软件的后端服务,处理业务逻辑、用户管理、数据库交互等。

- 职责:调用AI模型服务,整合结果,并与其他系统(如用户数据库、订单系统)进行交互。

软件前端开发

开发用户界面,让用户能够使用你的AI软件。

- 形式:可以是网站、移动App、桌面软件或硬件设备上的界面。

- 职责:展示AI处理的结果,接收用户的输入。

DevOps与部署

将开发好的软件部署到服务器上,并建立持续集成/持续部署的流水线。

- 容器化:使用

Docker将应用和其依赖打包成一个标准化的容器,确保在任何环境下一致运行。 - 容器编排:使用

Kubernetes (K8s)来管理和调度容器化应用,实现高可用、自动扩缩容。 - 云平台:在AWS, Google Cloud, Azure或阿里云、腾讯云等平台上部署,利用它们提供的计算、存储和网络服务。

第四阶段:产品化、部署与运维

这是“交房”和“物业维护”阶段,确保软件稳定、高效地服务用户。

模型部署

将封装好的AI模型服务部署到生产环境。

- 部署方式:

- 实时推理:用户请求后立即返回结果,延迟要求高。

- 批量推理:定期对大量数据进行处理,如夜间生成第二天的推荐列表。

- 部署策略:蓝绿部署、金丝雀发布,确保更新过程平滑,不影响用户。

监控与日志

- 性能监控:监控API的响应时间、吞吐量、错误率。

- 模型性能监控:监控模型的预测准确率是否随时间下降(这被称为模型漂移)。

- 日志记录:详细记录每一次请求和响应,便于排查问题。

A/B测试

将新模型(或新功能)推送给一小部分用户(如5%),与旧版本进行对比,用数据新版本是否真的更好。

持续迭代

AI软件不是一劳永逸的,你需要:

- 收集用户反馈。

- 监控数据变化。

- 定期用新数据重新训练模型。

- 不断优化产品体验。

技术栈与工具推荐

- 编程语言:Python 是绝对的主流,拥有最丰富的AI库。

- 机器学习框架:

- Scikit-learn:传统机器学习。

- TensorFlow / Keras:工业界和学术界都非常流行。

- PyTorch:学术界和研究领域更受欢迎,灵活性高。

- 数据处理:Pandas, NumPy, Apache Spark (用于大数据)。

- 后端框架:Flask, FastAPI, Django。

- 数据库:PostgreSQL, MySQL, MongoDB (NoSQL), Redis (缓存)。

- 部署与运维:Docker, Kubernetes, Git, Jenkins/GitLab CI。

- 云平台:AWS SageMaker, Google AI Platform, Azure Machine Learning。

制作AI软件的关键挑战

- 数据挑战:获取高质量、标注好的数据是最难、最昂贵的一步。

- 人才挑战:需要同时具备数据科学、软件工程和产品思维的复合型人才。

- 算力挑战:训练大型模型需要强大的GPU/TPU算力,成本高昂。

- 落地挑战:将一个在实验室表现良好的模型,变成一个稳定、可靠、用户愿意用的产品,中间有巨大的鸿沟。

- 伦理与偏见:AI模型可能会学习并放大训练数据中存在的社会偏见(如性别、种族歧视),需要特别注意。

希望这个详细的指南能帮助你理解制作人工智能软件的全过程!这是一个充满挑战但回报丰厚的领域,从一个小项目开始,一步步实践,你就能掌握其中的精髓。

标签: 人工智能软件开发流程 AI软件制作技术栈 自主开发AI软件工具