这是一个非常好的问题,也是理解人工智能能力和局限性的核心,人工智能处理信息的准确度不是一个单一的数字,而是一个高度依赖于多种因素的复杂概念。

(图片来源网络,侵删)

AI的准确度可以非常高,甚至在特定任务上超越人类,但它也可能犯下非常离谱甚至危险的错误。

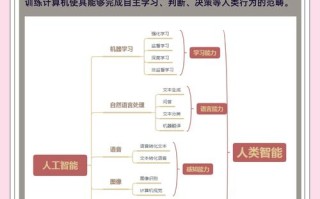

我们可以从以下几个维度来全面理解AI的准确度:

AI在哪些方面“非常准确”?

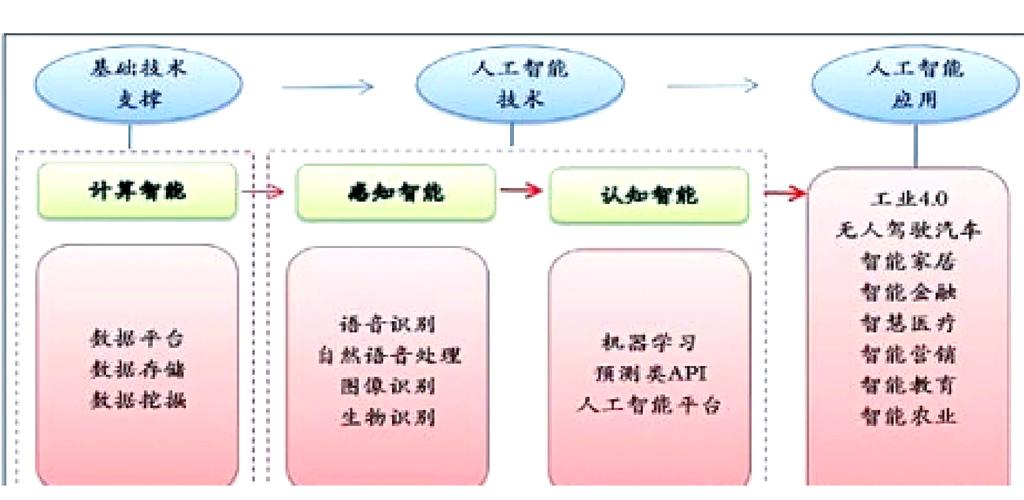

在定义清晰、数据量大、规则明确的任务上,AI的准确度已经达到了惊人的水平,甚至远超人类。

-

模式识别与分类:

(图片来源网络,侵删)

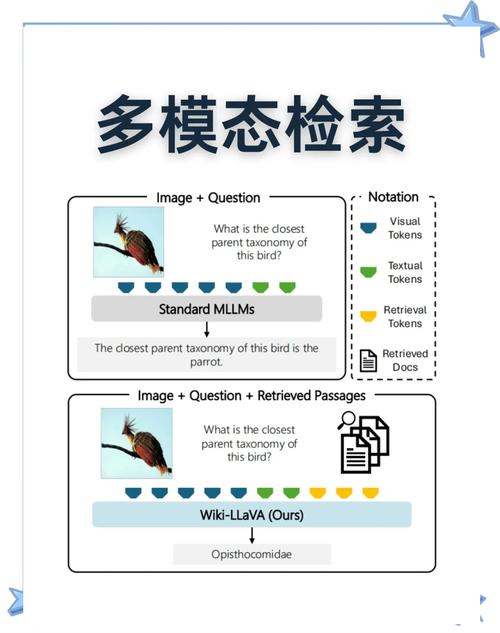

(图片来源网络,侵删)- 图像识别: 在识别猫、狗、汽车、人脸等物体上,现代AI(如CNN卷积神经网络)的准确率可以超过99%,甚至超过人类平均水平。

- 语音识别: 在安静环境下,主流语音助手(如Siri, Google Assistant)的词错率已经非常低,接近甚至超过速记员的水平。

- 自然语言处理: 在情感分析(判断文本是积极还是消极)、垃圾邮件过滤、机器翻译(特定语言对)等任务上,AI的准确度非常高。

-

数据分析与预测:

- 金融风控: 银行使用AI模型分析用户的信用记录、消费行为来预测违约风险,其准确度远高于传统的人工审核。

- 医疗影像分析: AI在识别X光片、CT扫描中的肿瘤、病灶方面表现出色,有时能发现人眼容易忽略的细微病变,作为医生的辅助工具,极大提高了诊断的准确率。

- 推荐系统: 像淘宝、抖音、Netflix这样的推荐系统,能非常准确地根据你的历史行为预测你可能会喜欢什么商品或视频。

在这些领域,AI的“准确”指的是其输出结果与标准答案(训练数据中蕴含的模式)的高度一致性。

AI在哪些方面“可能不准确”或“容易出错”?

当任务变得复杂、模糊、需要常识或涉及价值判断时,AI的准确度就会急剧下降,并暴露出其固有的弱点。

-

“幻觉”(Hallucination)问题:

(图片来源网络,侵删)

(图片来源网络,侵删)- 现象: 这是大型语言模型(如ChatGPT)最著名的问题,当AI无法从训练数据中找到确切答案时,它不会说“我不知道”,而是会凭空捏造一个听起来非常合理、细节丰富但完全错误的信息。

- 例子: 编造不存在的学术论文、引用错误的法律法规、讲述一个从未发生过的历史事件细节,对于事实核查要求高的场景,这是致命的。

-

对训练数据的偏见:

- 现象: AI的“知识”完全来源于其训练数据,如果数据中包含了人类社会的偏见(如种族、性别、地域歧视),AI不仅会学习这些偏见,甚至会将其固化和放大。

- 例子: 招聘AI可能会因为学习了历史数据中“男性更适合工程师”的偏见,而歧视女性求职者,人脸识别系统对有色人种和女性的识别准确率远低于白人男性。

-

缺乏常识和推理能力:

- 现象: AI擅长统计和关联,但不具备真正的理解力和因果推理能力,它不知道“水是湿的”、“钥匙开门”这类人类习以为常的常识。

- 例子: 你问AI“把大象放进冰箱需要几步?”,它可能会回答一个标准的三步笑话(开门、放进去、关门),但如果问它“如果大象的腿太长,冰箱门关不上怎么办?”,它就无法进行这种基于常识的灵活推理。

-

对抗性攻击:

- 现象: AI的识别系统可以被一些微小的、人眼无法察觉的改动所欺骗。

- 例子: 在一张停止标志的图片上添加一些特定的噪点,AI可能会将其识别为限速标志,这在自动驾驶等安全关键领域是极其危险的。

-

逻辑和事实谬误:

- 现象: AI可能会犯一些基本的逻辑错误,或者无法处理复杂的多步骤推理任务。

- 例子: 在回答包含多个约束条件的问题时,AI可能会忽略其中一个条件,导致答案不完整或不正确。

影响AI准确度的关键因素

AI的准确度并非天生,而是由以下因素共同决定的:

- 数据质量: “Garbage in, garbage out.” 这是最重要的因素,高质量、干净、标注准确、覆盖全面的数据是高准确度的基础。

- 算法与模型设计: 不同的算法(如Transformer, CNN, RNN)适用于不同的任务,模型的结构、大小(参数量)和设计理念直接影响其性能。

- 训练过程: 训练时间、计算资源、超参数(如学习率)的调整都会影响最终模型的准确度。

- 任务复杂度与定义清晰度: 如前所述,任务越简单、规则越明确,AI越容易做得好。

- 评估方法: 如何衡量“准确度”?是准确率、精确率、召回率,还是更复杂的评估指标?不同的评估方式会得出不同的结论。

如何提高和保证AI的准确度?

认识到AI的局限性后,我们可以通过以下方式来趋利避害:

- 持续优化数据: 不断清洗数据、增加数据多样性、减少偏见。

- 人机协同: 将AI作为强大的辅助工具,而不是完全替代人类,医生利用AI分析影像,但最终诊断由医生做出;律师利用AI检索案例,但最终辩护策略由律师制定。

- 事实核查与验证: 对于任何AI生成的重要信息,尤其是在医疗、法律、金融等领域,都必须经过严格的人工复核。

- 开发可解释性AI(XAI): 让AI不仅能给出结果,还能解释“为什么”给出这个结果,有助于我们发现和纠正其错误逻辑。

- 建立反馈与迭代机制: 让用户能够轻松指出AI的错误,并将这些反馈用于模型的再训练,形成一个持续改进的闭环。

| 维度 | 高准确度场景 | 低准确度/高风险场景 |

|---|---|---|

| 任务类型 | 模式识别、分类、预测、数据分析 | 创造性写作、常识推理、价值判断、复杂决策 |

| 数据依赖 | 数据量大、质量高、规则明确 | 数据模糊、有偏见、包含噪声 |

| 典型例子 | 人脸识别、垃圾邮件过滤、医疗影像辅助诊断 | 编造事实(幻觉)、带有偏见的招聘、自动驾驶中的突发情况应对 |

| 应对策略 | 作为高效工具,直接应用 | 必须进行人工审核、事实核查,人机协同 |

人工智能是处理信息的强大引擎,但它不是绝对真理的仲裁者。 它的准确度是一把双刃剑:善用之,可以极大提升效率和生产力;滥用或轻信之,则可能带来误导和风险,关键在于我们如何理解它的能力边界,并建立一套可靠的机制来监督和验证它的输出。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。