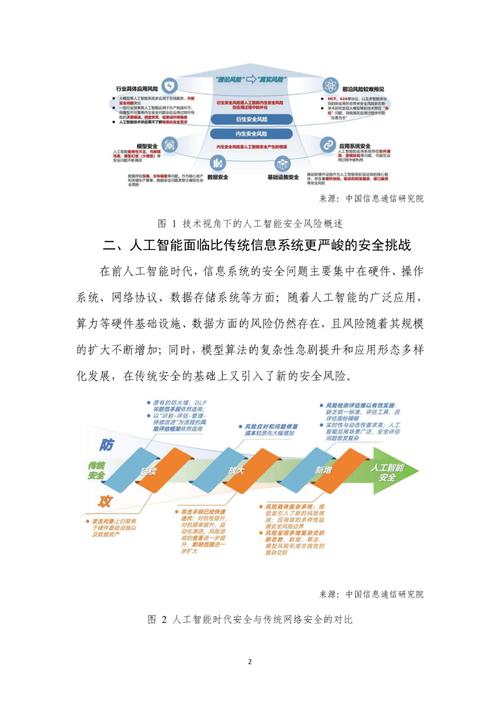

这是一个非常重要且复杂的问题,人工智能的产品安全问题已经从学术界的研究课题,演变为影响企业生存、社会稳定乃至国家安全的重大挑战。

我们可以从多个维度来系统地探讨这个问题。

核心安全问题分类

AI产品的安全问题可以归纳为以下五大类,它们相互关联,共同构成了AI的风险矩阵。

数据安全与隐私

数据是AI的“燃料”,因此数据层面的安全是所有问题的根源。

- 隐私泄露:AI模型在训练过程中需要大量数据,这些数据可能包含用户的个人身份信息、行为习惯、健康状况等敏感内容,如果数据收集、存储、处理不当,或模型本身“记住了”训练数据中的隐私信息,就可能导致大规模泄露。

- 例子:一个医疗AI模型在训练后,可能仍然能“回忆”并输出某些特定病人的病历信息。

- 数据投毒:攻击者通过向训练数据中注入恶意、错误或偏见的数据,来“污染”AI模型,使其学习到错误的模式或产生特定的、有害的行为。

- 例子:在自动驾驶汽车的识别数据中加入大量“停止标志是三角形”的错误标注,导致模型在真实世界中误判。

- 数据窃取:通过模型逆向工程等技术,从训练好的模型中反推出部分原始训练数据,尤其是敏感数据。

- 例子:攻击者通过查询一个面部识别模型的API,不断尝试输入,最终可以拼凑出用于训练该模型的部分人脸图像。

模型安全与鲁棒性

模型本身是否可靠,能否抵抗各种攻击,是其安全性的核心。

- 对抗性攻击:这是最著名的一类攻击,攻击者通过在输入数据中添加人眼或人耳无法察觉的微小扰动(如一张图片的几个像素点、一段音频的一小段噪音),就能导致AI模型做出完全错误的判断。

- 例子:在一张“停止”标志上贴上精心设计的特殊贴纸,自动驾驶系统可能会将其识别为“限速60公里/小时”的标志。

- 后门攻击:攻击者在模型训练阶段植入一个“后门”,在正常情况下,模型表现良好;但当输入满足特定“触发器”(trigger)时,模型就会执行攻击者预设的恶意行为。

- 例子:一个带有后门的AI人脸识别系统,对所有人都能准确识别,但只要佩戴一副特定款式的眼镜,就会被识别为“授权管理员”。

- 模型窃取:攻击者通过大量查询目标API(一个图片分类网站),来构建一个功能相似的“克隆模型”,从而窃取了昂贵模型的知识产权和技术。

算法公平性与偏见

AI的决策不应因种族、性别、年龄等因素而产生歧视,这不仅是伦理问题,也是法律和商业风险。

- 数据偏见:如果训练数据本身就包含了人类社会的历史偏见(如某些种族或性别在特定职业中代表性不足),AI模型就会学习并放大这些偏见。

- 例子:一个用于招聘的AI,如果用过去几十年男性主导的工程师简历数据进行训练,可能会在筛选简历时歧视女性求职者。

- 算法设计偏见:即使数据是平衡的,算法的设计目标(如优化准确率)也可能导致不公平的结果,为了降低对多数群体的误判率,可能会牺牲少数群体的利益。

- 例子:一个用于评估贷款风险的AI,为了确保整体低违约率,可能会对少数族裔申请人设置更高的门槛,即使他们的信用评分与多数族裔申请人相同。

系统安全与部署风险

AI不是孤立存在的,它嵌入在更大的软件和硬件系统中,这些系统本身也存在安全风险。

- 供应链攻击:攻击者不直接攻击AI模型,而是攻击其依赖的第三方库、框架或硬件(如GPU、芯片),通过在供应链中植入恶意代码,来破坏下游的AI产品。

- 例子:一个广泛使用的深度学习框架被植入后门,所有使用该框架训练的模型都可能被控制。

- API安全漏洞:提供AI服务的API(如云服务)如果存在认证、授权或输入验证漏洞,攻击者可以利用这些漏洞进行滥用、窃取或破坏。

- 例子:一个图像生成API没有严格的调用频率限制,被攻击者用来批量生成恶意内容,或导致服务瘫痪。

- 模型窃取与滥用:合法用户获取AI模型后,可能将其用于恶意目的,如生成深度伪造内容、进行大规模网络攻击等。

伦理与社会风险

这类风险超越了技术层面,涉及AI对社会结构和人类价值观的深远影响。

- 责任归属:当一辆自动驾驶汽车发生事故,或一个AI医疗系统误诊导致病人伤亡时,责任应该由谁承担?是车主、汽车制造商、AI算法开发者,还是数据提供方?现有的法律框架难以应对。

- 自主武器系统:能够独立搜索、识别并攻击目标的“杀手机器人”引发了巨大的伦理担忧,它们可能降低战争门槛,引发军备竞赛,并在出现错误时造成无法挽回的灾难。

- 信息茧房与社会操纵:推荐算法(如新闻、短视频推荐)为了最大化用户粘性,可能会将用户困在“信息茧房”中,加剧社会极化,AI驱动的虚假信息和深度伪造技术可以被用来大规模操纵舆论、影响选举、破坏社会信任。

- 失业与经济结构冲击:AI的广泛应用可能导致大量岗位被替代,加剧贫富差距,对现有社会经济结构造成冲击。

应对策略与最佳实践

解决AI产品安全问题需要一个多层次、全生命周期的综合治理方案。

技术层面

- 数据层面:

- 数据脱敏与匿名化:在训练前对数据进行处理,去除或模糊化个人信息。

- 差分隐私:在数据查询或模型发布时加入经过计算的“噪音”,使得攻击者无法推断出单个个体的信息,同时保证模型的可用性。

- 数据质量审计:建立严格的数据清洗和验证流程,检测并剔除异常和恶意数据。

- 模型层面:

- 对抗性训练:在训练过程中,持续用对抗性样本来“攻击”模型,让它学会抵抗这种攻击,从而提高鲁棒性。

- 模型水印:在模型中植入不易察觉的“水印”,用于验证模型的来源和所有权,防止模型被窃取后冒充。

- 可解释性AI(XAI):开发能够解释其决策过程的AI模型,如果模型做出错误判断,我们可以更容易地找到原因并进行修复,这对于检测后门和偏见至关重要。

- 形式化验证:像验证硬件电路一样,用数学方法严格证明AI模型在某些属性上的安全性(某个区域内的输入必然导致某个安全输出)。

管理与流程层面

- 建立AI安全开发生命周期:将安全考量融入AI产品从需求、设计、开发、测试到部署和维护的每一个环节,DevSecOps的理念同样适用于AI。

- 实施红队测试:组建专门的“红队”(攻击方),模拟真实世界的攻击者,对AI产品和系统进行全方位的渗透测试。

- 进行风险评估与审计:在产品发布前和发布后,定期进行独立的安全风险评估和伦理审计,识别潜在风险并制定缓解措施。

- 建立负责任的AI治理框架:企业应制定明确的AI伦理准则、使用政策,并设立专门的委员会或岗位(如AI伦理官)来监督AI的研发和应用。

法律与政策层面

- 制定法律法规:政府和监管机构需要出台相关法律法规,明确AI产品的安全标准、数据隐私保护要求、责任归属原则等,例如欧盟的《人工智能法案》就是一次重要的尝试。

- 推动行业标准:鼓励行业组织、研究机构和领先企业共同制定AI安全的技术标准和最佳实践指南。

- 加强国际合作:AI安全是全球性问题,需要各国在打击网络犯罪、防止AI军备竞赛、制定全球伦理准则等方面加强合作。

人工智能的产品安全是一个动态演进的“军备竞赛”,随着攻击手段的不断翻新,防御技术也必须持续进步,对于企业而言,将安全视为AI产品的核心属性而非附加成本,是赢得用户信任、实现可持续发展的关键,对于整个社会而言,需要技术、管理、法律和伦理协同发力,确保人工智能的发展方向是“以人为本、安全可控、造福人类”。

标签: AI产品安全责任归属 AI产品安全隐患责任方 AI产品安全责任方划分